1.Introducton

本篇文章是2020年发表于ACL的一篇文章,不同于其他人直接编码现成的依赖树,这篇文章中作者通过重塑与修剪普通的依赖树从而将方面词作为依赖树的根节点。此外作者还提出一个Relational Graph Attention Network模型来对新的依赖树进行编码。

2.

Model

模型部分主要介绍两个模块,一个是依赖树的修剪,一个是图注意网络的构建。

2.1 Aspect-Oriented Dependency Tree

对于作者通过修改依赖树原因,这里作者主要介绍了两处(我自己认为)。1.与方面直接连接的依赖关系可以帮助模型更多地关注相关的意见词。2.依赖树包含丰富的语法信息,然而传统依赖树通常不以目标方面为根。

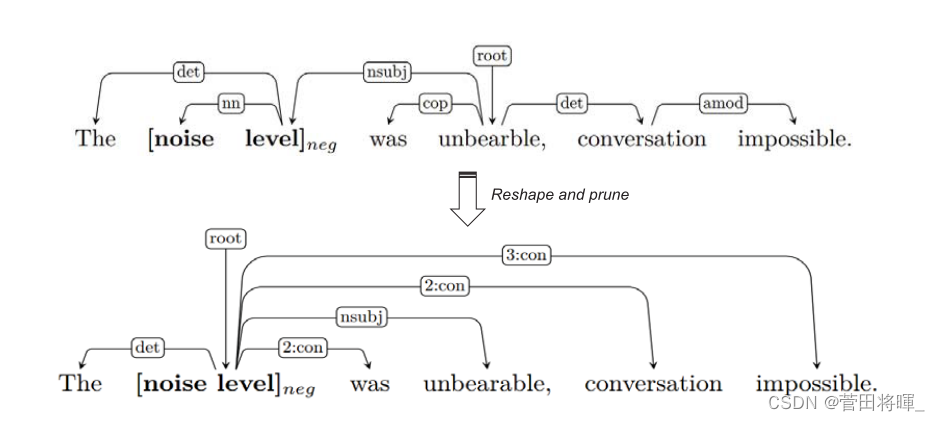

图1:依赖树的修剪与微调

图1所展示的便是对依赖树的修剪与微调。这原文中,作者主要通过三个步骤来进行创建。1.将目标方面放在根上,其中多词方面被视为实体(整体?)。2.将直接连接到方面的节点设置为子节点,对于子节点,原始的依赖关系被保留。3.其他的依赖关系都被丢弃了,取而代之的是,使用一个虚关系n:con (con意指connected)来进行一个代替,其中n代表两个节点之间的距离。具体的构造如图2所示。

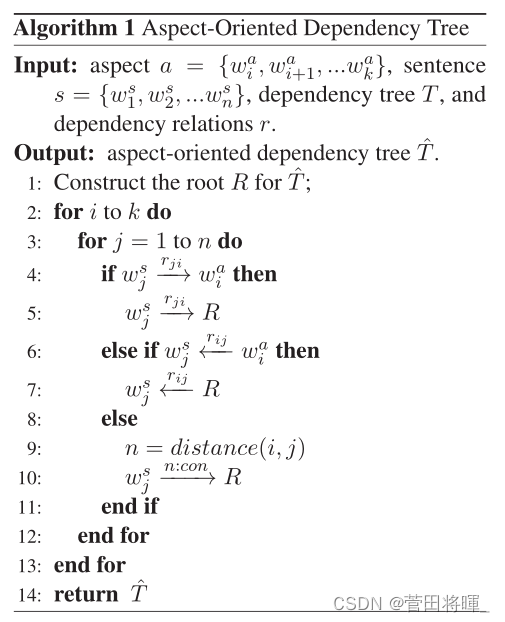

图2:依赖树构建的具体运算法则

对于这种树的构造,作者认为关注句法上接近目标方面的上下文单词的小子集可能就足够了。并且这种树结构不仅使模型能够集中于方面和意见词之间的联系,而且便于训练期间的批处理和并行操作。而虚关系n:con放置的原因,是因为现有的解析器可能不总是正确地解析句子,并且可能错过与目标方面的重要连接。在这种情况下,关系n:con使得新树更加健壮。

2.2 Relational Graph Attention Network

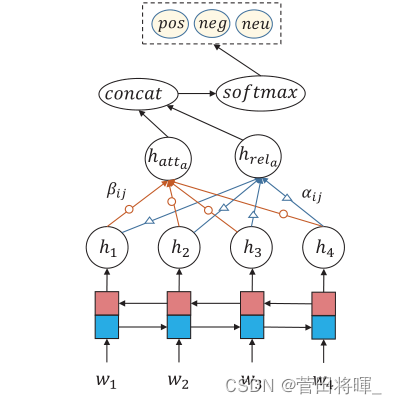

图3 R-GAT的结构

多头的图网络注意力公式如下。

|

|

(1) |

|

|

(2) |

而R-GAT的结构是基于GAT进行了一定的延伸。在文中,作者提到GAT聚合邻居节点的表示(信息)是沿着依赖路径的。但是,这种聚合的过程往往会忽视依赖关系,可能会丢失一些重要的依赖信息。于是作者决定将这些所谓的“依赖关系”考虑到自己的模型中。

首先作者将依赖关系映射成向量表示,然后计算一个关系头

|

|

(3) |

|

|

(4) |

|

|

(5) |

在这里

指的是节点I和j之间的关系嵌入。K和M分别指的是R-GAT的注意力头数和关系头数。

随后作者将这两个头数进行一个合并。

|

|

(6) |

|

|

(7) |

最后经过softmax得到最后的结果。

|

|

(8) |

损失函数:

|

|

(9) |

3.Experiments

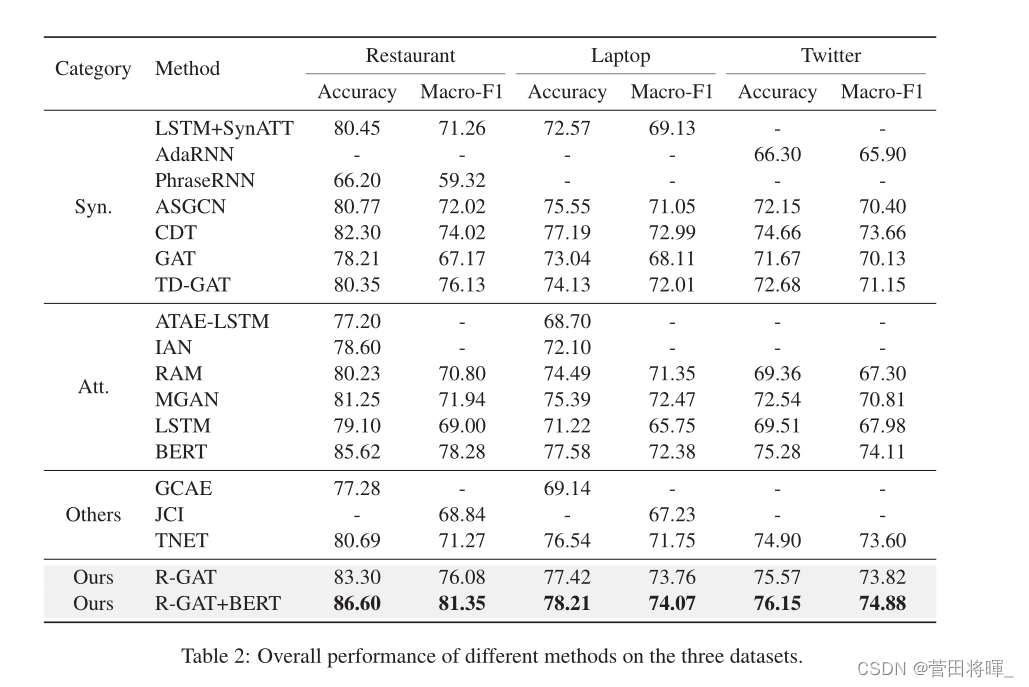

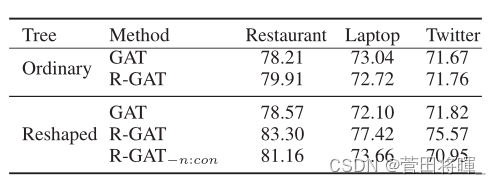

模型比较

消融实验

注:实验结果这一方面看的比较简单,具体内容请移步论文。

4.Conclusion

在本文中,作者提出了一种有效的方法来编码全面的句法信息,用于基于方面的情感分析。作者首先定义了一个新颖的面向方面的依赖树结构,通过重塑和修剪一个普通的依赖解析树,使其以目标方面为根。然后,作者演示了如何用关系图注意力网络(R-GA T)对新的依赖树进行编码,以进行情感分类。在三个公开数据集上的实验结果表明,R-GA T能更好地建立特征与观点词之间的联系,GAT和BERT的性能得到显著提高。作者还进行了一项消融研究,以验证新树形结构和相关头部的作用。最后,对错误预测的例子进行了误差分析,导致对这项任务的一些见解。