一、Numpy 中 Concatenate

Neural Network中的concatenate一般就是用来将特征联合,多个卷积特征提取框架提取的特征融合或者是讲输出层的信息进行融合

这个联合其实就是维度的一个联合

例如:Keras.concatenate()

import numpy as np

import keras.backend as K

import tensorflow as tf

# a,b 均为 [2,2,2]

a = K.variable(np.array([[[1, 2], [2, 3]], [[4, 4], [5, 3]]]))

b = K.variable(np.array([[[7, 4], [8, 4]], [[2, 10], [15, 11]]]))

c1 = K.concatenate([a, b], axis=0)

c2 = K.concatenate([a, b], axis=1)

c3 = K.concatenate([a, b], axis=2)

#试试默认的参数

c4 = K.concatenate([a, b])

init = tf.global_variables_initializer()

with tf.Session() as sess:

sess.run(init)

print(sess.run(c1))

print()

print(sess.run(c2))

print()

print(sess.run(c3))

print()

print(sess.run(c4))运行结果如下:

# 第一个维度是第一个中括号扩展[4,2,2]

[[[ 1. 2.]

[ 2. 3.]]

[[ 4. 4.]

[ 5. 3.]]

[[ 7. 4.]

[ 8. 4.]]

[[ 2. 10.]

[15. 11.]]]

# 第二个维度是第二个中括号扩展[2,4,2]

[[[ 1. 2.]

[ 2. 3.]

[ 7. 4.]

[ 8. 4.]]

[[ 4. 4.]

[ 5. 3.]

[ 2. 10.]

[15. 11.]]]

#第三个维度是第三个中括号扩展[2,2,4]

[[[ 1. 2. 7. 4.]

[ 2. 3. 8. 4.]]

[[ 4. 4. 2. 10.]

[ 5. 3. 15. 11.]]]

[[[ 1. 2. 7. 4.]

[ 2. 3. 8. 4.]]

[[ 4. 4. 2. 10.]

[ 5. 3. 15. 11.]]]二、深度学习中 concatenate 函数的使用

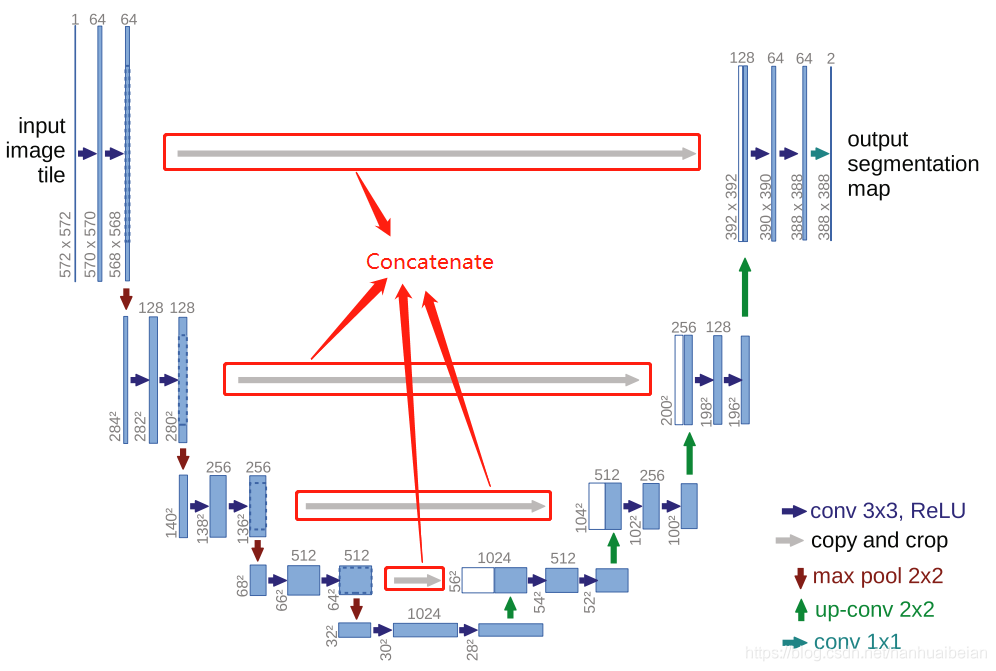

以 U-Net: Convolutional Networks for Biomedical Image Segmentation为例我们来分析一下Concatenate 的作用

这个网络结构包括一个收缩路径和一个扩张路径,也可看坐是downsampling 和 upsampling 的过程。

收缩路径是一个典型的卷积网络结构,包括两个 3×3 的卷积的重复应用(无填充的卷积过程),卷积后面的选用 ReLU作为激励函数,选择 2×2 的最大池化操作,在每个downsampling 过程中我们将特征图的数量增加一倍。

扩张路径的每一步都要经历一个 2×2 的反卷积过程,从图中可以很明显看出反卷积之后 feature channels 减半。然后将反卷积的特征图与相应收缩路径对应的裁剪后的特征图进行 Concatenate 操作,接着进行卷积操作,卷积后的激励函数仍然选用 ReLU。

这里的裁剪是很有必要的,因为这里采用的是无填充的卷积过程,每个卷积过程之后都会有相应边界像素的丢失

最后一层,使用 1×1 卷积将每个 64 分量的特征映射到所需要的类别里。

那为什么选用 Concatenate 的操作呢?

一定程度上缓解了梯度消失的问题,使每一步的卷积结果不止依赖上一步的操作结果,后面的每一层也和对应的相应层建立了联系

版权声明:本文为DreamBro原创文章,遵循 CC 4.0 BY-SA 版权协议,转载请附上原文出处链接和本声明。