Deepin Linux下安装Hadoop3.x

本文大部分内容来自http://dblab.xmu.edu.cn/blog/install-hadoop/

针对hadoop3.x做了修改

初学者,仅供参考

-

更新apt

sudo apt-get update -

安装SSH,配置SSH无密码登录

(deepin已经默认安装了openssh-client)

2.1 安装 SSH serversudo apt-get install openssh-server2.2 登陆本机

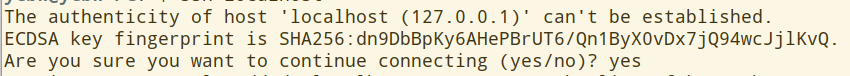

ssh localhost此时会出现提示,输入yes

接下来按照提示输入本机密码,显示登陆成功2.3 设置无密码登陆

exit # 退出上一步的ssh localhost cd ~/.ssh/ # 若没有该目录,再次执行一遍ssh localhost ssh-keygen -t rsa # 如果有提示输入,一路回车即可 cat ./id_rsa.pub >> ./authorized_keys # 加入授权 -

安装Hadoop

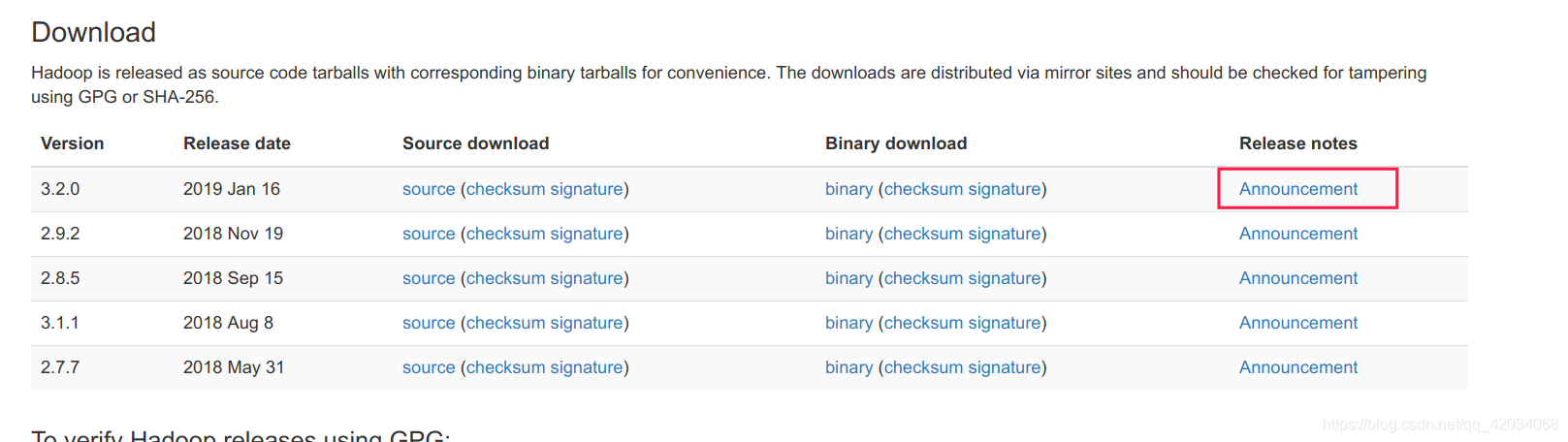

3.1 从官网下载Apache Hadoop

官网https://www.apache.org/

3.2 在系统中安装hadoopsudo tar -zxf ~/Downloads/hadoop-3.2.0.tar.gz -C /usr/local # 解压到usr/local cd /usr/local/ sudo mv ./hadoop-3.2.0/ ./hadoop # 把文件夹更名为hadoop sudo chown -R xxx(你的用户名) ./hadoop # 修改文件权限3.3 检测是否安装成功

cd /usr/local/hadoop ./bin/hadoop version -

Hadoop伪分布式配置

hadoop的配置文件路径: /usr/local/hadoop/etc/hadoop/

伪分布式需要配置的文件: core-site.xml 和 hdfs-site.xml4.1 修改core-site.xml

修改后<property> <name>hadoop.tmp.dir</name> <value>file:/usr/local/hadoop/tmp</value> <description>Abase for other temporary directories.</description> </property> <property> <name>fs.defaultFS</name> <value>hdfs://localhost:9000</value> </property>4.2 修改hdfs-site.xml

<configuration> <property> <name>dfs.replication</name> <value>1</value> </property> <property> <name>dfs.namenode.name.dir</name> <value>file:/usr/local/hadoop/tmp/dfs/name</value> </property> <property> <name>dfs.datanode.data.dir</name> <value>file:/usr/local/hadoop/tmp/dfs/data</value> </property> </configuration>配置完成后,执行namenode格式化

./bin/hdfs namenode -format #在/usr/local/hadoop目录下开启NameNode和DataNode守护进程

./sbin/start.dfs.sh

注意

-

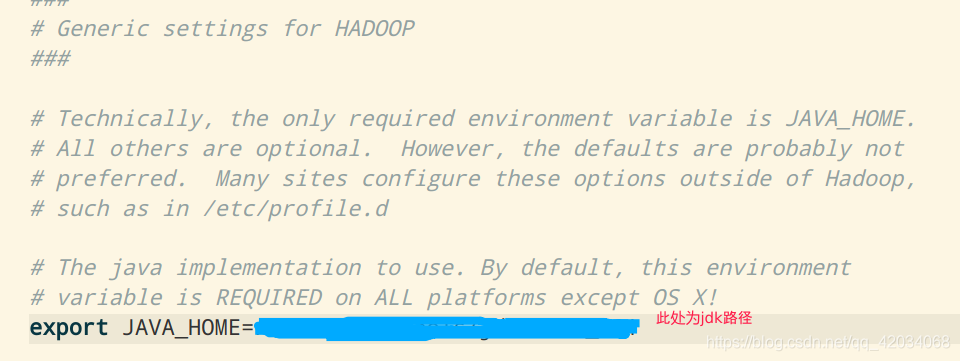

如果在这一步时提示 Error: JAVA_HOME is not set and could not be found. 的错误,则说明之前设置 JAVA_HOME 环境变量那边就没设置好,请先设置好 JAVA_HOME 变量

-

如果设置好JAVA_HOME环境变量之后依然出现这个问题,请到hadoop的安装目录修改配置文件“/usr/local/hadoop/etc/hadoop/hadoop-env.sh”,在里面找到“export JAVA_HOME=${JAVA_HOME}”这行,然后,把它修改成JAVA安装路径的具体地址,比如,“export JAVA_HOME=/usr/lib/jvm/default-java”,然后,再次启动Hadoop。

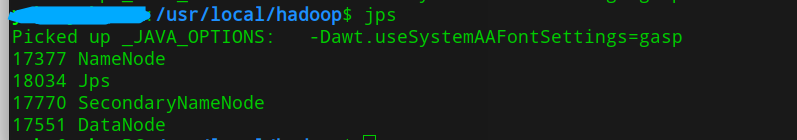

4.3 检查启动是否成功

使用jps命令检查启动是否成功jps出现如下进程信息代表启动成功

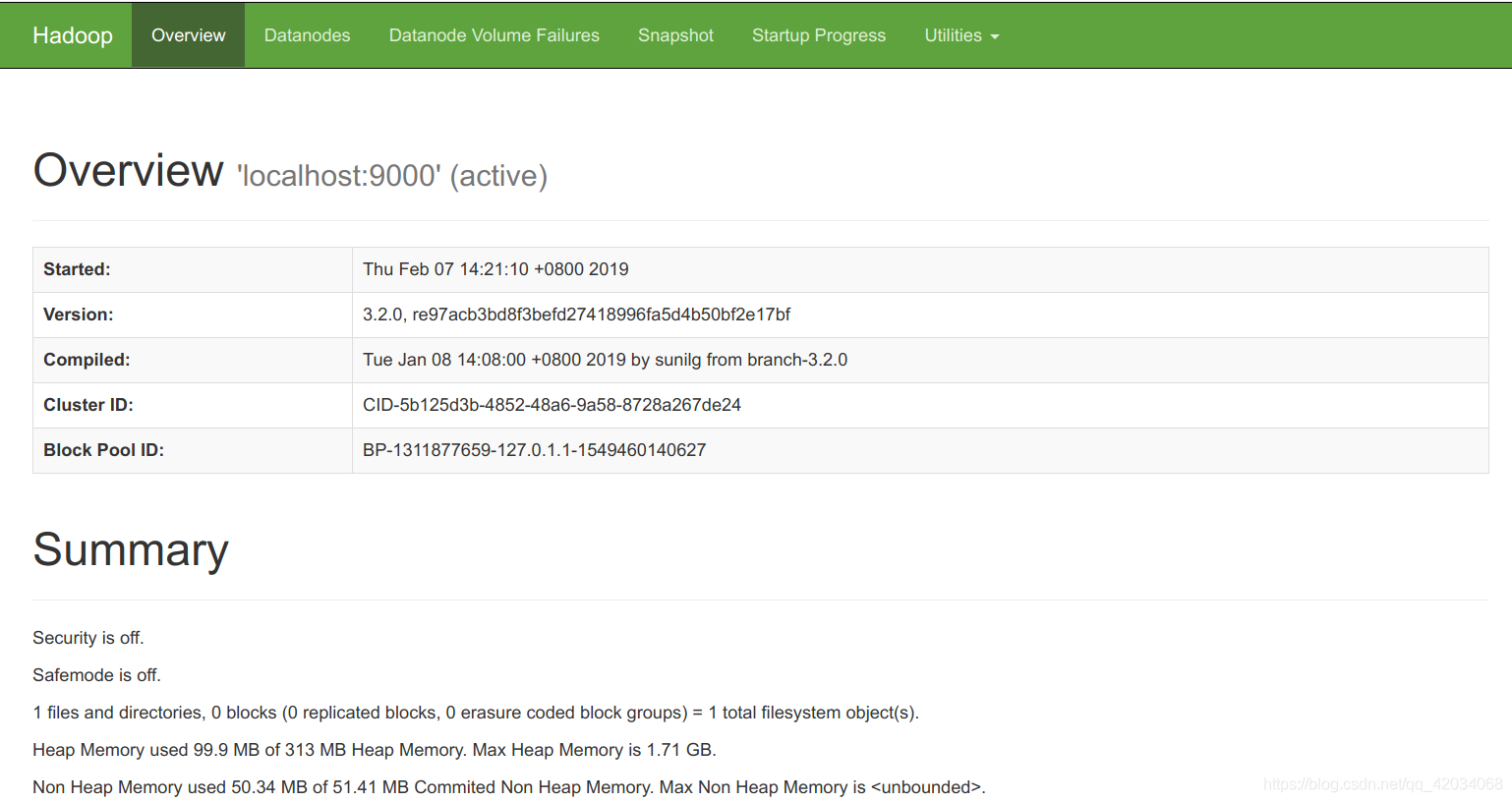

成功启动后,可以访问 Web 界面

http://localhost:9870

查看 NameNode 和 Datanode 信息,还可以在线查看 HDFS 中的文件。