一、文章作者:

Matthew D. Zeiler 和Rob Fergus Dept. of Computer Science, Courant Institute, New York University

原文链接:http://arxiv.org/pdf/1311.2901.pdf

二、简介:

该文章从可视化的角度分析AlexNet(即卷积神经网络)成功的原因,解释了为什么卷即神经网络有很好的表现,并且优化了AlexNet结构从而获得了更好的效果。

三、文章主要创新点与可关注点:

1,多层反卷积网络

Alexnet网络中每一个卷积层的操作有如下四个步骤:

1. 卷积运算

2. 矫正运算(ReLU函数)

3. 池化运算

4. 归一化运算

论文将中间层特征反向映射到像素空间中,观察得到什么输入会导致特定的输出,可视化过程是基于反卷积网络实现的,如图1所示就是其网络结构。反卷积网络可以看成卷积网络的逆过程,其卷积核是卷积网的卷积核的转置它们拥有相同的卷积核和pooling函数(准确来说是逆函数),因此反卷积网就是将输出特征逆映射成输入信号。

首先,输入图像通过卷积网模型,每一层都会产生特定的特征。然后将反卷积网中观测层的其他链接权值全部置零,将卷积网观测层产生的特征当作输入,输入到对应的反卷积层,依次进行以下操作:

1) Unpooling;

2) 矫正;

3) 反卷积;

UNpooling

在卷积网中,池化操作是不可逆的,论文中用了一种近似的方法来计算max pooling的逆过程。在池化的过程中,用maxlocations“switch”表格记录下每一个块的最大值的位置,在unpooling过程中这里将最大值标注回记录所在位置,其余位置设置为0。

矫正

在卷积网络中,为保证特征有效性,论文通过relu非线性函数来保证所有输出都为非负数,这个约束对反卷积过程依然成立,因此将重构信号送入reluc函数中。

反卷积

卷积网使用学习得到的卷积核与上一层输出做卷积,得到特征。为了实现逆过程,反卷积网使用相同的卷积核的转置作为核,与矫正后的特征进行卷积运算。

图1 特征数据可视化结构

2,特征组合观点

卷积神经网络低层产生比较浅显的特征,比如纹理,边,角等,越往上层,会将低层的特征进行组合,形成更复杂更高级的特征,所以其receptive field也越大,这也就形成了下一个要点,特征不变性。还有一个需要关注的是在训练卷积神经网络的时候,特征进化的过程为浅层的卷积层特征会很快收敛,高层的卷积层特征收敛的比较慢。

3,特征不变性

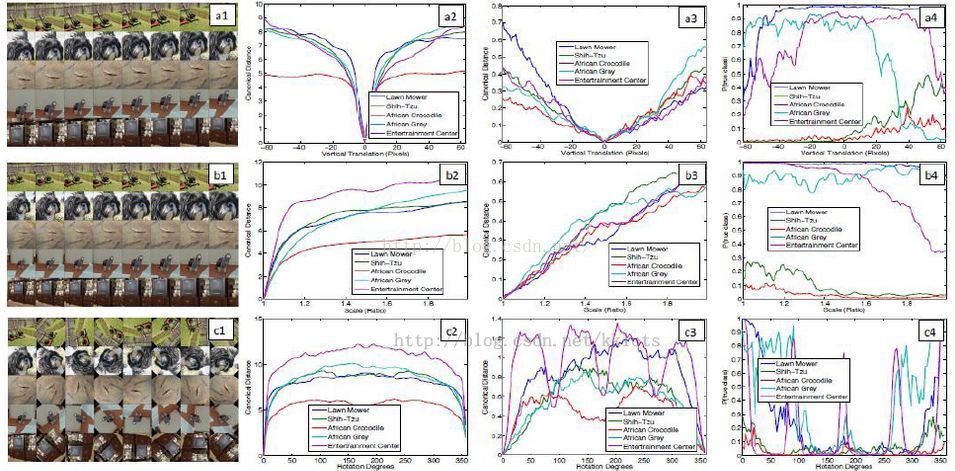

如图2所示,5个不同的例子,它们分别被平移、旋转和缩放。图5右边显示了不同层特征向量所具有的不变性能力。在第一层,很小的微变都会导致输出特征变化明显,但是越往高层走,平移和尺度变化对最终结果的影响越小。卷积网无法对旋转操作产生不变性,除非物体具有很强的对称性。

图3

3,遮挡敏感性

文章解释了卷积神经网络达到这么好的效果是使用了什么信息实现的分类?是图像中的具体位置的像素值,还是图像中的上下文。文章回答了这个问题,当图片的关键信息被遮挡时,分类器的性能急剧下降,所以卷积神经网络利用图像中具体位置像素值特征进行分类。

4,图片关键特征间相关性分析

文章验证了深度网络非显示地计算了特定物体部件之间的相关性关系。

5,卷积神经网络特征的泛化性

文章在Caltech-101和Caltech-256上通过固定网络的特征生成部分,只在softmax分类器上进行训练发现卷积神经网络的特征生成网络具有很好的泛化性,经过固定的训练就可以超过当时最好的结果,但是在PASCAL VOC 2012上训练的效果没有当时的最好结果好,作者分析可能是该数据集上存在多个物体对象,文章训练的卷即神经网络仅能提取单个对象的特征,但是仅仅比最好的分类效果地3.2%。

6,特征分析

文章分别使用1-7层卷积网络提取特征,并且分别用SVM和SoftMax分类器做分类,得出结论为卷积网络层数越高,提取出的特征的分类效果越好。