Learning Dynamic and Hierarchical Traffic Spatiotemporal Features with Transformer

原文,见

这里

作者:Haoyang Yan, Xiaolei Ma

期刊:

关键字:

摘要

交通预测是智能交通系统不可缺少的组成部分,长期全网精确交通速度预测是最具挑战性的任务之一。近年来,深度学习方法在这一领域越来越受欢迎。

由于交通数据在物理上与道路网络相关联,大多数提出的模型都将其视为一个时空图建模问题,并使用基于图卷积网络(GCN)的方法。这些基于GCN的模型高度依赖于一个预定义的和固定的相邻矩阵来反映空间依赖性。然而,预定义的固定相邻矩阵在反映交通流的实际依赖关系方面存在局限性

。本文提出了

一种新的交通变压器模型,用于时空图建模和长期交通预测,以克服这些局限性

。Transformer是自然语言处理(

NLP

)中最流行的框架。

Traffic Transformer将其应用于时空问题,通过多头注意和蒙面多头注意机制对数据进行分层动态提取时空特征,并融合这些特征进行交通预测

。此外,通过分析

注意力权重矩阵

可以发现路网中有影响的部分,从而更好地了解交通网络。在公共交通网络数据集和实际交通网络数据集上的实验结果表明,该模型的性能优于现有模型。

1 Introduction

城市交通系统满足了旅客的需求,保证了城市的运行。但随着城市化进程的不断加快,交通拥堵等问题越来越难以解决。智能交通系统有助于缓解交通拥堵,而交通速度预测是智能交通系统的基础。

交通速度是反映交通状况最关键的指标之一

。许多研究者针对交通速度预测提出了不同的方法,并取得了很大的成功。

近年来,

深度学习方法

在这一领域得到了广泛的应用,它可以让研究人员建立

数据驱动的模型

来提取时空特征。

路网交通流数据具有两类特征:空间特征和时间特征

。时间特征可以通过不同的时间序列模型提取,但空间特征还没有一个通用的提取方法。一开始,研究人员忽略了空间特征,只关注单一的道路。

以往的深度学习模型通常将交通网络转化为类网格结构,并将其视为图像,利用

卷积神经网络(CNN)

提取空间特征。然而,这些转换显然丢失了大量信息,并彻底破坏了网络关系。

例如,同一网格中的道路被合并,不能进行分析。由于交通数据与道路网络的物理关联,

最近提出的模型将其视为一个时空图建模问题,并使用基于图卷积网络(GCN)的方法。这些基于GCN的模型的关键是邻域矩阵

。邻接矩阵定义了图的节点和边之间的关系,从而允许模型卷积收集邻接节点中的信息。基于gcn的模型在全网络流量预测方面取得了巨大的成功。然而,这些基于GCN的模型仍然存在一些局限性。

⭐️1.1 Limitations in GCN-based models

(a).

定义一个完美的邻接矩阵对人类来说是困难和昂贵的

。相邻矩阵表示在图中传递的消息,但流量的传播是复杂的,不是简单地基于距离,有些节点可以看作是抽象的连接。例如,市中心路口的传感器可以在一定程度上代表网络的服务水平。该传感器具有一定的影响,可以看作是抽象地与大多数传感器相连。

(b).

相邻矩阵在模型中是固定的

。固定的相邻矩阵无法处理周、周末、早高峰、晚高峰等不同情况下的动态流量。此外,如(a)所示,相邻矩阵中存在不可避免的错误。例如,在无左转弯路口,左转弯路线的上下游传感器在空间上是近的,但在逻辑上是远的。固定的邻域矩阵意味着这些错误会一直影响模型。

©

没有深度和等级

。提出的模型通常只使用一个相邻矩阵。有些模型使用一组相邻矩阵,但这些相邻矩阵的结果只是简单地相加或拼接。然而,我们一直希望在深度学习中采用分层的“深度”模型。

针对上述挑战,我们发现空间特征提取和自然语言处理(

NLP

)有相似之处,并借鉴了NLP的先进方法。

1.2 Similarity between spatial feature extraction and

NLP

Fig.1 空间特征提取与自然语言处理的相似性。(a):自然语言数据和交通数据可视为顺序数据;(b):改变序列的顺序会改变含义;(c):高依赖性可能存在于序列中甚至很远的地方;(d):含义是动态的,并取决于其他部分。

空间特征提取与自然语言处理不仅在数据特征上相似,而且在挑战和困难上也相似。如

图1

(a)所示,自然语言数据和交通数据都可以看作是顺序数据。自然语言数据是单词的序列,交通数据是传感器的序列。如

图1

(b)所示,绝对位置和相对位置很重要。改变序列的顺序会改变意义。如

图1

©所示,长期依赖在NLP中很常见,推断明天的日期必须回到文章的开头。交通网络中的每个传感器无论远近都可以对传感器产生抽象的影响。如

图1(d)

所示,依赖关系是动态的,单词的意义取决于上下文。即使两个句子中的单词“it”是完全相同的,两个单词的意思是不同的。同样,中心节点的流量状态相同,但节点的空间依赖关系不同。

Transformer解决了上述的挑战和困难,在自然语言处理领域取得了巨大的成功,是一个健壮的序列学习框架。考虑到相似性,本文提出了一种

新的交通变压器模型

,用于

时空图建模和长期交通预测,以克服基于GCN模型的局限性

。我们将Transformer应用于交通预测问题。利用

Transformer的多头注意机制

,通过数据动态提取每对节点的关系。堆叠变压器层允许我们的模型分层提取特征。通过注意机制融合特征。在

公共交通网络数据集METR-LA

和我们自己生成的两个真实交通网络数据集上的实验结果表明,我们提出的模型具有比现有模型更好的性能。我们工作的主要贡献总结如下:

- 我们提出了一种新的交通变压器模型,用于时空图建模和长期交通预测。它提取和融合了全网交通流的全局和局部空间特征,显著提高了预测精度,尤其是在长期预测方面。

- 在Traffic Transformer中,提取的空间依赖依赖于输入数据是动态的。对于不同的输入数据的不同情况,Traffic Transformer给出了不同的空间关系,以通过注意力机制更好地进行预测。

- Traffic Transformer中分层提取特征。不同的层和块学习不同的特征并分层融合,帮助我们更好地学习交通网络和交通流的传播。

- 实验结果表明,即使邻域矩阵是未知的,该模型仍能达到良好的预测效果。

本文的其余部分组织如下:第2节介绍了交通速度预测方法的文献综述。第3节展示了交通预测问题的制定和我们提出的交通变压器网络。第4节提供实验来评估我们的模型的性能,以及对所提取的动态和分层交通时空特征的解释。最后,我们总结了我们的论文,并在第5部分介绍了我们的进一步工作。

2 Literature Review

在过去的几十年里,研究人员提出了许多不同的交通预测方法。这一领域的文献旨在提高准确性。为了实现这一目标,

现有的方法是提取和建模交通数据的空间和时间关系

。我们将前者的研究分为三个不同的阶段

:(a)传统研究方法;(b)基于网格的深度学习;©基于图的深度学习。这种划分取决于空间特征的提取方式

。以下是对这三个阶段的简要文献综述。正如我们前面提到的,空间特征提取和NLP不仅在数据特征上相似,而且在挑战和困难上也相似。我们正在将NLP的先进方法应用于交通预测。因此,对序列建模在自然语言处理中的应用进行简要的文献综述如下。

2.1 Traditional approaches

早在1976年,Box和Jenkins就提出了自回归综合移动平均线(ARIMA)。1979年,ARIMA被应用于交通预测(Ahmed and Cook, 1979)。ARIMA是一种参数化方法,它假设交通状态的分布是已知的,可以用多个参数估计。通过对ARIMA进行改进,考虑更多对交通系统的影响,ARIMA的V个变种表现出更好的性能。例如,

季节性ARIMA(SARIMA)

(Williams&Hoel,2003)考虑了交通系统中的周期性影响,

KARIMA

(V an Der V oort,Dougherty,Watson 1996)将kohonen地图与ARIMA相结合用于交通预测,Lee和Fambro使用ARIMA子集进行短期高速公路交通量预测。其他参数方法包括

指数平滑(ES)

(Ross, 1982)和卡尔曼滤波(Okutani和Stephanedes, 1984)。但由于交通状态分布的复杂性和动态性,这些参数化方法对于交通系统中的突发性变化(如高峰时段)可能不能很好地发挥作用。

为了提高学习精度,提出了一些先进的非参数机器学习方法。

k-NN

(Davis and Nihan 1991;Cai et al.,2016)是一种非参数惰性模型,通过找到输入的k个最近邻域来预测未来状态。贝叶斯网络(Sun、Zhang和Y u 2006)使用因果网络来表示变量的概率。

支持向量机(SVM)

(V anajakshi和Rilett,2004;Zhang和Xie,2008)定义支持向量并通过支持向量进行预测。

随机森林(RF)

(Leshem和Ritov,2007)和

梯度提升决策树(GBDT)

(Zhang和Haghani,2015)是套袋或提升决策树的集成方法。

小波包自相关函数

(Jiang和Adeli,2004)使用离散小波包变换来表示信号的其他细微细节,

人工神经网络(ANN)

(Adeli,2001;Dharia和Adeli,2003;Vlahogianni等人,2007)模拟生物神经元来构建神经网络,建立输入和输出之间的关系。然而,

这些方法都侧重于常规时段的短期交通预测。由于交通流的高度动态性和非线性,这些模型在高峰时段和长期交通预测中表现不佳.

2.2 Grid-based deep learning

由于

深度学习模型

具有很强的非线性和特征提取能力,近年来备受研究人员的关注。深度神经网络(DNN)可以提取隐藏在交通流数据中的时空特征,显著提高模型的性能。许多文献提出了不同的基于DNN的模型,深度学习方法在土木工程领域得到了广泛的应用(Rafiei和Adeli,2016, 2018;Rafiei, Khushefati, Demirboga和Adeli,2017)。

DNN模型

可用于空间和时间特征提取。例如,Ma等人(2015)使用

长短期记忆(LSTM)网络

来预测走廊上的速度演化。M. Zhou等人(2017)提出了一种

基于递归神经网络(RNN)的微观车辆跟随模型

来预测未来的交通振荡。Ma等人(2017)将

交通动态转换为热图图像,并使用深度卷积神经网络(CNN)

进行速度预测。H. Y .等。提出了一种用于

交通预测的时空递归卷积网络

(2017)。S. Chen、Leng和Labi(2019)开发的混合CNN-LSTM算法考虑了人类先验知识和时间信息。M. Zhou, u yu, Qu(2020)将强化学习与汽车跟随模型相结合,改进了互联和自动驾驶汽车的驾驶策略。

这些神经网络在特征提取和预测方面具有较高的准确性和鲁棒性。然而,这些方法的输入数据都局限于欧氏结构。全网交通数据是一种时空数据。时间维度自然是欧几里得结构,但空间维度不是。虽然交通数据自然地与图域联系在一起,但这些方法需要将图数据转换为类似网格的欧氏结构,在转换过程中会丢失大量的信息。例如,相同网格中的节点被认为是相同的,它们的信息将丢失。此外,粒度是这些“图到网格”转换方法的超参数,通常难以定义。

2.3 Graph-based deep learning

由于交通动态与路网自然地联系在一起,我们希望可以直接在图上分析问题。

将卷积算子扩展到图卷积(Kipf和Welling, 2017),称为图卷积网络(GCN)

。

GCN可以更好地提取全网空间特征,因为交通数据自然是用图形表示的

。例如,Li等人(2018)提出了

扩散卷积递归神经网络(DCRNN)

,它结合了扩散卷积和门控递归单元(GRU)。Y u等人(2018)将空间图卷积和时间门控卷积结合到全网络流量预测中,即所谓的

时空图卷积网络(STGCN)

。Y u等人(2019)将U – Net和STGCN结合起来,提取了多层次的时空特征,即

ST-UNet

。

这些模型有一个限制,这些模型的空间依赖性是预定义的,并在训练后保持固定

。通常考虑距离和上下游关系,最后计算相邻矩阵并将其应用到模型中。针对上述局限性,提出了从数据中学习空间相关性的新模型。Zhang等人(2018)提出

门控注意网络(GaAN)

通过图注意(GA T)机制从数据中学习动态空间相关性(V eličković et al., 2018)。Wu等人提出了

Graph Wave Net (GWN)

,并利用源向量和目标向量从数据中嵌入和学习相邻矩阵。

这些“适应邻接矩阵”方法的成功表明,交通的空间依赖性不仅仅局限于道路网络,远距离空间依赖性存在,路口的节点可以看作是连接到整个网络的。然而,虽然这些方法中的邻域矩阵是可学习的,但训练后邻域矩阵仍然是固定的。

2.4 Sequence modeling in

NLP

自然语言处理一直是人工智能领域中最受关注的领域之一。自然语言处理中大部分数据都是序列数据,序列建模是自然语言处理的基础。

序列到序列(seq2seq)

是

NLP

的基本任务之一,

seq2seq2意味着模型的输入和输出都是序列,序列的长度是不确定的

。例如,机器翻译的输入是长度不确定的句子,机器翻译的输出也是长度不确定的句子。类似的任务包括回答问题、生成文本等。Sutskever出版社。2014年提出了一种

带有神经网络的seq2seq模型

,将输入编码为向量,并将向量解码为输出。

注意机制被提出并与seq2seq模型相结合

,表现出了巨大的性能。注意机制可以将查询向量和一组键值对向量映射到输出。输出作为值的加权和计算,其中分配给每个值的权重是通过查询与相应键的兼容函数计算的。注意力机制允许模型返回到作品的输入序列,并在输出时找到重要的部分。注意力机制目前被广泛应用于包括交通预测在内的大多数深度学习任务中。例如,Q. Liu等人提出了一种

基于注意卷积神经网络

的短期交通速度预测方法。

长期以来,研究人员认为CNN或RNN是序列建模中不可缺少的一部分,可以处理序列数据中长度不确定的部分,但V aswani等人(2017)提出了

Transformer

,完全放弃了CNN和RNN。

Transformer只使用注意机制和完全连接的前向神经网络对序列进行建模

。Transformer及其变体实现了大多数最先进的性能。结果表明,

Transformer具有强大的时序性和非局部建模能力,非常适合于交通网络空间特征的提取

。最近,许多研究人员基于Transformer的想法提出了不同的模型,以适应其他领域的任务,包括Computer V版本(Dosovitskiy等人,2021年)和Point Could (M. Guo等人,2021年),这些变体在他们的领域取得了最先进的性能。这意味着Transformer具有可转移性,可以广泛应用于交通运输中的交通预测等多个领域。然而

,很少有交通预测模型考虑使用Transformer。

3 Methodology

本节介绍Traffic Transformer框架,它将Transformer应用于全网交通速度预测。该模型不仅具有良好的性能,而且对理解分层交通时空特征具有良好的可解释性。

3.1 Problem statement

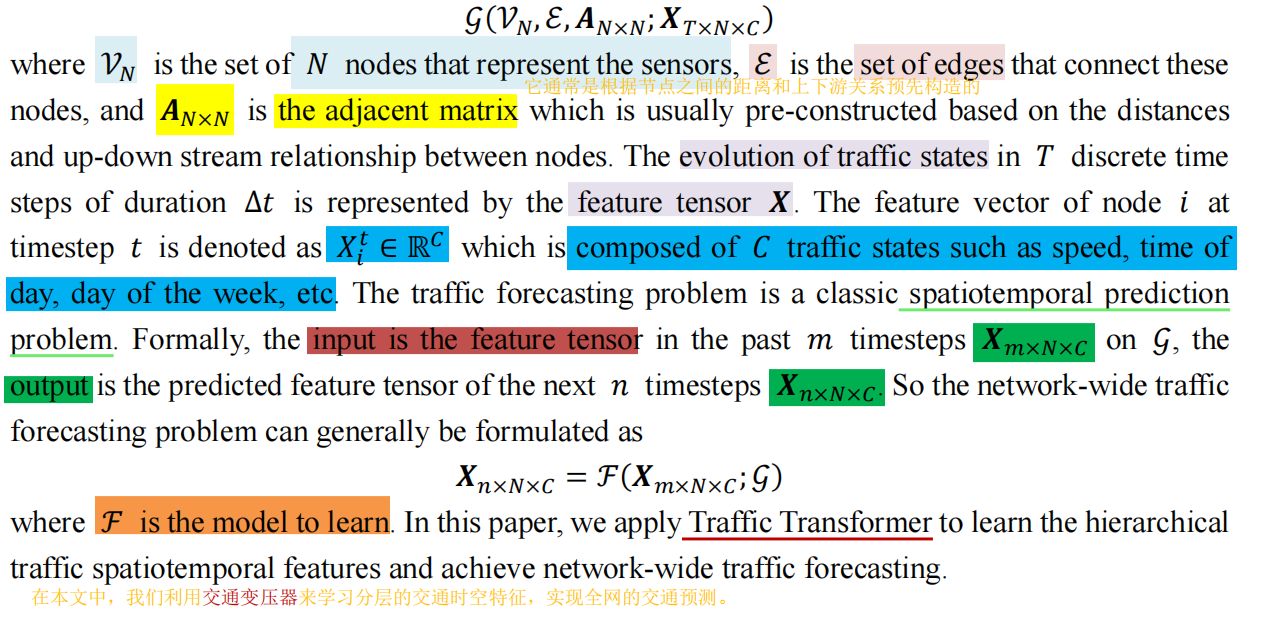

全网流量动态可以很自然地写成一个时空图:

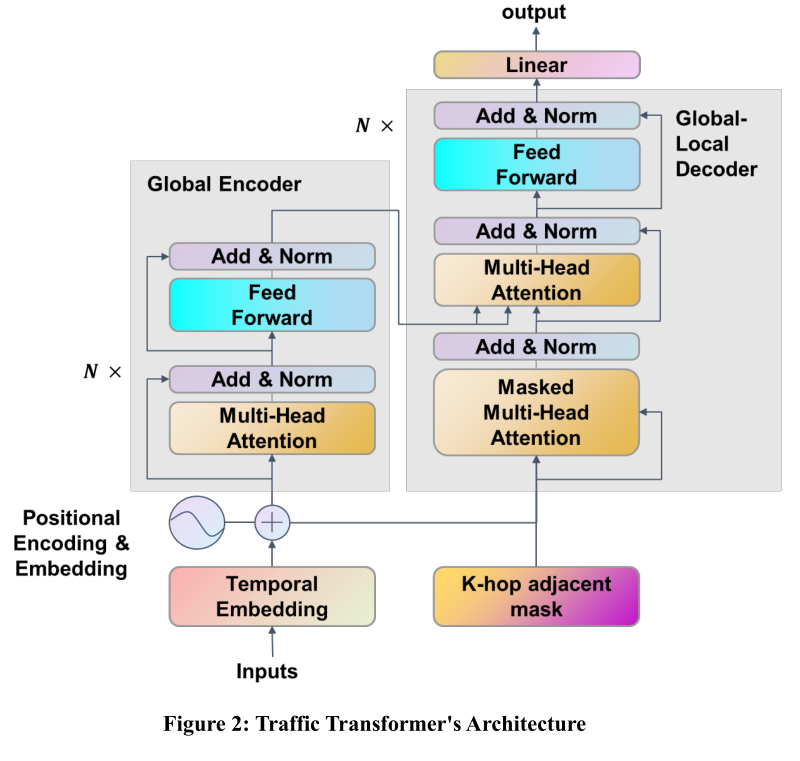

3.2 The Overall Architectures

如

图2

所示,流量转换器由两个主要部分组成。一种叫做

全局编码器

,另一种叫做

全局局部解码器

。多个全局编码器和全局局部解码器块堆叠在一起,形成分层特征的深度模型。Global Encoder和Global- local Decoder分别提取全局空间特征和局部空间特征。

全局-局部解码器

融合

了全局编码器提取的全局空间特征和全局-局部解码器提取的局部空间特征。此外,

时间嵌入块

在模型开始时提取时间特征。然后,

位置编码和嵌入块

帮助模型理解节点的绝对位置和相对位置。最后,一个密集神经网络将学习到的特征聚合起来进行最终的预测。通常有两种不同的方法来训练模型。以往的交通预测模型通常认为交通预测是

一个自回归问题

,并逐步进行预测,这导致了误差累积问题。因此,我们的模型放弃了

自回归方法,同时进行多步预测。这样既提高了长期预测的准确性,又缩短了推断时间。

3.3 Global Encoder

本小节集中讨论全局空间特征,即每个节点与所有其他节点之间的特征。

每个Global Encoder块有两个部分。第一个是多头注意块,第二个是完全连接的前馈层。在每个子层周围加入残差连接,然后进行层归一化

,以稳定梯度,有助于更好地训练模型。我们将通过下面的部分进一步阐述如何提取全球空间特征。

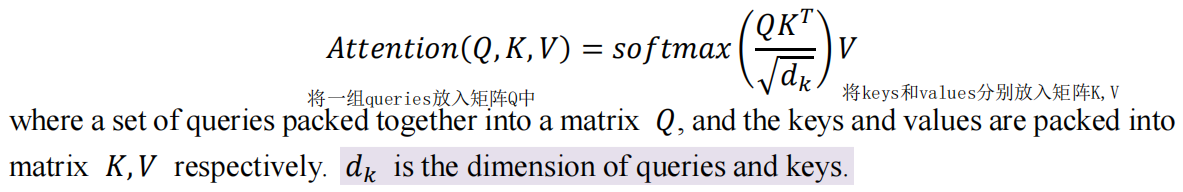

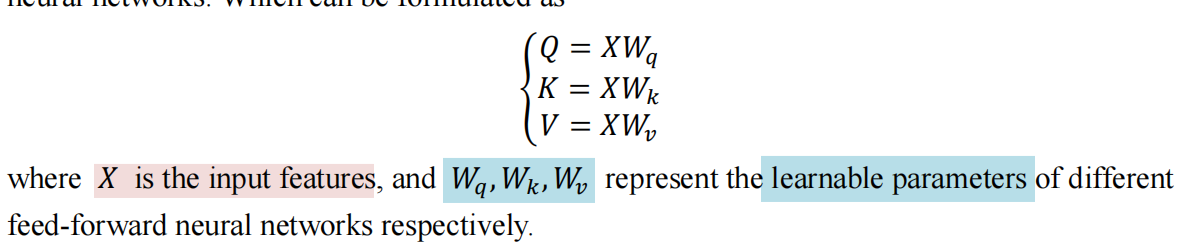

1) Multi-head attention

注意函数可以将

query向量和一a set of key-value pairs vectors组键值对向量

映射到输出。输出作为值的加权和计算,其中分配给每个值的权重是通过查询与相应键的兼容函数计算的。

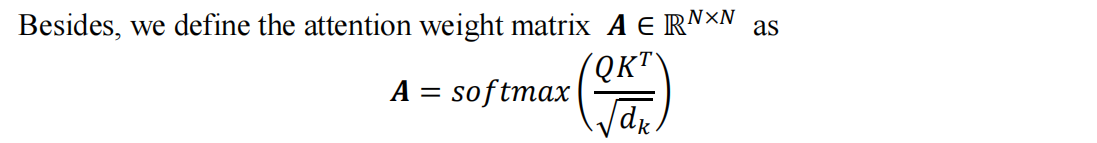

缩放点积注意(scaling Dot-Product Attention)

是变压器中常用的方法,可以写成

In Global Encoder, 矩阵

Q

,

K

,

V

Q,K,V

Q

,

K

,

V

都来自于相同的输入特征。利用不同的可学习前馈神经网络将输入特征投影到不同的潜在子空间。可以写成

Fig.3 注意权重矩阵来自每对节点。

如

图3

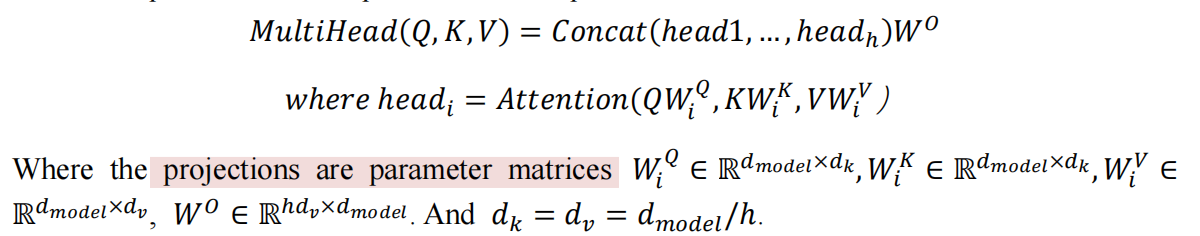

所示,注意权值矩阵可以表示每对节点之间的依赖关系。注意权值矩阵会根据输入数据动态变化。**多头注意**使用不同的学习前馈神经网络对Q、K、V进行h次线性投影。它允许模型在不同位置共同关注来自不同表示子空间的信息。它可以写成

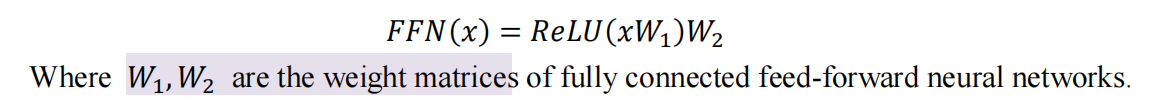

2) Fully connected feed-forward layer

一个

完全连接的前馈层

可以在每个位置单独地、相同地进一步改进模型。层由

两个线性投影

组成,中间有

ReLU激活

,用作

总之,

Global Encoder全局编码器

中的

多头注意

将输入节点投影到三个不同的子空间中。

通过缩放点积注意学习每对节点之间的关系。无论节点之间的距离是远还是近,它们都以相同的方式处理。因此,甚至可以提取两个遥远节点之间的隐藏空间特征。提取的空间特征是全局的,并且根据不同的输入动态变化。

3.4 Global-Local Decoder

本小节主要关注两件事。

首先提取局部空间特征,然后将局部空间特征与全局特征进行融合。每个全局局部解码器都有一个掩码多头注意、一个多头注意和一个前馈神经网络。还将在每个子层周围添加剩余连接,然后进行层归一化,以稳定梯度并帮助更好地训练模型。

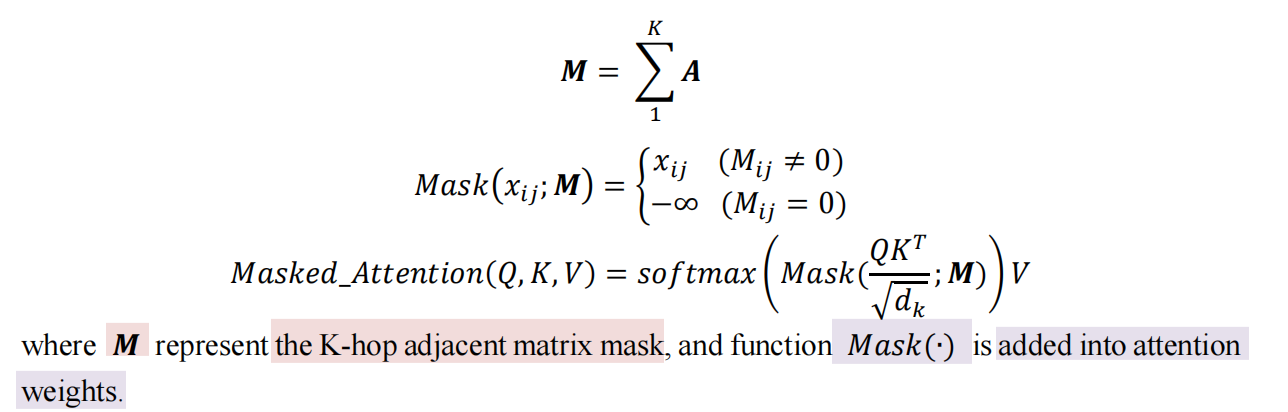

Mask Multi-head attention

是多头注意的一种变体,它使用mask忽略非局部节点来提取局部空间特征。它使用

K-hop邻接矩阵

作为掩码来定义局部和非局部,它可以表示为

全局局部解码器中的多头注意

与

全局编码器中的多头注意

相似,但全局编码器的输出用作

键

和

值

,即,? 和?, 并将mask多头注意的输出用作queries,即,? 。 这种多头注意是全局和局部空间特征的融合,其表

现优于通过注意机制简单地添加或串联

。

第三个是

完全连接的前馈层

,其结构与编码器中的完全连接的前馈层相同。

综上所述,

全局-局部解码器

侧重于局部。虽然全局编码器应该能够理想地处理每个节点的权重,但实际上它仍然需要手动定义的“局部”mask才能更好地学习。而基于注意的全局和局部特征融合使得模型能够学习这些特征的重要性权重,在最终预测中表现出更好的性能。

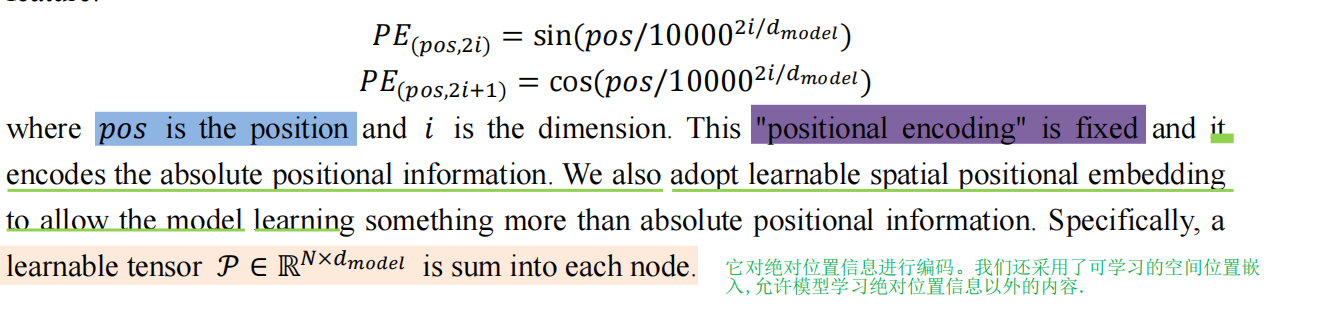

3.5 Positional Encodings and Embeddings

上述

交通变压器

的结构

只有前馈结构,没有卷积或循环操作

。因此,这些结构不能利用序列的顺序,但正如我们前面提到的,在流量预测和NLP中,

绝对和相对位置都很重要

。改变顺序会改变意思。序列的顺序表示节点的顺序和图的结构。绝对和相对位置太重要了,不能失去。为此,

我们在流量转换器的输入中添加了“位置编码”和“位置嵌入”。

位置编码

使用不同频率的正弦和余弦函数,求和到每个节点特征:

3.6 Temporal Embedding

上述结构和模块忽略了时间特征。但由于我们的问题是一个时间序列建模问题,时间特征不能被忽略。

大多数提出的模型交替地堆叠时间块和空间块。因此,这些模型逐步提取时间特征和空间特征。与这些模型不同,我们发现不需要堆叠时间块。在模型的开始处使用一个时间块就足够了。

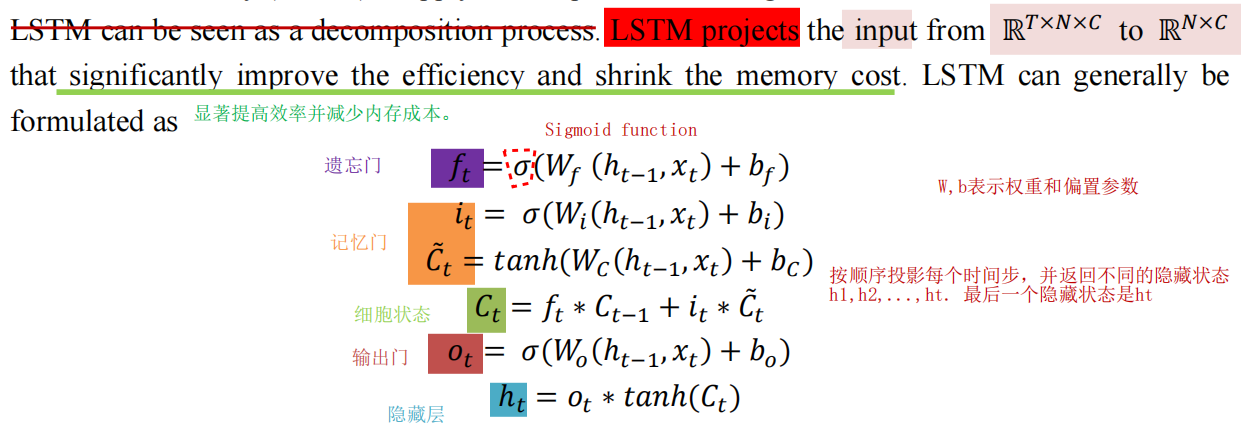

此外,时间特征在实践中通常很短,大约十个时间步。我们使用长短时记忆(LSTM)来应用时间嵌入。我们选择LSTM的原因是,

LSTM可以看作是一个分解过程

。

4 Experiments and Results

在本节中,我们对三个真实路网进行了实验,以回答:

(1)与目前最先进的方法相比,提出的交通变压器模型是否会显著提高预测性能?(2) Traffic Transformer模型是否会通过注意机制动态分层提取特征?(3)是否会提取潜在的空间全局和局部关系?

所有实验都是在NVIDIA RTX 2080Ti GPU (11GB RAM)的计算平台上进行的。使用Python来进行和评估所有的实验。

4.1 Data description

我们的模型在三个交通数据集上进行了验证。其中一个(METR-LA)是之前工作发布的公共数据集,另一个(Urban-BJ, Ring-BJ)是我们自己生成的。

具体来说,

METR-LA

是通过洛杉矶县高速公路上的环路探测器收集的。

数据集范围为2012年3月至2012年6月,共有207个传感器(节点)

。UrbanBJ和Ring-BJ是由上传的北京10000多辆出租车的GPS数据生成的。Urban-BJ和Ring-BJ的

时间范围为2015年6月至2015年8月

。在

Urban-BJ

中,选取一个市中心区域的

278个节点

。

Ring-BJ

选取了北京二环内的

236个节点

。这些节点和路网如

图4

所示。如

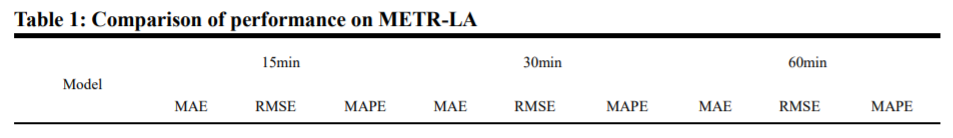

表1

所示,METR-LA只包括高速公路,Ring-BJ只包括一级公路。但城市北京由不同等级的道路组成。METR-LA的区域范围大,环- bj在中间,Urban-BJ在小范围。城市-北京是一个小范围内不同等级道路混合的城市,是一个复杂的路网。环北京的网络很简单,它只包括一条环路。METR-LA的复杂性在中间。我们选择这些不同特征的数据集来测试Traffic Transformer在不同情况下的性能。

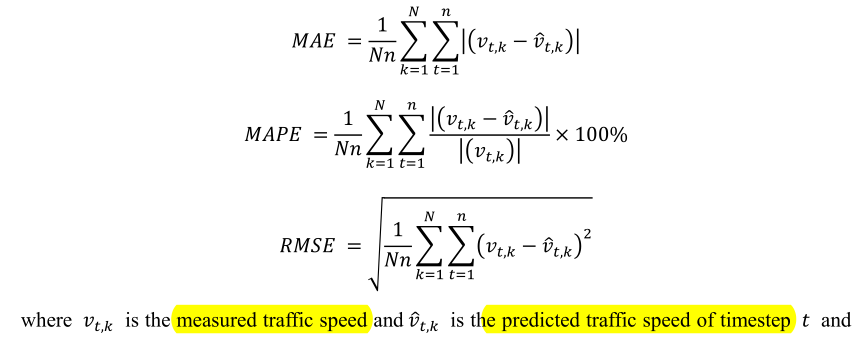

4.2 Measures of effectiveness

在本研究中,我们使用三种有效性度量,平均绝对误差(MAE)、平均绝对百分比误差(MAPE)和均方根误差(RMSE),来评估预测模型的准确性:

在这些不同的有效性测量方法中,MAE测量的是整体精度;MAPE对低速模式的误差特别敏感,并衡量模型是否跟踪道路网络中的拥堵情况;RMSE衡量的是预测的不确定性的偏差和方差。

4.3 Model comparisons

我们提出的Traffic Transformer模型与以下5个基准模型进行了比较,其中包括ARIMA和FC-LSTM等传统模型,以及DCRNN、STGCN和GWN等基于gcn的模型。

*ARIMA:时间序列预测中常用的模型。自回归阶、差值和移动平均是ARIMA模型的三个关键参数。通过“auto-ARIMA”工具进行网格搜索获得最优参数。

- FC-LSTM:完全连接LSTM (fully connected LSTM, FC-LSTM)可以提取时间特征的长短期依赖关系,是一种经典的RNN,通过完全连接神经网络学习时间序列并进行预测。

- DCRNN:扩散卷积递归神经网络(Diffusion Convolutional Recurrent Neural Network, DCRNN)是最具代表性的交通预测GNN方法之一。提出了一种具有编码器-解码器结构的序列对序列(seq2seq)模型,用于多步预测。

- STGCN:时空图卷积网络(spatial – temporal Graph Convolutional Network, STGCN)是另一种最具代表性的交通预测GNN方法。它利用时间块和空间块的叠加,提取st -特征并进行单步预测。

- GWN: Graph Wave Net (GWN)将Wave Net模型应用于图问题,取得了最先进的性能。

此外,为了进一步证明Traffic Transformer不同部分的有效性,我们设计了一个消融研究,使用了三种变体来与Traffic Transformer进行比较:

-

Traffic Transformer Encoder

:在变压器结构中只使用全局编码器,完全取消全局局部解码器。因此,该模型训练时不需要预先定义邻域矩阵。图结构完全通过模型学习得到。 -

Traffic Transformer Decoder

:在互感器结构中只使用全局局部解码器,完全去掉了全局编码器。由于缺少全局编码器,因此没有建立全局局部解码器的第二个多头注意层,并将其删除。因此,这个模型也可以看作是一个带有掩码的全局编码器。 -

Traffic Transformer-No temporal

:去除模型开始时的时间嵌入。该模型不能提取数据的时间特征。通过线性神经网络将不同时间步的速度在一维上压平,投影到原始维上。

网格搜索

用于调优超参数。最后,我们设置

Global Encoder块和Global- local Decoder块的数量都为6

。我们将时间嵌入后的模型中

隐藏的特征通道设置为64

。Traffic Transformer中前馈网络的

维度设置为256

。我们通过最小化MAE来训练我们的模型,并使用Adam作为1e-5重量衰减的优化器。在验证集上的早期停止用于缓解过拟合。利用剪切梯度机制稳定梯度,提高训练效果。

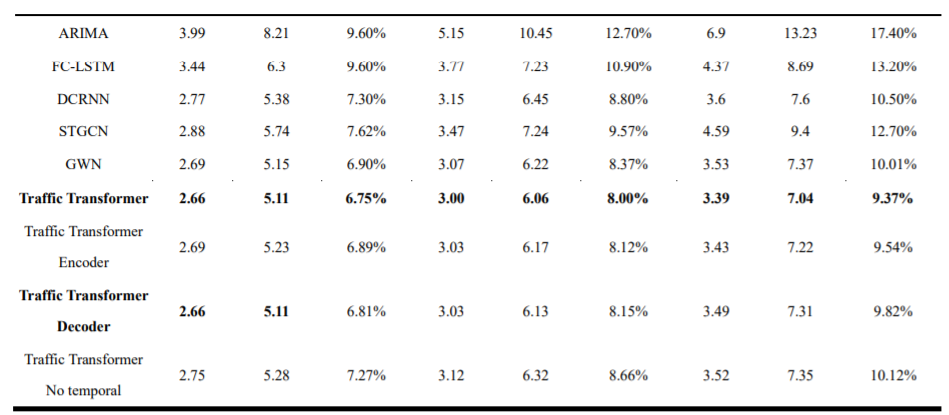

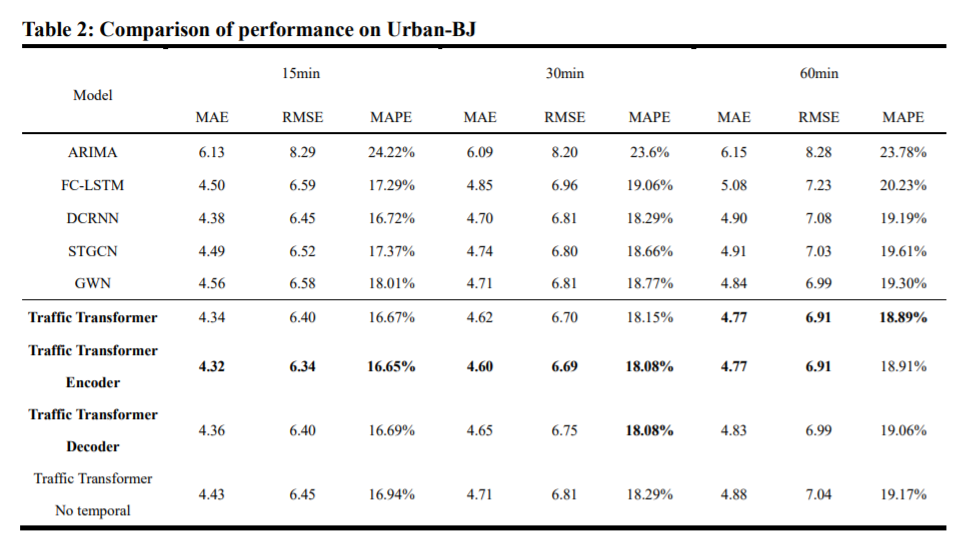

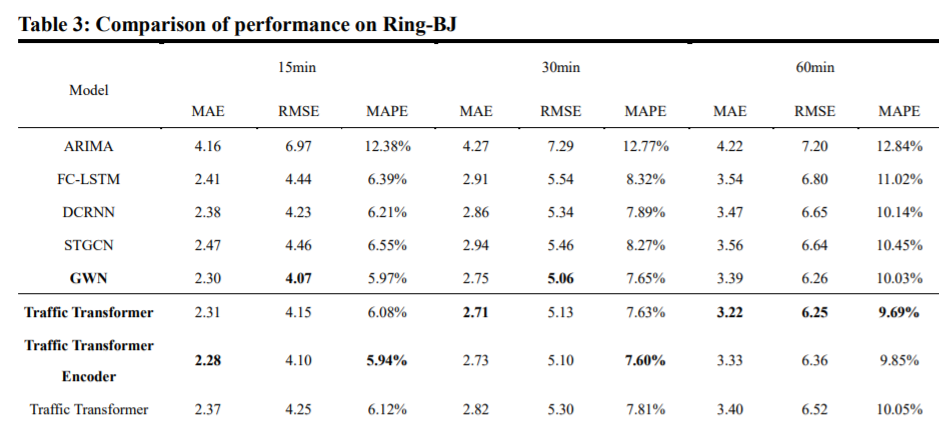

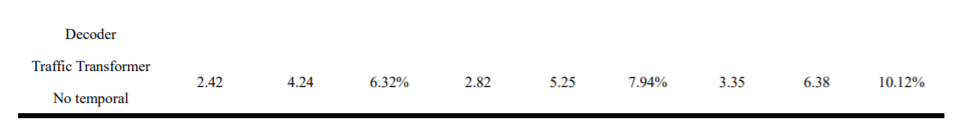

表1至表3

分别列出了METR-LA、Urban BJ和Ring BJ的不同交通变压器和比较基准方法的结果。结果表明,TrafficTransformer和Traffic Transformer Encoder在三种数据集和不同的预测项上的性能最好(但GWN在环- BJ上的短期(15min)和中期(30min) RMSE的比较更好),尤其是在长期(60min)预测中,

因为Traffic Transformer可以受益于提取的隐藏的远距离空间关系

。通过进一步的分析,可以得到一些观察结果和现象。

- 在传统模型的结果中,FC-LSTM比ARIMA的性能要好得多,这表明深度学习方法更适合于交通预测。

- 基于gcn的模型比传统模型具有更高的精度。这些基于gcn的模型表明空间特征在交通预测中具有不可替代的作用。换句话说,时空模型比时间模型的性能要好得多。

- GWN、Traffic Transformer和Traffic Transformer Encoder比DCRNN和STGCN取得了更好的结果,因为GWN每次迭代可以学习一次自适应邻接矩阵,Traffic Transformer和Traffic Transformer Encoder可以通过注意机制给出每对节点的邻接关系。因此,GWN、交通变压器和交通变压器编码器可以提取隐藏的空间特征,特别是在长期的性能更好。

- 与GWN相比,在交通变压器和交通变压器编码器中,学习到的空间关系来自于多头注意机制,因此学习到的空间关系是动态的,依赖于输入数据。交通变压器和交通变压器编码器的深层结构提取的是层次化的时空特征,而不是单一的相邻矩阵。因此,我们的模型在不同的情况下动态地提取层次隐藏空间特征,在长期预测方面优于GWN。

- 在Urban-BJ中,烧蚀模型Traffic Transformer Encoder优于原始模型,取得了最好的效果。这是因为定义不好的邻域矩阵会损害模型。Urban-BJ的复杂性如表1所示,很难定义一个足够好的邻接矩阵。因此,对于类似的情况,最好只使用Traffic Transformer Encoder而不是Traffic Transformer。

- 即使没有时间嵌入块,Traffic Transformer的结果也不差。说明数据中隐藏的时间特征简单,不需要反复提取时间维的变化。在开始时,只有一个单一的时间嵌入就足够了,并且可以显著地减少分解的训练成本。

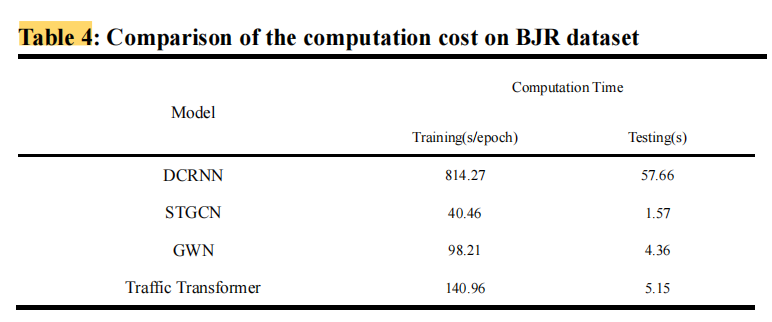

我们还在最大的数据集Urban BJ上比较了Traffic Transformer与DCRNN、STGCN和GWN的计算成本。如

表3

所示,由于DCRNN的多步预测架构训练成本过高,因此DCRNN的速度要比其他模型慢得多。我们的Traffic Transformer在训练中比DCRNN快,但比STGCN和GWN慢。在测试中,一步预测模型的效率显著,Traffic Transformer比DCRNN快,但比STGCN和GWN慢。

4.4 Model Interpretation

我们的实验表明,具有可学习邻接矩阵的模型能够更好地学习空间关系,尤其是在长期预测方面。在全局编码器和全局局部解码器中,交通转换器通过多头注意力来学习空间关系。每个多头注意的动态、分层的注意权矩阵与相邻矩阵相似,可以揭示学习到的空间关系。

我们设计了另一个实验,以更好地展示Traffic Transformer学习的动态和分层时空特征。选取几批试验数据投影到训练模型中,返回注意权矩阵进行分析。例如,我们在metro – la的测试集中选择了三个批次,分别在

0:00 AM、8:00AM、4:00PM

三个不同的时间段。这些批被分别投射到我们训练好的模型中。

将每个多头注意层和每个数据集的注意权值矩阵缩放为(0,1)

,如

图5

所示。Global编码器中的注意权矩阵称为“源权”,在图中缩写为“src”;Global- local解码器中的第一个注意权矩阵称为“目标权”,在图中缩写为“tgt”;Global- local解码器中的第二个注意权矩阵称为“内存权”,在图中缩写为“mem”。

图5:不同时间段的注意力权重矩阵。(a) :注意权重矩阵0:00 AM批次;(b) :注意上午8:00批次的权重矩阵;(c)注意下午4:00批次的重量矩阵。

在每个关注权重的热图中,权重的第

i

i

i

行和第

j

j

j

列表示

s

e

n

s

o

r

i

sensor_i

s

e

n

s

o

r

i

和

s

e

n

s

o

r

j

sensor_j

s

e

n

s

o

r

j

的影响。如

图5

所示,一些行和列的权值比其他的大很多,这意味着这些行和列对应的节点对几乎所有其他节点都很重要。这表明,这些节点对图中的大多数节点都有影响,而其他节点的影响较弱。不同时段、不同层次的源关注权值不同,

Traffic Transformer能够基于输入数据动态分层提取全局空间特征。目标注意力权重看起来非常相似。这是因为目标注意权值使用了预定义的K-hop邻接矩阵来关注局部。内存注意权值表明全局和局部特征是如何融合的

。它们的图显示了与源关注权重热图相似的特征,融合图中一些节点对大多数节点有影响,而另一些则没有。

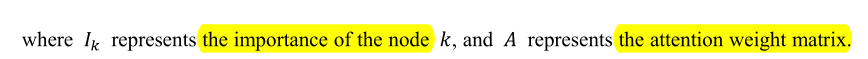

为了进一步证明我们的观察结果,我们通过定义

每个节点的重要性

其中,对均值大于一个标准差的节点被定义为

影响节点

。

1) Dynamicity

我们在metro – la测试集中选取了两批数据。一个在上午8点,另一个在下午4点。将这两批数据发送到训练好的模型中,并将所有多头注意力块中的注意力权重矩阵连同输出一起返回。我们选择“记忆6”的注意权重矩阵(即:以待进一步分析。选择144号传感器进行分析。选取144号传感器中影响最大的10个传感器,绘制在

图6

中。如图6所示,红点表示NO.144传感器。蓝色点表示上午8:00时段影响最大的10个传感器,橙色点表示下午4:00时段影响最大的10个传感器。蓝点位于网络的东部,红点位于网络的西部。需要指出的是,162号传感器与163号传感器的距离很近,但如图6放大部分所示,它们位于同一高速公路路段的不同方向。这意味着Traffic Transformer在不同时间段找到了不同的影响点。这表明我们的Traffic Transformer可以动态地提取空间依赖关系,在我们的模型中相邻关系是动态的,依赖于输入。它突破了传统的基于gcn的模型中相邻矩阵固定的限制,具有更好的性能。

Fig.6 144号传感器在不同时间段的影响传感器。蓝点:上午8:00;橙色圆点:下午4点。放大后的图片显示了同一条路上不同方向的两个传感器。

2) Hierarchy

在metro – la数据集中,我们在测试集中选择了8:00AM的一批数据。我们计算了不同源注意层的影响节点,并将其绘制在地图上,如图7所示。可以看出,大多数有影响的节点都位于交通网络中通常重要的交叉口附近。不同层次的空间特征表现出从全局到局部再到全局的层次特征。在最底层(

图7

(a),第1层),影响节点分布在全网中。但在中间层(

图7

(b)和©,第2层和第4层),影响节点集中在网络的一部分。例如,

图7

(b)所示的代表第二层影响节点的青色点大多集中在网络的东部。在较高层(

图7

(d),第6层),影响节点再次分布在全网中。需要指出的是,有趣的是,在第6层中提取了传感器26(图中左侧)作为影响节点。然而,在metro – la中,第26点是一个孤立的顶点。证明Traffic Transformer能够提取远距离空间特征。

Fig.7 图7:地图上不同层的影响节点:(a)第1层;(b) 2层;(c)第四层;(d)层6。(a)为底层;(b)和(c)为中间层;(d)是最上面一层。(a)和(d)偏好全局特征,(b)和(c)偏好局部特征。

5 Conclusions and Discussions

在本文中,我们提出了一种新的时空图建模和长期交通预测模型。我们提出的交通变压器模型可以高效、有效地通过数据提取动态、分层的交通时空特征。我们选择三个不同的数据集来评估我们的模型在不同情况下是否稳健。将该模型与传统模型、基于gcn模型和烧蚀模型等8种基准模型进行了比较。三种有效性测量方法(MAE, MAPE和RMSE)被用来评估这些模型的准确性。在三个真实的数据集上,Traffic Transformer实现了最先进的结果。帮助人们找到网络中有层次影响的节点。

根据实验结果,我们可以得出以下结论

:(a)全网流量预测具有与自然语言处理相似的特点和挑战。变压器等先进的自然语言处理方法和框架可以适应全网络流量预测问题。(b)在所有交通预测模型中,traffic Transformer在可接受的训练时间内取得了最好的预测结果。由此证明了Transformer在交通预测问题中的强大功能。©训练后的Traffic Transformer模型提取的有影响的传感器不在局部。这表明路网空间依赖关系可能在距离上存在较大差异,传统的基于距离的相邻矩阵存在局限性。(d)不同时段具有不同影响传感器,意味着路网空间依赖关系是动态的,传统的固定相邻矩阵具有局限性。(d)空间依赖是分层的,深度模型可以从全局或局部提取这些特征。(e) 随着网络复杂性的提高,定义一个足够好的邻接矩阵越来越困难,而人为定义矩阵的错误对模型的危害也越来越不可避免。让模型学习空间相关性在这些情况下更好地提高性能。然而,在网络复杂度适中的情况下,使用预定义的邻域矩阵来帮助模型更好地了解“局部”可以提高性能。

在未来的工作中,该模型可以扩展到更多的外部信息(如道路特征、不利天气条件和重大事件),以提高预测精度。由于数据的限制,本文仅研究道路网络中的速度预测,但一旦有更多的信息数据,该模型可以扩展到其他交通状态(如流量和密度)和其他交通系统(如地铁网络和非机动车交通系统)。本文将传感器的数量限制在300个以下。这是因为Transformer有

O

(

n

2

)

O(n^2)

O

(

n

2

)

的算法复杂度即当传感器数量过大时,模型将很难训练。然而,最近提出的Transformer的一些变体,如Transformer- xl (Dai等。和Longformer (Beltagy等。, 2020年)可以处理长文档等万级序列。我们将研究使用Transformer的这些变体来处理更大的网络,并找到流量中更深层次的隐藏依赖关系。此外,基于Transformer的语言模型在NLP中也很流行,如BERT (Devlin et.al 2018)和GPT (Radford et.al)。, 2017;雷德福出版社。, 2018)。研究人员认为BERT是一个自动编码(AE)过程,而GPT是一个自回归(AR)过程。在交通时空特征的提取中,空间维度更像是一个AE过程,时间维度更像是一个AR过程。在未来的研究中,一个“语言模型”的流量可能会显示出巨大的性能。