talk

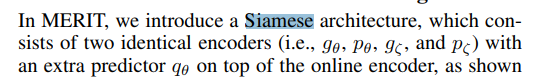

这篇文章也是对比学习,亮点:就是把cv里面的很快用过了,采用动量编码器和project head,同时采用 冻结 target encoder的参数。

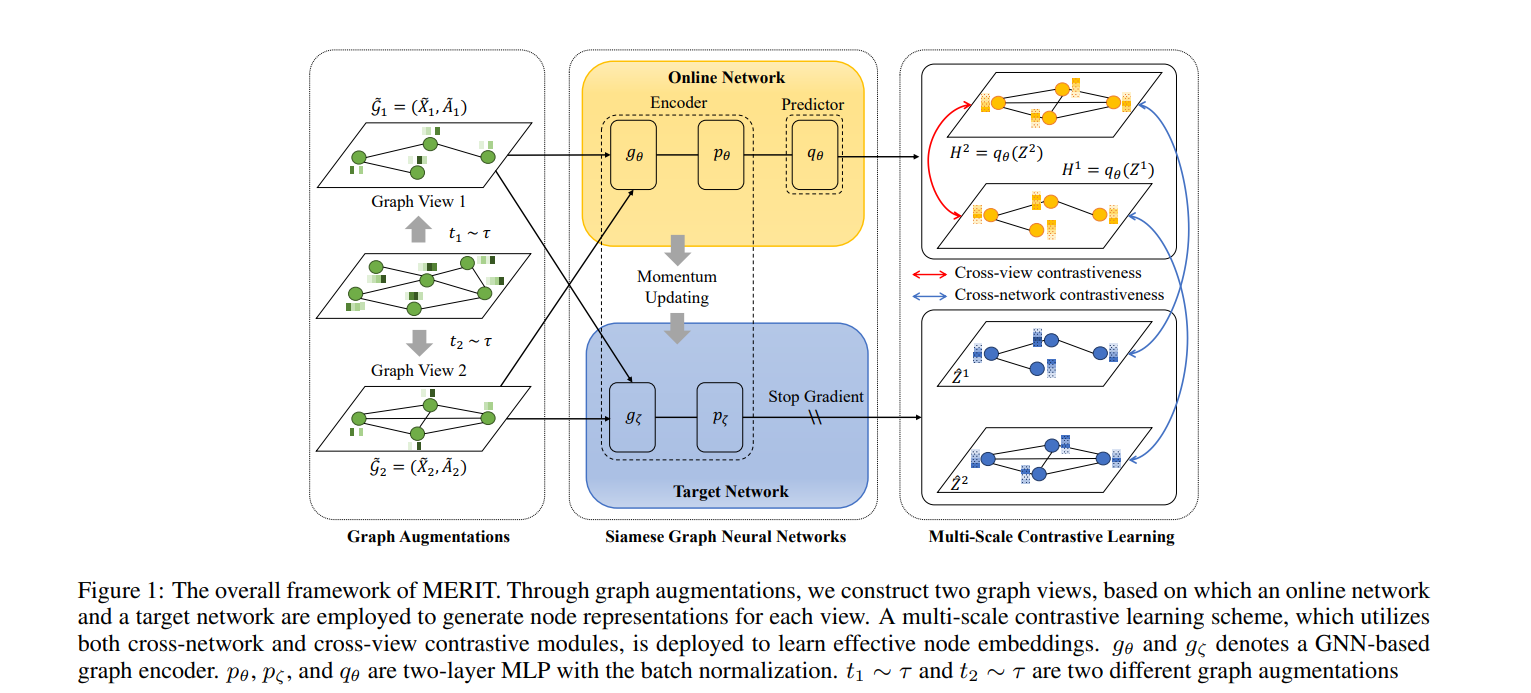

图增强的做法:融合了mvgrl(ppnp+subgraph) +GRACE(修改grace,A:删除一半加一半, X:直接选择p%维度来掩盖)

这个文章的 loss 项 太太太太多了,,,,,,感觉很难复现吧

1. model

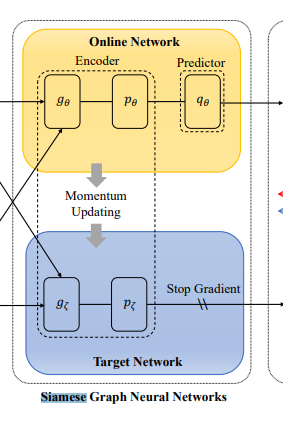

online+target encoder 采用动量形式更新 target ,并停止target的梯度。不知道左边两侧的交叉两个箭头是在干嘛。。。。

———————-看到 cross-view损失才明白,这里是 对于视图1,2 都走一遍上下encoder,上面获得 H1 H2, 下面获得 Z1 Z2

文章在介绍 具体损失时候 不知道是不是 手误,还是我不理解,感觉 这个第一个Z2应该是 H2

那么模型 右边 H1, H2就是表征,Z1,Z2 就是 两个网络学到的节点嵌入。

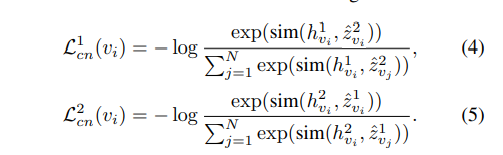

1.1 Cross-Network Contrastive loss 两个encoder之间的hz对比

视角1嵌入和视角2表征。 视角2嵌入和视角1表征 进行对比

这里等价于 grace 就是 infonce损失,这里只不过是 每个 嵌入 z 经过 predictor 得到 表征h。 如果不是 h 都是 z,两个损失之和就等价于GRACE的损失。

这里有一处不明白,作者说只有 online encoder 才有 predictor, 那么这里的 h2∈H2 是怎么得来的?? – 后面知道是 G2 输入到上面 online

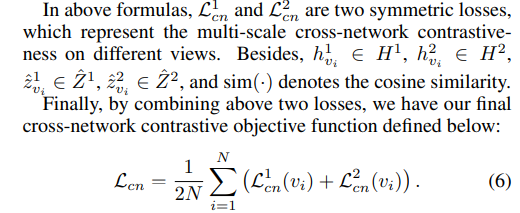

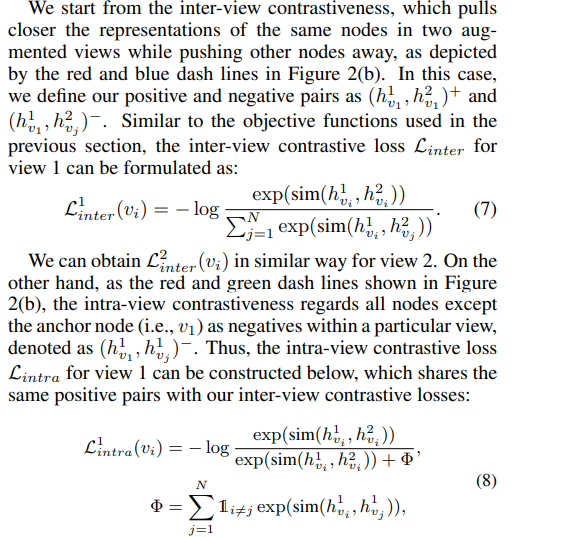

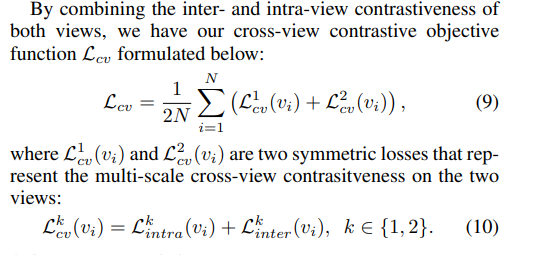

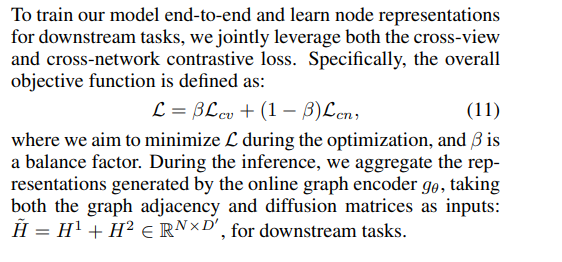

1.2 Cross-View Contrastive loss online networ 里面的两个视角对比

这里是 两个 h 进行对比 形式上 完全和 GRACE对比一样,作者这里提了一下,和GRACE不同的地方是 获得视角的形式不同。 GRACE是对 AX干扰,而他采用了 ppnp获得了全局视野

上面这个 Linter就是 GRACE的损失,两个视图 相同节点拉近,视图1 和视图2中不同id拉远

intra和inter分子一样,都是拉近两个相同id的节点,分母是 推开 同一个视图,视图1里面的其他节点

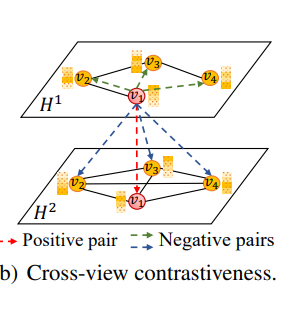

红色—分子, 蓝色 inter的分母 绿色 intra的分母,之前的工作一般不 进行绿色(intra)的推拉,都是 不同视图 间 相同节点id 拉近,不同节点id 推远

1.3 做法

按照正常的 逻辑, 产生的两个视图就应该 各自 通过各自的 encoder 生成 H,来形成对比,类似MVGRL 视图1 和视图2. 视图2 和视图1. 就相当于这里的 cross-network的损失。。

然而,本文是 两个视图 还都送入到 online的 encoder, 因此 又进行了 inter和intra loss(cross-view),这个损失 类似于 一个共享参数的encoder 形成对比。

都可以拆开成为两个工作。 但都没什么创新。

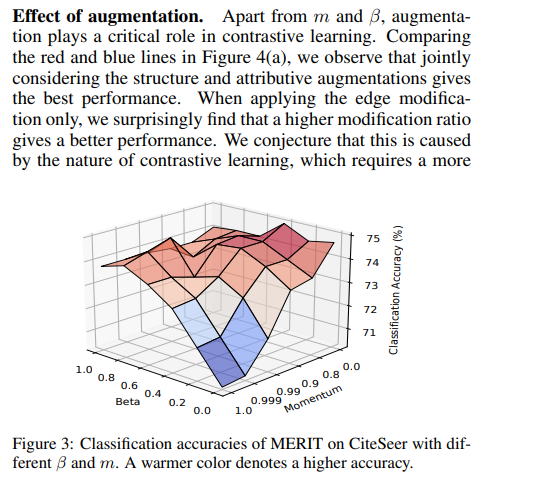

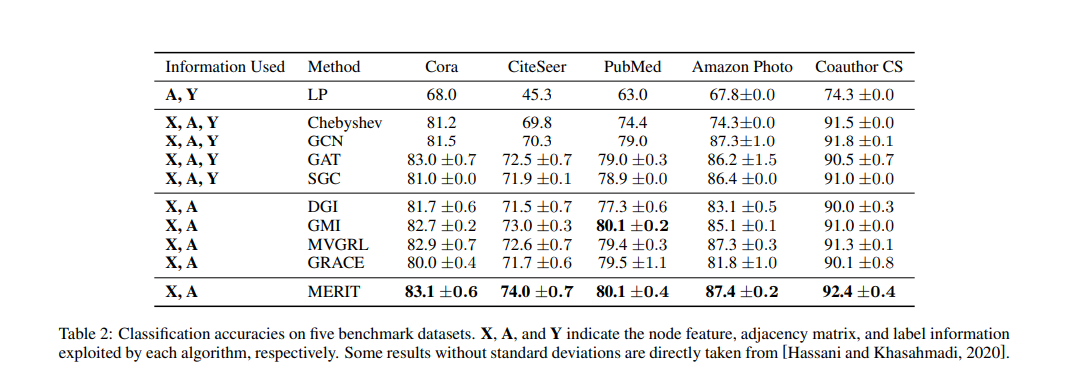

2. 实验

图挺好看的,aaai和ijcai的色调

效果上cora citeseer的效果很好,但是 本文的 github 有留言,说是method 的acc不是 收敛后取得,而是取的 best。

感觉其实并不是 越多越好,本文就是 疯狂堆叠+占坑站得早(动量encoder)+写的高级(cross-view+network)

本文最让我 疑惑的 地方 是 siamese网络,看完了 其实我还没注意到 孪生网络的身影,专门搜了一下啊,这两个encoder叫做孪生网络,本科毕设时候看过,依稀记得是 共享权重的网络,再次百度了一下,还是共享权重,输入两个样本,输出 相似度么,,, 这里感觉 不是孪生网络吧,,,, 如果勉强要说, online encoder是 孪生网络,他接收G1,G2,后面生成 H1,H2 来对比。。。。 真是 有个表征就对比,,,,挺烂的,要不是 S. Pan 发了 GGD,挺不喜欢这个组