前提准备:

1.ES+kibana+logstash 一台虚拟机配置运行内存3G,由于本人电脑资源有限开了2台

2.kafka+zookeeper 一台虚拟机,运行内存1G

共7个G

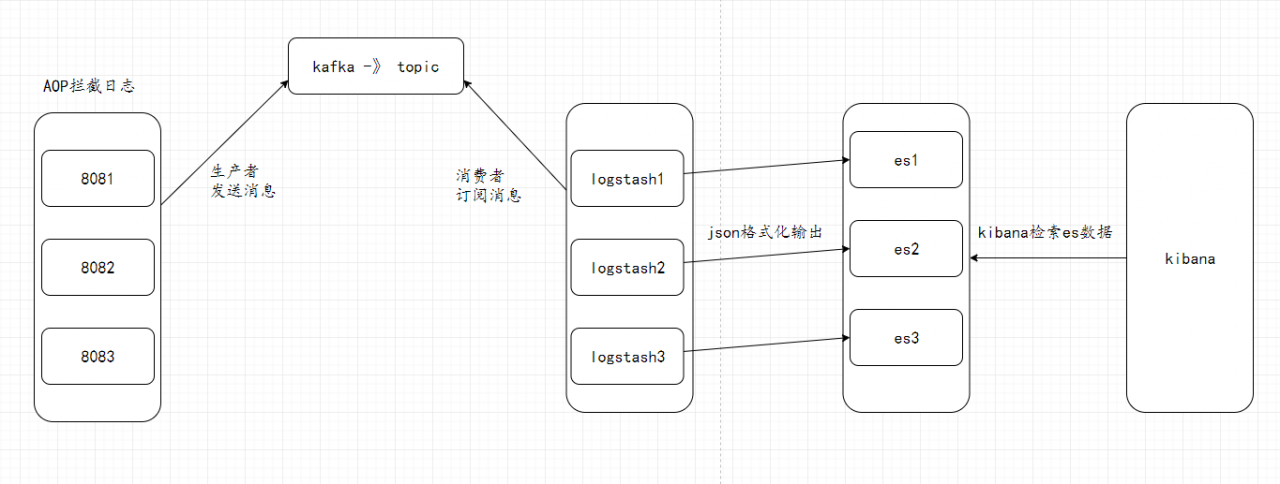

原理图:

更加详细的原理elk原理可以看我之前的一篇文章,有专门说到,这里就不说了

一、安装jdk

1.安装之前先检查一下系统有没有自带open-jdk

命令:

rpm -qa |grep java

rpm -qa |grep jdk

rpm -qa |grep gcj如果没有输入信息表示没有安装。

如果安装可以使用rpm -qa | grep java | xargs rpm -e –nodeps 批量卸载所有带有Java的文件 这句命令的关键字是java

2.首先检索包含java的列表

yum list java*3.检索1.8的列表

yum list java-1.8*4.安装1.8.0的所有文件

yum install java-1.8.0-openjdk* -y5.使用命令检查是否安装成功

java -version二、集群环境下基于docker安装es和kibana

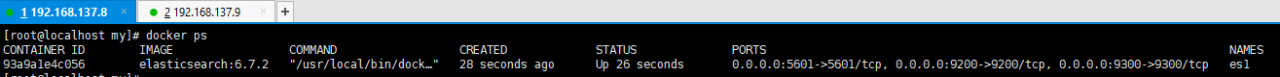

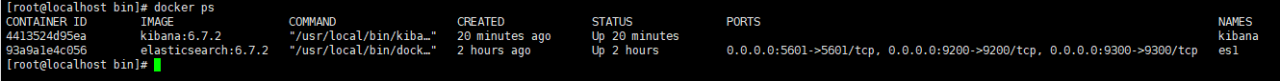

启动两个虚拟机 分别在不同的虚拟机启动es容器和kibana

启动虚拟机1,es名称为:es1

下载es 和 kibana

docker pull elasticsearch:6.7.2

docker pull kibana:6.7.2

运行容器

docker run -it --name es1 -d -p 9200:9200 -p 9300:9300 -p 5601:5601 elasticsearch:6.7.2

docker run -it -d -e ELASTICSEARCH_URL=http://127.0.0.1:9200 --name kibana --network=container:es1 kibana:6.7.2

启动虚拟机2,es名称为:es2

下载es 和 kibana

docker pull elasticsearch:6.7.2

docker pull kibana:6.7.2

运行容器

docker run -it --name es2 -d -p 9200:9200 -p 9300:9300 -p 5601:5601 elasticsearch:6.7.2

docker run -it -d -e ELASTICSEARCH_URL=http://127.0.0.1:9200 --name kibana --network=container:es2 kibana:6.7.2

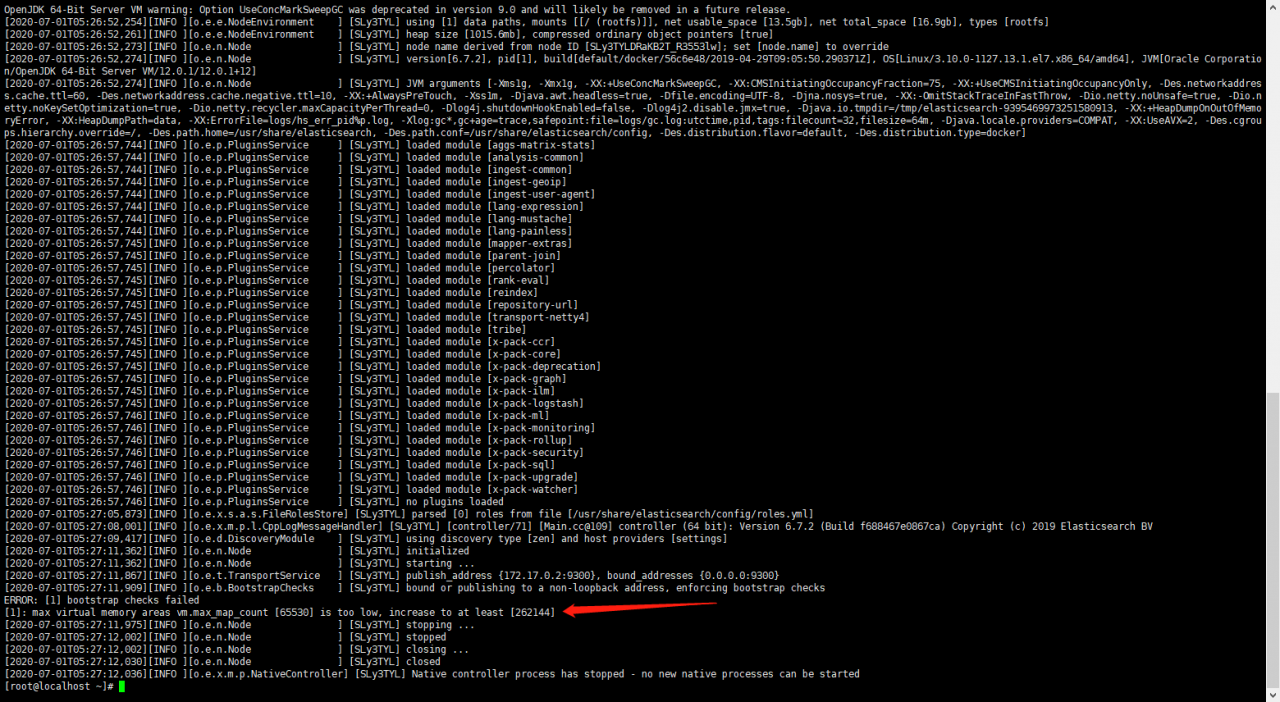

如果在启动的ES过程中,报如下错误

解决方案:

分配给ES的内存太小了

1.进入etc目录,编辑sysctl.conf文件:

vi /etc/sysctl.conf2.添加配置:

vm.max_map_count=262144 或者 6553603.执行:

sysctl -p重启服务器

三、配置ES集群

进入容器修改集群配置服务器1

#进入容器

docker exec -it 容器ID /bin/bash

#编辑配置文件

vi /usr/share/elasticsearch/config/elasticsearch.yml

#注释掉原有的配置 添加配置

cluster.name: elasticsearch-cluster

node.name: es-node1

network.bind_host: 0.0.0.0

network.publish_host: 192.168.137.8

http.port: 9200

transport.tcp.port: 9300

http.cors.enabled: true

http.cors.allow-origin: "*"

node.master: true

node.data: true

discovery.zen.ping.unicast.hosts: ["192.168.137.8:9300","192.168.137.9:9300"]

discovery.zen.minimum_master_nodes: 2

#保存退出

#退出容器

exit

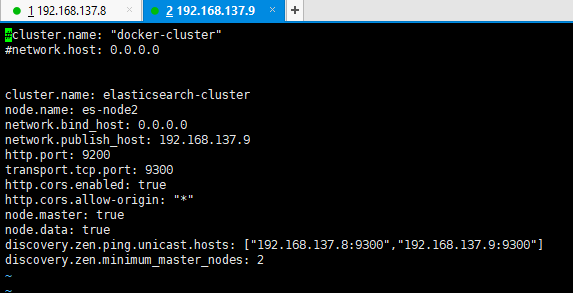

进入容器修改集群配置服务器2

#进入容器

docker exec -it 容器ID /bin/bash

#编辑配置文件

vi /usr/share/elasticsearch/config/elasticsearch.yml

#注释掉原有的配置 添加配置

cluster.name: elasticsearch-cluster

node.name: es-node2

network.bind_host: 0.0.0.0

network.publish_host: 192.168.137.9

http.port: 9200

transport.tcp.port: 9300

http.cors.enabled: true

http.cors.allow-origin: "*"

node.master: true

node.data: true

discovery.zen.ping.unicast.hosts: ["192.168.137.8:9300","192.168.137.9:9300"]

discovery.zen.minimum_master_nodes: 2

#保存退出

#退出容器

exit

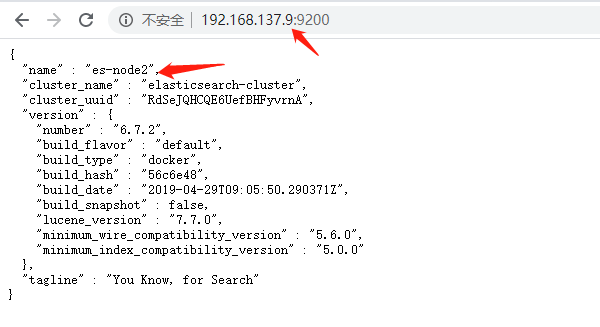

最后重启两个服务器docker里面的es,让配置进行生效

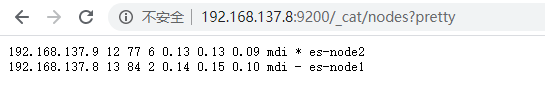

docker restart 容器id网页访问集群的两台es,可以发现es配置已经生效了

但是这样还并不能确定是否成功集群,访问如下ES集群其中任何IP地址即可

http://192.168.137.8:9200/_cat/nodes?pretty如下图,就代表es集群成功搭建

五、下载zk和kafka源码包

在公司里面,正常情况下,zk不会和es放在一起的,所以我这里额外开了一个虚拟机运行zk和kafka

正常来说kafka应该是集群,由于本人资源有限,就单机版本了

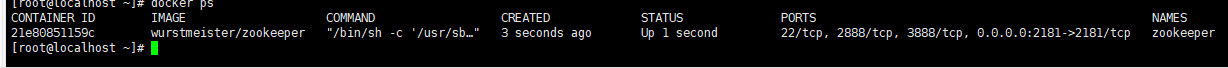

基于docker下载zookeeper源码包

docker pull wurstmeister/zookeeper运行zookeeper

docker run -d –name zookeeper -p 2181:2181 -t wurstmeister/zookeeper

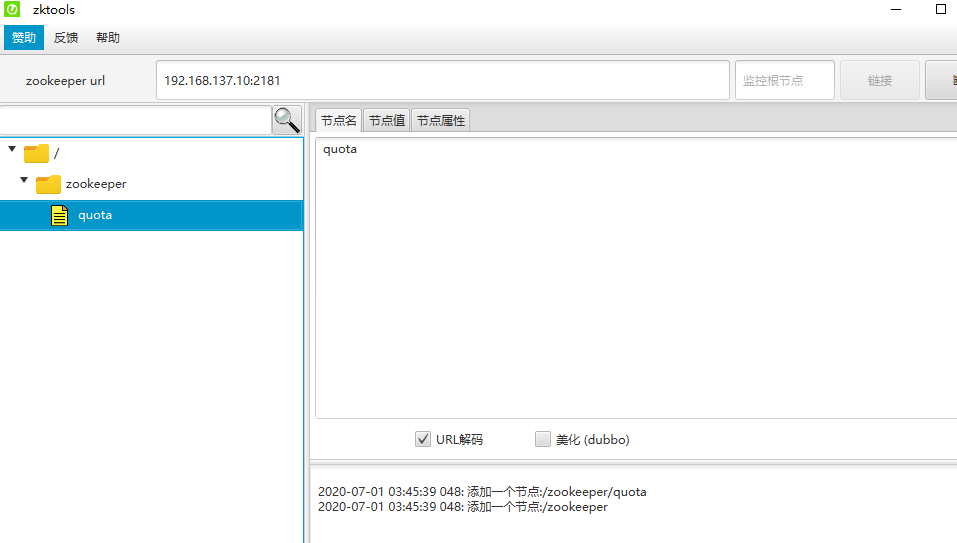

通过工具连接zk

基于docker下载kafka源码包

docker pull wurstmeister/kafka运行kafka

docker run --name kafka01 \

-p 9092:9092 \

-e KAFKA_BROKER_ID=0 \

-e KAFKA_ZOOKEEPER_CONNECT=192.168.137.10:2181 \

-e KAFKA_ADVERTISED_LISTENERS=PLAINTEXT://192.168.137.10:9092 \

-e KAFKA_LISTENERS=PLAINTEXT://0.0.0.0:9092 \

-d wurstmeister/kafka

进入容器

docker exec -it d0ac77407dd1 /bin/bash创建topic

/opt/kafka/bin/kafka-topics.sh --create --zookeeper 192.168.137.10:2181 --replication-factor 1 --partitions 1 --topic sunny-topic查询所有topic

/opt/kafka/bin/kafka-topics.sh --list --zookeeper 192.168.137.10:2181查看某个topic所有的消息

/opt/kafka/bin/kafka-console-consumer.sh --bootstrap-server 192.168.137.10:9092 --from-beginning --topic sunny-topic六、下载logstash源码包

下载源码包

官方地址

https://www.elastic.co/cn/downloads/logstash

国内加速下载网址

https://www.newbe.pro/Mirrors/Mirrors-Logstash/

下载地址

wget https://mirrors.huaweicloud.com/logstash/6.7.2/logstash-6.7.2.zip

下载zip命令解压

yum -y install zip

解压

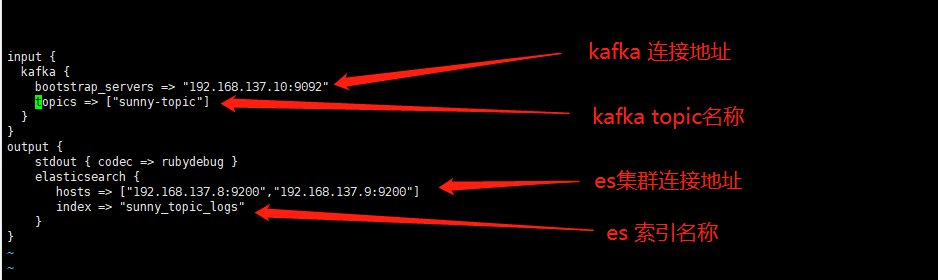

unzip logstash-6.7.2.zip修改配置文件

进入到logstash/config目录

#新建sunny_log.conf文件

vim sunny_log.conf

#添加配置文件

input {

kafka {

bootstrap_servers => "192.168.137.10:9092"

topics => ["sunny_topic"]

}

}

output {

stdout { codec => rubydebug }

elasticsearch {

hosts => ["192.168.137.8:9200","192.168.137.9:9200"]

index => "sunny_topic_logs"

}

}

保存退出

添加完配置后,进入logstash/bin目录下,启动logstash

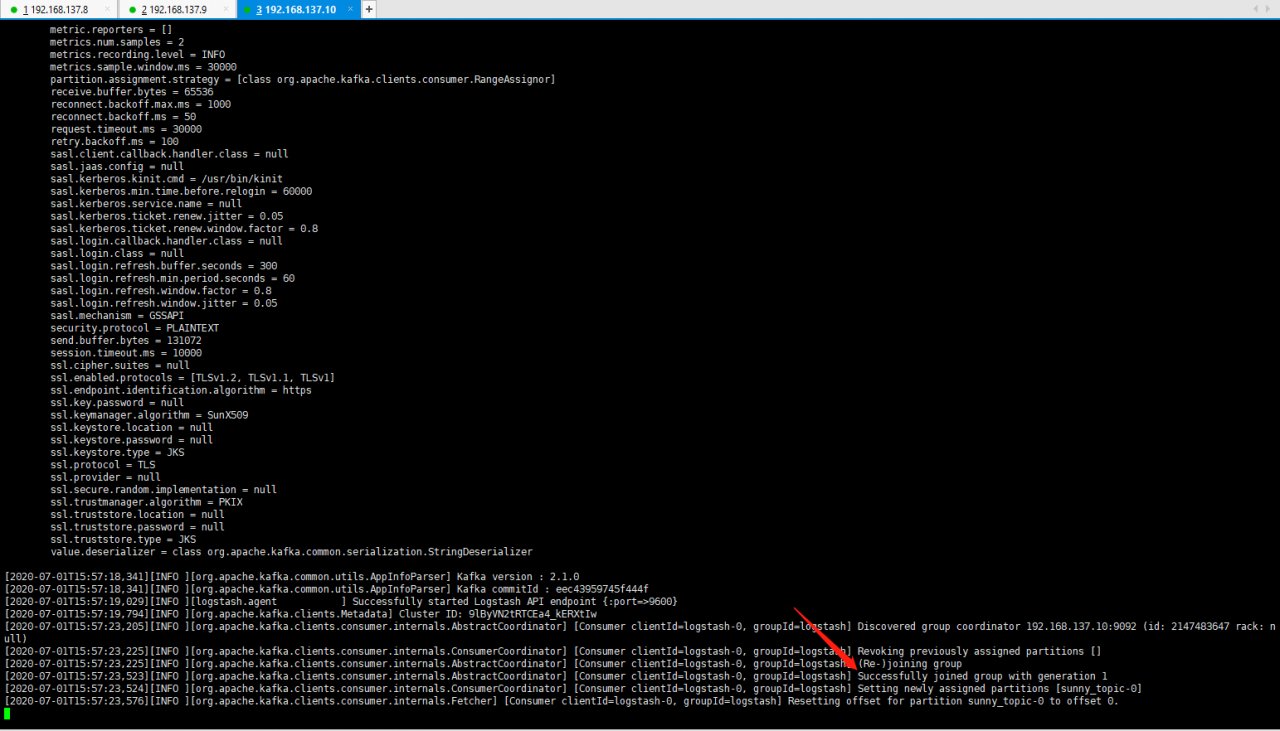

./logstash -f ../config/sunny_log.conf启动成功

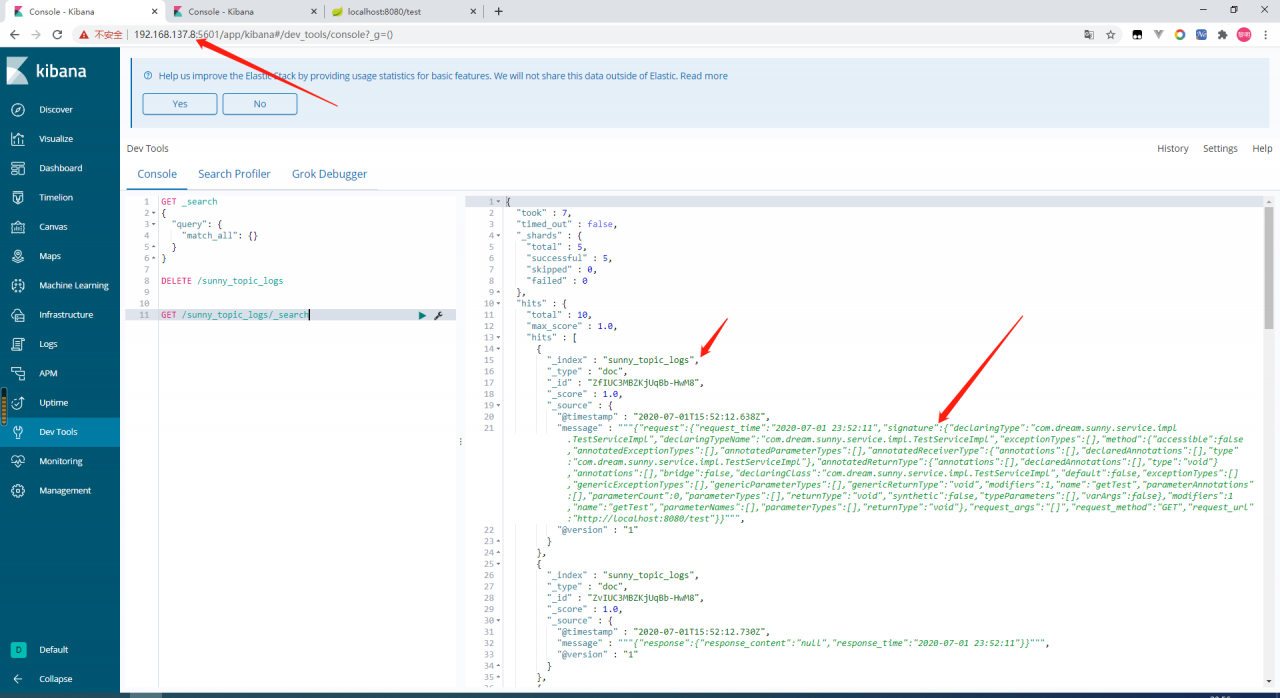

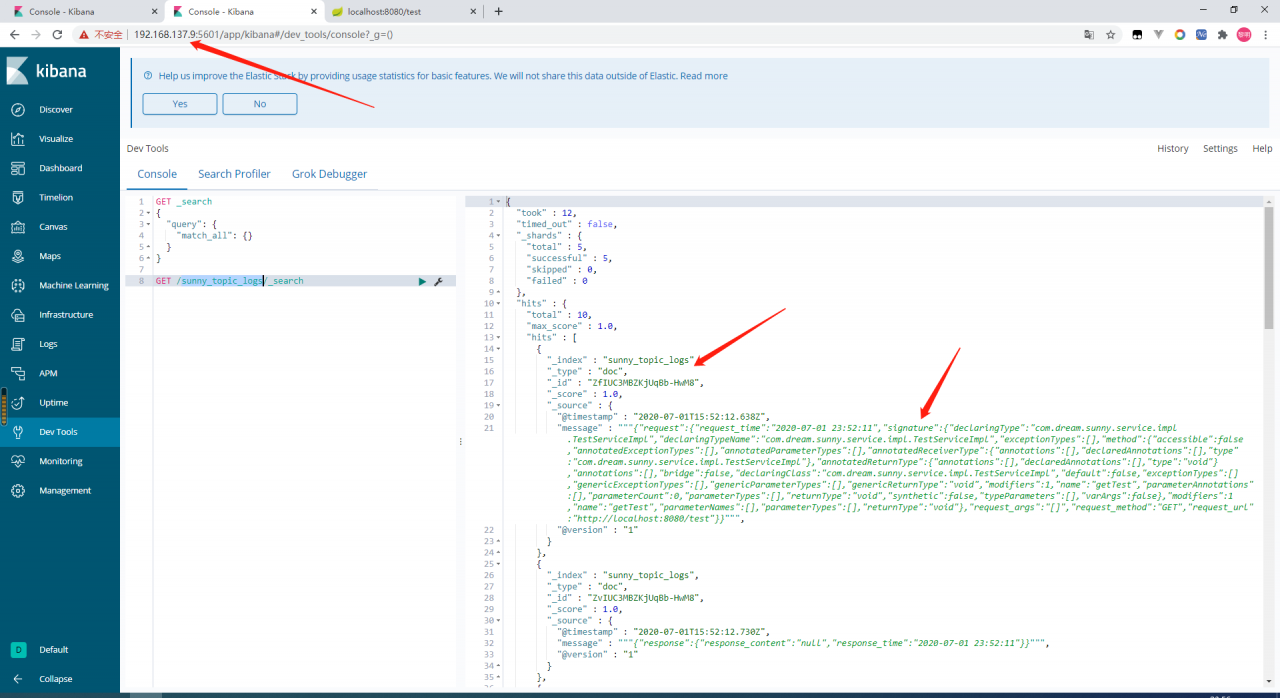

接收到kafka消息后,同步数据到es

启动kibana(两台es服务中的kibana都可以启动,启动其中一台也行,因为logstash会将数据同步到两台服务器中)

docker run -it -d -e ELASTICSEARCH_URL=http://127.0.0.1:9200 --name kibana --network=container:es2 kibana:6.7.2