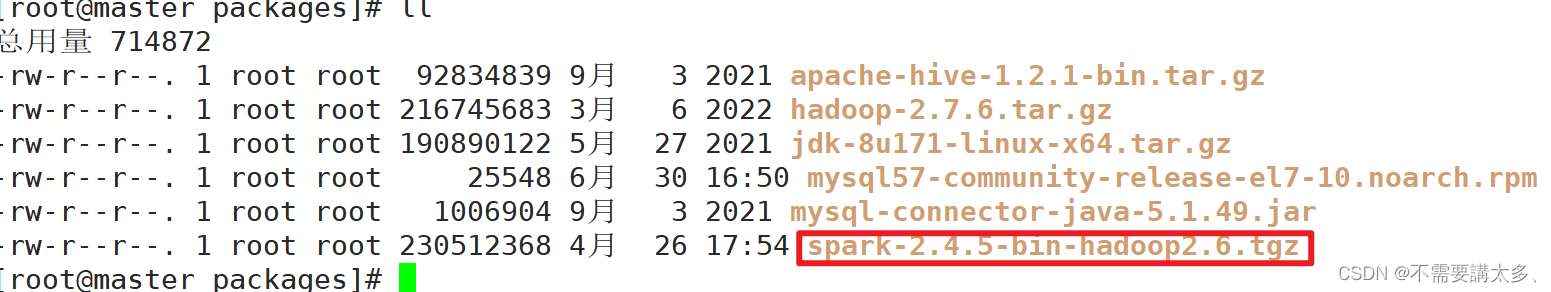

一,将spark压缩文件上传至Linux相应目录下,并进行解压。

解压到指定目录:

tar -zxvf spark-2.4.5-bin-hadoop2.7.tgz /目录重命名:

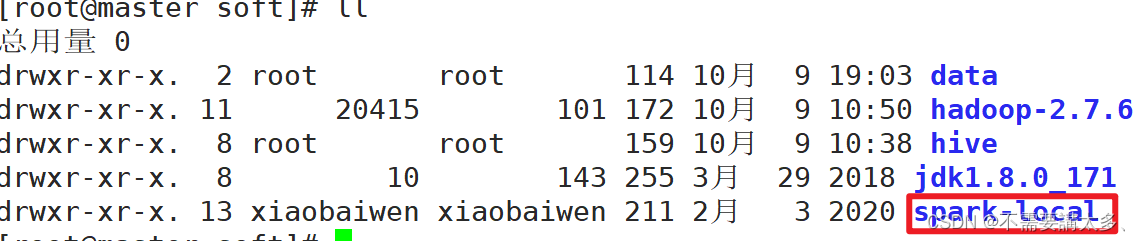

mv spark-2.4.5-bin-hadoop2.7/ spark-local

二,配置环境变量:

进入根目录

vi ~/.bashrc

在里面添加配置:

export SPARK_HOME=/usr/soft/spark-local

export PATH=$PATH:$SPARK_HOME/bin

注意SPARK_HOME的配置目录是你自己的压缩spark(spark-local)文件目录

最后:source一下

source ~/.bashrc三,启动local环境:

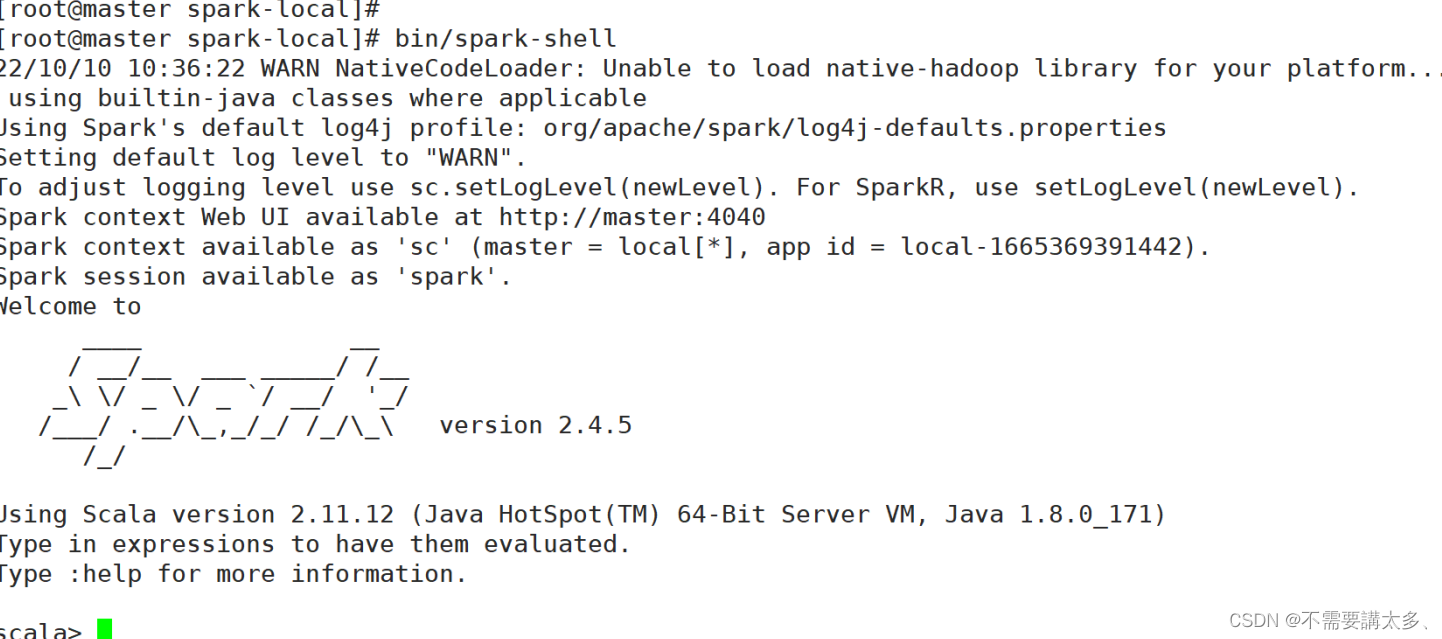

进入压缩(spark-local)目录下,执行以下命令

bin/spark-shell

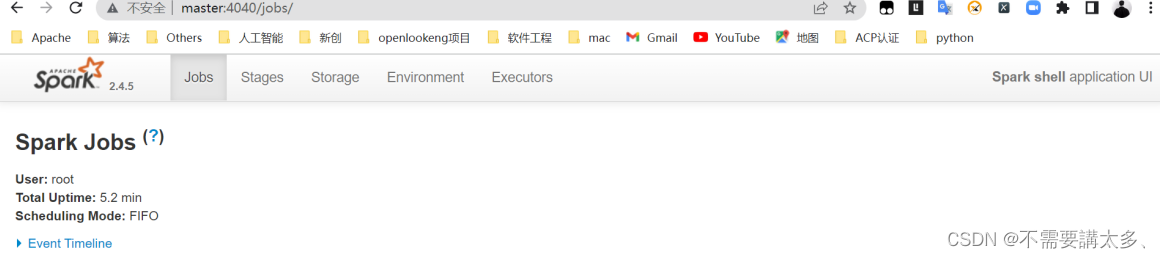

启动成功后可以输入网址进行Web UI监控页面访问:

http://master:4040

注意|:master是自己的主机名

如果输入自己主机名加载不出网址就把主机名改成自己虚拟机的IP地址

四,退出本地模式:

按键CTRL+C或者输入Scala命令:

:quit

版权声明:本文为weixin_54354021原创文章,遵循 CC 4.0 BY-SA 版权协议,转载请附上原文出处链接和本声明。