几篇文章比较相像,单独记录一下再做对比。

一、 cyclegan

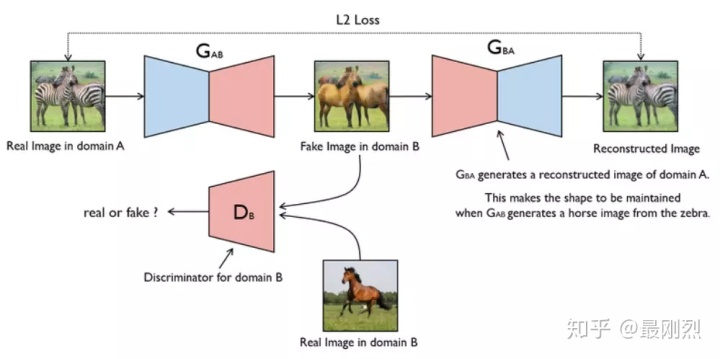

1、单向

上图是一个加了重构loss的单向gan。有两个生成器和一个鉴别器,两个loss(生成器的重建Loss和判别器的判别Loss)

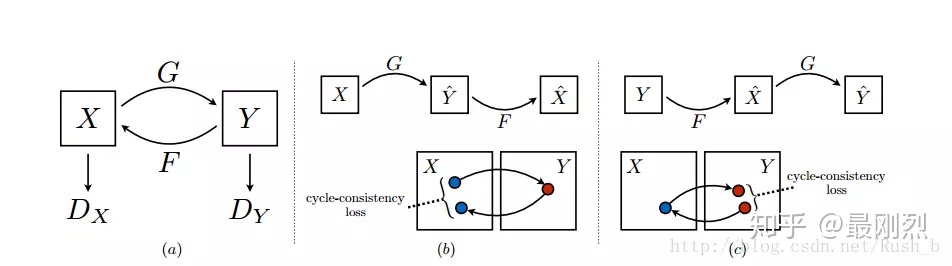

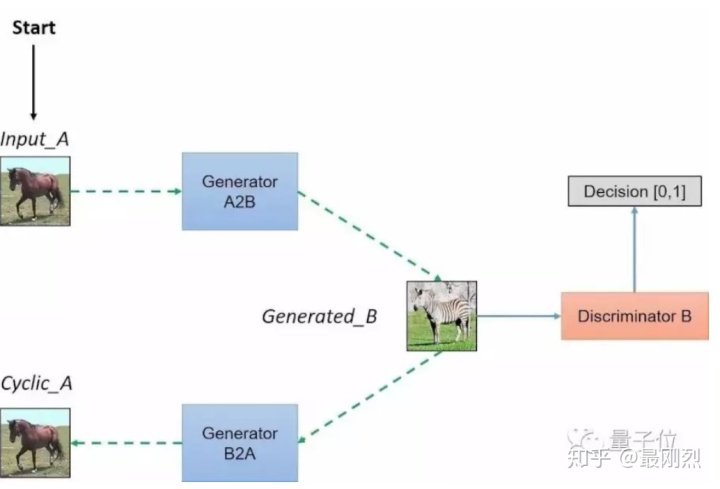

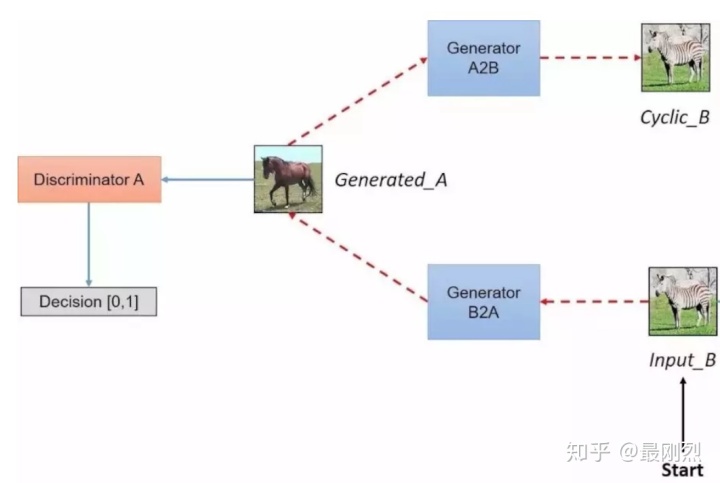

2、cycle

CycleGAN本质上是两个镜像对称的GAN,构成了一个环形网络。两个GAN共享两个生成器,并各自带一个判别器,即共有两个判别器和两个生成器。一个单向GAN两个loss,两个即共四个loss。

3、网络结构

生成器由编码器、转换器和解码器构成。

编码

:第一步利用卷积神经网络从输入图象中提取特征。将图像压缩成256个64*64的特征向量。

转换

:通过组合图像的不相近特征,将图像在DA域中的特征向量转换为DB域中的特征向量。作者使用了6层Reset模块,每个Reset模块是一个由两个卷积层构成的神经网络层,能够达到在转换时同时保留原始图像特征的目标。

解码

:利用反卷积层(decovolution)完成从特征向量中还原出低级特征的工作,最后得到生成图像。

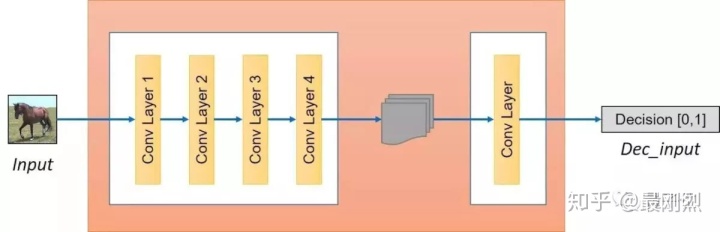

鉴别器将一张图像作为输入,并尝试预测其为原始图像或是生成器的输出图像。鉴别器本身属于卷积网络,需要从图像中提取特征,再通过添加产生一维输出的卷积层来确定提取的特征是否属于特定类别。

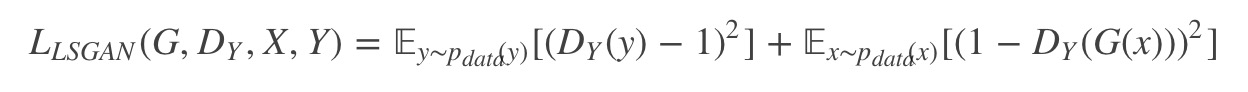

论文里面提到判别器如果是对数损失训练不是很稳定,所以改成的均方误差损失,如下

二、孪生三兄弟

这三篇论文的想法十分相似,几乎可以说是孪生三兄弟,并都取得了不错的结果。不过,这三兄弟的诞生原因也有迹可循。今天就稍微整理一下这三篇相似论文的发展脉络:它们彼此之间的异同,以及它们与前人工作的相似之处。文章总结自Bessie的csdn博客。

CycleGAN 的开头非常优美和引人入胜,先是放出了这些 impressive 的 result;同时用一种带逛博物馆的语气写了 Introduction:“

当梵高在一个和煦的春天的早上&#