关注公众号,发现CV技术之美

●

研讨会介绍

●

手与物体的交互在我们的日常活动中经常出现,因为我们会用一只或两只手直接操纵物体或使用各种工具。通过与物体的交互,人们可以轻松掌握各种操纵任务,掌握新技能,并适应复杂和不断变化的环境。最近,人们对理解和生成手和物体互动的兴趣逐渐增加。这一任务可以很好地支持机器人、增强现实和其他重要领域的应用。因为这类应用通常需要详细了解人手在4D(3D空间+1D时间)中与各种物体的动态交互,并努力在4D中合成或执行与人类相同水平的灵巧操作。

我们本次研讨会可以促进对以下主题的讨论:

1.在手与物的互动过程中,哪些信息对感知是重要的?

2.在各种场景、物体和手的变化情况下,如何实现HOI的稳定感知?

3.如何在HOI理解和HOI生成之间建立正确的接口?

4.对人手-物间交互的几何和功能理解如何能促进灵巧的操纵?

5.如何建立机器人基础模型以促进可推广的灵巧操作?

6.模拟/合成手-物体交互的作用是什么,它如何能将HOI的理解与机器人的灵巧操作联系起来?

研讨会将在2023年6月18号举办,我们邀请了一些具有丰富相关经验的领先研究人员在我们的研讨会上做主题报告。我们还将组织一次竞赛,以衡量目前4D HOI几何理解的进展,同时也鼓励更多的研究人员加入这一领域。我们将在全天的研讨会结束时组织一次小组讨论。我们设想,这样的讨论将激发人们的灵感,并刺激4D手-物交互的新研究。更多信息请关注研讨会官网:https://4dhoi.github.io/

●

HOI4D竞赛介绍

●

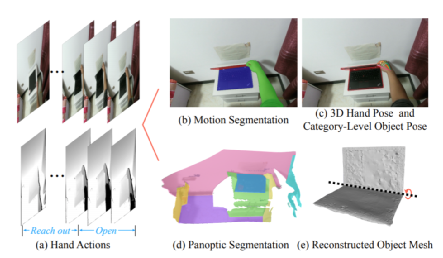

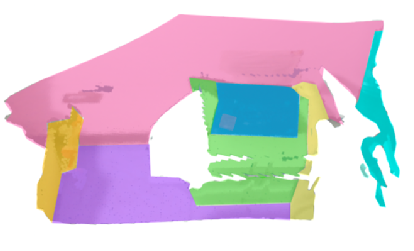

HOI4D数据集提供了用于全景分割、运动分割、3D手部位姿、类别级物体位姿和手部动作的逐帧注释,以及物体CAD模型和重建场景点云。论文还建立了三个基准任务来促进4D类别级人-物体交互的发展,包括 4D 动态点云序列的语义分割、类别级物体位姿跟踪和第一人称的细粒度视频动作分割。此研究可以支持大量的新兴研究方向,如4D场景理解,类别级人-物体交互,动态场景重建等,对人-物体交互领域的发展具有重要推动作用。数据集目前已经开源!

◆论文和项目网址:https://hoi4d.top/

我们首次提出了一个用于类别级人-物体交互的大规模第一人称数据集HOI4D,如图下图所示。我们从最近的类别级物体位姿估计和跟踪工作中汲取灵感,旨在将 4D的人-物体交互感知推进到一个新时代,使计算机视觉系统具备理解复杂场景中的类别级物体交互的能力。HOI4D数据集由240万张RGB-D图像(4000段RGB-D视频序列)组,4个采集者与 800个物体实例交互。这些物体实例平均分为16个类别,包括7个刚性物体和9个关节物体。

此外,我们的采集环境没有像之前的工作一样局限在实验室,而是在 610 个不同的室内场景中执行与物体功能性相关的任务,这一过程中无需佩戴任何人工标记。HOI4D逐帧标注了全景分割、运动分割、3D手部位姿、刚性和关节物体位姿以及动作分割,为类别级别的人与物体交互提供前所未有的细致标注。另外,HOI4D数据集还为每一段采集序列提供了配套的物体CAD模型和静态重建点云。

HOI4Dchallenge

HOI4D动态点云感知任务挑战赛

🔷赛道设置

竞赛HOI4D挑战赛包括以下三个方向:4D语义分割挑战赛、类别级HOI物体追踪挑战赛、4D动作分割挑战赛。

4D语义分割挑战赛中,我们希望推断出每个3D点的语义标签。因此,所有被评估的方法的输入是一个三维点的坐标列表。然后每个方法都应该为扫描的每个点输出一个标签。

🔷

提交评估

我们将维护一个在线排行榜,通过该排行榜,参与者可以测试他们正在进行的项目并提交他们的结果。我们将在我们的服务器上评估并且及时更新排行榜。注意我们只会测试来自学校或公司邮箱注册提交的结果,私人邮箱账号的提交将不被允许。同时来自同一个团队的成员提交的结果我们每周仅测试最早提交的结果,短时间内使用多个邮箱多次重复提交将会被取消评奖资格。

在类别级HOI物体追踪挑战赛中,输入是一个点云视频,给定第一帧中物体的姿势,我们跟踪这个物体,并给出此后每一帧中物体的姿势。请注意,我们指的是类别级别的物体姿态。

在4D动作分割挑战赛中,我们需要给点云视频中的每一帧点云贴上一个动作类别标签。该任务的输入是一个点云视频,输出是该视频中每一帧描述的动作。

🔷

奖金设置

我们为每个赛道的前三名分别颁发3000、2000、1000美元的奖金并且将邀请团队分享他们的杰出工作。

🔷

竞赛时间线

🔹02-07: 挑战赛开始

🔹05-25: 挑战赛截止日期

🔹06-01: 向作者发出获奖通知

🔹06-18: workshop日期

为了降低研究者参与挑战赛的门槛,我们为每个赛道均提供了基线测试方法及其代码,代码及更多详细信息更关注研讨会网站与挑战赛网站(www.hoi4d.top)!

END

欢迎加入「人物交互

」

交流群👇备注:

HOI