在具体的论述之前,先说几个结论:

1.目前只有Nvida GPU能完整的支持深度学习,所以请购买较新的nvidia显卡(pascal、turing架构以上)

2.GPU上的投资回报比基本呈线性变化,因此可以按照自己的需要配置不同GPU。

3.保持工作站长期稳定工作需要一个靠谱的电源,所以在电源选择上追求稳定。

4.在现有预算下,GPU>CPU=RAM>=SSD

5.云服务用起来简单,长期使用却十分昂贵,所以我们要有自己的硬件设施。

1.需求分析

(一)为什么要为深度学习专门配置工作站(服务器)?

1.深度学习需要大量的并行计算资源,而且动辄计算几天甚至数周,而显卡(GPU)恰好适合这种工作,提供几十上百倍的加速,性能强劲的GPU能在几个小时内完成原本CPU需要数月完成的任务,所以目前深度学习乃至于机器学习领域已经全面转向GPU架构,使用GPU完成训练任务。

2.如今即使使用GPU的深度学习任务也要持续数天乃至数月(取决于数据规模和深度学习网络模型),需要使用单独的设备保障保证训练任务能够7×24小时长期稳定运行。

3.独立的深度学习工作站(服务器)可以方便实现实验室计算资源共享,多用户可以在个人电脑编写程序,远程访问到深度学习服务器上排队使用计算资源,减少购买设备的开支并且避免了在本地计算机配置复杂的软件环境。

(二)深度学习工作站配置要求

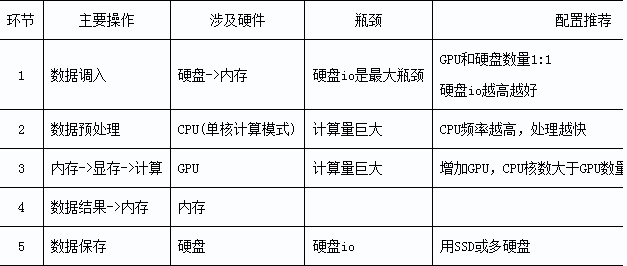

深度学习任务对计算机性能要求较高,各硬件主要完成以下操作:

深度学习计算过程

深度学习计算过程上述图示,深度神经网络计算大致流程,下面通过深度神经网络计算环节,分析核心硬件配置理想要求:

各硬件性能要求

各硬件性能要求

CPU:

因为主要使用显卡进行cuda计算,因此对CPU的要求并不是很高,频率越高、线程数越多越好,一般最低要求cpu核心数大于显卡个数。其中一个制约因素:cpu的最大PCI-E 通道数。每张显卡占用16条pcie通道才能达到最大性能,而单cpu最大支持40条pcie,也就是即使有4个pcie x16接口,只能最多达到2路x16加一路x8,插上的显卡不能发挥全部性能。不过,主板芯片组其实也可以扩充一部分pcie通道。(x99主板可以扩宽2.0的8lanes,z170可以扩充3.0的20lanes)

显卡:

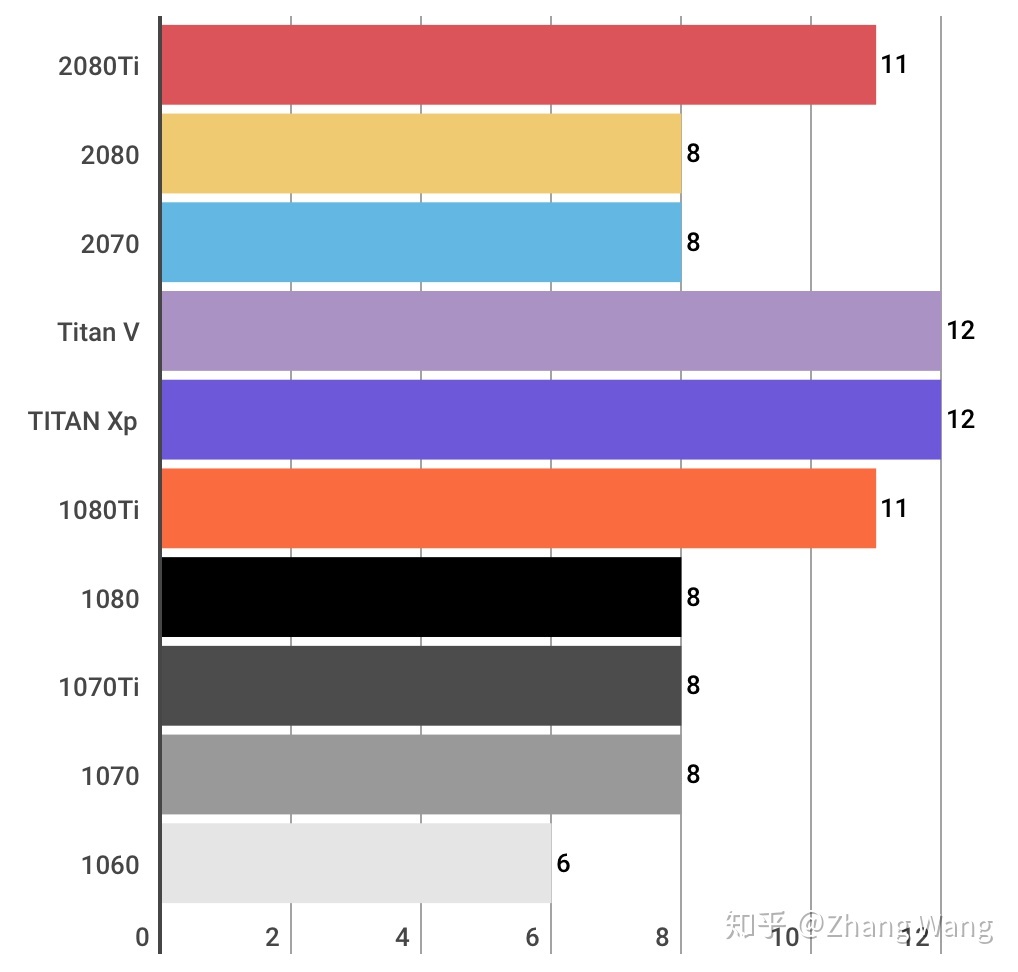

深度学习需要较强性能的显卡进行复杂的单精度运算,通常神经网络需要大量显存和内存资源,因此需要8GB以上显存才能运行大规模的深度卷积网络,执行计算机视觉任务,一般选择GTX1070以上配置。应该购买具有较大显存的显卡。下面给出2080ti、2080、2070、1080ti、1070、1060、Titan X、Titan V的几项指标的对比:

TFLOPS

(teraFLOPS FLoating-point Operations Per Second每秒浮点运算次数)单精度

也就是运算性能,决定了运算速度,首选1080ti、2080ti、Titan V,不过性能最强的titan V的价格是2080ti的三倍

VRAM

(显存):显存大小决定了我们的网络模型能不能执行,大型的卷积神经网络会使用超过8G以上的显存,因此购买具有大显存的显卡才能够保证大多数卷积神经网络模型能够顺利执行。

其中1080ti具有11G显存,能胜任较大的网络模型,性能也比较强,售价大约5000元一张具有最高的性价比。

2080ti是最新的显卡,同样拥有11G显存,但速度是1080TI的1.5倍,售价大约9000元。

Titan V具有12G显存,可以说能够执行绝大多数网络,并且速度是最快的,由于是面向商用,所以其价格也非常感人,约25000元一块。

这三款较为适合深度学习图像处理任务,能完成大多数网络,可以根据预算自由选择。8G显存和6G显存的1080和1060也不失为信价比之选,但是考虑到显存的限制,还是尽量购买具有11G以上的显存的显卡。

主板:

前面提到了cpu提供的pcie通道数的限制,如果要使用多块显卡,就需要主板提供额外的pcie通道,一般只有服务器级别的主板才会提供扩展pcie通道如x99、x299等主板,但是使用此类主板必须搭配具有该接口的服务器级cpu(xeon系列、i7 7900x以上、i9系列等),如果不需要三块以上的显卡,使用cpu提供的40lane pcie即可。

内存:

深度学习需要大量数据,中间计算过程也会临时储存大量数据,一般要求具有显存2~3倍的内存,32G或64G乃至更高。内存频率越高越好。

最低建议32G DDR4 3200MHz内存(16G*2)约2000元,预算宽裕可升级到64G(约4000元)。

硬盘:

深度学习需要大量数据,和较快的访问速度,一般使用一个较大的固态硬盘作为系统盘和训练数据仓储盘,另外使用hdd机械硬盘作为仓储盘。

建议使用512G以上nVME固态硬盘(800元)搭配几TB(2TB约300元)Hdd作为储存空间

电源、机箱:电源其实还是要买个比较稳定的,因为要保证长期稳定运行会有“无休止”的training。一般使用大品牌的经过80PLUS金牌或铂金认证的电源。只搭配一张显卡700w即可,每多一张增加400w。4*titan V大概使用1600w电源。

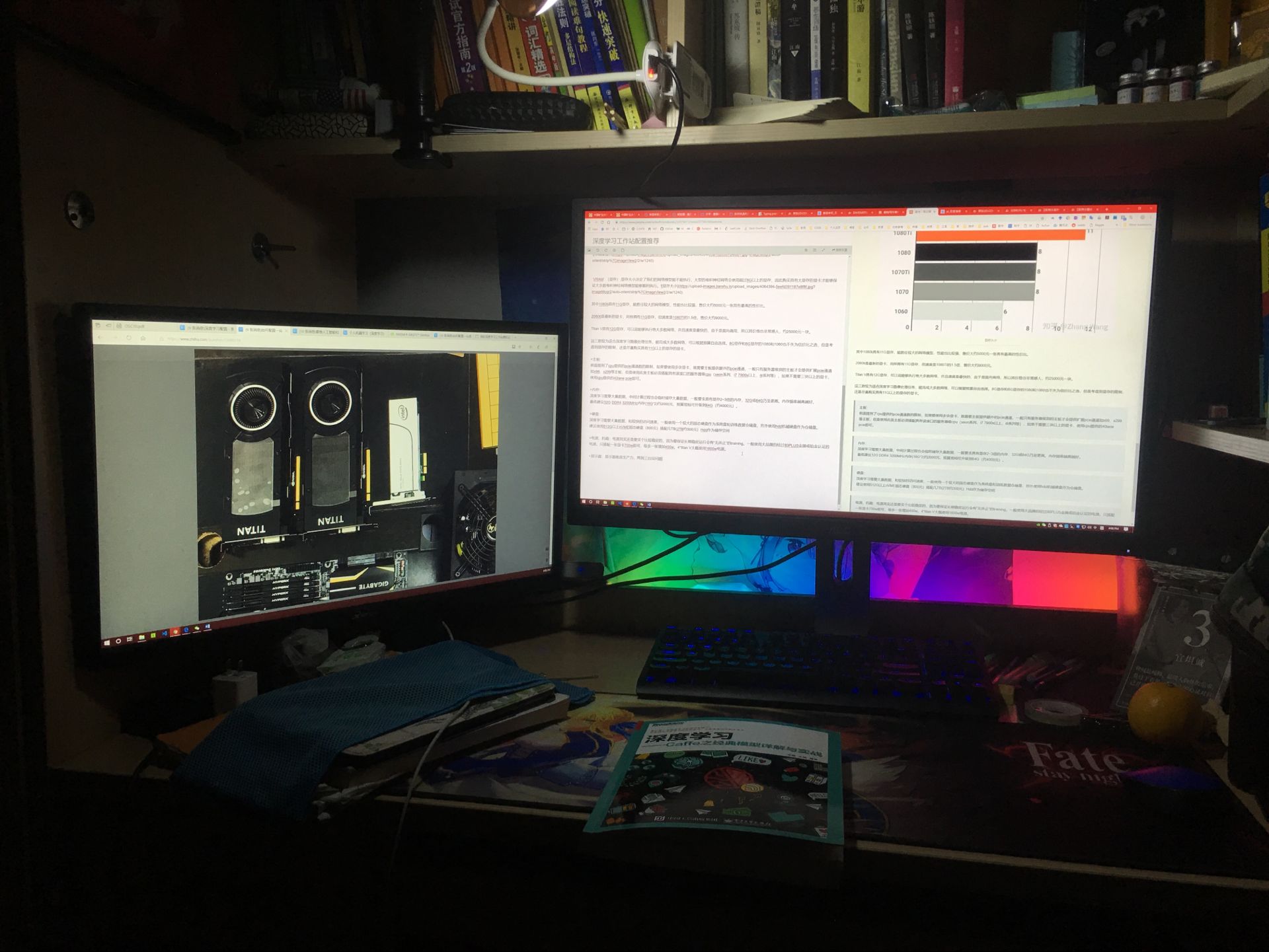

显示器:显示器就是生产力,两到三台没问题。这是我的工作环境,两台显示器,一台查看运行状态,另一个查文献资料调试。

6.jpg

6.jpg

2.配置推荐

讲完了基本需求,我们来到正题,推荐几个不同价位的配置样板,分别是

0.深度学习入门配置 i5 8400+GTX 1060/1070/1070ti +16G RAM +256G SSD 约7000元,这个配置基本上可以尝试大部分模型,如今的网络模型越来越大、越来越深,不免遇到显存不足的情况。不过学习是一个循序渐进的过程,等到你的知识到了需要更高规格的设备,自然知道需要什么样的配置了

1.深度学习个人进阶配置 i7 8700K+GTX 1080TI+32G RAM +512G SSD ,约15000元。有这样一个配置,大多数深度学习项目基本上不会遇到问题,如果有更深层次的需求,到了需要上集群的高水平,应该也知道需要什么样的配置了。我的建议就不管用了。。。

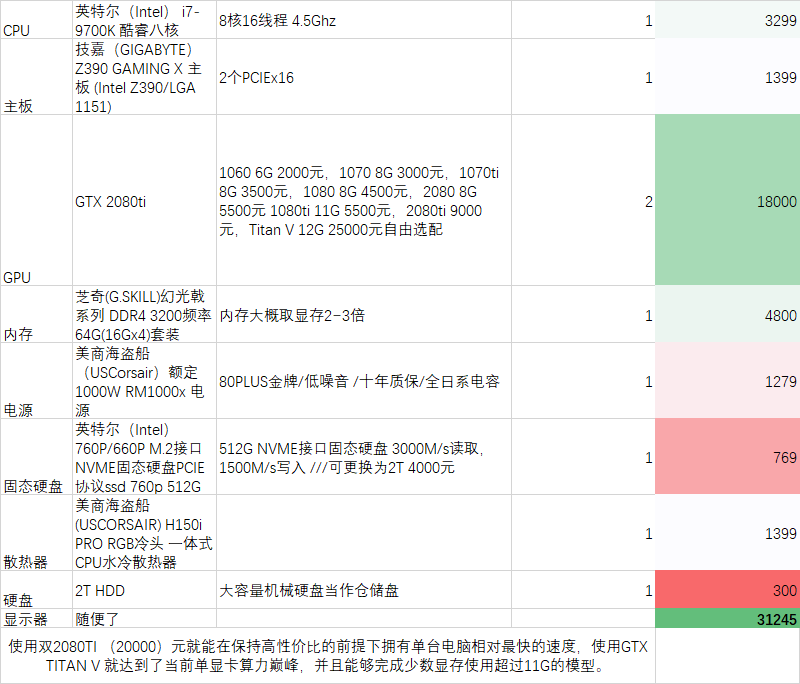

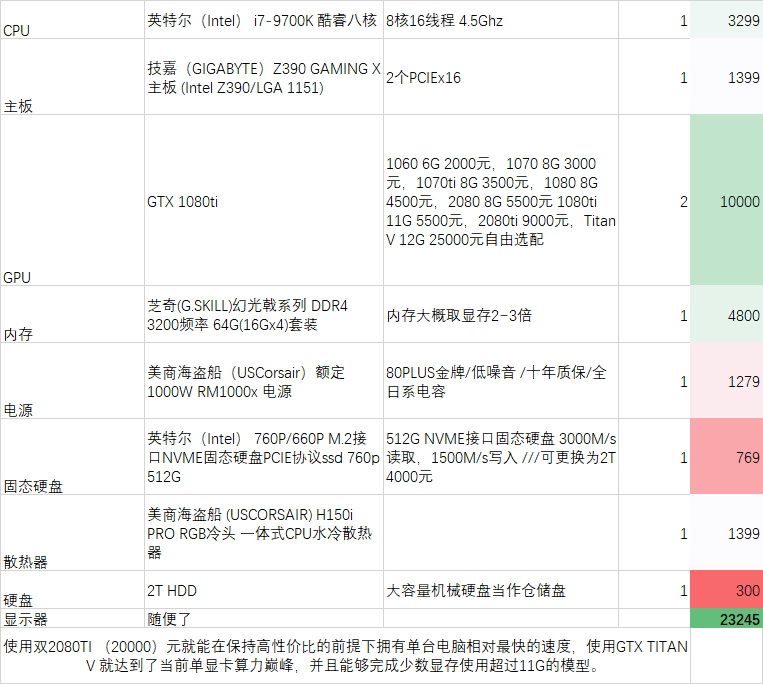

2.深度学习个人完美配置,i7 9700K+GTX 2080TI

2或者GTX TItan V

1+64G RAM +2T SSD。约三万元,如果使用双2080TI (20000)元就能在保持高性价比的前提下拥有单台电脑相对最快的速度,使用GTX TITAN V 就达到了当前单显卡算力巅峰,并且能够完成少数显存使用超过11G的模型。

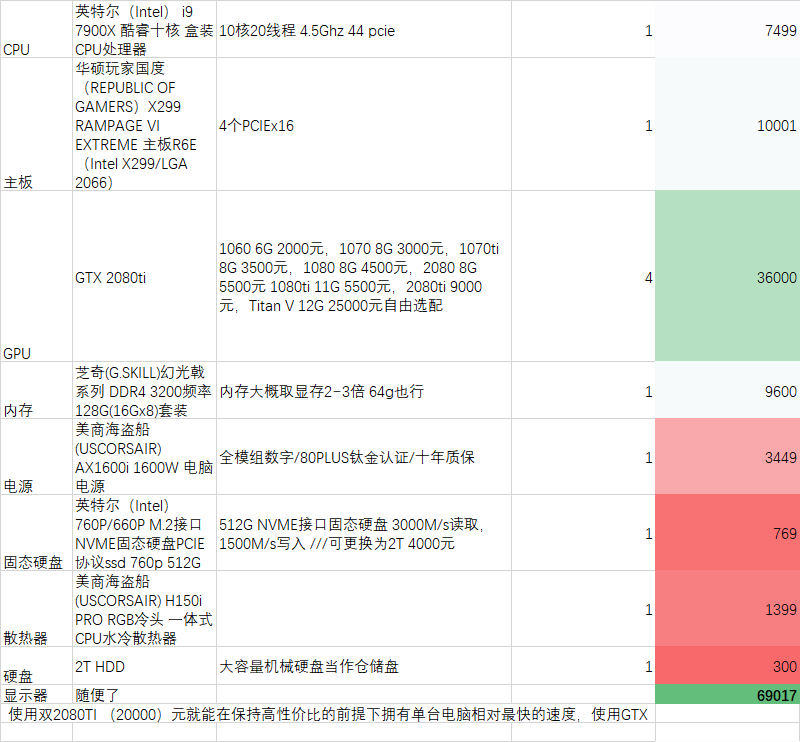

3.深度学习实验室共享服务器,7

24小时运行 2080ti或者4

titan V 其实前两个配置也可以拿来做共享服务器,不过计算资源太少,预算充裕可以专门购置一台高性能多显卡深度学习服务器,24*7小时运行,其他用户可以在自己的笔记本电脑和台式机上编写和初步调试卷积神经网络,本地验证无误后,上传至服务器进行训练任务。这样做可以极大的节省设备开支,最大限度的利用计算资源,也避免了每个用户单独配置复杂的软件环境。

4.深度学习实验室共享服务器单机最高配置。基本上是单台服务器能提供的最高配置,如果要更高配置,可以模仿大型商业研究院在此基础上构建服务器集群。(相当于购买很多台这种配置,使用高速以太网互联。。一个10GE交换机可能要几万块)

0. 深度学习个人入门配置

i5 8400+GTX 1060/1070/1070ti +16G RAM +256G SSD 约7000元,这个配置基本上可以尝试大部分模型,如今的网络模型越来越大、越来越深,不免遇到显存不足的情况。不过学习是一个循序渐进的过程,等到你的知识到了需要更高规格的设备,自然知道需要什么样的配置了

1.深度学习个人进阶配置

i7 9700K+GTX 2080TI

2或者GTX TItan V

1+64G RAM +2T SSD。如果使用双2080TI (20000)元就能在保持高性价比的前提下拥有单台电脑相对最快的速度,使用GTX TITAN V 就达到了当前单显卡算力巅峰,并且能够完成少数显存使用超过11G的模型。

可以在此基础上将显卡更换为2080ti(性能为1080ti的1.5倍,价格翻一倍 约9000元)或显存12G的titan V,达到单卡性能巅峰

2.深度学习个人完美配置

i7 9700K+GTX 2080TI

2或者GTX TItan V

1+64G RAM +2T SSD。约三万元,如果使用双2080TI (20000)元就能在保持高性价比的前提下拥有单台电脑相对最快的速度,使用GTX TITAN V 就达到了当前单显卡算力巅峰,并且能够完成少数显存使用超过11G的模型。

将显卡换为1080ti可以省一半的钱

3.深度学习实验室共享服务器

7

24小时运行 2080ti或者4

titan V 其实前两个配置也可以拿来做共享服务器,不过计算资源太少,预算充裕可以专门购置一台高性能多显卡深度学习服务器,24*7小时运行,其他用户可以在自己的笔记本电脑和台式机上编写和初步调试卷积神经网络,本地验证无误后,上传至服务器进行训练任务。这样做可以极大的节省设备开支,最大限度的利用计算资源,也避免了每个用户单独配置复杂的软件环境。

显卡换为1080ti可以省一些,主板也可以替换为5000元左右的支持四路显卡sli的

4.深度学习实验室共享服务器单机最高配置

基本上是单台服务器能提供的最高配置,如果要更高配置,可以模仿大型商业研究院在此基础上构建服务器集群。

4.显示器

显示器当然越多越好,2-3台差不多,虽然多数任务可能都是在笔记本上完成。

5.最后是机箱

既然是科研设备,机箱一定要看起来有排面,一般深度学习服务器除了机柜式的以外都使用海盗船的这一款机箱

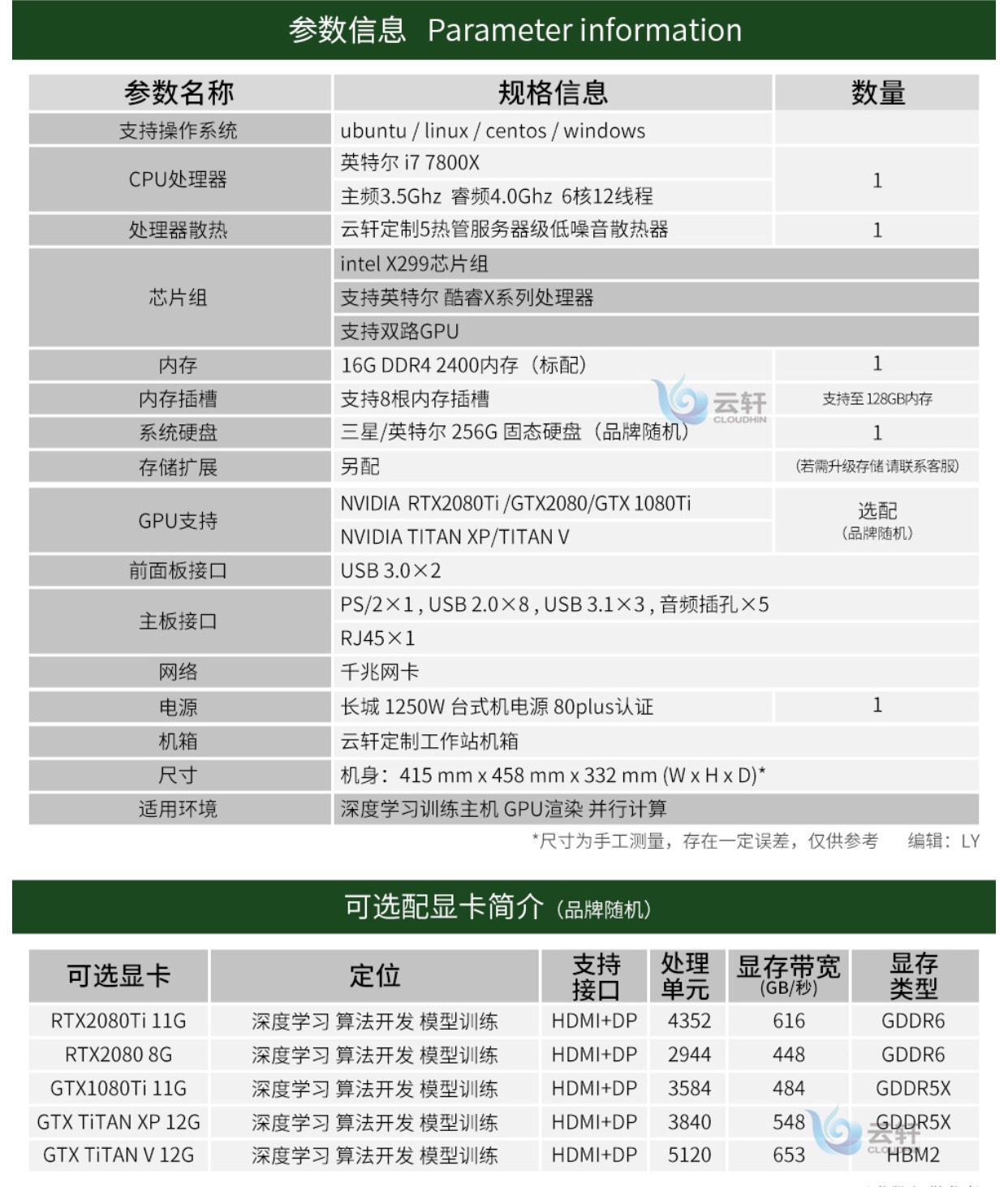

各种服务商卖的深度学习主机也差不多就这样,注意不要被忽悠购买Tesla P系列商用计算卡,虽然是商用卡,但是性能同等的情况下比 gtx和rtx系列要贵几倍

这是商家大概给的推荐。

一般供应商给的配置差不多是靠谱的,就是会在有些零件用特殊渠道产品。有的商家给的配置性价比不高,比如说配置里无脑推荐titan V,25000一块,能买五张有它60%性能的1080ti,毕竟无奸不商,需要购机的朋友可以参考本文自行斟酌需要的配置,精打细算一番。唉,说多了都是泪