【编者按】

晓苏是我以前的同事,现在任职Cavium公司技术经理。

Cavium公司是全球领先的多核 MIPS 和 ARM 处理器提供商,处理器广泛应用于网络/通讯、无线、存储和控制应用等领域的安全产品。

2016年6月,Cavium以13.6亿美元收购网络厂商QLogic;2017年11月,Marvell拟以 60 亿美元收购 Cavium。

本篇文章经作者授权。可以看到高速网络下vSphere的性能。从下面10G、25G的测试性能截图可以看出,在虚拟环境下,也能充分地发挥硬件的性能。

—Begin—

VMware vSAN

简介

VMware vSAN

,曾用名

VMware Virtual SAN

,现称

vSAN

。我们可以把

vSAN

理解为

vSphere Storage

,是

vSphere

虚拟机后端的企业级高性能存储。

vSAN

其实就是基于服务器端存储的共享分布式对象存储系统,可以用来取代

vSphere

后端的外置磁盘阵列。

vSAN

把

vSphere

集群服务器各个节点内的

SSD(

固态硬盘

)

和

HDD(

硬盘

)

,聚合在一起,构成一个共享的存储池。然后再由存储池按照预先创建好的存储策略

(

用户不创建,则自动使用系统默认策略

)

,分配存储空间给集群内的虚拟机使用。

如果借助

NAS

插件,也可提供共享的文件空间给其他集群,或者物理机使用。或者借助vSAN iSCSI接口,也可提供vSAN的空间,以块的访问方式给物理机使用。

vSAN

是一种基于软件的分布式存储解决方案,可在任何标准

X86

服务器上运行,只要

I/O Controller(

控制器

)

、

SSD

和

HDD

在

vSAN HCL (Hardware Compatibility List-

兼容列表

)

内,就可运行。

vSAN

的

HCL

非常丰富,为用户的选型提供了非常高的灵活性。

与

S2D

可以使用

RDMA

并且建议采用

25G

网络不同,

VMware vSAN

目前并没有针对网络环境提出太高的要求,选择更为宽松:

在官方建议的最佳实践中,

1G

千兆网卡为最低配置,

10G

万兆网卡为建议配置。这在目前的数据中心网络当中,特别是软件定义存储应用当中,此配置要求是比较宽泛的。

最佳实践是为了获得最好的性能,因此

10G

共享网卡作为最低配置更匹配系统的实际要求,单独的

10G

网卡或者更高速率的接口,才能实现更好的性能特别是全闪存配置的要求。

在

vSAN

最新版本所对应的

vSphere 6.5

系统配置当中,明确了以下网卡都可以支持:

高速以太网

更高带宽的网卡接口,到底对性能有多少影响呢?

我们做了这样一个实验,单纯地对比

10G

网卡和

25G

网卡在

VMware

环境当中的网络传输性能。

10G

测试时,两端的服务器采用

QLE3442-SR

网卡,每台服务器使用

1

个端口连接到

10G

交换机;

25G

测试时,两端的服务器采用

QL45212

网卡,每台服务器使用

1

个端口连接到

25G

交换机。

vCenter

服务器采用

1G

网卡通过千兆网络对两台测试系统进行管理工作。

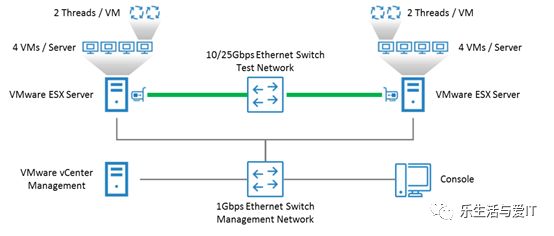

实验拓扑请参考下图:

每台

ESX

服务器创建

4

台

VM

虚拟机,并在虚拟机上运行

IxChariot

流量测试程序,

ixchariot

是

Ixia

公司的专业性能测试软件,可以模拟各种网络流量场景以评估设备、系统以及网络在这些场景当中的表现。每台虚拟机会运行

2

个

IxChariot

测试进程,因此在单向流量测试中,总共有

8

个进程在传输测试数据;而双向流量测试中,总共有

16

个进程在传输数据。我们选择的数据包大小在

1KB

~

64KB

之间,基本可以覆盖主流应用的数据包大小区间。另外,每项测试进行两次,第一次是关闭网卡的

large segment offload (LSO)

和

TCP segment offload(TSO)

卸载功能,由

CPU

进行数据拆分切片;第二次则开启网卡的

LSO

,

TSO

硬件卸载功能,降低

CPU

的消耗,提高系统处理能力。

10G

网卡双向流量测试结果:

25G

网卡双向流量测试结果:

从上面的单纯速率测试可以看出以下几点:

1.

25G

网卡传输性能远远超过

10G

网卡

在

16KB

以下的数据包测试中,差距尤为明显。数据包大小为

16KB

时,差距是

3

倍;而数据包为

1KB

时,传输性能差距超过

20

倍!

2.

LSO/TSO

对网络性能提升帮助很大

在

25G

网卡测试中,开启

LSO/TSO

硬件卸载平均可以实现

18%

左右的性能提升。

因此从性能角度想要达到最佳的性能,在端口速率的选择上应该还是越高越好。

RDMA

网络特性

既然高速以太网网卡可以提升网络带宽来提高性能,那么现在非常火热的以太网

RDMA

是否也可以应用在

vSAN

之上呢?众所周知

S2D

可以利用

iWARP

和

RoCE

两种以太网

RDMA

协议。

目前

vSAN 暂

不支持以太网

RDMA

,不过相信不久的将来会支持。微软曾经提供过一个简单虚拟化环境下

RDMA

和普通

TCP/IP

网络性能的对比:

从上图我们可以看出:

1.

RDMA

技术可以显著提升性能,在提高

IOPS

的同时降低时延,降低

CPU

消耗。

2.

TCP/IP

虽然没有

RDMA

网络速度快,但是依然是一个非常可靠的选择

,在对时延要求较低的应用当中,依然可以提供非常可观

IOPS

输出。

vSphere

原本就支持

InfiniBand

网络,在

2017

年

3

月的文章

vSphere 6.5 with RoCE (RDMA over Converged Ethernet)and Certification Suite

中,已经开始了网卡认证工作。

vSphere

一旦开始支持

RDMA

网络,

vSAN

就会很快实现了。希望到那个时候,我们可以再横向比较一下

vSAN

在

RDMA

网络和普通

TCP/IP

网络之间的区别。

—End—

本篇文章2018年1月12日在微信公众号 CaviumQLogic 上发布,题为:《vSAN软件定义存储与高速以太网特性 (25G/100G以及RDMA)》

微信公众号平台”乐生活与爱IT”在目前阶段,主要是分享软件定义存储(SDS),及VMware vSAN相关的文章,偶尔也会分享虚拟化、云计算、大数据、区块链等IT类文章,甚至生活类的好文章。

欢迎投稿,特别是原创文章。如果原创文章属于首次发布,根据质量和阅读量的不同,能获得20~500元的稿费。

我的QQ号:9269216

。

另外,如果还有赞赏收入,

作者可获得60%

。

欢迎对SDS感兴趣的朋友,加入软件定义存储讨论 QQ群:122295009,可下载原创的一些文章,及其他有参考价值的文档。可直接搜索群号,或者扫描如下二维码:

同时,欢迎您加入 “开放讨论群-SDS&虚拟化” 微信群,并邀请其他对SDS和虚拟化感兴趣的朋友加入此微信群。可以通过添加如下管理员之一的微信号,建议添加管理员时,告知你的公司名和姓名,方便备注保存。

sdg8848

libo9538

yangzhuan

dts0103

欢迎您通过扫描关注微信公众号:“乐生活与爱IT”。

关注后,可以通过点击左下角的

“

文章目录

”

,通过输入三位数(

记住!是三位数

,目前

第一位是0或者1

)详细了解如何查看历史文章。

点击左下角“

阅读原文

”,可以跳转到微信公众号“乐生活与爱IT”的上文章:

《InfiniBand支持VMware vSAN吗?》