GPU 已经成为支撑 AI 应用的一种关键计算加速设备,GPU 的多处理器架构非常适合用来加快深度神经网络应用中的大量矩阵运算过程。大量实测数据表明,跟通用处理器相比,GPU 在运行深度神经网络时具有显著的效能优势。在虚拟机中使用 GPU 主要有三种设置:DirectPath I/O、NVIDIA vGPU、vSphere Bitfusion,我们来比较一下这几种方法的优缺点。

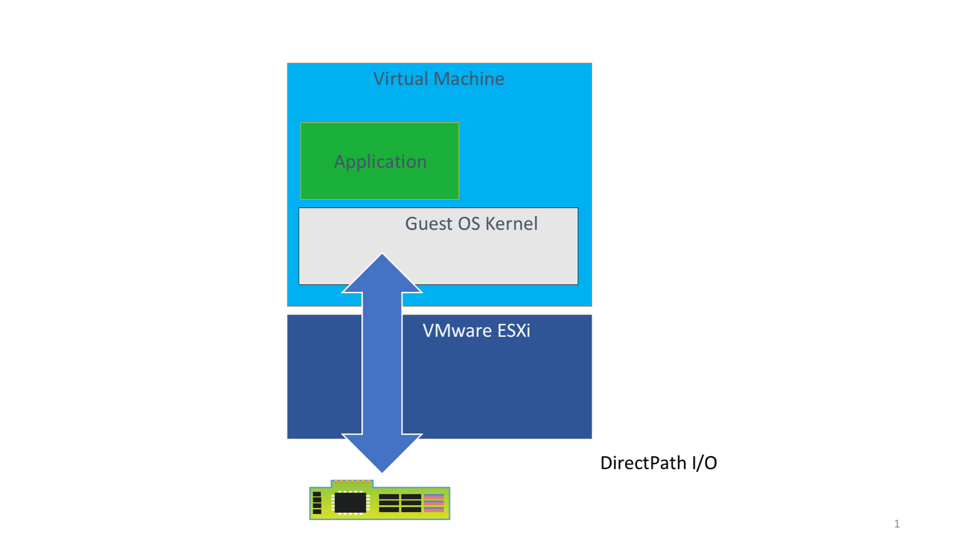

1. DirectPath I/O (直通)

这种方法是在 vSphere 虚机上使用 GPU 的“最小干预”途径,ESXi hypervisor 把 GPU 设备直接映射成虚机中的 GPU 设备,供应用使用。

DirectPath I/O 方法适用于需要占用一块或多块物理 GPU 进行机器学习训练,并且训练需要一段时间的场景。这种情况下机器学习模型和数据可能会消耗 GPU 的所有内核和内存,通常是长期运行的模型训练工作。DirectPath I/O 方法通常用于高性能计算方案中,例如计算密集型的模拟或科学计算工作。

DirectPath I/O方法的优点: 所有版本的 vSphere 都支持 DirectPath I/O,虚机的操作系统里需要安装 GPU 驱动程序。

可以将1块或多块 GPU 分配给一个 虚机以充分利用多块 GPU 叠加的计算能力。

用户具有对 GPU 内存和内核独占访问权,没有共享的 GPU 内存或内核,因此不会受到其他用户的干扰。

事实证明 DirectPath I/O 所提供的计算性能与物理