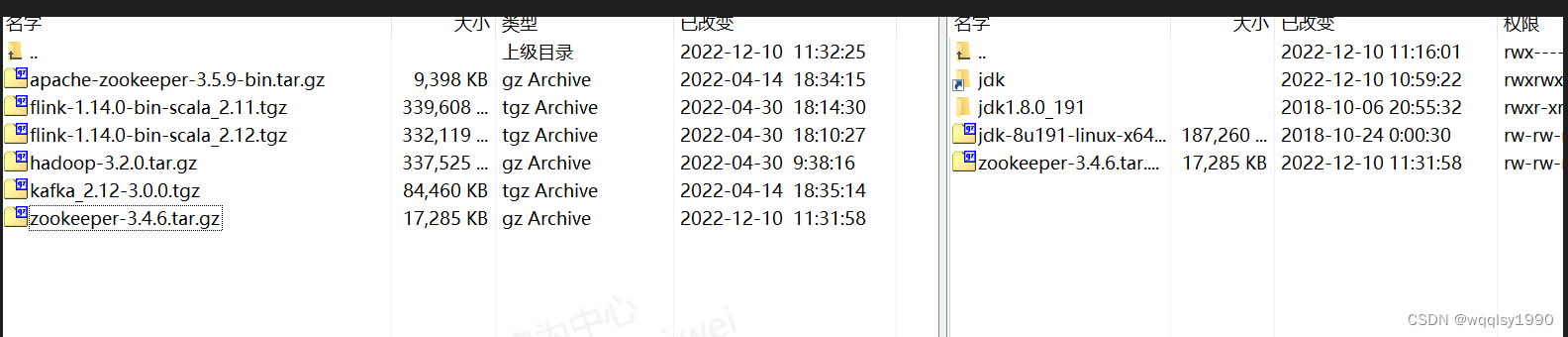

1.zookeeper 下载:

1.1.zookeeper下载:

可以根据自己的需要下载不同的版本:我用的zookeeper版本是 3.4.5

Index of /dist/zookeeper/zookeeper-3.4.5

1.2.下载jdk8 (由于我本地已经下载了,其他本版,所以演示不用图中版本)

Java Archive Downloads – Java SE 8u211 and later

2. zookeeper安装环境准备

2.1 linux主机名与IP映射

编辑/etc/hostname 文件。

修改主机名称为 hadoop01。

2.2 关闭linux以及防火墙

停止防火墙服务,并禁止防火墙。

查看防火墙状态

需要注意的是:需要重启虚拟机才能保证永久关闭防火墙

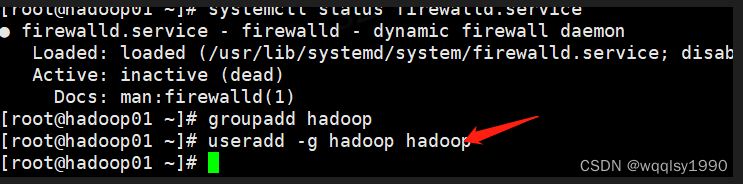

2.3 创建Linux用户及用户组(此步骤可以做也可以不做,不做就直接在root账户下创建)

创建 hadoop 组

创建 hadoop 用户并加入到 hadoop 组中

给hadoop设置密码,否则做免密登录时可能会失败

输入你设置的密码直接回车,要输入两次。

2.4.从 hadoop01 克隆 hadoop02 和 hadoop03

2.5 Linux SSH 免密登入设置

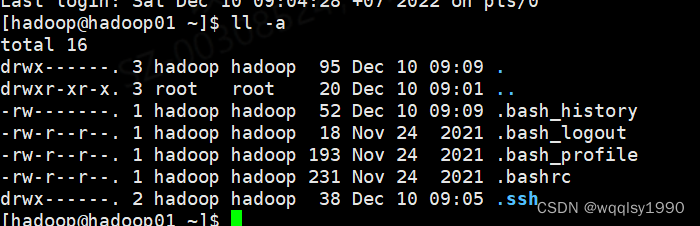

切换到Hadoop用户

![]()

生成公私密钥。

ssh-keygen 为 ssh 生成、 管理和转换认证密钥,ssh-keygen 命令 用于为“ssh” 生成、 管理和

转换认证密钥, 它支持 RSA 和 DSA 两种认证密钥。 SSH 密钥默认保留在 ~/.ssh 目录中。 如

果没有 ~/.ssh 目录, ssh-keygen 命令会使用正确的权限创建一个

一直回车就可以

ssh-keygen -t 选项的作用是指定要创建的密钥类型。

生成密钥后会出现.ssh 的隐藏目录。

进入该目录, 浏览内容 cd /home/hadoop/.ssh

将 hadoop01 的公钥发到授权文件中, 或者使用 ssh-copy-id hadoop01 也可以。

ssh-copy-id 命令可以把本地主机的公钥复制到远程主机的 authorized_keys 文件上。

authorized_keys 文件用来验证 client 。 使用 ssh-copy-id 命令将本地公钥复制到远程主机之

后可以实现免密登录远程主机。

cp id_rsa.pub authorized_keys

查看

操作之后就实现了免密 ssh 链接 hadoop01.

注意:hadoop02,hadoop03需做同样的操作。

3.zookeeper 集群安装前准备

3.1 配置hosts文件

编辑/etc/hosts 文件

vi /etc/hosts

配置主机 IP 和名称的映射关系(其中前面是ip,后面是名字,ip可以通过ifconfig进行查询)

重启网络让配置生效。

![]()

备注: hadoop02、 hadoop03 方法和步骤一样。、

3.2 集群设置免密

将 hadoop02 公钥发送到 hadoop01 的授权文件 authorized_keys 中, 实现 hadoop01 免密访问

hadoop02。

将 hadoop03 公钥发送到 hadoop01 的授权文件 authorized_keys 中, 实现 hadoop01 免密访问

hadoop03

将 hadoop01 的授权文件 authorized_keys 分别发送给 hadoop02 和 hadoop03, 实现三台主机

间免密互访。

Linux scp 命令用于 Linux 之间复制文件和目录。 scp 是 secure copy 的缩写, scp 是 linux

系统下基于 ssh 登陆进行安全的远程文件拷贝命令。 scp 是加密的, rcp 是不加密的, scp 是

rcp 的加强版。

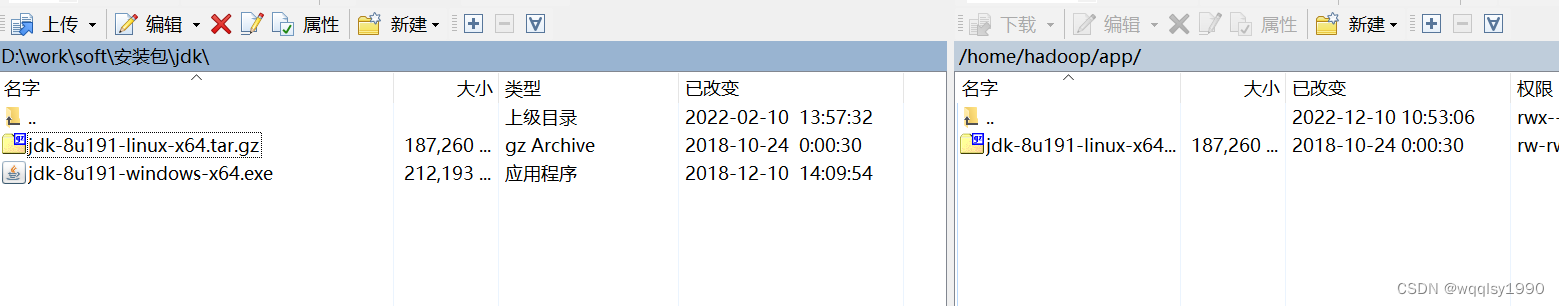

3.3 JDK安装

3.3.1. 下载上传 JDK 到 Linux

创建 app 目录用于存放应用程序。

mkdir命令用于创建目录。

从 windows 上传 JDK 安装包到 Linux, 此处为/home/hadoop/app。

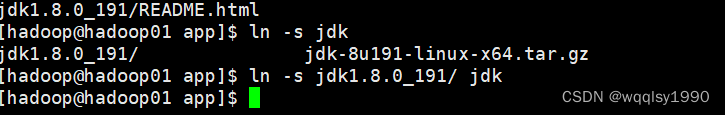

3.3.2. 解压 JDK

进入app目录

查看内容, 看到上传的 jdk 压缩包。

用tar -zxvf 进行解压

可以查看到解压后的 jdk 目录。

创建一个软链接文件键结到源目录。

ln -s 创建软链接(符号链接)。 类似于 Windows 操作系统中的快捷方式。

3.3.3. 配置 JDK 环境变量

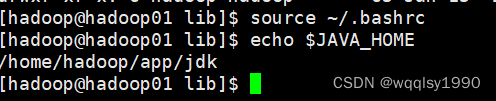

修改 hadoop 用户家目录下的.bashrc 隐藏配置文件可以永久改变 hadoop 的环境。

配置 JAVA 的环境变量。

配置后, 使用 source 命令让配置文件生效。

然后使用 echo 命令验证环境变量 JAVA_HOME 已经生效。

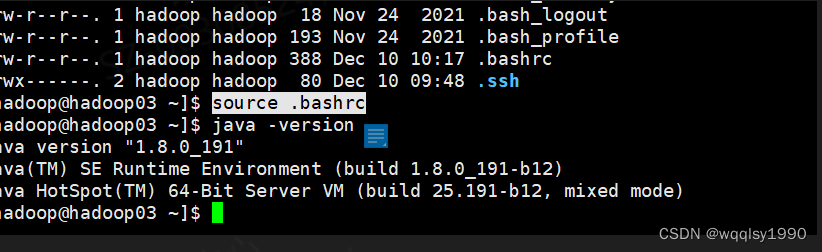

3.3.4. 检查 JDK 是否安装成功

查看 Java 版本验证 JAVA 成功安装。

3.3.5. 配置其他节点的 JDK 环境变量

hadoop02 和 hadoop03 的 JDK 和 hadoop01 一样。

4. Zookeeper 集群的安装部署

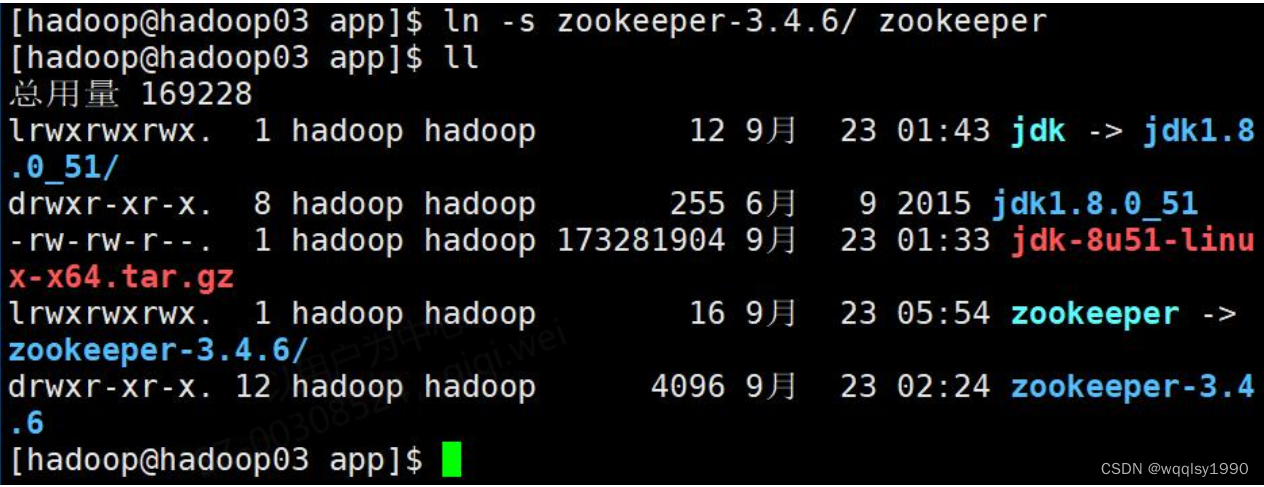

4.1.上传解压 Zookeeper

解压并创建软连接。 (参考前面 JDK 解压过程)

4.2.配置 Zookeeper

进入/home/hadoop/app/zookeeper/conf 目录, zookeeper 的配置文件在这里。 可以看到

zoo_sample.cfg, 这是配置文件的样例文件。

cp zoo_sample.cfh zoo.cfg

vim zoo.cfg 如下修改如下内容:

4.3.Zookeeper 安装目录同步到集群其他节点

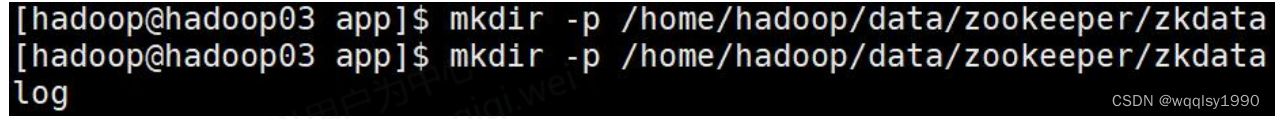

4.4.创建 zookeeper 数据和日志记录

Zookeeper 用来存放数据 zkdata 和日志 zkdatalog 的目录, 要和 zoo.cfg 内的配置对应上。

mkdir -p 可以级联创建目录。

4.5.为 zookeeper 集群各个节点创建服务编号

hadoop01 的编号为 1, 创建 myid 文件, 写入 1。

hadoop02 的编号为 2, 创建 myid 文件, 写入 2。

hadoop03 的编号为 3, 创建 myid 文件, 写入 3。

注意: 每个节点服务编号是一个整数且不能重复。

4.6.启动 Zookeeper 集群

使用/home/hadoop/app/zookeeper/bin 下的 zkServer.sh start 启动 Hadoop01 的 zookeeper。

同样启动 hadoop02 和 hadoop03 的 zookeeper。

使用/home/hadoop/app/zookeeper/bin 下的 zkServer.sh status 查看状态。

可以看到 hadoop02 为 leader, hadoop01 和 hadoop03 为 follower。

至此,zookeeper安装完成