4.1 深度学习(一)

● BatchNormalization 的作用

参考回答:

神经网络在训练的时候随着网络层数的加深, 激活函数的输入值的整体分布逐渐往激活函数的取值区间上下限靠近, 从而导致在反向传播时低层的神经网络的梯度消失。而 Batch Normalization 的作用是通过规范化的手段, 将越来越偏的分布拉回到标准化的分布, 使得激活函数的输入值落在激活函数对输入比较敏感的区域, 从而使梯度变大, 加快学习收敛速度, 避免梯度消失的问题。

● 梯度消失

参考回答:

在神经网络中,当前面隐藏层的学习速率低于后面隐藏层的学习速率,即随着隐藏层数目的增加,分类准确率反而下降了。这种现象叫做消失的梯度问题。

● 循环神经网络,为什么好?

参考回答:

循环神经网络模型(RNN)是一种节点定向连接成环的人工神经网络,是一种反馈神经网络,RNN 利用内部的记忆来处理任意时序的输入序列,并且在其处理单元之间既有内部的反馈连接又有前馈连接,这使得 RNN 可以更加容易处理不分段的文本等。

● 什么是 Group Convolution

参考回答:

若卷积神将网络的上一层有 N 个卷积核, 则对应的通道数也为 N。设群数目为 M, 在进行卷积操作的时候, 将通道分成 M 份, 每个 group 对应 N/M 个通道, 然后每个 group 卷积完成后输出叠在一起, 作为当前层的输出通道。

● 什么是 RNN

参考回答:

一个序列当前的输出与前面的输出也有关, 在 RNN 网络结构中中, 隐藏层的输入不仅包括输入层的输出还包含上一时刻隐藏层的输出, 网络会对之前的信息进行记忆并应用于当前的输入计算中。

● 训练过程中, 若一个模型不收敛, 那么是否说明这个模型无效? 导致模型不收敛的原因有哪些?

参考回答:

并不能说明这个模型无效, 导致模型不收敛的原因可能有数据分类的标注不准确, 样本的信息量太大导致模型不足以 fit 整个样本空间。学习率设置的太大容易产生震荡, 太小会导致不收敛。可能复杂的分类任务用了简单的模型。数据没有进行归一化的操作。

● 图像处理中锐化和平滑的操作

参考回答:

锐化就是通过增强高频分量来减少图像中的模糊, 在增强图像边缘的同时也增加了图像的噪声。

平滑与锐化相反, 过滤掉高频分量, 减少图像的噪声是图片变得模糊。

● VGG 使用 3*3 卷积核的优势是什么?

参考回答:

2 个 3

3 的卷积核串联和 5

5 的卷积核有相同的感知野, 前者拥有更少的参数。多个 3*3 的卷积核比一个较大尺寸的卷积核有更多层的非线性函数, 增加了非线性表达, 使判决函数更具有判决性。

● Relu 比 Sigmoid 的效果好在哪里?

参考回答:

Sigmoid 的导数只有在 0 的附近时有较好的激活性, 而在正负饱和区域的梯度趋向于 0, 从而产生梯度弥散的现象, 而 relu 在大于 0 的部分梯度为常数, 所以不会有梯度弥散现象。Relu 的导数计算的更快。Relu 在负半区的导数为 0, 所以神经元激活值为负时, 梯度为 0, 此神经元不参与训练, 具有稀疏性。

● 问题:神经网络中权重共享的是?

参考回答:

卷积神经网络、循环神经网络

解析:通过网络结构直接解释

● 问题:神经网络激活函数?

参考回答:

sigmod、tanh、relu

解析:需要掌握函数图像,特点,互相比较,优缺点以及改进方法

● 问题:在深度学习中,通常会 finetuning 已有的成熟模型,再基于新数据,修改最后几层神经网络权值,为什么?

参考回答:

实践中的数据集质量参差不齐,可以使用训练好的网络来进行提取特征。把训练好的网络当做特征提取器。

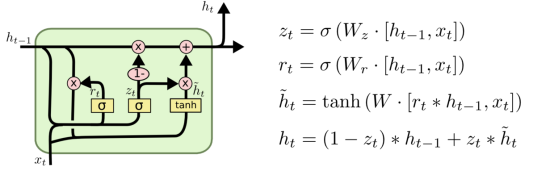

● 问题:画 GRU 结构图

参考回答:

GRU 有两个门:更新门,输出门

解析:如果不会画 GRU,可以画 LSTM 或者 RNN。再或者可以讲解 GRU 与其他两个网络的联系和区别。不要直接就说不会。

● Attention 机制的作用

参考回答:

减少处理高维输入数据的计算负担, 结构化的选取输入的子集, 从而降低数据的维度。让系统更加容易的找到输入的数据中与当前输出信息相关的有用信息, 从而提高输出的质量。帮助类似于 decoder 这样的模型框架更好的学到多种内容模态之间的相互关系。

● Lstm 和 Gru 的原理

参考回答:

Lstm 由输入门, 遗忘门, 输出门和一个 cell 组成。第一步是决定从 cell 状态中丢弃什么信息, 然后在决定有多少新的信息进入到 cell 状态中, 最终基于目前的 cell 状态决定输出什么样的信息。

Gru 由重置门和跟新门组成, 其输入为前一时刻隐藏层的输出和当前的输入, 输出为下一时刻隐藏层的信息。重置门用来计算候选隐藏层的输出, 其作用是控制保留多少前一时刻的隐藏层。跟新门的作用是控制加入多少候选隐藏层的输出信息, 从而得到当前隐藏层的输出。

● 什么是 dropout

参考回答:

在神经网络的训练过程中, 对于神经单元按一定的概率将其随机从网络中丢弃, 从而达到对于每个 mini-batch 都是在训练不同网络的效果, 防止过拟合。

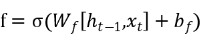

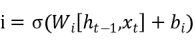

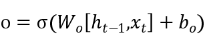

● LSTM 每个门的计算公式

参考回答:

遗忘门:

输入门:

输出门:

● DropConnect 的原理

参考回答:

防止过拟合方法的一种, 与 dropout 不同的是, 它不是按概率将隐藏层的节点输出清 0, 而是对每个节点与之相连的输入权值以一定的概率清 0。

转自

https://www.nowcoder.com/tutorial/95/2785805c26a549b2bbcf5e60cab5f61e