Windows10系统下C#部署Paddlex模型

一、部署环境介绍

本文部署环境如下:

| 软件 | 版本 |

|---|---|

| 操作系统 | Windows10 |

| Visual Studio | Enterprise2019 |

| cmake | 3.18.0 |

| Miniconda | 4.9.2 |

| paddlepaddle-gpu | 2.1.2 |

| paddleX | 2.0.0rc4 |

| CUDA | 10.1 |

| cuDNN | 7.6.5 |

部署过程大部分参照

GitHub官方文档1

和

GitHub官方文档2

进行。

二、文件下载

2.1下载PaddleX源码

按照

GitHub官方文档

说明,首先需使用git工具从GitHub下载PaddleX源码。

需要注意的是当前为最新版本2.1.0,如果模型训练时不是使用2.1.0版本进行训练,那么在生成可执行文件后,文件无法正确进行预测。

下载命令如下:

mkdir projects

cd projects

git clone https://github.com/PaddlePaddle/PaddleX.git

2.2下载C++ 预测库 paddle_inference

摘抄官方文档:PaddlePaddle C++ 预测库针对是否使用GPU、是否支持TensorRT、以及不同的CUDA版本提供了已经编译好的预测库,目前PaddleX支持Paddle预测库2.0+,Paddle预测库2.1.0版本下载链接见

GitHub官方文档

:

Paddle预测库2.1.1版本下载链接见

官网官方文档

:

CUDA与cuDNN版本查看可参照

一步步教你查看cuda和cudnn版本

。

本文选择CUDA10.1、cuDNN7.6对应的2.1.0Paddle预测库进行下载。

2.3下载Opencv

在OpenCV官网下载适用于Windows平台的

3.4.6版本

。

前三步下载完成后,文件夹如下:

2.4下载TensorRT

在训练了神经网络之后,TensorRT可以对网络进行压缩、优化以及运行时部署,并且没有框架的开销。TensorRT通过combines layers,kernel优化选择,以及根据指定的精度执行归一化和转换成最优的matrix math方法,改善网络的延迟、吞吐量以及效率。TensorRT下载版本需要和cuda进行匹配,

下载链接

,下载前需注册NVIDIA账号登录,本文选择TensorRT-6.0.1.5.Windows10.x86_64.cuda-10.1.cudnn7.6进行下载。

安装过程参照

在Windows10下安装TensorRT5.1 GA

,但通过运行sample_minist来验证是否安装成功过程中会报错“Could not find *.pgm in data directories”,原因是TensorRT-6.0版本中缺少minist相关数据文件,需从

链接

下载,解压到data\mnist路径下,然后运行bin\sample_mnist.exe出现下图,安装成功。

三、编译C++可执行文件

3.1vs生成项目工程

按照官方文档说明,有两种方式生成项目工程,一种为使用Cmake对PaddleX/deploy/cpp中代码进行编译,另一种是使用vs直接打开PaddleX/deploy/cpp文件夹中CMakeLists.txt进行项目生成。本文首先选择使用vs进行项目生成。

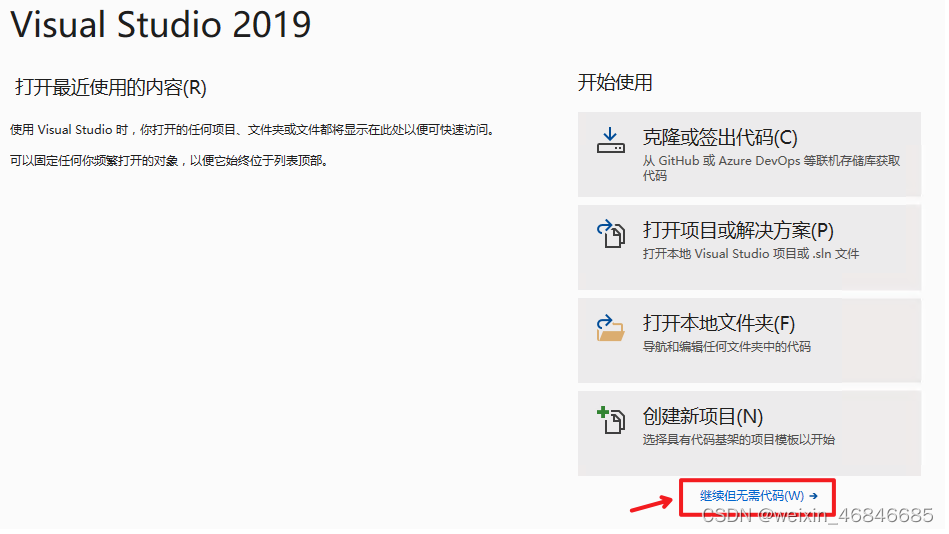

打开vs2019点击继续但无需代码:

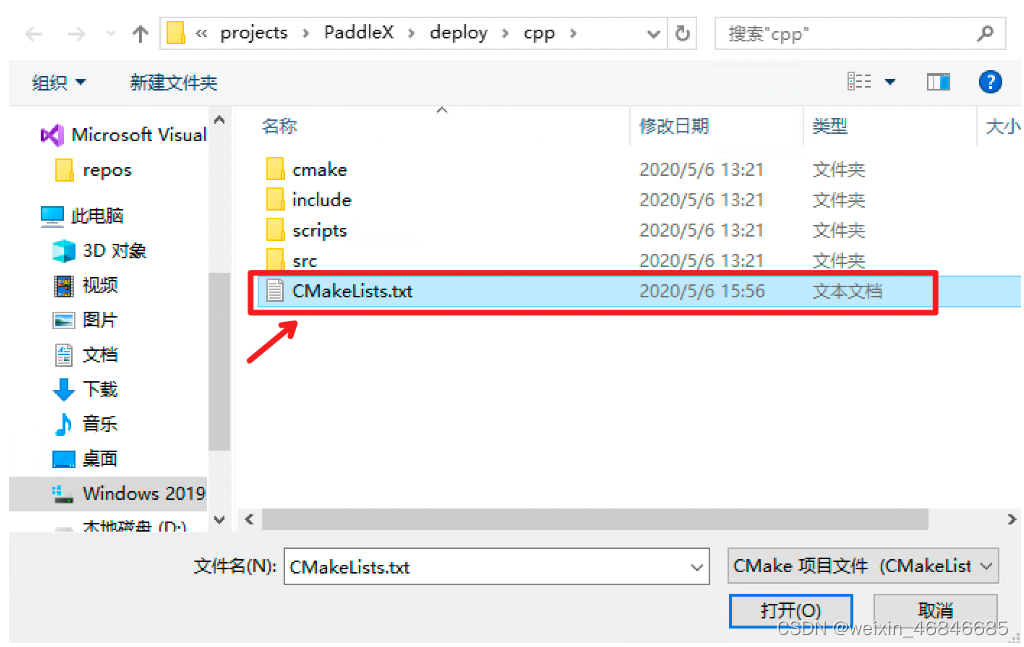

点击: 文件->打开->CMake:

选择PaddleX\deploy\cpp文件夹,并打开CMakeList.txt:

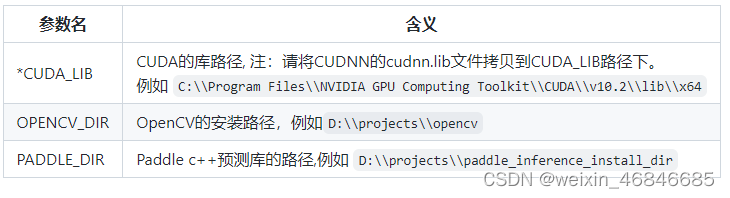

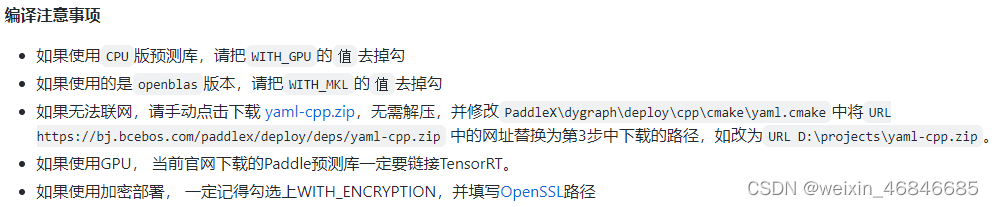

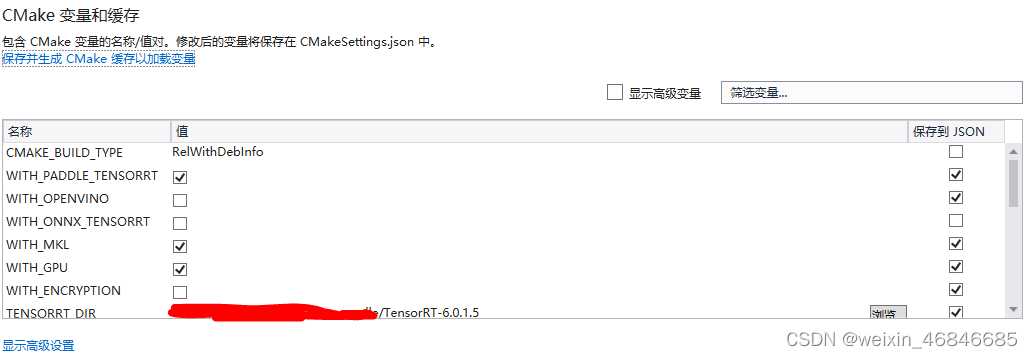

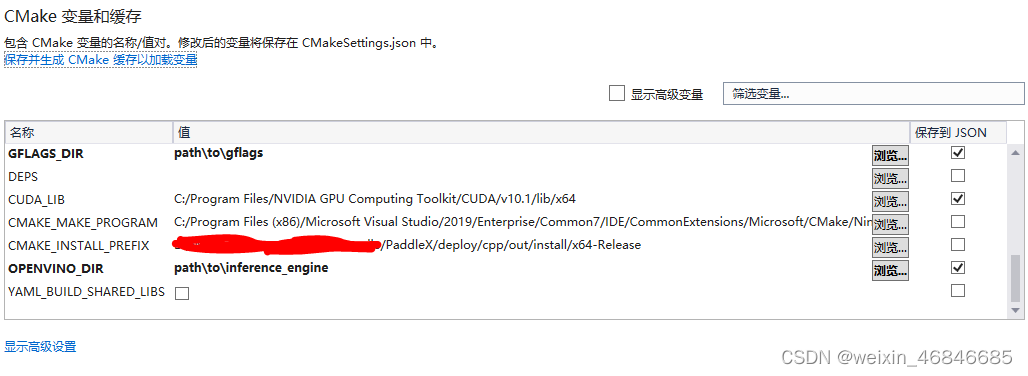

点击:项目->CMake设置,分别设置编译选项指定CUDA、OpenCV、Paddle预测库的路径,依赖库路径的含义说明如下(带*表示仅在使用GPU版本预测库时指定, 其中CUDA库版本尽量与Paddle预测库的对齐,例如Paddle预测库是使用9.0、10.0版本编译的,则编译PaddleX预测代码时不使用9.2、10.1等版本CUDA库):

最终配置路径完成如下图:

点击保存并生成CMake缓存,出现CMake 生成完毕且无报错代表生成完毕。

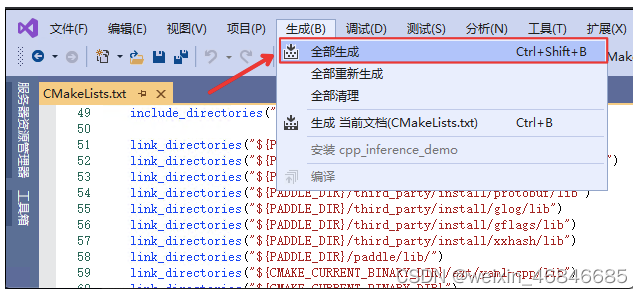

点击生成->全部生成,生成demo里的可执行文件。

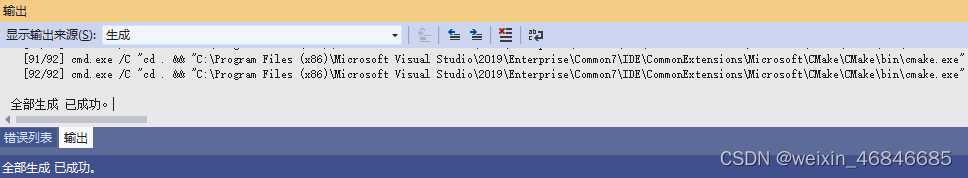

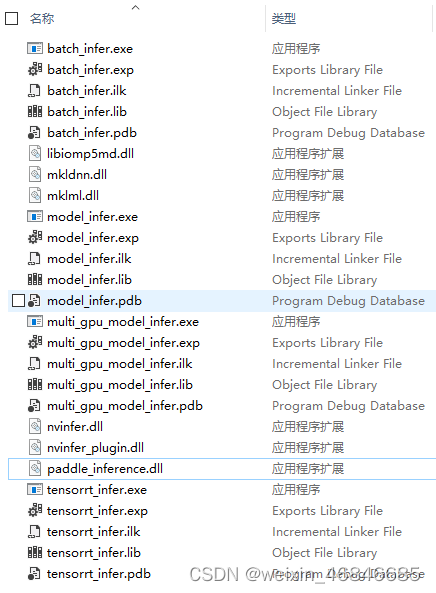

弹出“全部生成 已成功。”说明生成成功,在out\build\x64-Release\paddle_deploy路径下已生成exe可执行文件。

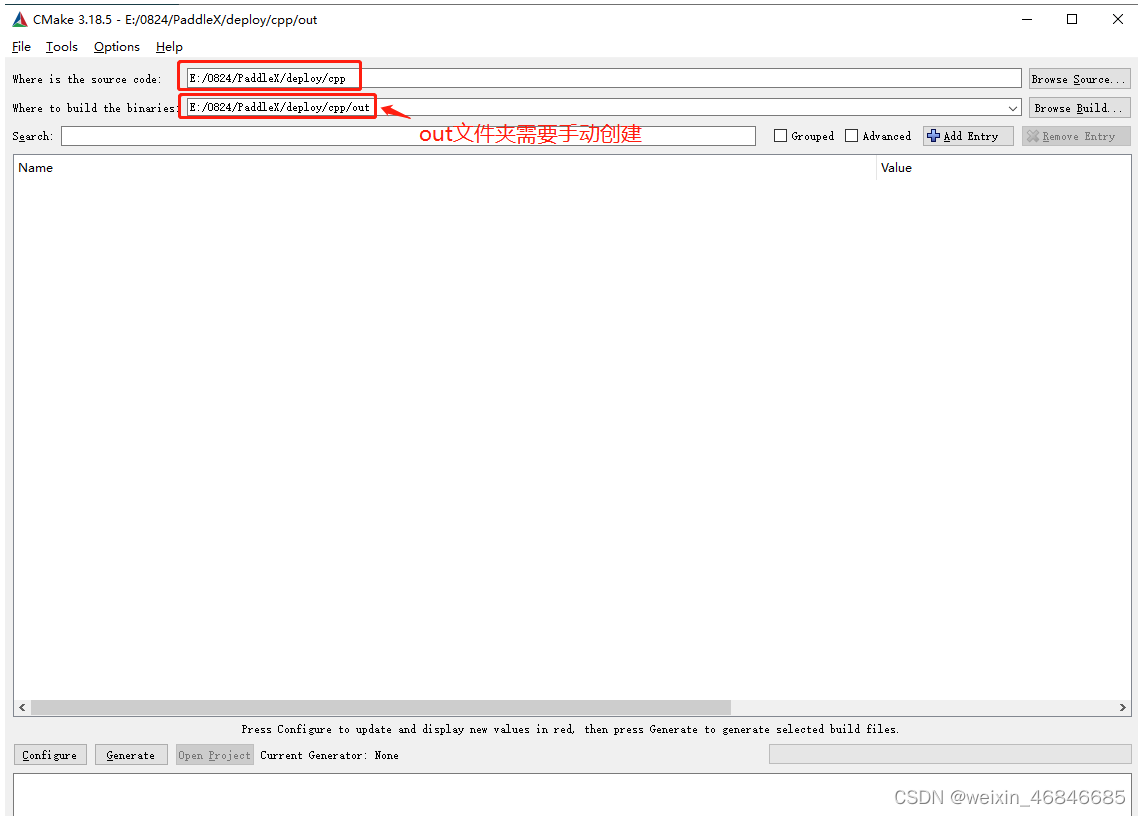

3.2Cmake生成项目工程

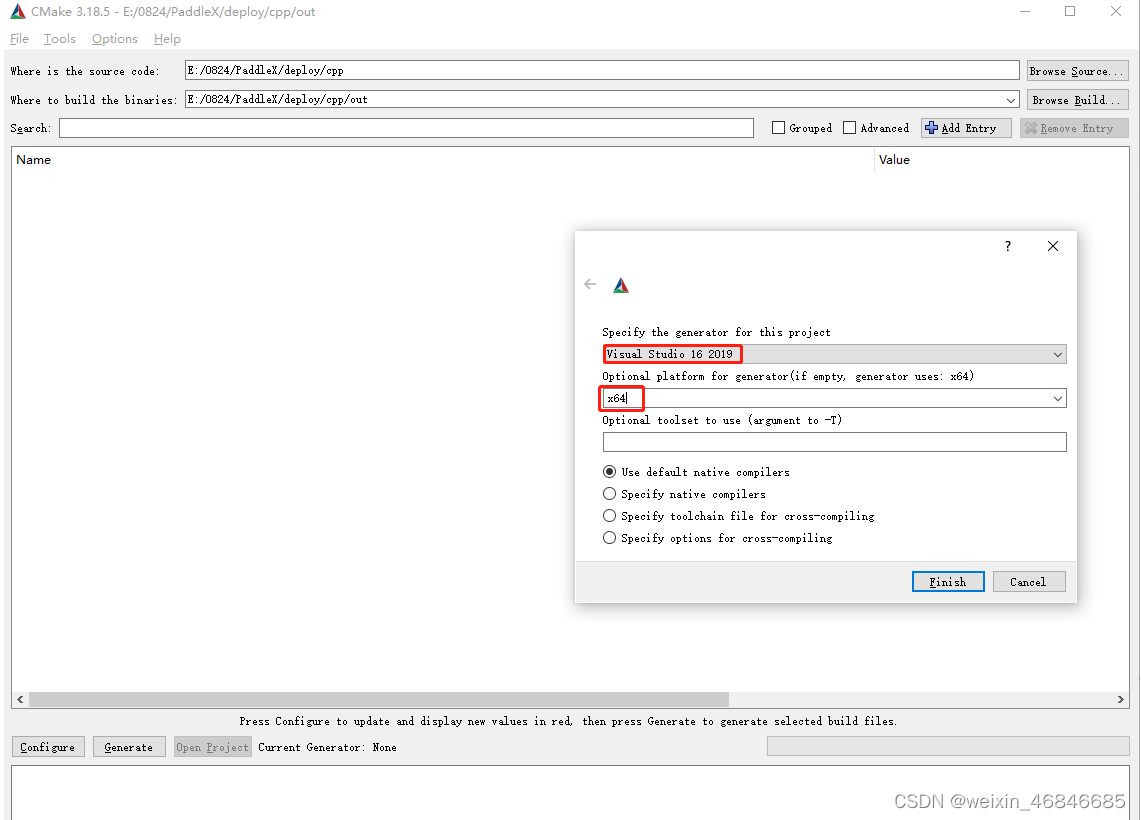

对PaddleX/deploy/cpp中代码进行编译,并创建out文件夹用来承接编译生成的内容,点击configure,在弹出界面选择x64,点击finish。

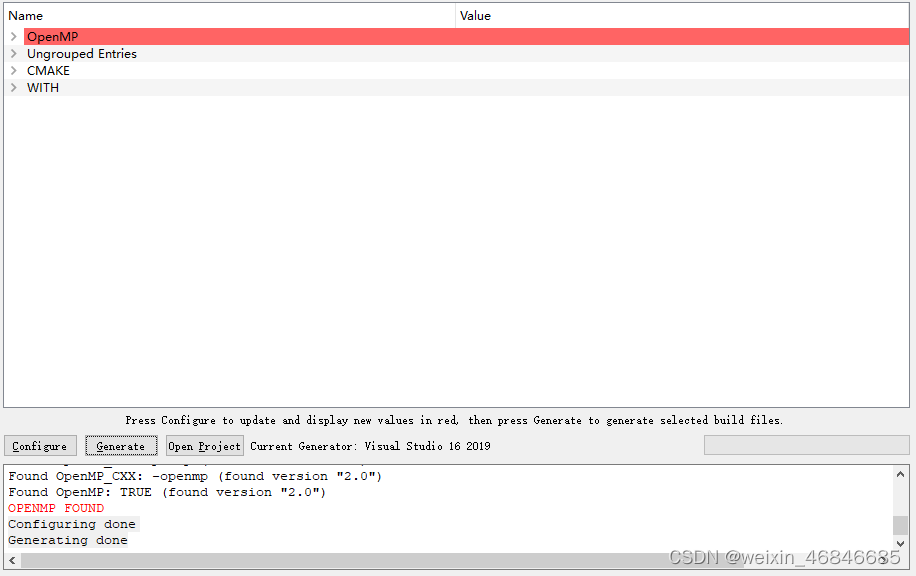

爆出“Unknown arguments specified Configuring incomplete, errors occurred!”错误,这时需在cmake中配置如3.1所述CUDA、OpenCV、Paddle预测库的路径,配置完成后点击configure,提示“Configuring done”,配置完成。点击Generate进行生成,提示“Generating done”,生成完成。

最终在out文件夹中出现了.sln文件,则表示通过cmake成功生成了解决方案:

3.3生成DLL可执行文件

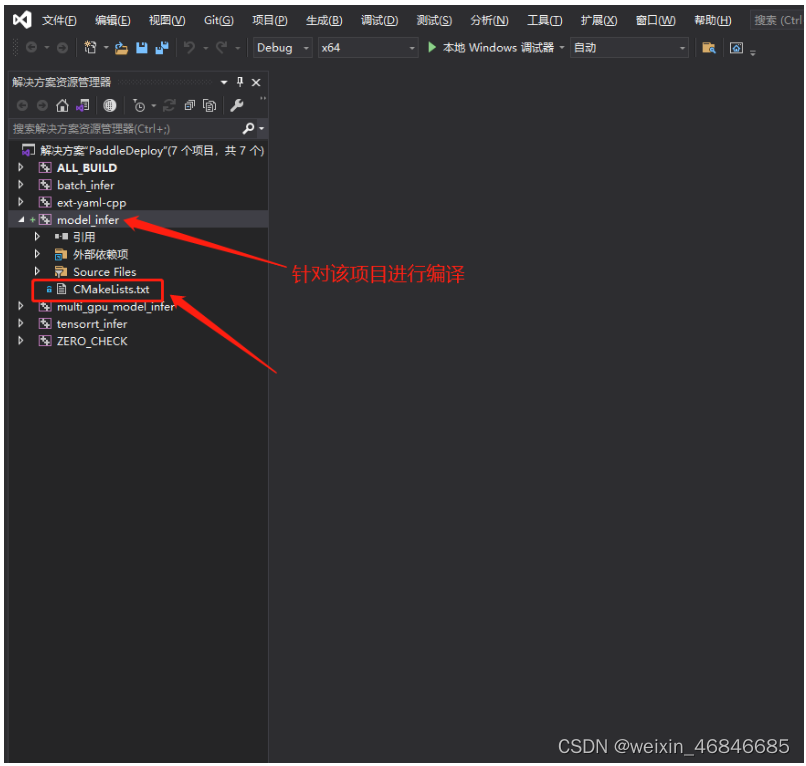

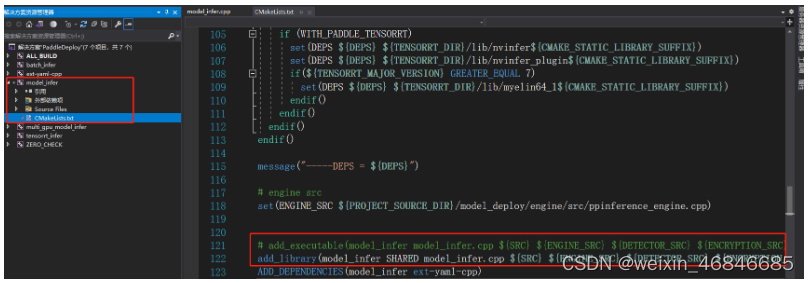

按照官方文档说明,首先使用vs打开PaddleDeploy.sln,按下图修改model_infer项目中的cmakelists,即将121行中的“add_executable”替换为“add_library”,在“model_infer model_infer.cpp” 中间增加“SHARED” :

关闭vs,然后用paddleX/deploy/cpp/docs/csharp_deploy/model_infer.cpp文件替换掉PaddleX/deploy/cpp/demo/model_infer.cpp。

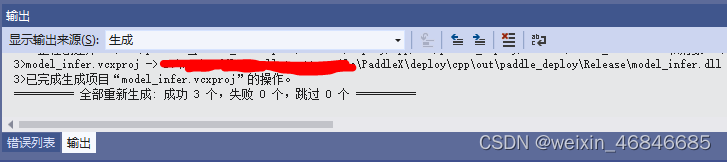

打开PaddleDeploy.sln,解决方案配置为release,对model_infer项目进行生成:

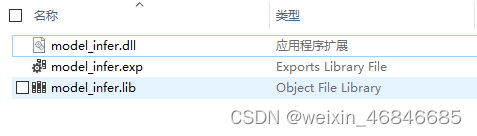

model_infer.dll文件生成成功,可在C#项目中进行调用,官方在PaddleX\deploy\cpp\docs\csharp_deploy\c#路径下给出了一个C#示例工程,读者可参照说明进行测试,这部分内容不再叙述。