一、正则化

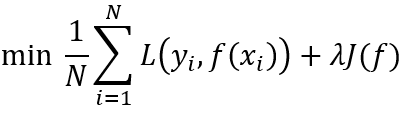

所有的有监督机器学习,无非就是正则化参数的同时最小化经验误差函数。最小化经验误差是为了极大程度的拟合训练数据,正则化参数是为了防止过分的拟合训练数据。

λ 为正则化系数,通常是大于 0 的,是一种调整经验误差项和正则化项之间关系的系数。

L1 范数就是矩阵中各元素绝对值之和;

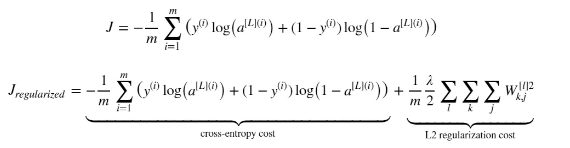

L2 范数是指矩阵中各元素的平方和后的求根结果。正则化的原理在于最小化参数矩阵的每个元素,使其无限接近于 0

L1 就是江湖上著名的 lasso,L2 则是岭回归

交叉熵损失函数加上正则化项L2范数:

二、dropout

dropout 可以随时随机的丢弃任何一个神经元,神经网络的训练结果不会依赖于任何一个输入特征,每一个神经元都以这种方式进行传播,并为神经元的所有输入增加一点权重,dropout 通过传播所有权重产生类似于 L2 正则化收缩权重的平方范数的效果,这样的权重压缩类似于 L2 正则化的权值衰减,这种外层的正则化起到了防止过拟合的作用。

版权声明:本文为Female_原创文章,遵循 CC 4.0 BY-SA 版权协议,转载请附上原文出处链接和本声明。