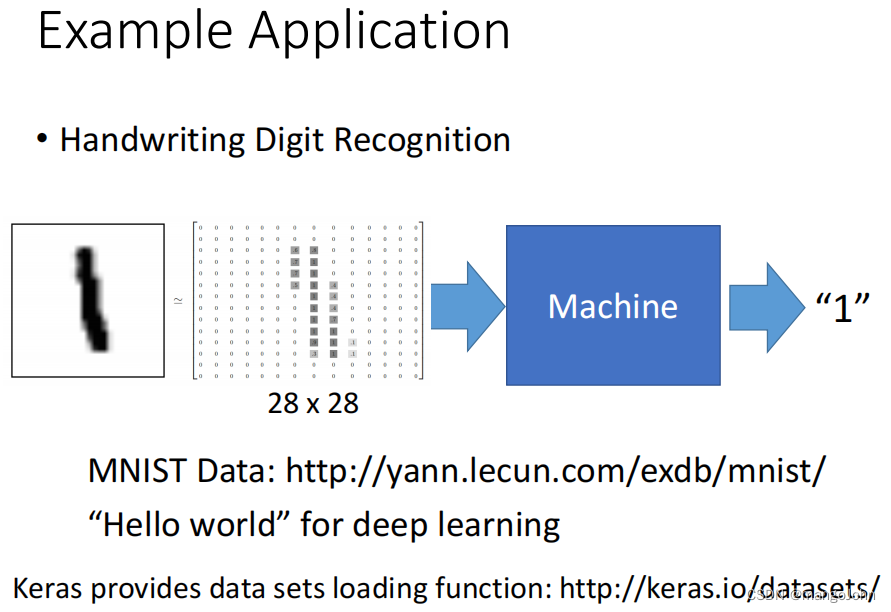

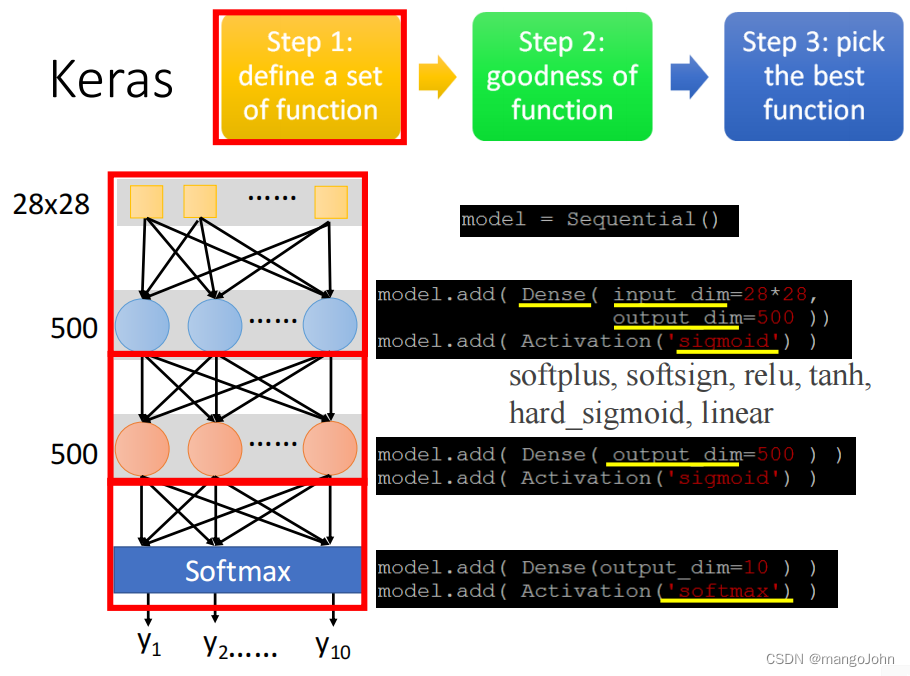

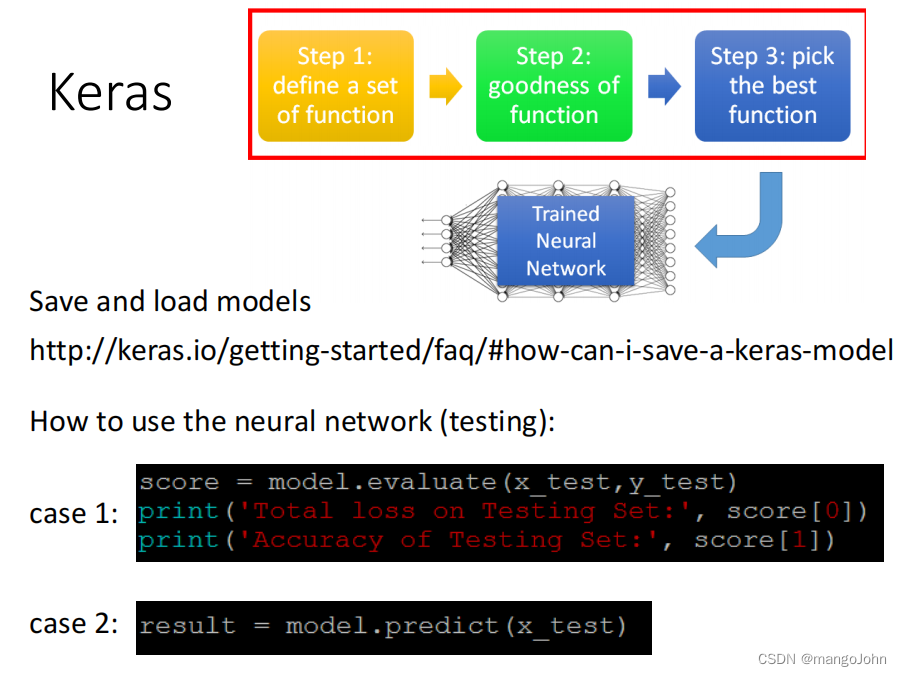

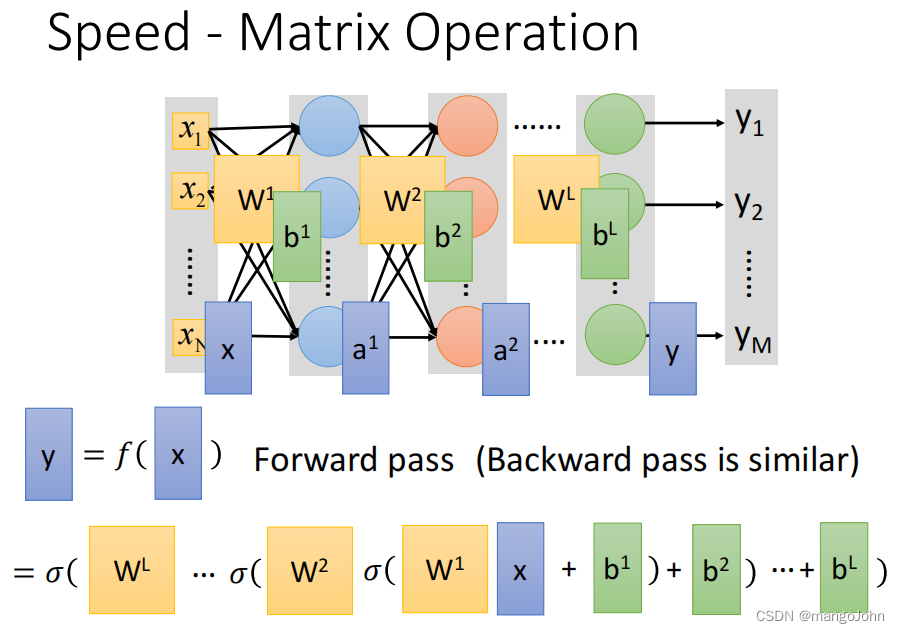

第一步:决定一下function set也就是neural network长什么样子

加一个fully connetced neural,

input 28*28的image,output 500的neural

用sigmoid当作activation function

下一个layer的input,就是上一个layer的output,所以下一个layer不用input

要做数字分类,所以最后layer是十维

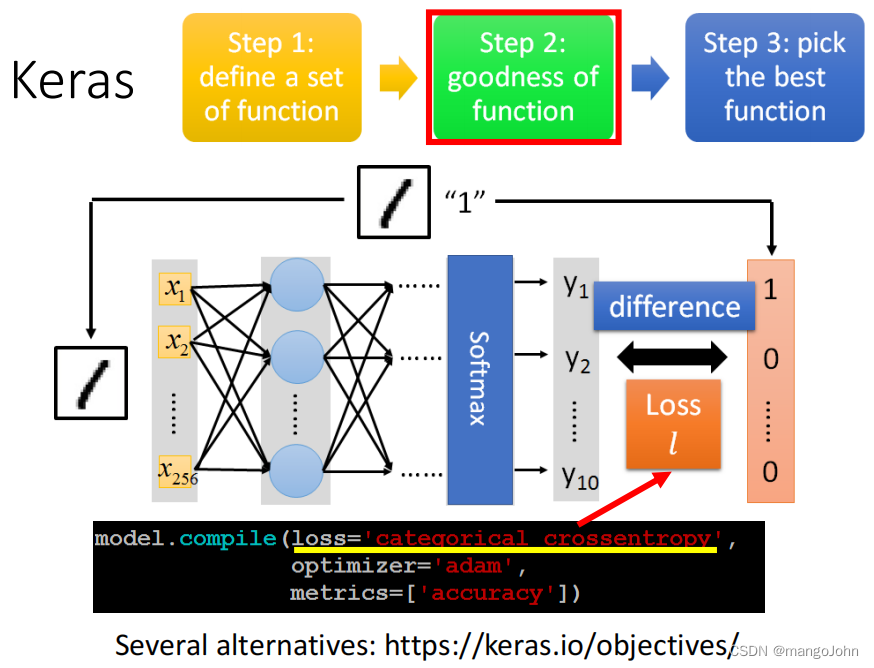

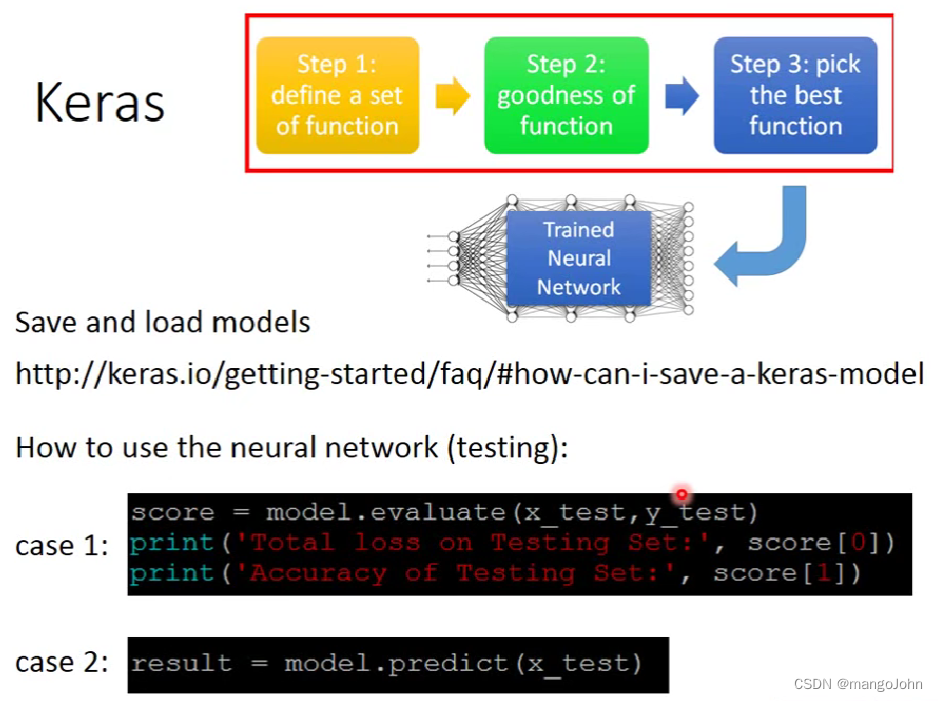

第二步:判断函数的好坏

loss function是categorical crossentropy(范畴交叉熵)

optimizer后面接的是learning rate,方法

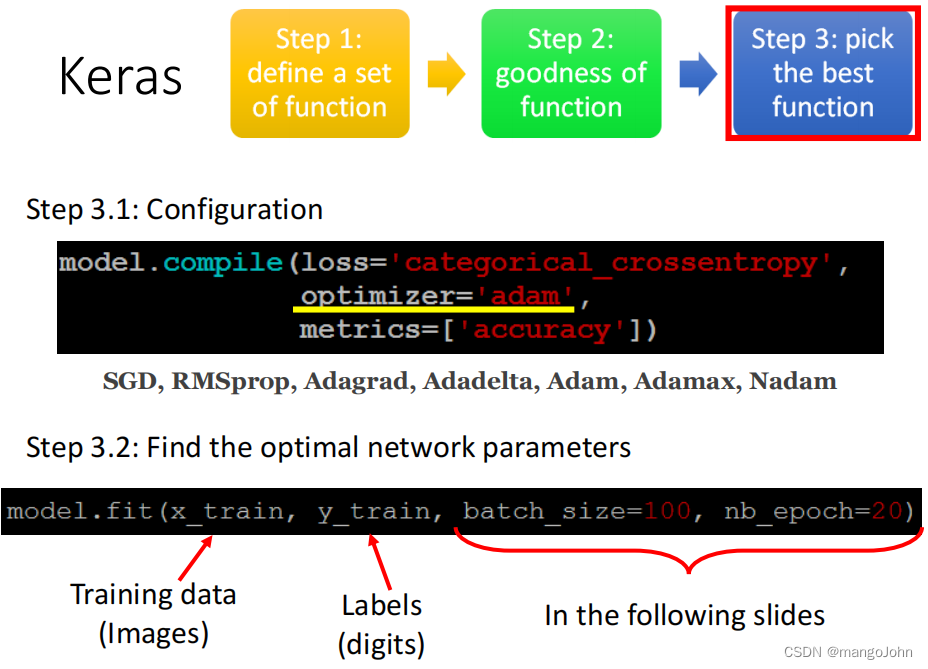

第三步:选择最好的函数

首先,配置方法,其次,找到最佳配置参数

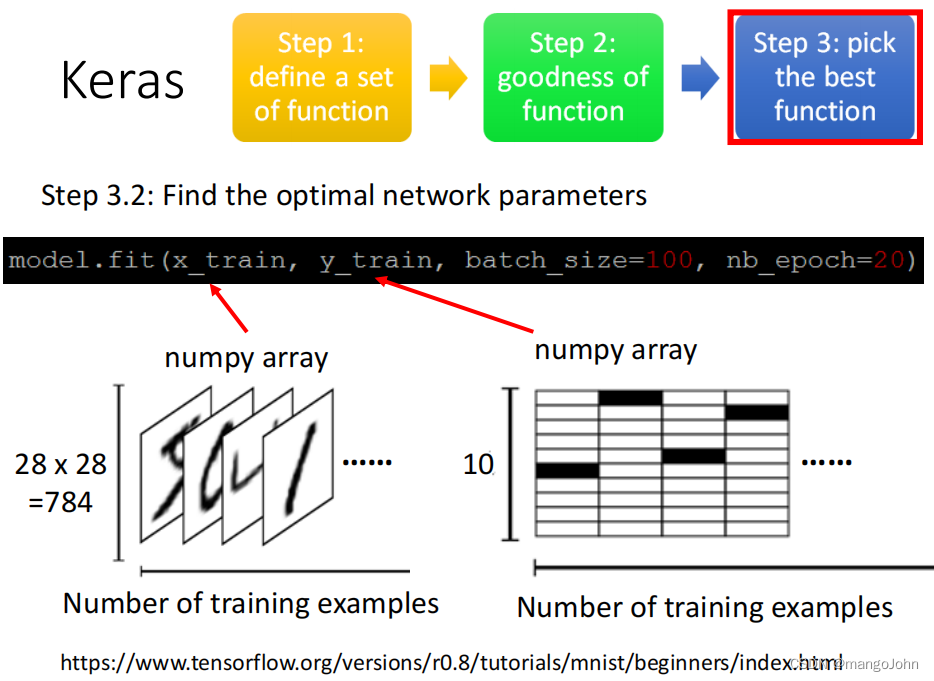

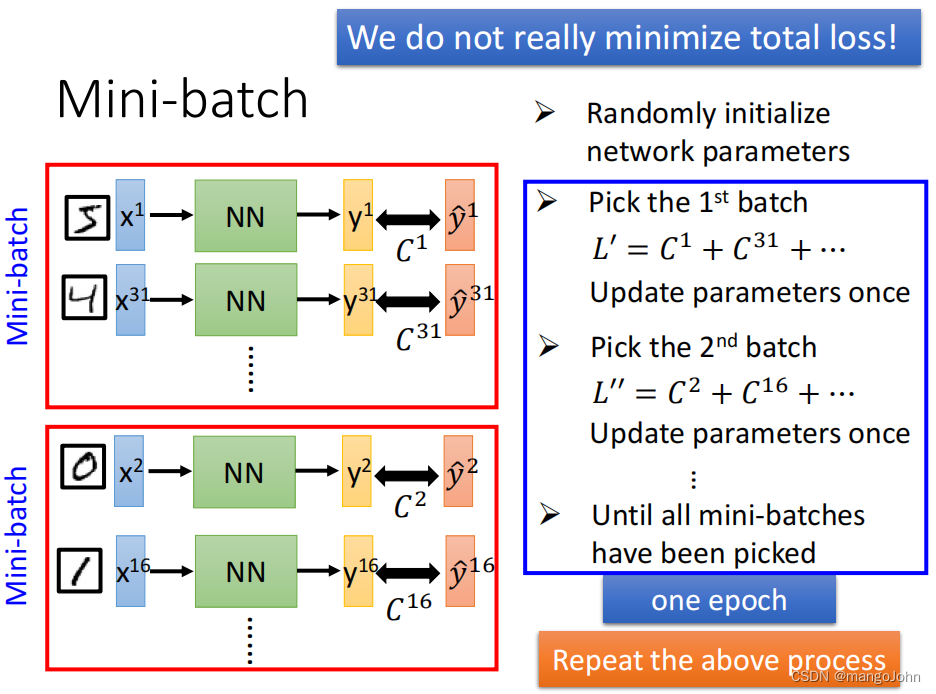

batch是随机的

计算第一个batch里面element的total loss,然后计算第二个,直到所有batch统统选过一次,这样的过程叫one epoch,重复上述过程

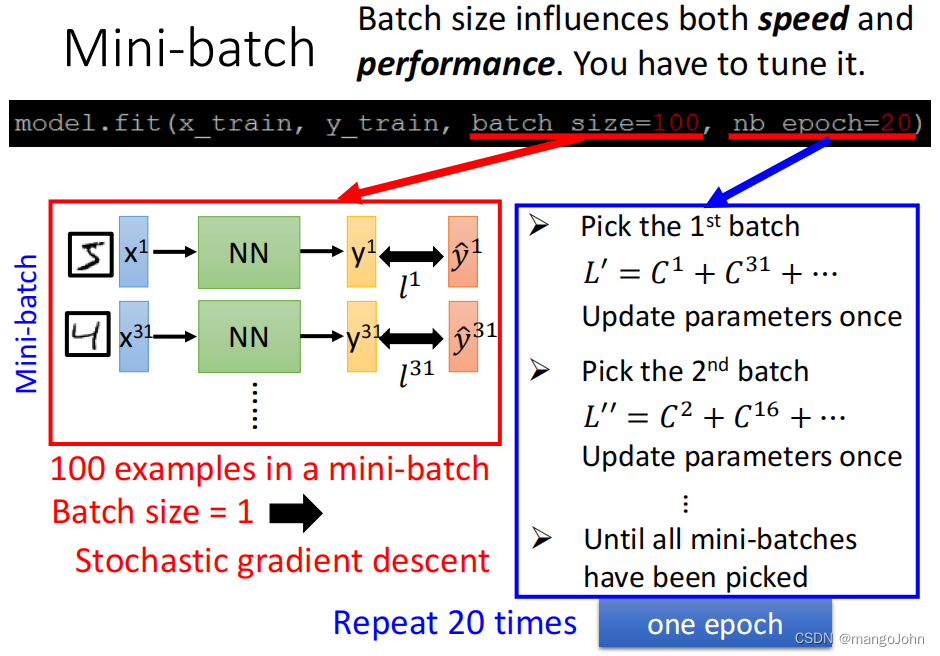

batch_size=100是把100个example放进batch里面

nb_epoch=20是重复20次epoch

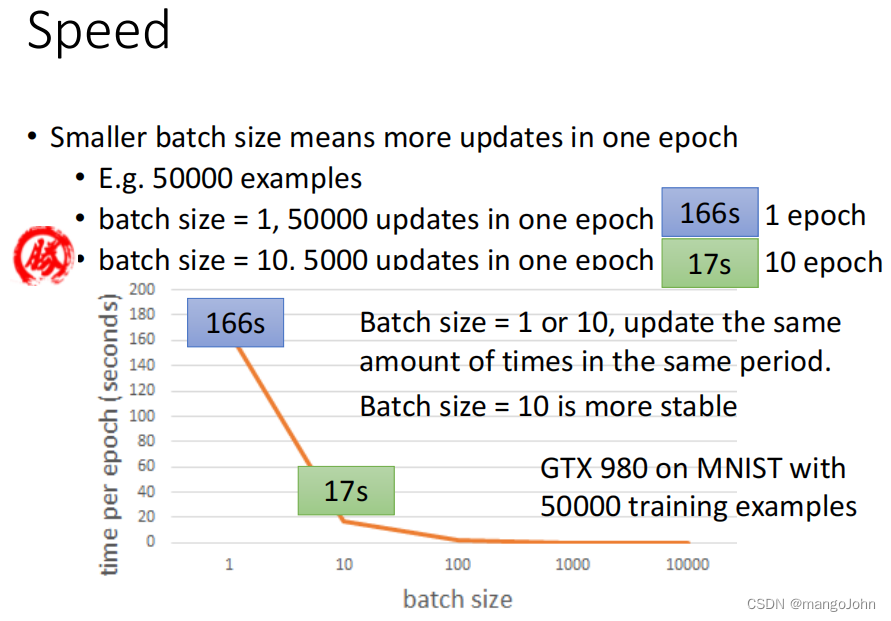

越小的batch大小意味着一个epoch里越多的更新

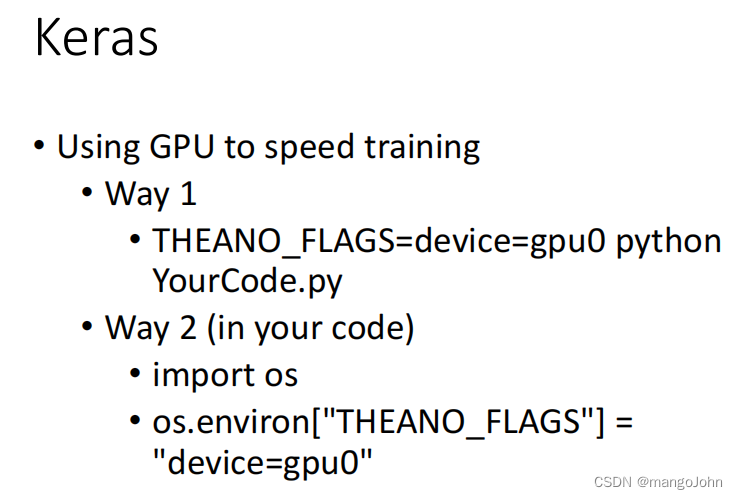

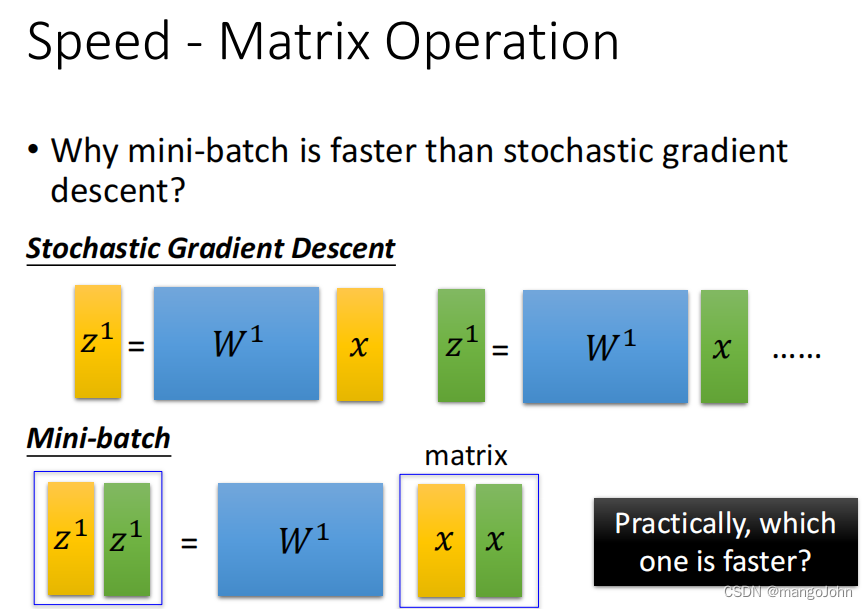

mini-batch 比随机梯度下降更快,用GPU速度翻倍

版权声明:本文为mangoJohn原创文章,遵循 CC 4.0 BY-SA 版权协议,转载请附上原文出处链接和本声明。