spark连接hive: shell窗口下:

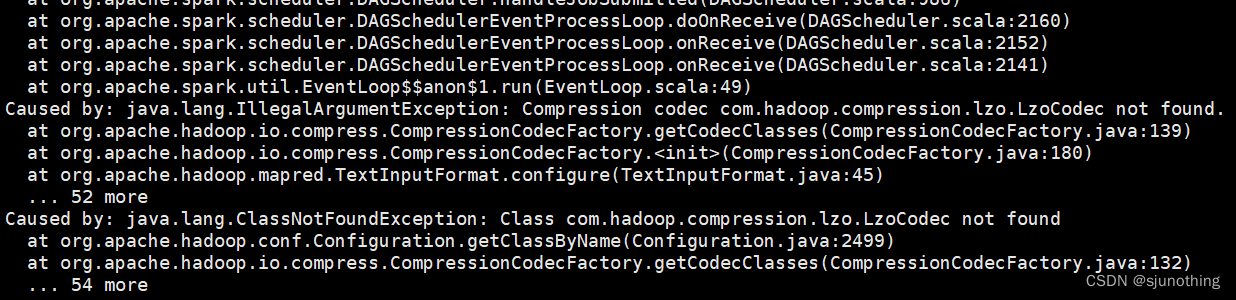

将core-site.xml、hdfs-site.xml、hive-site.xml复制到spark下的conf目录下,如果需要其它第三方包支持的,将第三方包放置jars下,例如:lzo压缩包,如果core-site.xml配置了相关lzo相关压缩,则将lzo的jar放置spark目录的jars中,然后

重新启动spark-shell即可。

版权声明:本文为sjunothing原创文章,遵循 CC 4.0 BY-SA 版权协议,转载请附上原文出处链接和本声明。