一,关闭防火墙

查看防火墙状态

systemctl status firewalld

关闭防火墙

systemctl stop firewalld

二,安装jdk和hadoop

1,通过Xftp 6将软件包传到虚拟机上

2,解压软件包

tar -zxvf 需要解压的包名 -C /usr/local

3,配置环境

vim /etc/profile

jdk:

export JAVA_HOME=/usr/local/jdk1.8.0_201

export PATH=$PATH:$JAVA_HOME/bin:$PATH

export CLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar

hadoop:

export HADOOP_HOME=/usr/local/hadoop-2.6.0-cdh5.7.0

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

4,重新加载配置

source /etc/profile

5,查看安装情况

输入java、hadoop查看

-bash: java: 未找到命令

不出现上面的信息基本就是安装成功了

三,修改主机名和IP的映射关系

vim /etc/hosts

在下面加入

192.168.99.200 hadoop

虚拟机的域名 后面自己随便起

四,配置ssh免密登录

ssh-keygen -t rsa

点击数次回车

ssh-copy-id 需要配置密钥的ip

免密就配置成功了

五,配置hadoop

1,进入hadoop文件夹

cd /usr/local/hadoop-2.6.0-cdh5.7.0/etc/hadoop

2,修改配置文件

(1)第一个配置文件名:hadoop-env.sh

vim hadoop-env.sh

#第27行

export JAVA_HOME=${JAVA_HOME}

将${JAVA_HOME}改为/usr/local/jdk1.8.0_201

把JAVA_HOME写成绝对路径,这么做是为了防止程序获取不到jdk的路径造成不必要的麻烦

(2)>第二个配置文件名:core-site.xml

vim core-site.xml

在

<configuration></configuration>

中加入下面的信息

<!-- 指定HADOOP所使用的文件系统schema(URI),HDFS的老大(NameNode)的地址 -->

<property>

<name>fs.defaultFS</name>

<value>hdfs://hadoop:9000</value>

</property>

<!-- 指定hadoop运行时产生文件的存储目录 -->

<property>

<name>hadoop.tmp.dir</name>

<value>/usr/local/hadoop-2.6.0-cdh5.7.0/tmp</value>

</property>

(3)>第三个配置文件:hdfs-site.xml

在```<configuration></configuration>```中加入下面的信息

<!-- 指定HDFS副本的数量 -->

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

3,格式化namenode

hadoop namenode -format

出现successfully 说明格式化成功

4,启动hadoop

start-dfs.sh

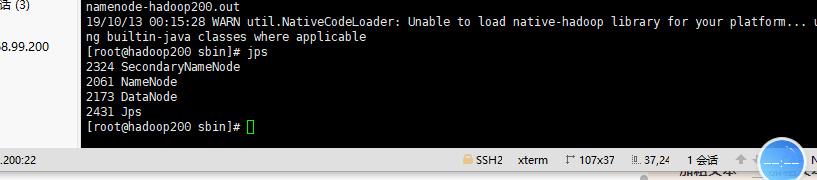

5,输入jps指令显示java程序的进程

启动成功

六,通过浏览器访问

在地址栏输入

192.168.99.200:50070

ip是自己虚拟机的ip

访问成功

搭建结束