从许多方面来看,回归分析都是统计学的核心。它其实是一个广义的概念,通指那些用一个或多个预测变量(也称自变量或解释变量)来预测响应变量(也称因变量、效标变量或结果变量)的方法。通常,回归分析可以用来挑选与响应变量相关的解释变量,可以描述两者的关系,也可以生成一个等式,通过解释变量来预测响应变量。本文主要讲述了线性回归的问题,详细描述了线性回归的建模、模型诊断、模型操作及模型可视化等。

《R语言实战–第2版》———Robert I.Kabacoff

本文内容:

- 回归的多面性

- OLS回归

- 回归诊断

- 异常观测值

- 改进措施

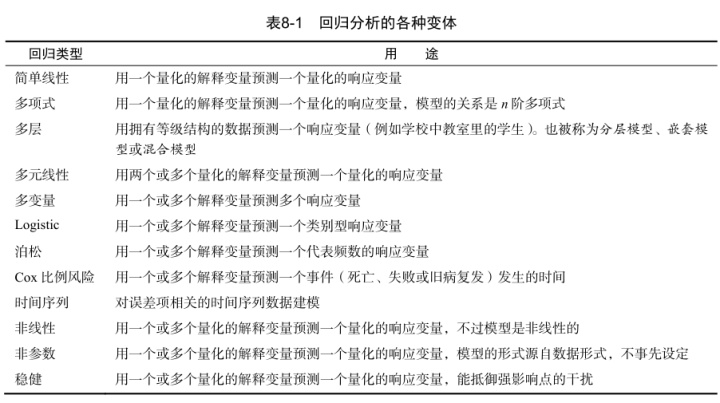

1. 回归的多面性

对于回归模型的拟合,R提供的强大而丰富的功能和选项也同样令人困惑。

在本次分享中,我们的重点是普通最小二乘(OLS)回归法,包括简单线性回归、多项式回归和多元线性回归。

2. OLS回归

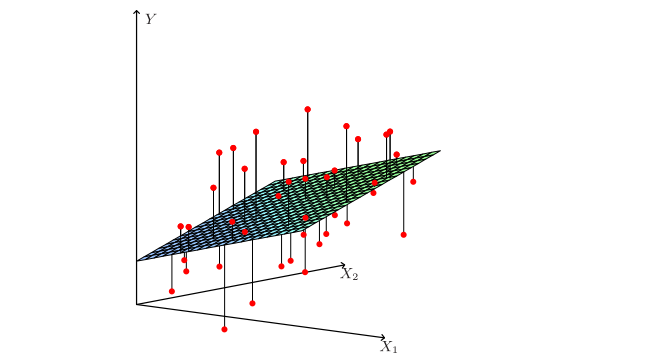

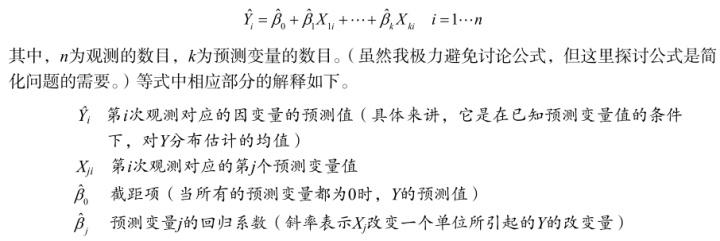

OLS回归拟合模型的形式:

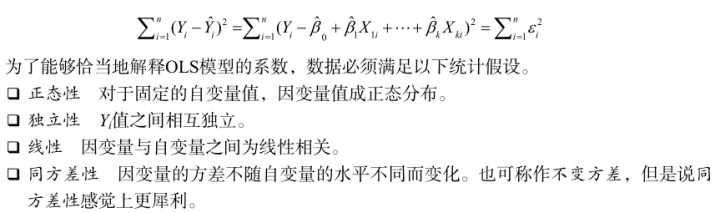

我们的目标是通过减少响应变量的真实值与预测值的差值来获得模型参数 (截距项和斜率) 。具体而言,即使得残差平方和最小。

观蒙斋主人:回归分析的基本假设zhuanlan.zhihu.com

机器学习—最小二乘线性回归模型的5个基本假设(Machine Learning Least Squares Linear Regression Assumptions)www.cnblogs.com

如果违背了以上假设, 你的统计显著性检验结果和所得的置信区间就很可能不精确了。 注意,OLS回归还假定自变量是固定的且测量无误差,但在实践中通常都放松了这个假设。

2.1 用 lm()拟合回归模型

在R中,拟合线性模型最基本的函数就是lm(),格式为:

myfit <- lm(formula, data)

其中,formula指要拟合的模型形式,data是一个数据框,包含了用于拟合模型的数据。结果对象(本例中是myfit)存储在一个列表中,包含了所拟合模型的大量信息。

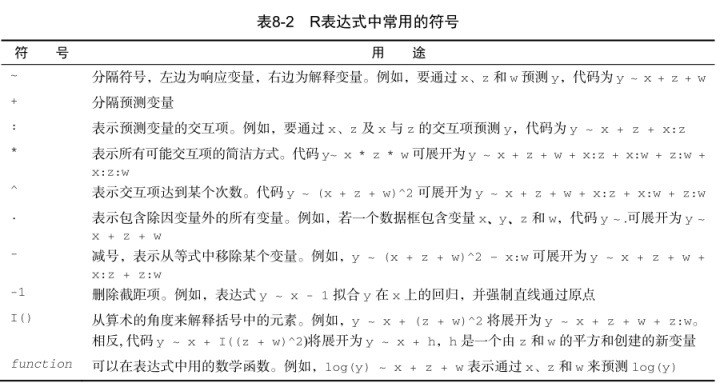

表达式(formula)形式如下:

Y ~ X1 + X2 + … + Xk

~左边为响应变量,右边为各个预测变量,预测变量之间用+符号分隔。

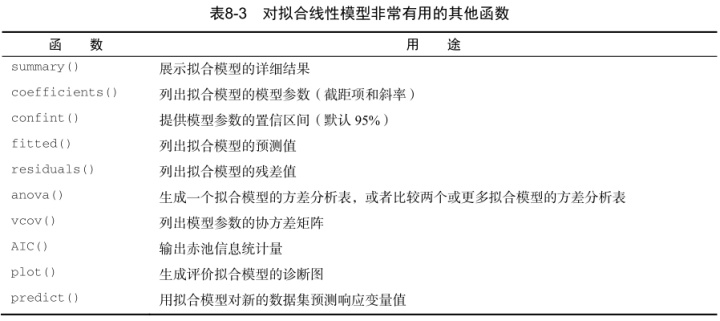

除了lm(),表8-3还列出了其他一些对做简单或多元回归分析有用的函数。拟合模型后,将这些函数应用于lm()返回的对象,可以得到更多额外的模型信息。

当回归模型包含一个因变量和一个自变量时, 我们称为简单线性回归。

当只有一个预测变量,但同时包含变量的幂(比如,

)时,我们称为多项式回归。当有不止一个预测变量时,则称为多元线性回归。

2.2 简单线性回归

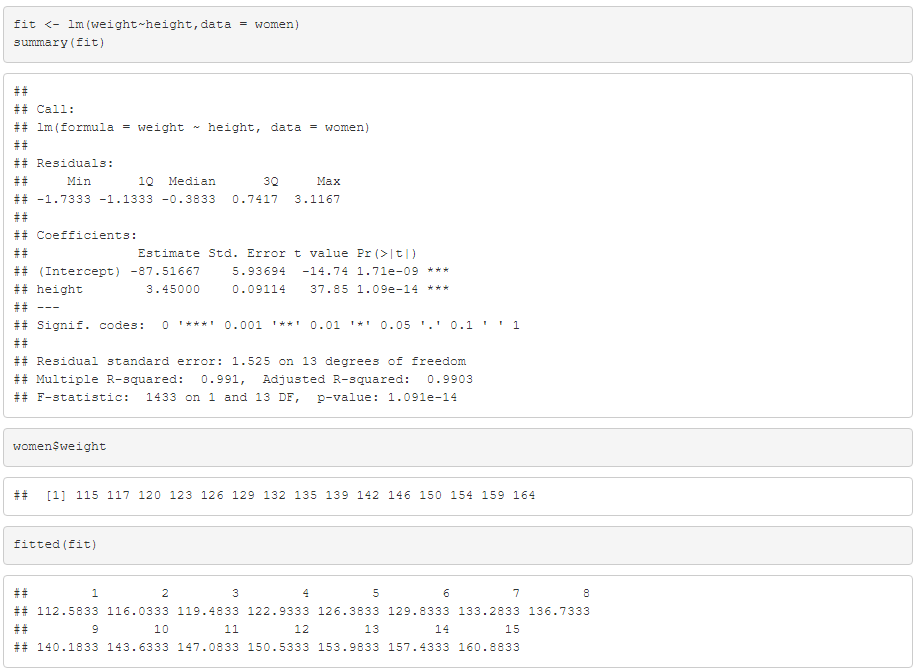

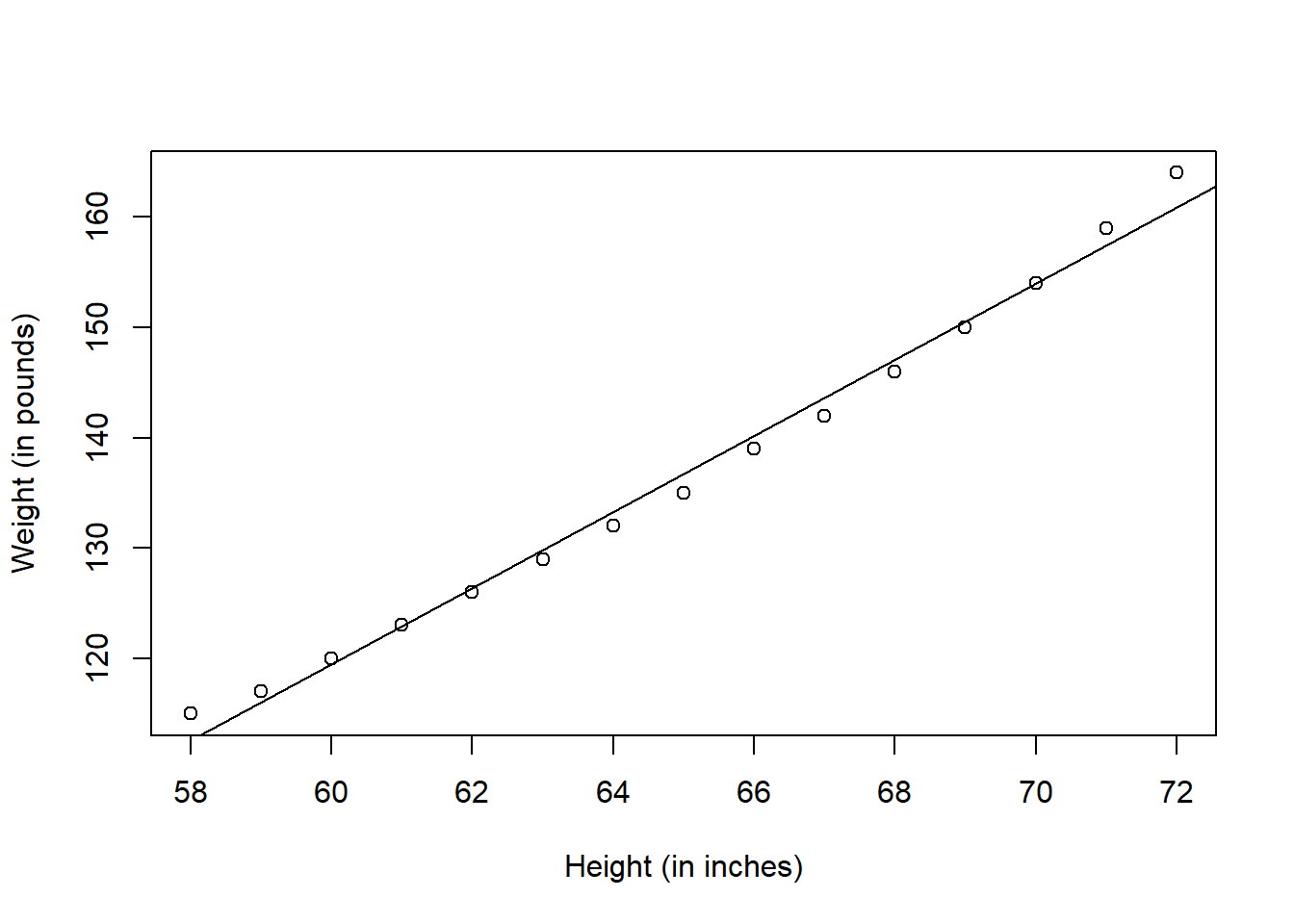

数据集women提供了15个年龄在30~39岁间女性的身高和体重信息,我们想通过身高来预测体重,获得一个等式可以帮助我们分辨出那些过重或过轻的个体。

fit <- lm(weight~height,data = women)

summary(fit)

women$weight

fitted(fit)

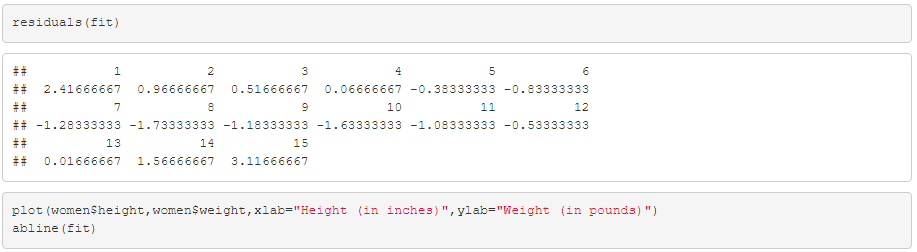

residuals(fit)

plot(women$height,women$weight,xlab="Height (in inches)",ylab="Weight (in pounds)")

abline(fit)

通过输出结果,可以得到预测等式:

因为身高不可能为0, 所以没必要给截距项一个物理解释, 它仅仅是一个常量调整项。 在Pr(>|t|)栏,可以看到回归系数(3.45)显著不为0(p<0.001) ,表明身高每增高1英寸,体重将预期增加3.45磅。R平方项(0.991)表明模型可以解释体重99.1%的方差,它也是实际和预测值之间相关系数的平方($R^2=r^2_{hat{y}y}$) 。残差标准误(1.53 lbs)则可认为是模型用身高预测体重的平均误差。F统计量检验所有的预测变量预测响应变量是否都在某个几率水平之上。由于简单回归只有一个预测变量,此处F检验等同于身高回归系数的t检验。

2.3多项式回归

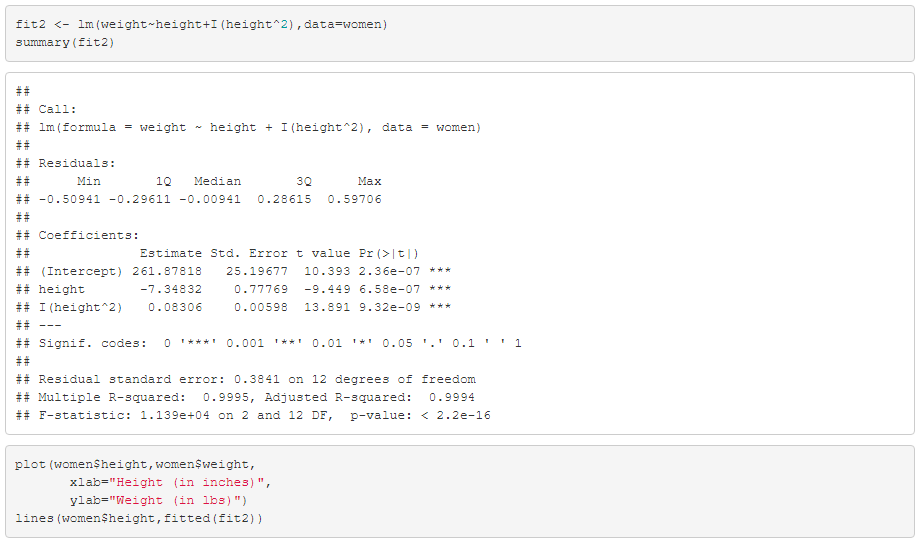

fit2 <- lm(weight~height+I(height^2),data=women)

summary(fit2)

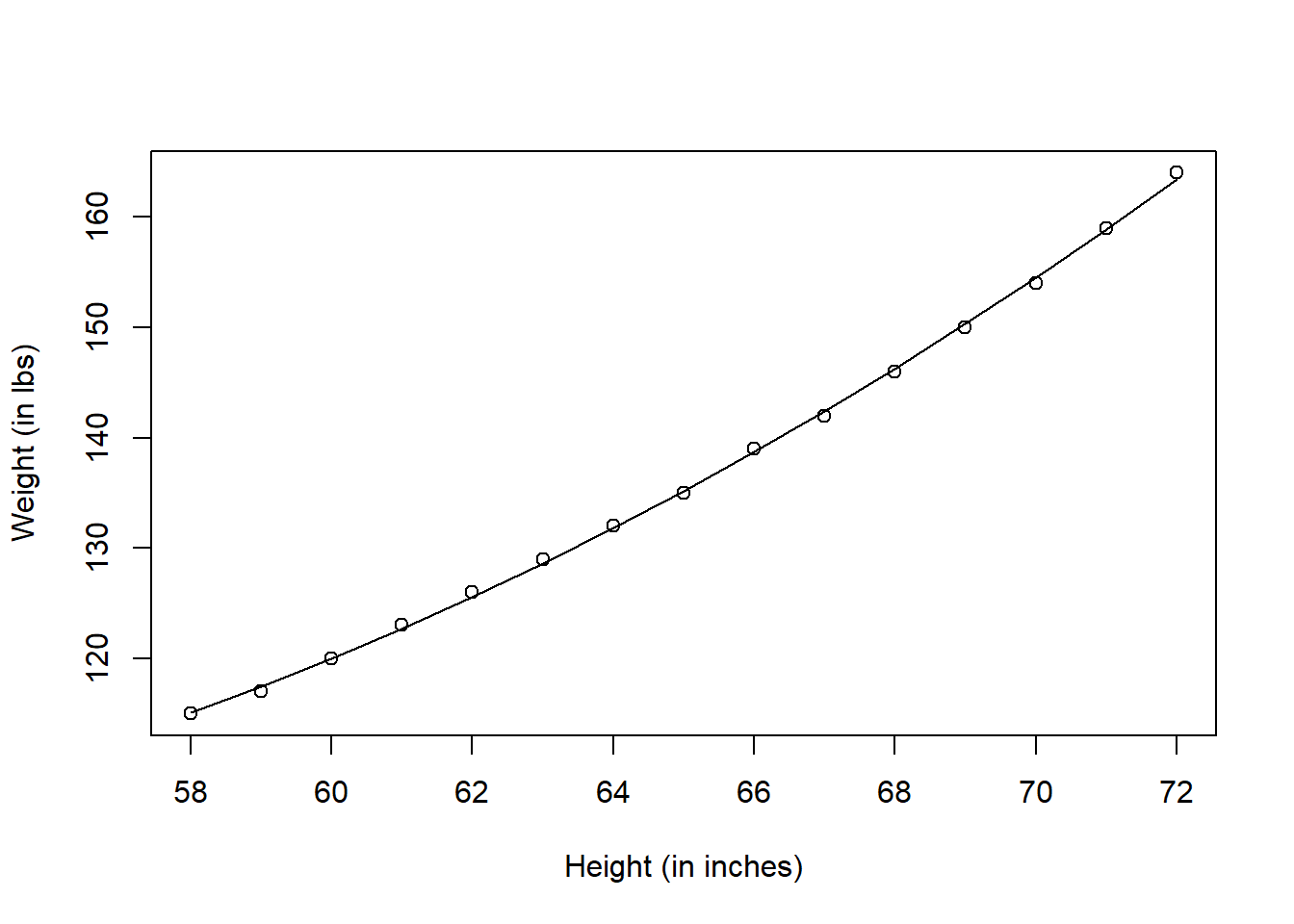

plot(women$height,women$weight,

xlab="Height (in inches)",

ylab="Weight (in lbs)")

lines(women$height,fitted(fit2))

新的预测等式为:

在p<0.001水平下,回归系数都非常显著。模型的方差解释率已经增加到了99.9%。二次项的显著性(t=13.89,p<0.001)表明包含二次项提高了模型的拟合度。从图也可以看出曲线确实拟合得较好。

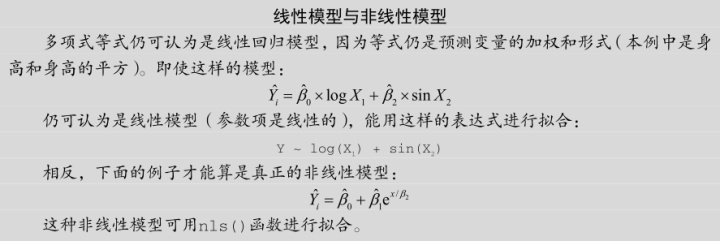

那线性回归的非线性回归的区别是什么呢?线性模型是指参数线性而不是x线性,同理,非线性模型是指参数非线性而非x非线性,如:

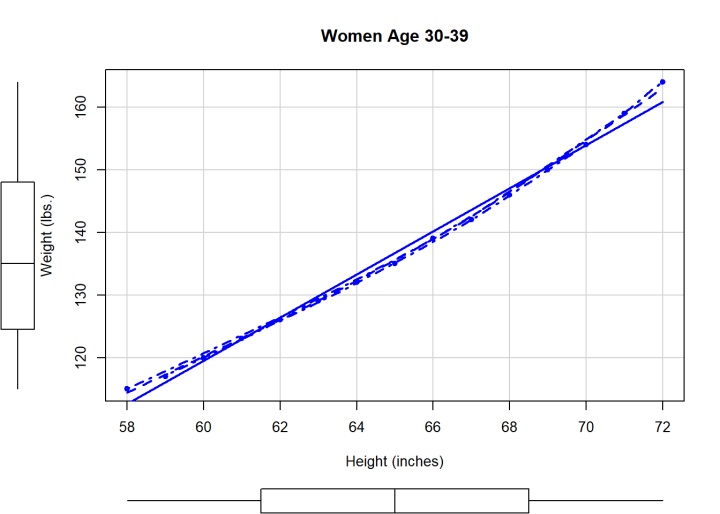

car包中的scatterplot()函数,它可以很容易、方便地绘制二元关系图:

library(car)

scatterplot(weight~height,data=women,spread=FALSE, smoother.args=list(lty=2), pch=19,

main="Women Age 30-39",

xlab="Height (inches)",

ylab="Weight (lbs.)")

这个功能加强的图形,既提供了身高与体重的散点图、线性拟合曲线和平滑拟合(loess)曲线,还在相应边界展示了每个变量的箱线图。spread=FALSE选项删除了残差正负均方根在平滑曲线上的展开和非对称信息。smoother.args=list(lty=2)选项设置loess拟合曲线为虚线。pch=19选项设置点为实心圆(默认为空心圆)。粗略地看一下图可知,两个变量基本对称,曲线拟合得比直线更好。

2.4 多元线性回归

当预测变量不止一个时,简单线性回归就变成了多元线性回归,分析也稍微复杂些。以基础包中的state.x77数据集为例, 我们想探究一个州的犯罪率和其他因素的关系, 包括人口、文盲率、平均收入和结霜天数(温度在冰点以下的平均天数) 。多元回归分析中,第一步最好检查一下变量间的相关性。cor()函数提供了二变量之间的相关系数, car包scatterplotMatrix()函数则会生成散点图矩阵 :

states <- as.data.fram