最后更新2021/07/06

在本节,作者一方面想给读者解释IBM PowerVM的一些基本概念,另一方面要统一双方对一些基本概念的界定和理解。IBM PowerVM几乎所有的组成部件都是IBM独立设计、开发的产品,尽管在IT业界有很多公开的标准可以匹配和遵从,但IT标准仅仅是业界的“共识”,而不是“法规”,也就是说厂商遵守也好,不遵守也罢,并没有什么权威的法律约束。作为IT技术的领导者之一(IBM作为IT技术的领导者是我们不得不承认的事实,而“之一”是IBM不得不承认的事实),IBM引领、参与、影响了无数IT标准的制定。在这一基础之上, IBM提出的技术设定往往会成为今后的标准,而IBM对相关概念的诠释也往往就顺理成章地成为了“官方”的概念解释。

事有例外,IBM也有很多技术并没有成为业界标准,而IBM这头巨象自然不满意这样的结果,它依然我行我素地走自己的道路,直到最后烈士断腕。在此期间,IBM标准、业界标准(主要的标准来源是IEEE/开源社区和厂商联盟)、其它厂商标准互相纠结争斗,直到某个标准一统江湖,时间可能会长达几年到十几年,最直接的后果是IT设施、实施专家要同时了解所有相关的概念和它们之间的区别。那么现在,我们也不得不先回顾这些概念。

-

AME Active Memory Expansion 动态内存扩展。由于IBM服务器的Power CPU性能越来越强,与之相匹配的高速内存的价格并不低廉,如果Power小型机系统配备完全足够的内存成本很高。在这种情况下,IBM PowerVM为Power 7 CPU小型机增加了内存数据动态压缩、还原的能力。物理内存中的数据可以由CPU进行动态压缩和解压缩,操作过程对内存中的程序、操作系统透明(当然可以通过一些命令进行状态察看和管理)。压缩和解压缩的过程当然需要消耗一些CPU的处理能力,但可以节省出大量的物理内存。有关AME技术的实现细节请阅读<2.5.13动态内存扩展AME>一节。

-

AMS Active Memory Sharing 动态内存共享。这是IBM PowerVM技术从Power 6 CPU开始增加的虚拟化功能,不仅仅CPU能在多个分区之间实时动态共享,物理内存也以可以实时共享。VIO Server提供了类似AIX操作系统paging space的功能,可以让分区“认为”自己拥有更多的物理内存。当分区真正访问到“并不存在”的物理内存的时候,就从已经分配给其它分区,但并未被使用的内存中获得[ 严格意义上,内存可能已经被使用,但被用于文件系统cache,AMS技术能够识别内存使用情况,释放可以被释放的内存。]。如果一台物理机上运行的所有分区需要的内存总和超出了真实存在的物理内存时,系统通过VIO上设置的专用交换交换区进行交换,来强制释放一些物理内存供分区使用。AIX操作系统级别已经可以实现paging space的虚拟内存功能,为什么还需要AMS功能在VIO上再次实现?这是因为在某些设计要求下,必须在比操作系统更低的层次上实现虚拟才能高效地利用内存资源。例如Power HA(即以前的HACMP群集技术)的一种配置方案是主备方案,即主机运行业务,备机处于热备、接管模式,随时等待接管主机业务。由于备机有可能接管主机,所以需要备机具有与主机相同的CPU、内存、IO配置以便在接管后保证运行性能。为利用备机(在虚拟化环境中是位于另一台物理机上的一个备份分区)的闲置资源,通常采用共享设计,从最初的VIO Server共享IO、到Share Partition的共享CPU,以至于AMS技术后的物理内存共享,可共享的资源越来越多。AMS解决的是AIX paging space虚拟内存模式无法真正获得物理内存的缺陷。AMS与在分区AIX操作系统中配置交换区有何区别?其实它们两者在技术上没有任何区别,但在使用中,在操作系统内部配置交换区,物理内存只能在同一操作系统中的不同进程之间进行调配,不可能超越同一操作系统的管理范围。AMS则可以跨分区实现,在多个操作系统之间进行调配。此技术非常有利于双机热备架构的群集系统,可以很好地利用备机闲置物理内存资源。有关AMS详细技术实现请参考<2.5.14动态内存共享AMS>一节。

-

APAR Authorized Program Analysis Report 通常与补丁程序关联在一起,其含义是经过IBM确认的程序bug报告,既然有bug,就需要有修补程序,因此每个APAR会有与之对应PTF Program Temporary Fix,就是对该bug的临时修正程序。在进行应用软件安装时,软件的安装要求往往不仅包含了最低操作系统版本(Version/Release)、最低技术版本(TL, Technology Level)和服务版本(SP, Service Pack)要求,还包括一组APAR(Authorized Program Analysis Report,即IBM对程序的故障分析及修复补丁PTF Patch Files[ APAR的IBM解释请参考:http://www-01.ibm.com/support/docview.wss?uid=swg21424131]),也就是单独需要安装的修复程序。AIX Version/Release/TL/SP都是定期推出,一般来说,Version的寿命是5年以上,从AIX面世的v4到目前的v7,在20年间已经有4个大版本推出;Release大约2年会有一个,每个版本3个Release左右,例如v4.3/v5.3(但v6.1只有一个Release);TL对应于每个Release,可能会有10个以上(TL以前称为ML, Maintenance Level。IBM觉得整天发布补丁太难听,特别是最近几年ML的定位从故障性补丁转移为功能性补丁,即不够成Release的小功能改进、对新机型的支持,所以将ML改名为TL),最著名的v5.3有12个TL之多。最后的SP只为特定TL提供补丁修补功能,原则上不会增加任何新功能、新支持。每个SP会包含很多个APAR(其实TL中也包含若干APAR,可以将TL理解为TL + SP0),每个SP大约3个月左右的生命周期。在最新的TL/SP中通常会包含所有以往发布的APAR(没有影响到的除外,例如某个功能/程序已经在当前TL中彻底消失或更改,APAR自然就不需要了)。但如果想使用稍低的TL/SP,那就必须安装要求的APAR。不要奇怪,有新的为什么还用旧版本?对于大型系统,很多应用程序如果已经运行在某个版本多年,经过持续不断的维护、修补,会进入比较稳定的时期,如果改用新版本,还会再经历一段故障较多的“磨合期”,这就是著名的‘浴盆曲线’。

-

APV Advanced Power Virtualization 是IBM对Power小型机虚拟化技术的称谓,包括分区、微分区、动态分区等技术。现在APV技术升级更名为PowerVM,并增添了一系列新功能。

-

ASMI Advanced System Management Interface 用于pSeries、Power小型机硬件管理的界面,物理接口是RJ45以太网接口,连通网络之后,使用Web浏览器或者HMC访问(HMC要首先与此界面连通)。ASMI提供比较底层的管理功能,当进行小型机首次初始化(通常此操作由IBM服务工程师完成)、与硬件设施相关的故障诊断和修复中才会使用,在本书中介绍了一部分Web菜单的功能和使用。详细技术请参考<6.2 ASMI管理>以及网站:

http://www-01.ibm.com/support/knowledgecenter/api/content/8247-22L/p8hby/p8hby_kickoff.htm -

BFF Backup File Format是一种AIX程序发布的格式,用于各种AIX安装程序,程序名的后缀通常是.bff,但并不是说程序名必须是xxxx.bff(AIX/Unix中文件类型与文件的后缀名无关)。BFF有两大类型,即安装类型和升级类型。升级类型需要已经有基础版本,必须在基础版本之上才能安装(有时安装类型也有一些预装软件要求,必须其它某种软件已经安装),但这两种类型在格式上没有区别,不同的是预装检测的内容不同而已,分为这两种类型纯粹是管理需要。如果是IBM发布的程序,在程序名中通常会标记相关信息,例如bos.adt.rte 6.1.8.3.U表示程序名为bos.adt.rte(bos表示basic operation system属于AIX OS的基础程序;adt是advance development tools高级开发工具的意思;最后的rte是runtime environment即运行环境),程序版本为6.1.8.3,这是升级程序(U),需要系统已经安装了任何一个bos.adt.rte 6.1以上的版本,或者在安装程序目录中存在任何一个对应程序的安装版,例如名为bos.adt.rte 6.1.6.0.I的程序文件(I表示安装版)。BFF格式的文件可以自己通过工具软件生成,在较新版本的AIX已经包含了创建BFF的命令bffcreate,或者通过bull网站下载工具。有兴趣的读者请参考以下网址的内容:

http://ramses.smeyers.be/varia/aix/createlpp -

BIST Built-In Self-Test 即固化于系统硬件基本输入输出程序(Basic IO System / BIOS)中的系统检测功能,用于系统(或者某个分区)刚刚启动时进行硬件设备和完好性检测。在虚拟化环境中,BIST通常指整机(物理机器Frame)上电时候进行的检测,而某个分区启动的时候由于物理整机早已经运行,所以没有什么BIST的工作要做。

-

Book 在IBM小型机中重要设备外都有金属壳保护装置,同时也提供了热插拔支持,这个设施就被形象地称为book。例如<图 22 Power 6 595小型机及BPA前视图>中部(未放大的部分),六个黑色带把柄的装置就是CPU book(图中有两排每排3个CPU book)。

金属壳保护的目的一方面是防止物理损坏,另一方面是进行电磁屏蔽减少干扰,其实同时也增加了对宇宙射线的屏蔽。读者不要觉得这是天方夜谭,事实上,IBM芯片研发机构通过对芯片损伤的分析发现,在正常使用情况下(非过热),有很大比例的芯片故障,特别是超大规模集成电路故障源自于宇宙射线。 -

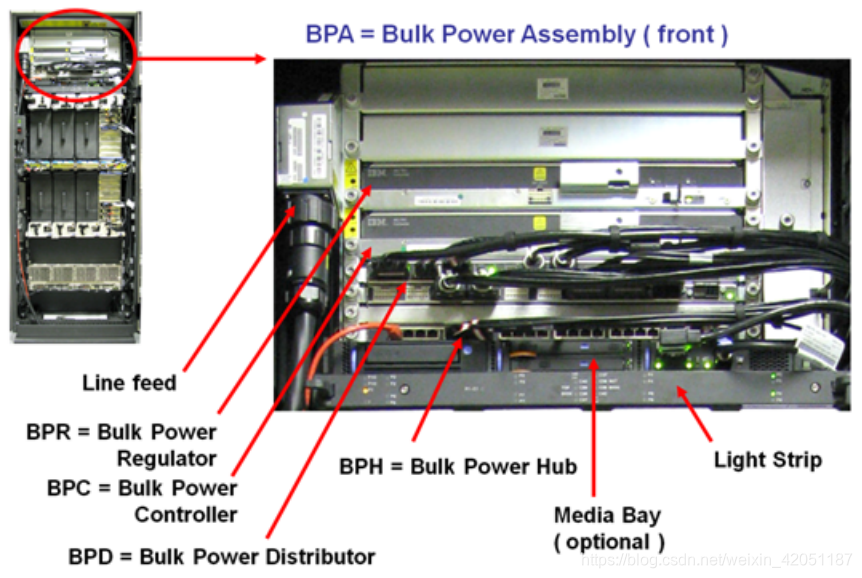

BPA Bulk Power Assembly IBM电源组件(电源系统的总称)、BPC Bulk Power Controller电源控制器、BPD Bulk Power Distributor 电源分配器、BPH Bulk Power Hub电源组件Hub(就是一个内置的以太网集线器用于连接电源系统内部组件和Service Processor)、BPR Bulk Power Regulator 电源整流器。<图 22 Power 6 595小型机及BPA前视图>中左图上层装置整体为BPA。这一系列设备通常只存在于IBM小型机中的高端机型,而其它中低端机型则只存在两个简单的独立电源,通过SPCN控制。

-

BSR Barrier synchronization register 用于支持多线程之间信号同步的寄存器。在分区设置中有一个选项参数可以打开或者关闭对BSR的支持。如果分区用于多线程科学计算,需要线程之间同步,可以通过打开BSR支持提高分区性能,反之则关闭它以减少无用的硬件消耗。实际上,即使不打开此寄存器,线程程序之间信号同步依然可以进行,不过是软件实现,效率较低而以。

-

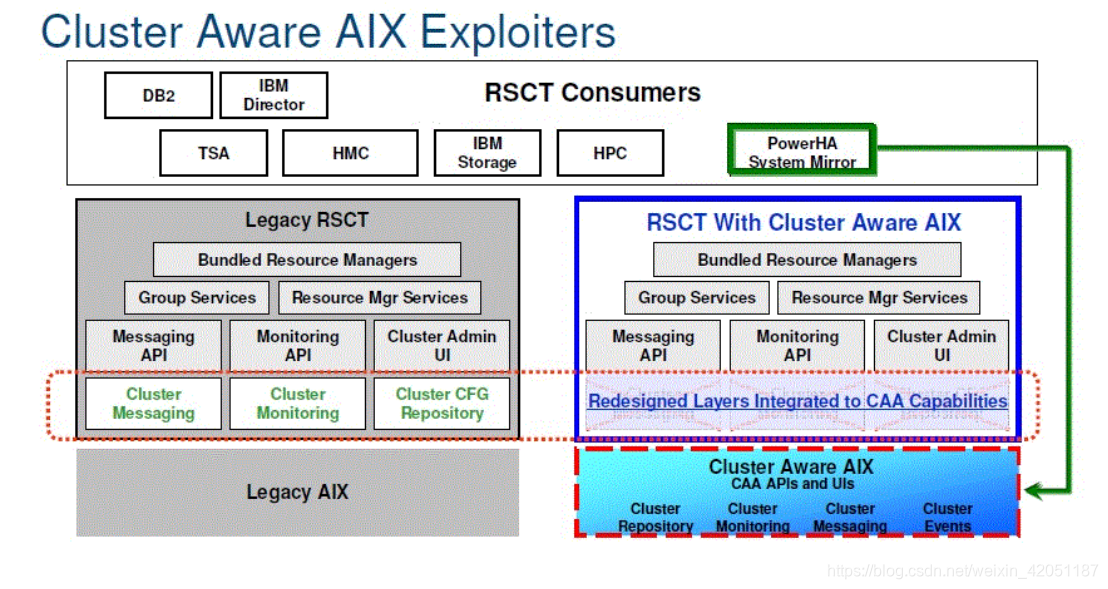

CAA Cluster Aware AIX内核支持群集的AIX。以往版本的AIX本身没有任何群集管理扩展,所有的群集功能都由外挂的程序完成,例如RSCT、CSP、PowerHA。AIX 6.1 TL6或AIX 7.1以后版本直接把部分群集功能集成到内核,使得AIX与群集管理软件联系更为紧密也更为可靠。如图<图 23 AIX内核支持群集功能>所示。由于CAA功能刚刚开发,目前还有很多bug,相信以后随着版本升级和bug修复,会越来越强大。

– CEC Central Electronics Complex,IBM的硬件系统经常用Complex(设施,另一个类似的名词是Facility)表示某一种设备组合,CEC也就是中心电子设备的意思,即小型机的主要电子设备——CPU/内存/系统板。而常说的CEC Drawer则表示小型机中装载主要电子设备的Drawer(抽屉, 参考Drawer词条)。 -

CSM Cluster Systems Management,IBM提供的群集系统管理软件,其客户端免费提供,在AIX 5.3以上操作系统中捆绑提供,安装操作系统的时候自动被安装。注意,如果不是新安装系统,而是由旧系统升级而来,则有可能由于升级步骤、方法不同,此软件集没有被正确安装,或者缺失部分文件集,在以后导致一些操作问题。如果遇到此类问题,需要先修正安装错误然后再去分析故障,最简单的解决方案是删除全部CSM文件集,再根据需要安装符合当前操作系统版本、补丁的CSM文件集。前一段时间,一度有消息说IBM放弃了未来对CSM的支持而转为xCAT,最近的新信息是CSM还会存在,并且会吸收很多xCAT的功能。其实CSM和xCAT的功能互相重叠,它们的区别是CSM由AIX项目组成员研发,属于闭门造车的产品(仅为作者个人看法),并且当时只支持AIX;而xCAT是IBM产品使用者(也是IBM工程师)开发,后来成为开源产品,更实用有效,但缺乏针对性和OS(AIX)底层内核支持。另外由于xCAT是开源产品,任人都可以插手分析,CSM则完全是版权产品,比较封闭,很难做进一步扩展。CSM与其它群集管理软件的功能也互有重叠,它们偏向于设备、硬件、底层管理,也就是控制硬件设备起动、引导过程等,而不具有直接的应用、业务接管等功能。更多内容请参考本节RSCT词条的介绍(RSCT的作用是提供其它群集管理软件基础的使用接口,也就是说CSM也需要依靠RSCT提供一些管理接口)。

-

CUoD Capacity Upgrade on Demand 这是IBM的一种硬件销售模式,即预先收取很少的费用但是额外提供更多的CPU、内存给买方,不过这些额外的资源并没有被激活,买方不能使用,相当于汽车的备胎。当买方实际购买(已经被激活)的硬件出现故障的时,或者买方付费升级系统,获得并输入了激活码完成激活操作之后,这些预先提供的硬件资源立刻就可以使用或者自动替代故障的系统资源(当然是坏一颗CPU,或者新购买一颗CPU资源,系统允许使用一颗新CPU)。激活过程对于最终用户是动态、透明的,系统的使用者不需要重启动分区、操作系统等操作。但是CUoD仅影响整机全部可用的资源,某分区最大可使用资源依然受分区配置资源表(参考profile词条)设定限制。CUoD升级、激活代码有很多类型,有永久激活、临时激活、按日计费等等,针对不同的资源也有不同的代码:

POD CPU升级/激活代码(Processor On Demand)

MOD 内存升级/激活代码(Memory On Demand)

TCOD 打开、关闭临时或按日计费CPU激活代码(Temporary COD)

TMOD 打开、关闭临时或按日计费内存激活代码(Temporary MOD)

PAID 保留CoD预付费代码(输入之后会更改可使用的预付费量)

VET 虚拟化版权升级/激活代码(Virtualization Technology Code)

STDP 标准CPU试用激活代码(Standard Trial CoD Processor Code)

STDM 标准内存试用激活代码(Standard Trial CoD Memory Code)

EXCP 特别CPU试用激活代码(Exception Trial CoD Processor Code)

EXCM 特别内存试用激活代码(Exception Trial CoD Memory Code)

USTA 按使用量计费CoD激活代码(Utility CoD Activation Code)

USTO 按使用量计费CoD终止代码(Utility CoD Termination Code)

URPT 按使用量计费CoD使用报告代码(Utility CoD Reporting Code)

PAID 按使用量计费CoD预付费激活代码(Reserve CoD Prepaid Code) -

Dedicated(独占)在IBM Power虚拟化系统中Dedicated意指该CPU资源被某个分区独占,而不会在多个分区之间共享。虽然是独占,IBM现在提供一种License使得独占分区空闲的CPU也可以被其他分区共享,当然独占分区自身具有最高优先级,只要需要就可以无条件把所有应属于他的CPU都拿回来。独占分区CPU最小分配粒度和使用粒度相同,都是0.1(Power 4的分区只支持独占模式,并且最小分配单位是1,最新Power 7的分配颗粒度是0.05和使用颗粒度还是0.01)。

-

Desired(期望)在IBM Power虚拟化系统中,表示某个分区希望得到的(CPU或者物理IO卡)资源,但分区运行过程中真正获得的(Entitlement)资源和Desired资源可能不同。原因可能是分区启动时没有足够资源,而仅仅获得了一部分,导致实际Entitlement资源少于Desired资源;另一个原因是Dlpar,通过Dlpar,可以调整分区Entitlement资源,进行增加或者减少操作。与Desired和Entitlement有关的其他几个名词是min、max、required,请参考<2.4.5 Profile CPU参数>和<2.4.7 Profile物理IO设备>。

-

DGD Dead Gateway Detection,AIX操作系统提供的一种网络技术,可以周期性地测试网关的连通性,如果网关不可访问,则触发操作系统动作,进行路由切换,保证网络继续畅通。在进行网络虚拟化设计的时候,有时需要使用DGD技术进行网络连通性判断,以提高网络的可靠性。当然,普通的AIX分区也可以使用DGD,此技术并非PowerVM所有,而是AIX的一种功能,用来提高网络的可靠性。由于即使双VIO的网络接管功能也仅仅检测网络硬件端口的物理联通性,不去判断IP层面地联通性。在很多网络故障情况下,网络物理层正常,但路由故障,VIO不会触发接管动作(最新版本的VIO虚拟网桥接驱动增加了物理信号“传递”的功能——如果VIO SEA物理网络连接中断,网口宕掉的信息会回传给分区虚拟网卡,而触发监控虚拟网卡的软件,例如PowerHA,进行切换动作),而且即使接管,网络2层的切换依然不能解决3层问题。DGD功能则通过AIX主动进行此类判断,如果有问题,可以主动触发路由切换动作。由于现在骨干网络路由也开始使用各种冗余机制,在AIX操作系统来完成判断和动作的需求越来越少,当然,在某些小型网络、低端路由配置时引入此功能可以很有效地提升网络的可靠性。详细请参考:

https://www.ibm.com/docs/en/aix/7.2?topic=routing-dead-gateway-detection -

DHCP Dynamic Host Configuration Protocol用于小型机网络地址管理的技术,可以动态为同一个以太网上连接的小型机分配IP地址,进行域名解析。在IBM虚拟化小型机系统管理中,HMC本身就是DHCP服务器,为其管辖FSP(Firmware Service Processor物理小型机的管理控制设备,参考本节FSP词条)分配IP地址。在双HMC管理的架构下,如果2层网络设置不合理,可能会发生DHCP冲突,在设计中要想办法避免。

-

Director,又被称为System Director,是IBM开发的系统管理软件,最初始版本主要用于对刀片小型机和xSeries PC小型机管理,有消息说IBM最终会用Director替代HMC,将Director的管理功能扩展到高端Power小型机,但由于SDMC(System Director Management Console)的市场失败,让这一想法夭折。IBM新梦想好像是要用SC(Smart Cloud)集成所有这一切,但作为成熟的直接硬件管理接口HMC体系依然存在,今后的产品走向未知。

-

DLpar Dynamic Lpar 动态分区技术是IBM小型机分区技术的延伸,在原有小型机分区技术的扩展。通过HMC、硬件分区(Hypservisor虚拟化管理系统)、分区上运行的AIX操作系统之间的交互动作,可以对分区资源进行分配/识别和释放/回收,完成小型机设备资源的重新分配,例如增减CPU、内存或者IO卡,而不用重新初始化(重启动)小型机或者分区。

-

DR Dynamic Reconfiguration 这是AIX操作系统提供的一种先进功能。大部分传统的操作系统只在启动的时候进行资源识别,在系统运行过程中,资源不能调整,否则会导致各种异常现象,例如死机。AIX中则引入了新一代操作系统动态资源管理的概念,可以随时调整大部分系统资源,增加或者释放,可调配的资源甚至包括核心的CPU、内存、总线设备等,这些功能得益于AIX的动态内核设计。但是为了最大限度保证系统的稳定和可靠,AIX的动态管理功能并非完全自动处理所有的资源调整,通常需要人工干预或者按照预先定义的策略进行处理,例如先执行命令释放某个设备之后才允许物理上断开该设备的连接(或者通过动态分区DLpar技术移走),而对新连接的物理设备需要执行诸如cfgmgr命令进行识别和配置动态资源配置。随着AIX、HMC管理技术的集成化程序越来越高,很多操做都由AIX/HMC在执行相应动作的时候自动完成,在新版本的AIX/HMC管理下,已经不需要手工执行cfgmgr去识别由DLpar功能新添加的设备了,但实际上,这一步骤依然存在,不过有HMC代替人工发送了cfgmgr的命令而已。

-

DRM Dynamic Reconfiguration Manager 在动态进行分区(Partition)资源移动的时候,需要先在逻辑层面让此分区上运行的AIX操作系统了解到即将进行的操作,让AIX预先(或者滞后)进行一些处理,释放或者识别被移动的设备资源。这个工作就是由DRM完成的,它是一组软件,通过RSCT与HMC通信,接收HMC发出的指令,触发AIX操作系统进行动作。在AIX操作系统中负责这个工作的是一个系统进程,就是DRM程序,它隶属RSCT_RM进程资源组。

Drawer抽屉。IBM小型机都是模块化设计,重要设备通过类似抽屉的铁箱子装载到机柜上。一台小型机往往有多个抽屉,抽屉之间用专用电路板或者线缆连接。每个抽屉中插着电路板卡,某些重要板卡或者支持热插拔的板卡外面还有Book作为保护。 -

EC EtherChannel 最早由Cisco开发的一种网络线路聚合技术,支持将多路网络线路聚合在一起,看成一条虚拟线路,绑定一个MAC地址进行数据传输的技术,可以增加网络带宽或者提供故障冗余功能。在IBM小型机虚拟化技术中经常需要利用此技术增加网络的冗余度或者提升网络性能。但Ethernet Channel只允许这些聚合链路连接同一台交换机,并且在交换机上也采用同样的标准(技术)进行设置(在高端Cisco交换机,现在也支持跨交换机的EtherChannel,但需要特别配置,被称为Channel Group)。AIX支持两种聚合标准:Cisco Etherchannel和802.1ax/LACP(Link Aggregation Control Protocol)。

-

ECC Error Checking and Correcting一种常用的数据校验和更正技术。一般采用奇偶校验的方式对数据的正确性进行验证,不同的校验算法对数据更正的能力不同,简单的算法只能检测出一位数据错误发生,而复杂一些的算法则不但可以发现,还可以更正多位数据错误。

-

Entitlement(应有、应得)IBM Power虚拟化系统中Entitlement表示某一分区当前应当具有、可以保证的资源。分区可以由于空闲“主动”释放CPU资源给其他分区,但是当分区需要的时候,一定可以获得Entitlement的资源。Entitlement与Desired区别是后者为期望得到的数值,如果实际没有那么多,只要分区能获得的CPU资源数大于Min的要求,分区就可以启动,而实际获得的这个数值就是Entitlement的数值。所以分区启动时Entitlement的数值介于Min和Desired之间,最大为Desired设定,但不会小于Min设定。分区运行中,可以通过Dlpar进行资源调整,调整的过程就是更改Entitlement设定的过程。经过Dlpar之后,entitlement可以是介于Min和Max之间的任何数值。Entitlement有动态、静态两个含义,当分区启动的时候,如果可用CPU数量少于Desired但大于Min,则分区依然可以启动,分区将获得当前可用的最大数量的CPU,这个数值就是静态的Entitlement,通过HMC查看分区当前特性properties可以看到此数值。如果不重新re-active分区profile或DLpar,此数值不会变化。我们知道共享(Shared模式)分区运行的时候,实际使用的物理CPU数量会不断变化,每时每刻真正使用的CPU数值就是动态的Entitlement,可以通过在AIX上执行vmstat看到ec数值在不断变化。

-

EPOW Environmental and Power Warning,IBM小型机常用的缩写,代表计算机的供电和运行环境。如果小型机管理芯片检测到电源或者运行环境不符合要求(例如环境温度过高、双路供电电源丢失一路),则会发出EPOW故障警告信息。故障信息会发送到每个分区,每个分区都会在errlog中显示标记有EPOW的错误信息,以便及时警告系统管理员,对错误进行处理。

-

ERRM Event Response Resource Manager 是IBM小型机RSCT功能中的一个子功能,用于响应RSCT接收到的各种事件,详见RSCT。

-

EWLM Enterprise Workload Manager这是IBM在虚拟化环境中针对小型机负载进行资源管理的软件系统。类似的管理软件还有很多,例如VE(Virtualization Engine)等。这些软件大都有其历史性和针对性,最终IBM会用统一的软件体系完成整合,完成的商业(收费)方案会成为Tivoli体系中,精简功能(免费)方案会成为HMC、Director等其它管理体系中的一部分。但是目前IBM在这方面尚没有清晰的界定,可能这一类软件有很多,并且功能互相交叠。

-

FC Fiber Channel光纤通道卡。继以太网卡之后另一种比较通用的数据传输卡,主要用于基于SCSI协议的数据传输(以太网卡则几乎都用于IP协议的数据传输)。

-

FFDC First Failure Decect and Correct,IBM的一种软、硬件设计技术,即在设备/软件中增加了额外的代码专门用于对错误、故障进行检测、隔离和恢复处理,并记录下来供支持人员分析原因。此功能可以解决很多软、硬件故障,而避免因此导致宕机。

-

F-Port 这是FC协议的一个术语,类似的Port术语还有很多,请参考下表 21。

简 称 详细名称 所属设备 功 能

N-port Network Port Nodes 连接一个FC节点(等同单一操作系统)与FC网络

F-port Fabric Port Switches FC交换机互联形成fabric(可以理解为一个管理域)

L-port Loop Port Nodes 连接一个FC节点与FC环路网络

NL-port Network+Loop Port Nodes 连接一个FC节点与FC环路或者交换模式网络

FL-port Fabric+Loop Port Switches FC交换机互联,端口可以是环路也可以是交换模式

E-port Extender Port Switches 用于级联FC交换机

G-port General Port Switches 通用端口,可以根据需要转换成各种其他各种Port

表 21 光纤协议各种“Port”比较 -

FSM Flex System Manager,专用于IBM PureFlex System管理的管理软件。由于PureFlex本质上是一种介于刀片服务器和普通机柜服务器之间的产品),是对刀片服务器的扩展。FSM则是一种定制的Cloud云管理软件,这个产品很不成功,现在已经几乎销声匿迹了。

-

FSP Firmware Service Processor又被称为SP(Service Processor),即用于管理Power小型机的内置CPU和管理软件(微码)。FSP直接与Power小型机内部硬件体系通信,对硬件系统进行管理和调度,实现分区、启动等动作。所有外部管理体系(设备)发布的指令都必须通过FSP才能够被真正执行,但它并不是虚拟化操作的真正实现者,只能算一个管理者。FSP是运行定制Linux的小单板计算机,通常每台IBM Power小型机有两个FSP,它们互相备份,并行同时工作即任何一个FSP都可以管理此小型机,但每个FSP在发布命令之前,要先去与另一个FSP通信,取得锁特权之后才能发布命令,以避免冲突。当然,这一切都是由FSP内运行的软件(即RSCT,它们与HMC内部运行的RSCT、分区内运行的RSCT互相通信、授权、执行命令)自动完成的。

-

HBA Host Bus Adapters 小型机上用于连接存储的控制卡,有时存储上用于连接小型机的控制卡也被称为HBA(但其含义是Host Bay Adapter),通常是FC卡或者SCSI卡。由于以太网卡和存储卡都有光纤接口,通常只有存储卡才被称为HBA。

-

HEA Host Ethernet Adapter 是IBM POWER 6以后发布的小型机上提供的一种以太网卡。它不需要VIO分区就可以支持虚拟以太网卡功能,相当于把VIO虚拟以太网卡功能固化到HEA卡的自身的芯片中,大大简化了实现小型机虚拟化的难度(如果只需要虚拟以太网卡功能,不用再配置VIO分区),提高了实施灵活性,同时也提升了系统性能(HEA网卡自身的处理芯片就可以完成网络封包转发功能,不再占用分区、VIO的CPU资源)。详细实现请参考<2.5.19 HEA(Host Ethernet Adapter)/IVE(Integrated Vritual Ethernet)>一节。

-

HMC Hardware Management Console 由于IBM小型机功能越来越强大,而且支持虚拟化功能,以往的液晶面板或超级终端管理方式已经不能满足要求。现在IBM的POWER小型机可以通过一台PC机(IBM特定型号和配置),装载了专用的管理软件进行管理,例如进行分区划分等操作。HMC目前最新版本为v8.8.3.0。IBM曾经想放弃HMC,转为SDMC(System Director Management Console,即装载了System Director的管理终端),整合对各种虚拟化设备的管理为同一产品(以往HMC管理Power小型机,Director可以管理x86上的VMware等虚拟化产品)。然而SDMC的开发很不成功,产品几乎无法使用,到目前HMC依然是唯一直接管理IBM Power小型机的产品。

-

Hypervisor 在IBM Power小型机上的一组特殊部件、功能的总称,用于管理各个分区的各种资源,提供分区之间通信机制和支持虚拟控制卡等设备。它是PowerVM虚拟化技术的基础,但Hypervisor总是隐藏在后台,并且也不仅仅是某个具体的硬件、软件产品,在使用者层面往往看不到它的身影,在本书中也只有在分析虚拟化技术某个功能的实现过程的时候,才会提到它。

-

IEEE Institute of Electrical and Electronics Engineers国际电子工业协会,该协会指定了很多标准,从硬件接口到软件协议,著名的IEEE 802.3以太网通信协议就是出自此协会。

-

IPL Initial Program Load 即系统引导过程,如果IBM技术人员提到IPL,通常意义是重新启动一下计算机或某个分区。

-

IVE Integrated Vritual Ethernet, IBM POWER 6以后的小型机利用特定集成的网卡,即HEA(HEA Host Ethernet Adapter),来实现网络虚拟化的一种技术,IVE能够脱离VIO Server而存在,连通小型机内虚拟网络和外界真实网络,但其支持的VLan数量等比VIO Server少。IVE也可以配置成普通网卡使用,相当于内置以太网卡。

IVM Integrated Virtualization Manager IBM开发的虚拟化管理软件,用于低端Power机柜或者刀片小型机的管理,与HMC功能类似,但不需要单独的硬件设备(HMC硬件),IVM需要安装到Power小型机自身的一个分区(必须是VIO分区,实际上IVM就包含在VIO软件中),但是管理能力有限制。 -

LA Link Aggregation 通信系统的一个名词,指多条链路聚合成一条虚拟线路进行数据传输。通常表示使用LACP协议的聚合链路。

-

LACP Link Aggregation Control Protocol IEEE指定的以太网链路聚合协议,被称为IEEE 802.3ad通常与IEEE802.1q/Trunk混合使用,另一种LA的协议标准是Cisco的EtherChannel。

-

LED Light Emitting Diode 在每台IBM小型机(物理机柜)上都有一个小液晶屏幕,用于显示一些非常关键或者底层的信息,本文中所有的LED都表示此屏幕的信息。如果是分区环境,虽然某个分区没有单独的LED,在(HMC)分区管理界面上,依然有一个标识位标识此分区虚拟的液晶屏应当显示的信息。

-

LHEA,Logical HEA,由HEA虚拟出来的逻辑HEA(可以简单地理解为虚拟网卡),供给每个分区使用。

-

LIC Licensed Internal Code,所有不安装在AIX操作系统之内的程序代码都被IBM成为LIC(有一些LIC通过AIX安装,但在AIX操作系统及磁盘内没有任何记录,他们被“下载”到控制卡、小型机管理芯片/设备内)。这些代码又被称为Microcode微码。本质上,这些代码都是一种管理控制程序,但他们并非由小型机主CPU执行,而是由小型机管理控制芯片,甚至控制卡上的管理芯片“执行”。代码保存的位置也是这些设备内置的Flash存储设备,而非AIX操作系统引导磁盘。由于这些代码也具有版权,所以被IBM成为“授权”的内部代码。LIC是个通称,这些代码从最简单低级的门电路控制码到最高级的完整操作系统加应用程序都有。例如HMC的LIC就是完整的Linux、Webspare平台和应用程序、防火墙等等一整套代码组合,DS8000存储系统的LIC甚至就是以AIX操作系统为基础,装载了一组数据IO管理软件、Websphere Java应用软件、双机管理软件等一整套代码。

-

LMB Logical Memory Block,代表Power小型机物理内存管理的颗粒度(每个分区可分配的内存必须是LMB的整数倍)。LMB缺省大小与小型机物理内存多少有关,内存越少,初始LMB越小。LMB可以更改,最小16MB,最大256MB。在Power 5以后小型机的AMSI web管理界面里可以更改。但更改生效需要重启小型机(整机,包括所有分区)。每个分区在启动之前,FSP首先要根据此分区profile的设置,进行资源组合,并准备配置参数表(内部使用)。其中物理内存管理一项与LMB大小有关。每个分区物理内存的动态扩展最大值与分区启动时拥有的物理内存数量相关。FSP根据初始内存数量准备hardware page table (HPT,物理内存分配表),此表大小只在分区重新物理初始化时,即重新active profile时才会改变。如果分区初始内存分配大小小于256MB,则此分区以后动态扩展的物理极限就是16倍初始大小(当然还受profile中memory max参数的限制,两者取最小值)。如果分区初始内存大于256MB,则此限制是64倍的初始物理内存(profile中memory max参数不能大于64倍min memory的限制就是来源于此,但目前新版本的PowerVM似乎可以根据profile中内存差自动调整相关参数,64倍的限制是否依然有效有待确认)。同时,分区动态增减内存的颗粒度是16MB。内存调整下限与此类似。LMB则影响内存分配的颗粒度。如果修改后的LMB大于某个分区profile的memory min,则必须调整此分区profile,使其等于LMB的整数倍。使用HMC的命令可以强制改变一些数据,但建议还是遵照IBM的最佳实践(Best Practices),在其它极限参数环境下,软件、硬件触发bug的可能性更大。

-

LPAR LPar/Logical Partition 逻辑分区,这是IBM Power小型机支持的一种虚拟化技术,可以将物理小型机设备按照一定规则切分成几台虚拟的小型机,每个虚拟小型机就被称为一个逻辑分区LPar。由于IBM的分区技术没有其他的物理分区设定,因此在本书中所说的分区既逻辑分区,逻辑分区既分区,不再特别区分。

-

LPM Live Partition Mobility 在线分区迁移,一种IBM Power小型机支持的虚拟化技术,它需要POWER 6以后的 CPU支持,并且要求Power VM License的Enterprise版本(Power VM License是一种微码级别的使用授权)。LPM有active和inactive两种模式,通常我们提到的LPM都是active LPM,即可以把运行中的分区直接从一台物理小型机迁移到另一台小型机,而不需要停分区,分区上运行的软件可以继续提供对外服务,包括网络和磁盘访问都没有中断,从而完成分区的动态移动,类似VMWare的VMotion功能。Inactive的LPM一般用于分区配置迁移(例如硬件升级到新机型),分区处于运行状态,很少使用。由于IBM Power小型机都采用冗余设计,当某台小型机发生硬件故障或者要求检修,小型机上的分区依然正常运转,但是修复故障需要停机,此时就可以利用LPM功能,将分区移动到其他小型机,而清空需要停机的小型机。当然,LPM有一定的设计要求,不是任何分区都能进行LPM。例如被移动分区必须使用VIO,不能有物理IO卡,目标小型机也需要有足够的可用CPU、内存资源等等。目前几乎所有在AIX上运行的软件都自动支持LPM,但依然有某些和系统底层联系紧密或者对机器本身硬件进行标记/监视的软件不支持LPM,这是由于LPM存在物理机器更换的动作,这些软件会发现物理设备忽然变更,而自身又未引入相应的机制去识别此变更来自LPM,往往会导致软件的异常动作,甚至宕机。例如现在用LPM技术移动Oracle的RAC分区就会出现宕机现象,在Oracle以后的版本应当会有修正以支持LPM。更多有关LPM的介绍请参考<2.5.14动态分区迁移LPM>。

-

LPP Source 这是NIM的一种资源,用于NIM管理安装软件的image。如果把NIM比喻成虚拟光驱软件(当然他们是有很大的区别的),则LPP Source就是ISO映像文件。

-

LUN Logical Unit Number 通常指磁盘阵列中提供给小型机使用的磁盘,对于磁盘阵列来说,这是经过RAID技术的逻辑磁盘,而对于小型机,它等同于物理磁盘,小型机无法分辨出不同。

-

LV Logical Volume 逻辑卷,是AIX逻辑卷管理技术中的一个概念,它是卷组中的一部分空间,可以被应用程序直接使用或者在上面创建文件系统。

-

LVCB Logical Volume Control Block 逻辑卷中起始部分的一些数据,被AIX操作系统保留,用于填写逻辑卷自身的一些定义信息。如果直接把逻辑卷分配给软件(例如数据库)使用,应用软件往往不会跳过LVCB空间,而导致LVCB被覆盖掉。这种情况下,AIX能检测出LVCB被覆盖,相关操作会有提示,但通常不会导致系统异常,因为LVCB并非AIX运行中必须要读取的数据。

-

LVM Logical Volume Manager 逻辑卷管理,是AIX操作系统对存储、数据进行管理的技术,包括卷组管理、逻辑卷、JFS/JFS2文件系统管理等一系列功能。

-

MCS Multiple Core Scaling 多核心扩展,这是一个很怪异的名词,其实质含义是允许一块以太网卡支持多个传输队列。低端的以太网卡只具有传输功能,为数据打包(增加以太网帧头格式)、解包功能都是由CPU完成的;高端的以太网卡内部有处理芯片,可以自动完成这些“简单”的操作,并对错误帧进行处理。由于CPU处理速度很快,高端网卡为了提高效率,通常会有一个内部缓存,CPU将要发送的数据传送到缓存,网卡异步地从缓存中取出数据,进行打包、发送;反之,收到的包也先由网卡保存在缓存,进行CRC校验,解包等操作。MCS参数允许HEA支持多个缓存队列。虽然可以用一个缓存队列处理多个虚拟的以太网卡,但这样每个虚拟以太网卡的即时响应特性将变得很差,因为在一个队列中使用的是先进先出策略,后到的包必须等前面的包都处理完才可以被处理。如果是为了单一小型机/分区提供服务,这并不是问题,而当一块网卡为多个小型机/分区提供服务时,就要采取一些措施来实现更好的传输质量分配,以防止某个分区持续传输(例如FTP)数据时阻塞网络,导致其它分区网络延时过长。IBM在IVE技术中引入了MCS参数,也就是允许多个缓存(MCS),每个缓存用于处理特定的一个或者几个逻辑端口(网卡)的数据包,经由不同缓存的数据包之间响应性不受影响。

-

Microcode微码,与LIC或Firmware含义相同。

-

Micro-Partition微分区,IBM服务器虚拟化分区技术中支持以非整数的数值进行物理CPU划分的一种技术。

-

ML Maintenance Level 类似Windows操作系统的Service Pack,它是AIX操作系统的补丁包,但这个名词已经过时,现在AIX的补丁策略使用了TL, SP/CSP等新的名词,但本质上没什么变化。

-

MPIO Multipath I/O 在AIX操作系统中内置提供了对磁盘多路径进行管理的机制,被称作MPIO。缺省的管理方式是一主一(多)备,安装磁盘系统自带的MPIO Plug-In插件之后可以实现更多的功能,例如负载均衡。

MRS Memory Region Size,在进行分区内存分配时的最小分配单位,包括初始分配的最小颗粒度和动态逻辑分区调整。 -

MTU Maximum Transmission Unit 最大传输单元,是以太网络数据传输的一个术语,代表当前以太网上允许的最大帧长度。以太网缺省的MTU是1500字节/帧,如果打开了Jambo Frame支持,则最大可以支持9000字节/帧。MTU越大传输大量数据的效率越高(帧头数据所占的百分比越少),但不适合远程传输或对网络抖动敏感的应用(例如涉及实时Video/Audio播放)。总之,MTU没有最好数值,只有针对不同情况更适合的设置。

-

NIB Network Interface Backup 网卡备份技术,AIX操作系统提供的一种技术,允许多块网卡聚合在一起提供冗余功能,但与Ethernet Channel技术不同,它没有并行能力,即同时只有一块网卡工作,只有当此网卡不通的时候,备份网卡才会接替。尽管NIB在性能方面不如Ethernet Channel,但是它对交换机没有任何要求,既不需要交换机支持Ethernet Channel协议,也不要求所有NIB聚合的网卡必须连接到同一台网络交换机。

-

NIM Network Installation Management这是IBM的一种网络软件管理、安装功能,它支持IBM Power小型机(或分区)通过网卡从另一台安装、配置了NIM Server软件的小型机(可以是AIX或Linux操作系统)引导系统,并通过这台小型机获取安装数据,安装操作系统或者其他应用软件,但这些软件必须支持IBM标准的installp模式安装。

-

NIMOL NIM on Linux 即使用Linux操作系统小型机作为NIM Server

-

NIM Shell,NIM服务器与被管理的AIX操作系统进行通信时可以使用RSH,也可以使用NIM自己提供的一种支持加密(通过标准SSL)命令传输方式,这种方式就是NIM Shell。在NIM服务器的配置中可以选择使用哪一种Shell进行通信。

-

Normal Mode 是分区引导的一种模式,分区将按照预先定义的bootlist(引导设备寻找顺序)依次试图引导操作系统。另一种引导模式是Service Mode。本质上这两种模式没有什么不同,可以简单地理解为两种不同启动顺序,类似PC机BIOS预先定义的启动顺序:正常情况从硬盘启动,如果按5则从光盘启动。

-

N-Port 光纤通信协议的标准,表示连接节点和交换机的端口。

-

NPIV N-Port ID virtualization即虚拟N-Port。我们知道类似以太网卡的MAC,每块FC卡都有自己唯一的WWPN号,NPIV功能则允许一块FC卡虚拟(在SAN网络上注册)多个WWPN号。从SAN网络看来,此块卡相当于多块FC卡。在IBM小型机虚拟化技术中,NPIV功能用于VIO实现FC卡虚拟,即用一块物理FC卡虚拟成多块FC卡,分配给各个分区使用。NPIV功能使得存储端与小型机分区端实现透明对接,VIO不再负责驱动FC设备。

-

NVRAM Non-Volatile Random Access Memory 掉电不丢失数据的内存,每台IBM小型机都配置了一些NVRAM用于存储IBM小型机的微码、设备引导顺序信息等。如果小型机进行了分区,则每个分区可以从属于自己的NVRAM(虚拟的)中读到自己分区相关的启动设备等信息。

-

ODM Object Data Manager 类似Windows系统的注册表,用于保存AIX操作系统的各种关键配置信息。

-

PEA Physical Ethernet Adapter 直译是物理以太网卡,但在虚拟化技术中特指VIO Server上用于架构共享以太网的物理网卡,也就是本文所定义的“物理SEA”。物理SEA不是IBM的标准定义,IBM虚拟化只有一个SEA即本文所说的逻辑SEA,但作者认为将SEA扩展为物理SEA(IBM定义的PEA)、虚拟SEA(IBM定义的VEA,即虚拟以太网卡,参考VEA词条)和逻辑SEA(IBM定义的SEA)更容易区分和理解虚拟以太网的要素。因为单单使用PEA、VEA的定义,没有展示出这两种网卡的特殊,容易与用于其他目的的物理以太网卡、虚拟以太网卡混淆。实际上,VIO Server用于架构虚拟以太网的PEA和VEA与用于其他目的的PEA、VEA相比,还是需要一些特别的设置的。

-

PIC Pool Idle Count,IBM CPU中支持虚拟化技术的寄存器,用于记录系统(物理整机)CPU Pool中闲置的物理CPU周期。

-

PHyp Power Hypervisor的简称,即PowerVM技术的主要实现者,也经常被称为Hypervisor或PHYP。

-

PLM Partition Load Manager, AIX提供的分区负载管理功能。

-

POST Power-On Self-test 上电自检,IBM小型机刚加电都会自动进行硬件检测,该功能可能由Service Processor完成,也可能由本机CPU完成,或者两者联合协作完成。

-

POWER Performance Optimization with Enhanced Risc (Architecture),IBM Power系列小型机名称的由来,含义是用增强的RISC CPU技术进行性能优化的小型机架构(采用POWER CPU)。

-

Power KVM,IBM将x86 Linux的KVM (Kernel-based Virtual Machine)移植到Linux on Power平台,可以在KVM虚拟机下安装运行Linux的。不过要注意,KVM并不提供指令集虚拟化,也就是说能在KVM虚拟机中运行的Linux依然是为Power指令集编译的Linux,而不是普通的支持x86指令集的Linux。Power KVM作为纯软件实现,与Power VM和Hypervisor功能类似,在性能和可靠性、安全性上略有不足,但在灵活性、适用性上更强。http://www.linux-kvm.org/page/Main_Page

-

PowerVC,Power Virtualization CenterIBM的Power虚拟化管理软件,功能介于SC与HMC之间,下面是IBM对三者的定位:

名称 定位 功能

Smart Cloud 云管理 提供完整的云计算管理功能,实现按功能模块划分的服务、虚拟化、应用管理功能;服务租用、用户管理;包括Smart Cloud Entry、Smart Cloud Provisioning和Smart Cloud Orchestrator三个级别的产品

Power VC Power系统虚拟化管理 提供智能的PowerVM和IBM v系列存储部署、资源动态分配和运行优化管理功能

HMC Power系统设备管理 PowerVM具体配置、Power产品硬件/微码管理、维护管理 -

PowerVM,IBM Power小型机虚拟化技术的最新名称(原为APV,Advanced Power Virtualization),当前分为三个级别的授权,分别是Express Edition,Standard Edition和Enterprise Edition。每一种授权级别都包含有一系列虚拟化功能(高级别涵盖低级别的全部功能,并且增加了允许分区的数量)具体内容请参考本书的后续介绍。

-

PPC Physical Processor Consumption 在虚拟化环境中,某个分区真正消耗的物理CPU与分配CPU的百分比(可能大于100%,此时说明这个分区是uncapped,它抢占了系统中富余的CPU资源)。

-

PPFC Physical Processor Fraction Consumed在虚拟化环境中,某个分区真正消耗的物理CPU的数量,最小单位是1/100个物理CPU。

-

Profile 分区资源配置信息表。这是IBM小型机虚拟化技术中的一个重要的定义,用于定义分配给某个分区的物理资源(配置信息)。它存在于物理小型机的Service Processor中,每个被激活(启动)的分区必须对应于一个Profile,而每个分区可以有多个Profile,系统管理员可以根据需要,使用某个Profile激活分区。Profile中的资源包括物理/虚拟CPU数量、CPU共享模式、内存数量、物理/虚拟IO资源(卡)等所有分区所需要的资源、配置信息。

-

PTF Program Temporary Fix 通常指ML或TL补丁包中的一个单独的补丁。

-

PTX Performance Toolbox AIX提供的性能监控、优化工具集。参考:

http://www-03.ibm.com/systems/power/software/aix/ptx/perftoolbox.html -

PURR Processor Utilization Resource Register 为了进行CPU动态分配,POWER CPU(5以后)引入了一个特别的寄存器用于跟踪不同分区的物理CPU使用情况。

-

PV Physical Volume 操作系统看到的物理磁盘,可能是虚拟磁盘(即一个LUN),也可能是物理磁盘。

-

PVID Physical Volume Identifier,AIX操作系统对每块磁盘(PV)都标记一串唯一的16进制数字,作为磁盘的识别号(hdisk#之类的名字是为了方便管理员,而操作系统真正使用的是16进制数字的PVID)。

-

PVID Port Virtual LAN Identifier 不要混淆,这是另一个PVID!代表以太网VLAN的标记(Tag),是从1-4095之间的整数。

-

QoS Quality of Service 服务质量保证,是一种网络传输协议。

-

RAS Reliability, Availability, and Serviceability IBM经常用RAS表示小型机最重要的三种非功能性特性,分别是可靠性、可用性和可服务性。

-

RMC Resource Monitoring and Control,AIX操作系统提供的一种管理机制,对分区资源进行监视和控制,与HMC配合(通信),实现各种分区资源状态显示、动态移动、配置等功能。

-

RS/6000, pSeries, System P, Power System P 都是IBM Unix小型机在不同时代的称呼。最古旧的称呼是RS/6000,后来改名为pSeries。此时与开始与iSeries共用大部分硬件生产线和部件,到了后期则彻底统一了硬件平台,iSeries和pSeries成为同一种硬件平台安装了不同微码和操作系统之后的称呼。甚至上iSeries可以通过划分分区,安装AIX操作系统,iSeries与pSeries之间的物理界限不复存在(但反之不行,即pSeries不能安装iSeries的OS/400操作系统)。随着POWER 6发布,IBM又再次为Unix小型机系列改名,叫做System P(对应的iSeries被称为System I)。最近几年,IBM为了借助POWER CPU的强大声望,更进一步称呼为:Power System P或Power System。当然,这些新称呼的改变都是对新发布的机型,除了部分过渡期生产的旧机型同时存在两个名字之外(例如RS/6000 S80也叫做pSeries p680,大部分机型名称并没有改变,而且这些名字不过用于市场营销,没有什么实质的含义。

-

RPL Remote Program Loader 既远程引导(boot),通过网络将引导影像数据读入,并完成引导过程。同常指NIM的网络引导功能。

-

RPM Red Hat Package Manager 一种Linux软件打包的方式。由于AIX提供了对Linux的支持,除了传统的BFF格式的安装包,AIX也支持RPM格式的安装包(仅仅是支持打包格式,目标代码需要支持PPC架构,而且还有程序必须支持AIX,不是任何rpm包都可以安装到AIX上的)。

-

RSCT Reliable Scalable Cluster Technology AIX操作系统提供的群集信息交互软件,可以通过统一的通信标准实现群集内机器之间以及与HMC等管理设备的通信。很多群集管理软件/设备包括Power HA(HACMP)和HMC都是直接调用RSCT进行群集节点之间、分区之间通信。

-

RSH Remote Shell 远程执行Shell,一种Unix标准的远程命令执行协议。NIM服务器通过RSH发送命令给被管理的AIX分区。

-

SDD Subsystem Device Driver IBM存储设备的路径管理驱动程序,可以实现多路径冗余切换、负载均衡(一些低端存储设备可能不支持负载均衡功能)。SDD有两种驱动形式,一种是操作系统磁盘之上的驱动,表现出来是生成一种新的vpath磁盘设备;另一种与操作系统自身的MPIO管理集成在一起,被称为SDD MPIO PCM,透过MPIO命令的扩展进行磁盘路径管理。从AIX 6.1起,MPIO成为主流,VPATH模式将逐渐消失。

-

SDMC System Director Management Console这是HMC的继承产品,可以把它理解为HMC+IBM Director软件的混合体。IBM为什么不继续HMC而转为SDMC的根本原因不得而知,可能是想通过SDMC实现跨越平台或者统一平台的虚拟化管理吧?HMC不能管理Power刀片系列产品,IVM也不是一个很好的方案,而SDMC则可以实现对Power全系列产品进行管理。当然,SDMC的另外一个好处是作为单独的虚拟程序运行,而不再(至少IBM承诺)绑定硬件。SDMC还尽量做到与HMC命令、操作兼容。SDMC做得很不成功,甚至还没有开始,就快要销声匿迹了,因此本书只介绍HMC。SDMC对一些HMC的概念还是做了变更,可以参考下表:

HMC名称 SDMC名称

Managed System Server

Frame / BPA Power Unit

LPAR / Logical Partition Virtual Server

HMC Roles:

hmcsuperadmin

hmcoperator

hmcuser Director Roles:

SMAdministrator

SMManager

SMUser

Partition mobility Relocation

Remove connection Remove a managed endpoint (MEP)

Server/Frame/LPAR states Director states, for example Started

表 22 HMC与SDMC基本概念对照表 -

SEA Shared Ethernet Adapter VIO分区的一种逻辑设备,与一块VIO分区的物理以太网卡对应,功能是使此网卡成为小型机内部虚拟以太网与物理以太网之间的网桥,进行封包转发。但在IBM的介绍中,SEA概念很含糊,一般IBM所说的SEA特指逻辑SEA。本文中把它扩展为3种,分别是:

IBM定义的PEA本文的PSEA(物理SEA);

IBM定义的VEA本文的VSEA(虚拟SEA);

IBM定义的SEALSEA(逻辑SEA)。

详细请参考<2.5.18 SEA Shared Ethernet Adapter共享以太网卡>一节的介绍。 -

Server/小型机,指pSeries的一台物理整机,可能由一个或多个机柜(IO抽屉)构成,在HMC中显示为一个被管理的系统(Managed System)。

-

Shared 一种分区模式,属于微分区功能的范畴(只有微分区才能支持Shared模式)。由于目前不仅仅CPU,内存也可以通过AMS技术进行share,但使用的不多,本书中如无特别说明,shared模式的分区仅仅指进行CPU share的分区。传统意义的分区只能按照物理资源的最小分配单位进行分区资源划分,例如一个物理CPU,一个IO插槽。IBM从使用Power 5 CPU的小型机开始支持更小颗粒度的CPU资源划分,即可以以0.1个物理CPU为最小单位进行CPU资源分配(Power 7支持0.05个物理CPU),在此同时,分区对于物理CPU的占用还可以有Shared(共享)和Dedicated(独占)两种模式,如果是Shared,分配给这个分区的物理CPU会和其他同处于一个Pool(共享池)中的其他分区互通有无,也就是分给这个分区的物理CPU仅仅是个“参考值”,系统会根据这个参考值和其他一些参数动态调整分配给此分区的实际物理CPU资源,也就是物理CPU资源可以在属于同一共享池的分区之间共享。关于物理CPU如何“分享”使用,在<3.5 CPU共享功能>一节有详细的介绍。

-

Share Pool共享池。共享池用于控制共享资源的抢夺范围,只有使用同一共享池的分区才能互相“共享”资源。

-

SMIT System Management Interface Tool,AIX提供的菜单式系统管理操作界面。

-

SMS System Management Services,IBM Power小型机提供的底层设备管理界面(程序),类似PC机的BIOS,可以对分区引导、引导设备进行选择、管理。

-

SMS Mode 与Normal/Service Mode对应的一种分区引导模式,是Profile中的一个设置参数。如果设置了SMS 模式,分区经过设备自检之后将进入SMS操作界面,等待人工干预,而不是根据Normal或者Service引导顺序直接引导操作系统。此状态与分区正常引导时,当LED(分区状态提示码)显示E1F1时按数字1进入SMS操作界面的功能相同(按5则进入Service Mode),不需要等待E1F1时按键,所以方便了进行分区维护的时候,但并没有其他特别功能。

-

SMT Simulate Multi-Thread仿真多线程。这是Power 5/6/7 CPU支持的一种CPU多线程执行技术,可以让一个物理CPU内核同时虚拟执行两个线程。此技术的理论基础是一个物理CPU有很多处理寄存器或者功能单元(例如浮点处理器),但每条线程指令流在执行的时候,只可能使用其中几个寄存器或功能单元,必然有闲置的处理寄存器/功能单元,这时就可以引入更多线程同时运行,让一个物理CPU同时完成两条指令流的操作。此技术与CPU物理设计中的超流水线或者超标量技术即相近,又稍有不同。可以理解为CPU超流水线、超标量等技术是在指令级实现,同时处理的一条指令流(线程)前后几条指令,但由于一条指令流前后指令相关性比较大,很多时候不能提前执行,必须按顺序一条一条执行,所以“加速”性能不好;而SMT技术是在线程级,即指令流之上实现,通常操作系统中两个线程之间是没有直接相关性的,线程之间通信(只有这时才存在相互影响的可能)通过专用的系统调用或者更高层的文件、网络操作实现,并行性比较好,所以SMT技术的“加速”能力稍高。Power 6 CPU每个CPU(内核、Core)SMT支持2个线程,Power 7CPU支持2线程或4线程(可调)。当然,尽管SMT效率更高,也不可能完全做到速度翻几倍,一般每个增加线程大约可以达到30-50%左右的单线程性能,即通过SMT技术,一个2线程SMT物理CPU当成1.5个物理CPU,一个4线程SMT物理CPU可以达到2-3个物理CPU的单线程处理速度。由于SMT是在线程级实现,所以线程运行类型差别越大(同时使用同一类型处理单元的可能性更小)、关联度越小,效果越好,特别是同时执行很多线程的事物性处理业务SMT的提升率较高。但对于很单一的纯计算性业务,并行线程数很少或处理特性几乎完全相同,SMT并不能实现加速,反而会有反作用。此时可以通过AIX操作系统命令smtctl -m off,关闭SMT(smtctl -m on则可以打开SMT,在AIX操作系统缺省SMT是打开的)。

-

Slot 槽位。Slot有物理和虚拟两个概念。物理Slot对应着IBM小型机IO Drawer上的某个具体插槽,根据槽位号可以查找到物理卡的位置,从而识别物理卡设备。虚拟设备也具有Slot槽位号,但是并没有具体的位置,只是用来区分不同的虚拟卡,根据虚拟设备槽位号可以将两个同型号的虚拟卡分开。实际上,在同一个分区,无论什么虚拟IO卡都只占用一个虚拟槽位。物理Slot位置对应的Slot号可以参考小型机IO Drawer上的标记;在分区Profile中定义虚拟设备时填写的Slot号生成虚拟设备,虚拟Slot最小从C01开始,只要在每个分区不重复,则可以任意设置,理论上可以达到C4095,但在profile中有一项参数限制虚拟slot的最大数值,省缺为20,可以更改,如果分区已经启动,必须重新激活此profile才生效。有一些架构师喜欢用特定的数值来配置虚拟设备,这样做的好处是根据槽位号很容易识别出设备的用途、连接对象等参数。当然也有一些小缺点,例如槽位号通常会变得很大,而Power小型机需要预留一些内存用于虚拟设备之间通信,允许的槽位数越大,预留内存越多(显示内存为Microcode保留)。当然,对于高端服务器初始一般配置了很多内存,浪费掉几个GB内存不是什么大问题,而如果是中低端服务器,可能就需要精打细算了。任何设备(从AIX系统中查看)的Slot号都可以通过命令lscfg -vl dev_name。例如下面的例子中vscsi0的(虚拟)槽位号是11(C11)。

#lscfg -vl vscsi0

vscsi0 U9119.FHA.02xxxxx-V2-C11-T1 Virtual SCSI Client Adapter

Hardware Location Code …U9119.FHA.02xxxxx-V2-C11-T1 -

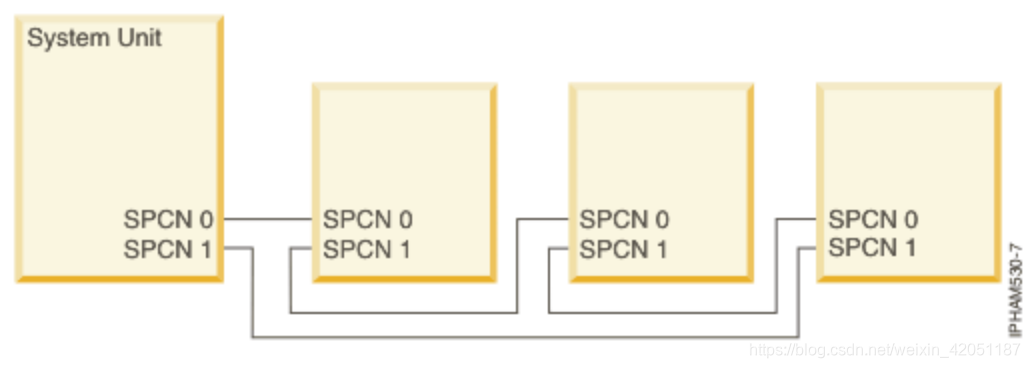

SPCN Service Processor Control Network 我们知道IBM小型机中用Service Processor控制所有的硬件,那控制命令是如何传送给各个组件的呢?就要通过SPCN网络进行。这个网络其实是用RS/232链接成的环形结构,参考<图 23小型机SPCN网络连接示意图>。例如一台IBM小型机有4个Drawer,Service Processor所在Drawer是主模块,通过几根专用的SPCN电缆将其它Drawer链接在一起。当机器家电启动的时候,Service Processor通过SPCN发送加电命令,其它几个Drawer则依次启动电源,完成初始化操作。

– SP Service Processor,IBM Power小型机内置的一个特别处理卡(一般是两块独立的单板机,互为备份),不同机型其功能稍有差别,提供对小型机内各种硬件资源管理,也就是动态分区等功能的执行者。SP又被称为FSP,在本书中FSP与SP通用,不再区分。SP卡是运行IBM定制Linux的控制卡,此Linux及控制程序(微码)又被称为eLiza(电子蜥蜴)。 -

SPOT Shared Product Object Tree 这是NIM管理的一个术语,是通过NIM生成的操作系统程序和数据的目录,与他们在真正的操作系统上安装、执行的目录结构完全相同,这样当NIM将他们映射给某个客户端,该客户端可以在经由bootp远程引导后自动通过NFS远程挂载此目录,可以执行目录中的程序,继续完成其他动作。

-

SRC System Resource Controller,AIX提供的资源管理系统,但其管理的不是硬件设备资源,而是软件逻辑资源,例如某种网络通信协议处理程序——inetd, NFS mountd等。

-

SR-IOV Single Root I/O virtualization,这是IBM PowerVM的新功能,可以在不需要(或很少)Hypervisor参与的情况下让多个分区共享PCIe卡。一方面,越过Hypervisor直接操作PCI卡,系统的性能会有提升(尽管PowerVM比其它纯软件实现性能能要好);另一方面,也不需要VIO支持,减少了维护复杂性。具体SR-IOV实现,我们将在<>详细介绍。

-

SRN Service Request Number,AIX系统在运行中,如果发生错误,提示错误信息的同时还会提示一个提示码,这就是SRN,可以帮助用户通过IBM网站搜索到相关的处理信息。

SSH Secure Shell 加密传输的Shell协议。与标准RSH/rshell功能相同,但对网络上传输的数据通过SSL进行加密,对连接双方使用RSA进行认证,这样避免了密码、数据明文传送等安全隐患,IBM的许多软件都使用SSL协议作为远程管理通信协议或直接通过SSH发送命令,例如NIM,TSA(Tivoli System Automation)。 -

SSL Secure Socket Layer SSH底层的加密协议层,可以理解为SSH就是SSL+Shell的组合。

-

TCE 通常代表Hypervisor Translation Control Entry tables这是控制物理内存分配的映射表,各分区所属内存需要通过一个映射表对应到真实的物理内存,每一项映射关系就是一个TCE。

-

UDF Universal Disk Format 一种国际标准的光盘介质格式。

-

UDID Universal Disk Identification一种国际标准的用于虚拟/物理磁盘管理的标识。由于虚拟化技术的引入,物理磁盘经过虚拟映射之后,很难对应出来相互依存关系,而这个标识就是在磁盘映射过程中保持唯一、不变的标识。

-

VEA Virtual Ethernet Adapter虚拟以太网卡,但在IBM小型机虚拟化中往往特指用于VIO Server中架构虚拟以太网的虚拟网卡,对应于本文的Virtual SEA。

-

VIPA Virtual IP Address 另一种AIX操作系统提供的网络冗余和负载均衡方案。与Ethernet Channel类似但各有不同。VIPA能够在AIX系统中生成虚拟设备设备(虚拟网卡),然后利用路由技术实现通信。表 23简要比较了这几种网络技术,更详细的信息请参考相关技术的说明:NIB Network Interface Backup, EC Ethernet Channel/或LACP)

VIPA NIB EC/LACP

网络设备 虚拟网络设备 虚拟网络设备 虚拟网络设备

网络设备名称 entx (x为整数) entx entx

交换机要求 无 无 支持EtherChannel或802.3ad

网络协议要求 运行动态路由协议 无 无

冗余网络接口数 本身无限制 一个 0-3个

负载均衡(出) 是,基于数据包 否,主备方式 是,多种方式

负载均衡(入) 是,基于数据包 否,主备 是,基于数据包

技术实现层次 网络(路由)层 链路层 链路层

主机CPU消耗 运行动态路由协议 几乎无 几乎无

切换速度 动态路由协议定义 几秒-几十秒可选 几秒-几十秒可选

故障探测方式 路由协议握手信息 Ping / 链路状态 Ping / 链路状态

表 23 几种网络虚拟设备技术比较 -

VLAN Virtual Local Area Network,网络技术中对于一个虚拟的广播域的称呼。传送到一个VLAN的没有特定目的MAC地址的数据帧(包)将被交换机在这个VLAN内部广播,所有属于此VLAN的网络端口都可以接收到一份拷贝。

-

VMControl,即IBM System Director的新称谓,同时支持PowerVM和对x86虚拟机的管理。

-

VP Virtual Processor,虚拟处理器(CPU),在IBM小型机虚拟化技术中,在每个分区中提供给操作系统(AIX, Linux或者OS/400)的虚拟的CPU数量,此参数必须为整数,并且要大于等于分配给该分区园整后的物理CPU数量。即如果分配的物理CPU是3.3个,则VP必须是大于等于4。同时,VP也是该分区在uncapped情况下能抢得的最大物理CPU数量。

-

VPD Vital Product Data,在任何IBM物理设备中,都有一些重要的配置、产品信息,例如微码版本、各种硬件地址ID等,这些信息通常被保存在设备的flash ROM中,不可更改,而且具有唯一性,被称为VPD。

-

VPN Virtual Private Network,虚拟私有网。在IBM虚拟化技术中,一些重要管理设备可以设置成直接和IBM维护、技术支持站点通信,即时将系统报错发送给IBM技术支持网站,或者从这些网站下载补丁。由于这些数据传输需要通过Internet,为了保证数据的安全和隐私,此类数据都是通过加密传输的,也就是通过在公共Internet上搭建一个私有的网络,而此网络上任何传输的数据都是经过加密的。

-

VRRP Virtual Router Redundancy Protocol 路由冗余协议。为了保证网络上网关的可用性,一些路由支持VRRP(这是Cisco最先提出的技术标准),可以将多台路由器配置成群集,提供一个虚拟的服务地址作为网关。当一台路由器故障,其他路由器会接管虚拟网关地址,继续对外提供服务。从小型机主机这边看来,网管路由器似乎一直在工作,从来没有中断过,因此网络传输的可靠性大大提高。

WLM Workload Manager,这是AIX的一个扩展功能,可以对AIX上运行的各个程序进程进行资源使用限定,例如限制其对CPU、内存的使用量等。缺省情况下,AIX对其上运行的程序(线程)采取一视同仁的管理方案,没有哪个线程可以获得特别多的资源,同时也不会有哪个线程获得比其它线程/进程少的资源,而通过WLM则可以实现不同的资源分配策略。资源包括CPU处理时间片、物理内存和磁盘IO。WLM是虚拟化系统负载管理在操作系统层的接口,其上与eWLM配合,实现跨分区、小型机进行资源调度;其下则接驳小型机硬件,实现对运行软件的资源限定或调配。AIX的WLM功能可以通过smit wlm快捷命令进入管理界面。 -

WPar 这是一种纯操作系统软件实现的虚拟化技术。在AIX 6.1以后的AIX版本可以支持多个操作系统映像,但必须是相同版本;AIX v7更开始支持不同版本(AIX v5.2)的映像。我们知道,一台物理机器是一堆物理资源的集合,而IBM的分区技术在此功能上等同于一台物理机器。两个不同的应用程序不能安装于同一台物理机器的主要原因是对物理资源的独占性,分区技术则很好地解决了这个问题。如果应用程序不需要独立的物理资源,是否就可以安装到同一个AIX映像中呢?有的时候也是不可以的,因为应用程序可能需要自己独立的、特殊的运行环境参数,而在同一操作系统映像内很难或无法设置多个不同的运行环境参数,例如全局的网络端口、相同的用户名等等。这时就需要操作系统映像独立,而并不需要物理资源独立,AIX的WPar功能正是针对这种需求而开发,WPar技术让应用程序“感觉”自己运行在一个完全独立的操作系统之内,而实质上几个WPar之间或者WPar与“父”操作系统映像之间共用物理资源,根据需要甚至可以共用系统程序代码(磁盘上只有一份物理copy)。此技术的好处很多,其中之一是在共用父操作系统代码的设置情况下,对父操作系统打补丁之后,父操作系统内衍生的若干子操作系统自动也被打了补丁,对于同时管理众多开发系统非常实用。当然WPar的另一种模式也支持多份操作系统映像。利用WPar可以实现Live Application Mobility,即动态迁移一个操作系统/应用程序映像到其它位置。更多介绍请参考<创建及迁移工作负载分区WPar>一节。