任何一个轮子都有被造出来的原因,Delta Lake项目出现的原因是什么、为了解决什么问题、怎么使用、使用场景,有什么缺点、是否有别的更好的组件替代。更深的就是深入源码弄懂整个流程是什么。

Delta Lake是一个数据湖产品,什么是数据湖?? 数据仓库是将数据进行ETL,存入HDF或者别的数据库。 数据湖是将所有类型的数据不进行处理,直接存入,做分析时,才将数据进行ETL。但是数据不进行处理全存到数据湖中会出现问题。

1.数据湖中的数据质量低,会出现垃圾数据。2.随着数据量的增加,性能增加 3.更新数据湖中的记录很难。

所以Delta Lake是为了解决这些而被创造出来的。

现在先从官网的Quickstart开始,官网给了很多种安装的方法,这里我在项目中加入maven pom依赖

<dependency>

<groupId> io.delta </ groupId>

<artifactId> delta-core_2.12 </ artifactId>

<version> 0.1.0 </ version>

</ dependency>

先从官网的例子开始:

val data=spark.range(5,10)

//create a table

data.write.format("delta").save("/tmp/delta-table")

//update the table data

data.write.format("delta").option("mergeSchema","true").mode("overwrite").save("/tmp/cy/delta-table/table1") //Read data

val df = spark.read.format("delta").load("/tmp/cy/delta-table/table1")

//用Time Travel

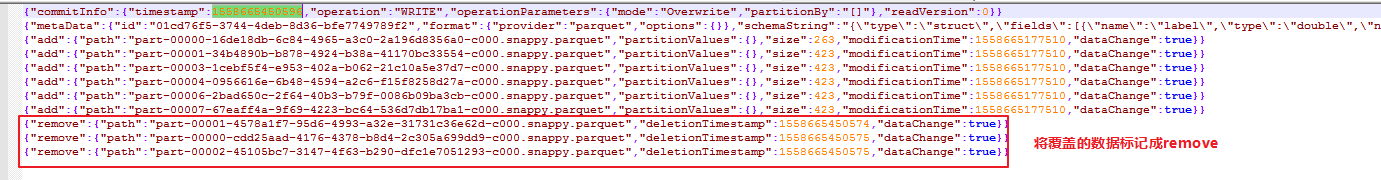

val df= spark.read.format("delta").option("versionAsof",0).load("/tmp/cy/delta-table/table1")对于overwrite我看了一下,hdfs上并没有将之前的数据覆盖而是创建了新的

翻看——delta_log

累了,不写了,待续。。

版权声明:本文为qq_24186017原创文章,遵循 CC 4.0 BY-SA 版权协议,转载请附上原文出处链接和本声明。