Hadoop是一个由Apache基金会所开发的分布式系统基础架构。

- 用户可以在不了解分布式底层细节的情况下,开发分布式程序。充分利用集群的威力进行高速运算和存储。

-

Hadoop实现了一个分布式文件系统(Hadoop Distributed File

System),简称HDFS。HDFS有高容错性的特点,并且设计用来部署在低廉的(low-cost)硬件上;而且它提供高吞吐量(high

throughput)来访问应用程序的数据,适合那些有着超大数据集(large data

set)的应用程序。HDFS放宽了(relax)POSIX的要求,可以以流的形式访问(streaming access)文件系统中的数据。 - Hadoop的框架最核心的设计就是:HDFS和MapReduce。HDFS为海量的数据提供了存储,而MapReduce则为海量的数据提供了计算。

还有一个组件非常好用就是yarn,我们可以将hdfs,mapreduce部署在yarn上运行。yarn可以管理集群的资源(cpu,核数,内存等)。

hadoop有三种部署模式:本地模式,伪分布式,分布式。

-

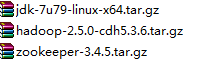

我们现在简单的部署下伪分布式,先利用vm建议一台虚拟机,然后安装jdk,配置环境,创建用户,修改主机名,修改ip映射(/etc/hosts),将hadoop安装包上传至虚拟机上。

-

将安装包解压到安装目录 /opt/modules

-

修改配置文件

hdfs:

hdfs-site.xml<property> <name>dfs.namenode.secondary.http-address</name> <value>zhiqiang3.com:50090</value> </property>

core-site.xml

<property>

<name>fs.defaultFS</name>

<value>hdfs://zhiqiang.com:8020</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/opt/app/hadoop-2.5.0-cdh5.3.6/data/tmp</value>

</property>

<property>

<name>fs.trash.interval</name>

<value>420</value>

</property>

export JAVA_HOME=/opt/modules/jdk1.7.0_79

yarn:

yarn-env.sh

export JAVA_HOME=/opt/modules/jdk1.7.0_79

yarn-site.xml

<property>

<name>yarn.resourcemanager.hostname</name>

<value>zhiqiang2.com</value>

</property>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.nodemanager.resource.memory-mb</name>

<value>4096</value>

</property>

<property>

<name>yarn.nodemanager.resource.cpu-vcores</name>

<value>4</value>

</property>

<property>

<name>yarn.log-aggregation-enable</name>

<value>true</value>

</property>

<property>

<name>yarn.log-aggregation.retain-seconds</name>

<value>640800</value>

</property>

mapreduce:

mapred-env.sh

export JAVA_HOME=/opt/modules/jdk1.7.0_79

mapred-site.xml

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<property>

<name>mapreduce.jobhistory.address</name>

<value>zhiqiang.com:10020</value>

</property>

<property>

<name>mapreduce.jobhistory.webapp.address</name>

<value>zhiqiang.com:19888</value>

</property>

-

启动hdfs:

1、sbin/start-dfs.sh start -

启动yarn

2、 sbin/start-yarn.sh start

版权声明:本文为CSDNWeiZhiQiang原创文章,遵循 CC 4.0 BY-SA 版权协议,转载请附上原文出处链接和本声明。