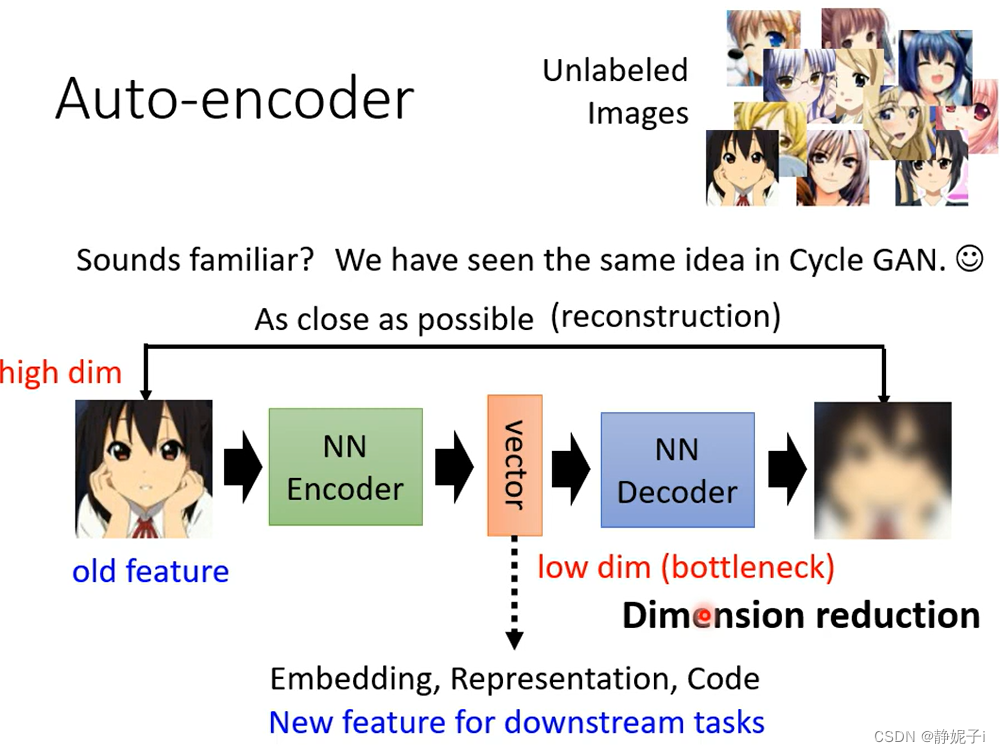

Auto-Encoder

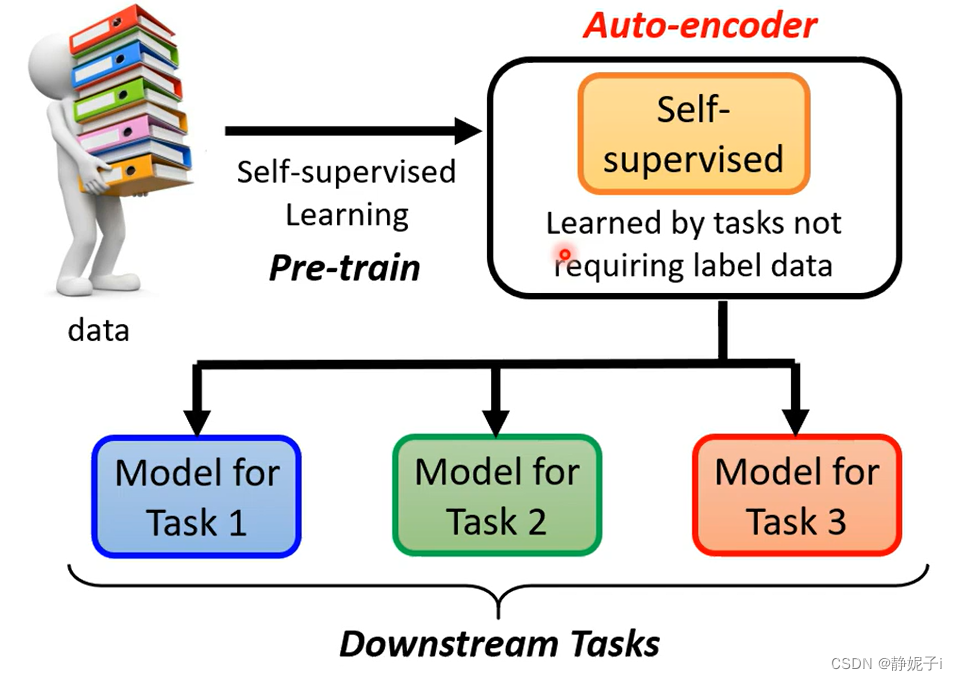

self-supervised learning Framework

已知大量无标注数据,使用不需要标注数据的任务去预训练模型,进行微调再将其应用在下游任务中

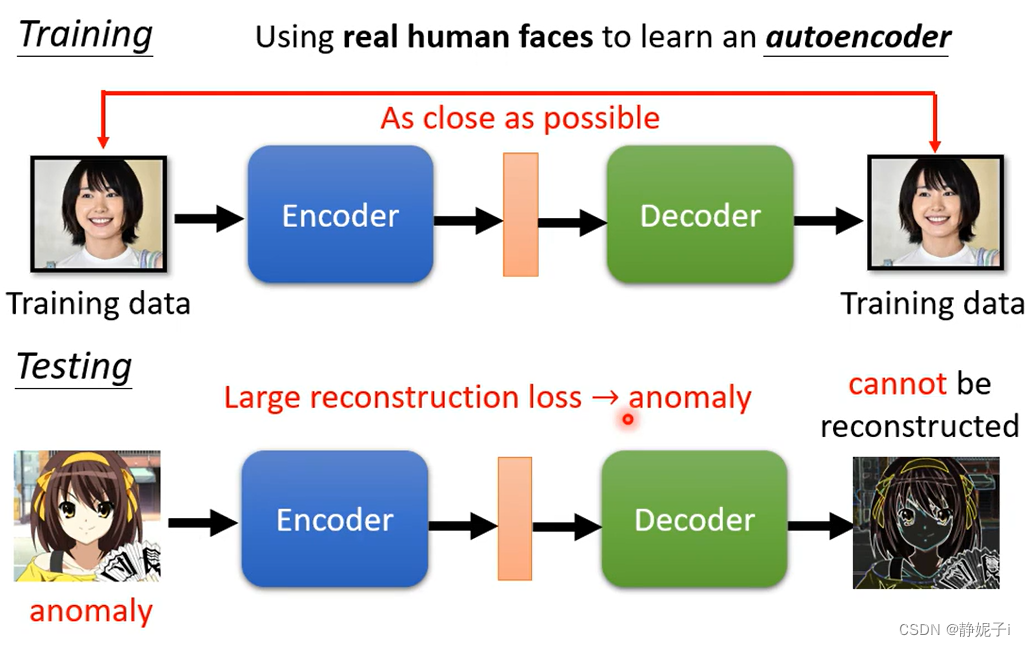

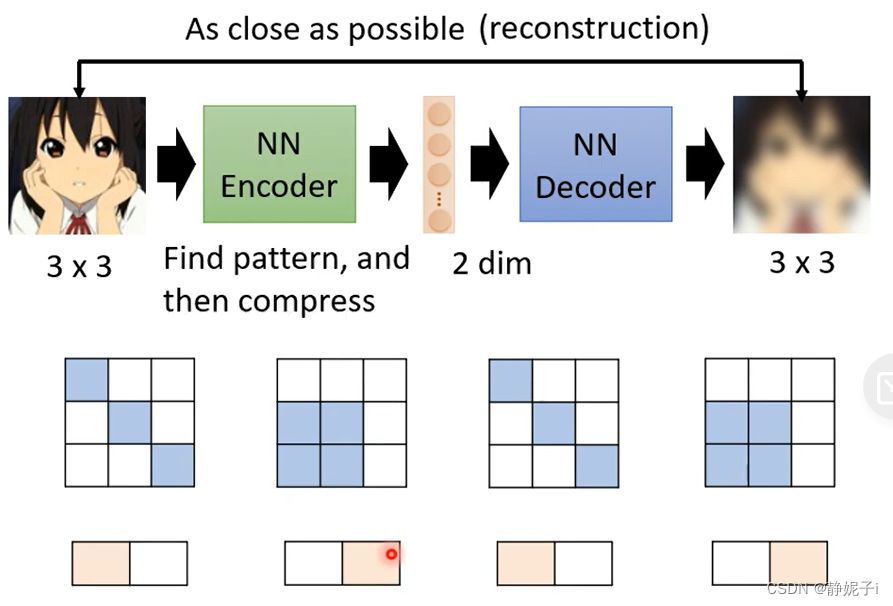

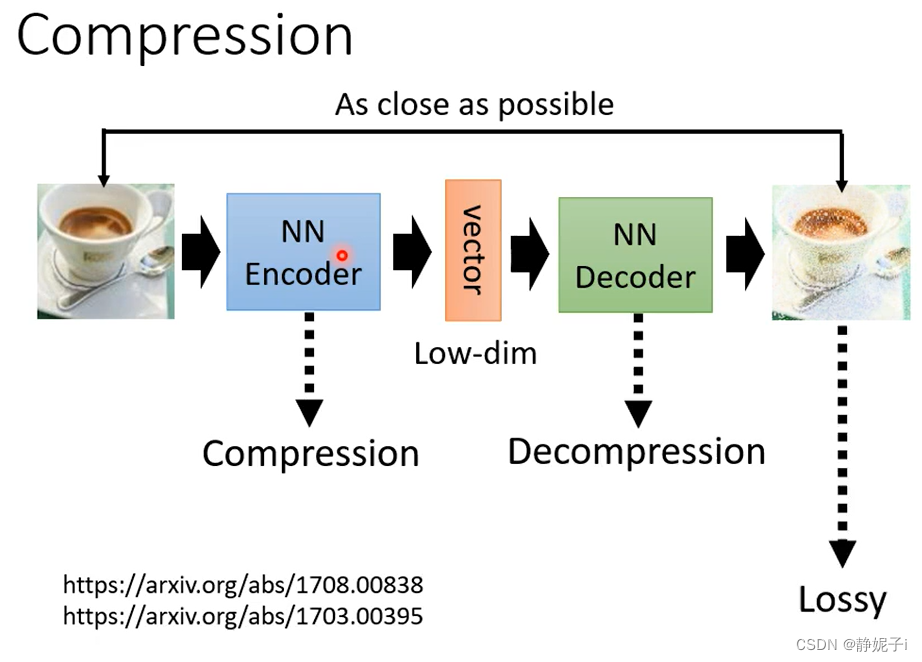

basic idea of auto-encoder

encoder读入一张图片并将其变成一个vector,作为decoder的输入产生一张图片

训练目标:encoder输入和decoder输出越接近越好

more dimension reduction:PCA;t-SNE

why auto-encoder

由于图片的变化是有限的,因此可以用更低维度的变化情况去表示有限的变化

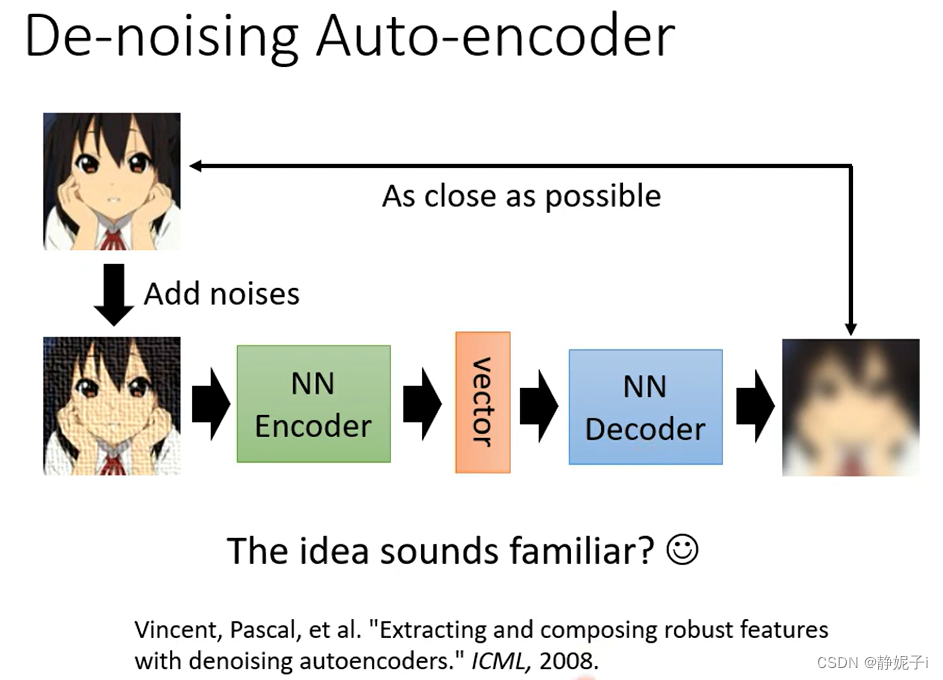

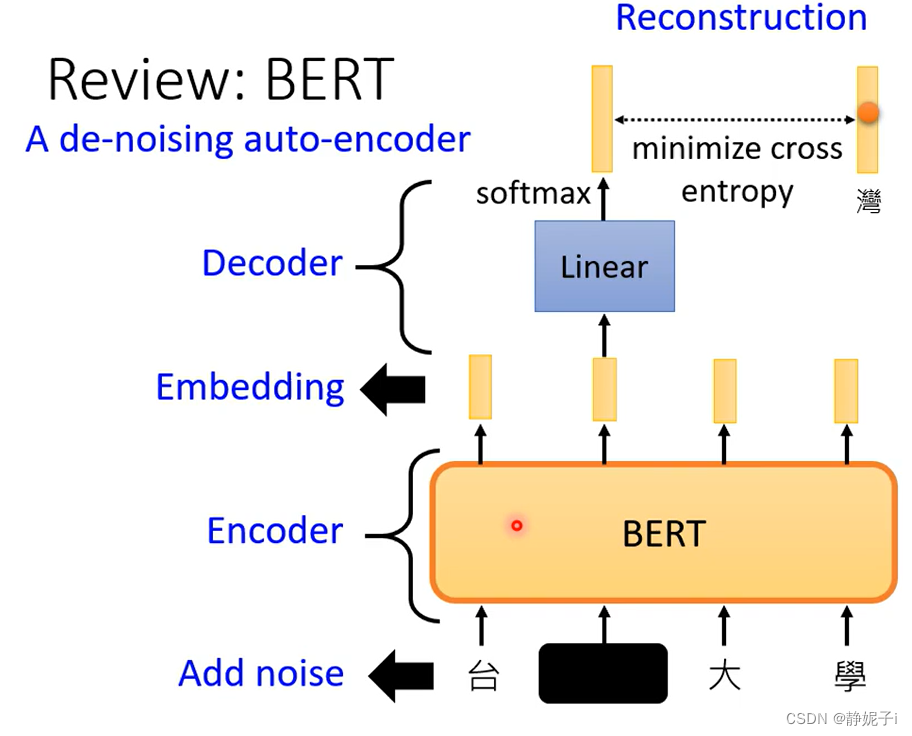

De-noising Auto-encoder

类比于BERT——de-noising auto-encoder

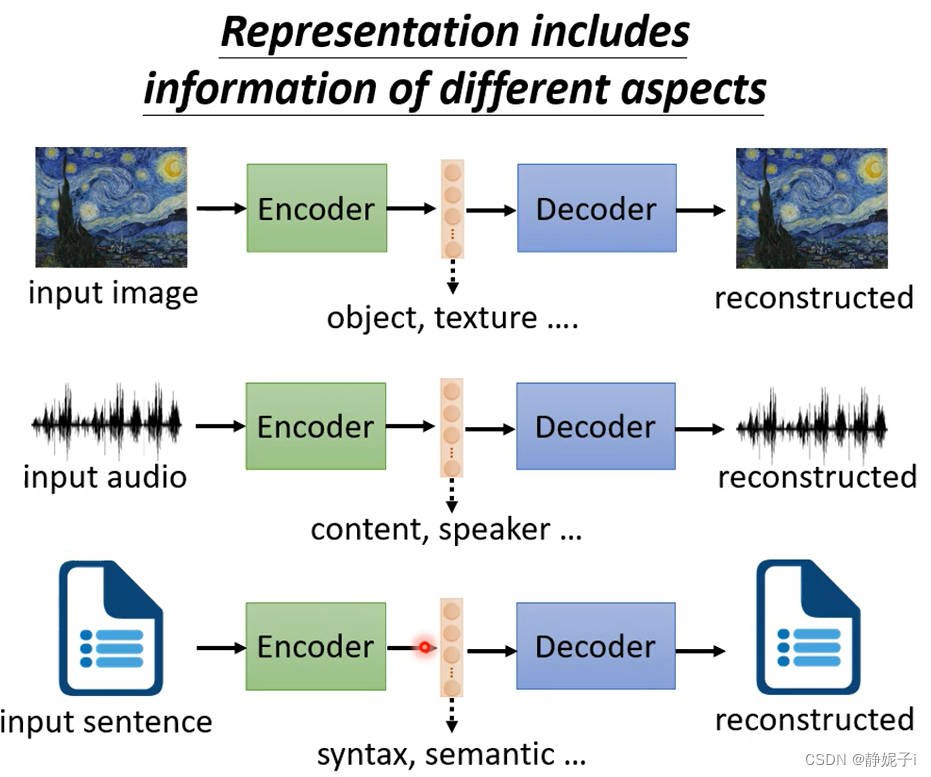

feature disentanglement

解耦:disentanglement 一句话概括就是:解耦的特征中,每一个维度都表示具体的、不相干的意义

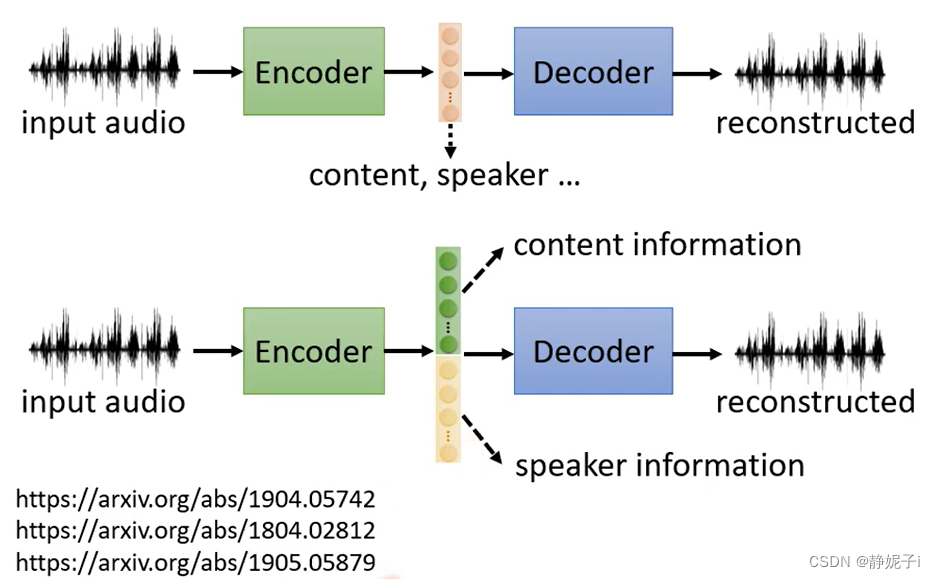

feature disentangle就是想要知道中间生成的vector中哪些维度表示某些信息

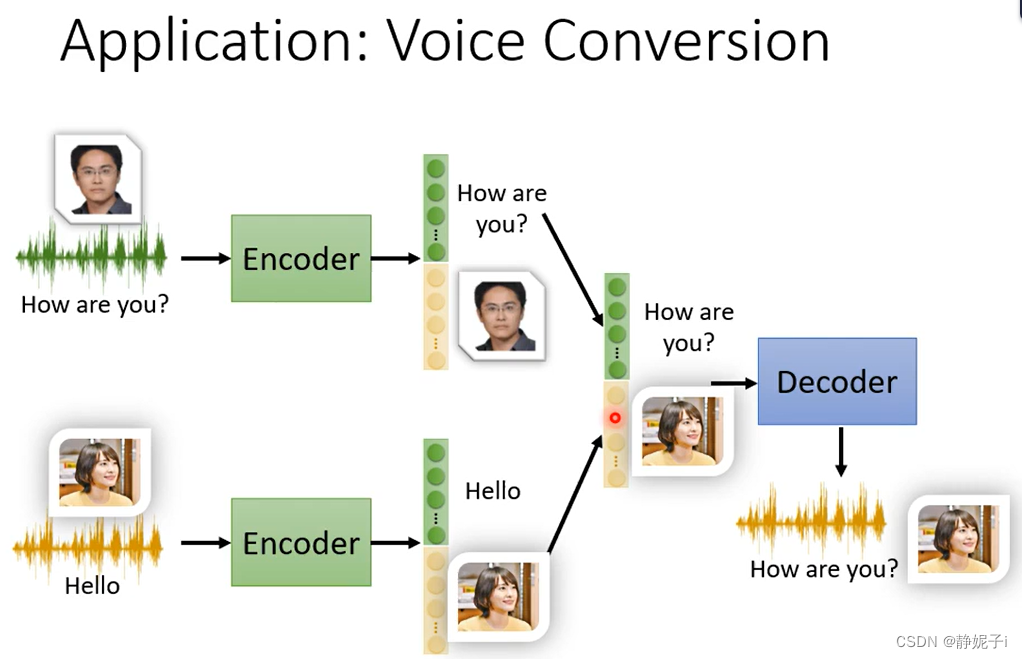

应用——voice conversion(领结变声器)

经过encoder之后的vector将内容与语音模式维度分开再拼接

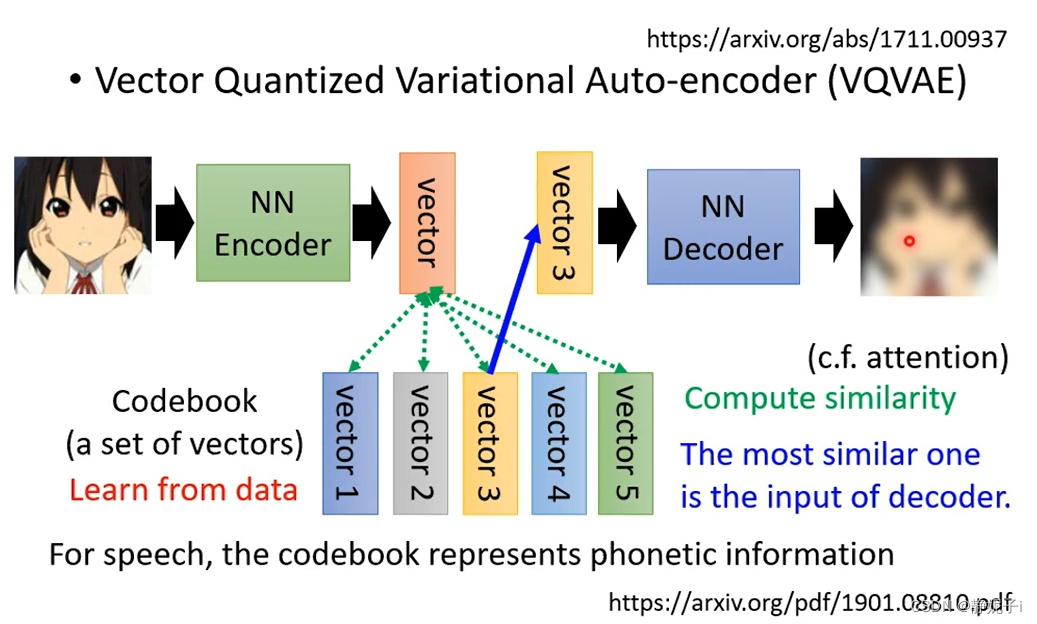

discrete latent Representation

经过encoder得到的vector与codebook中的vector计算相似度,并使用最相似的vector经过decoder生成

如在语言识别中应用:codebook中可以学习到最基本的发音音标,每个vector对应一个音标

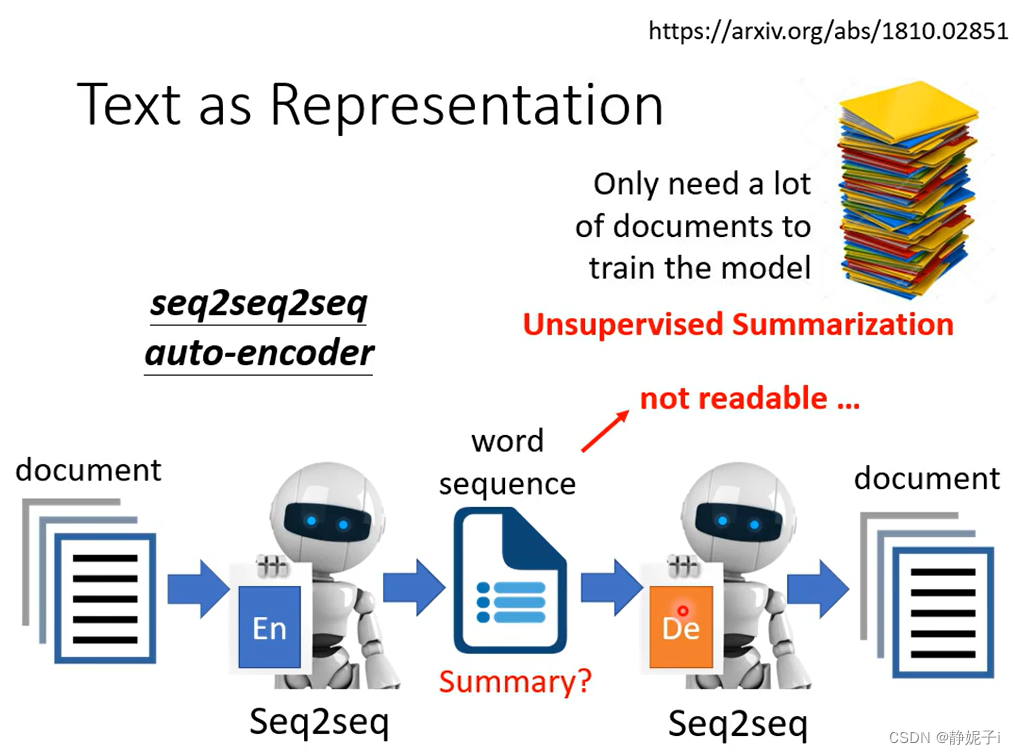

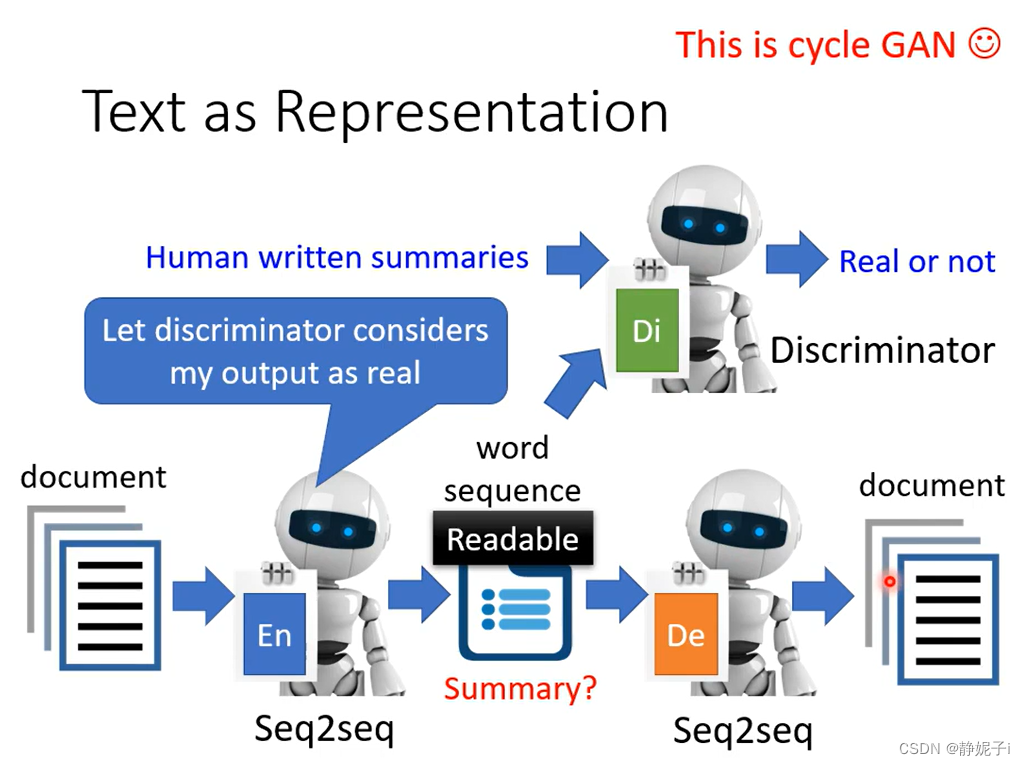

摘要生成

auto-encoder+GAN ——>cycle GAN

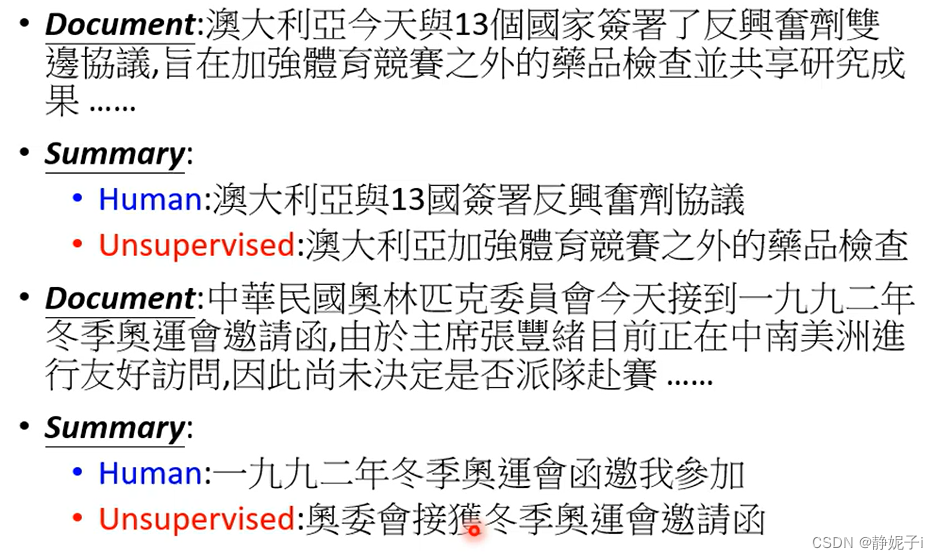

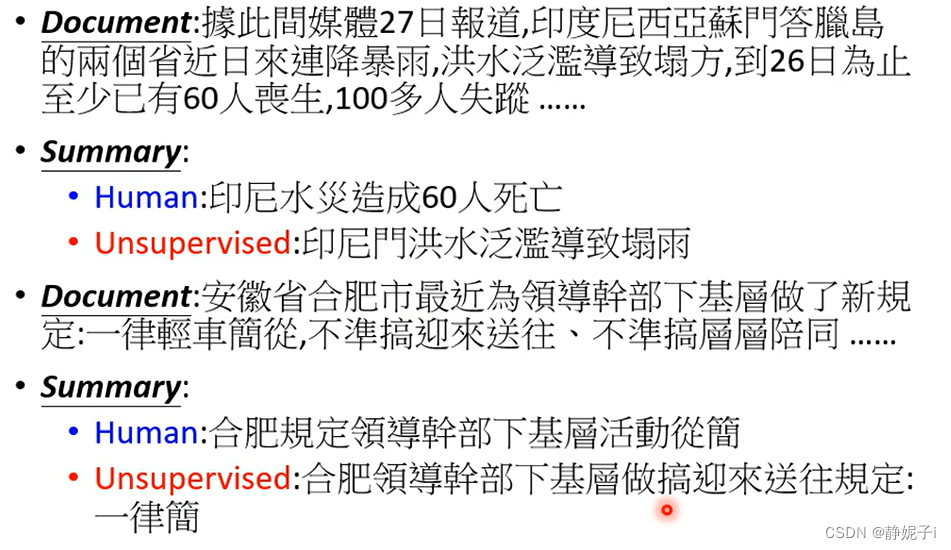

效果如下:

more application

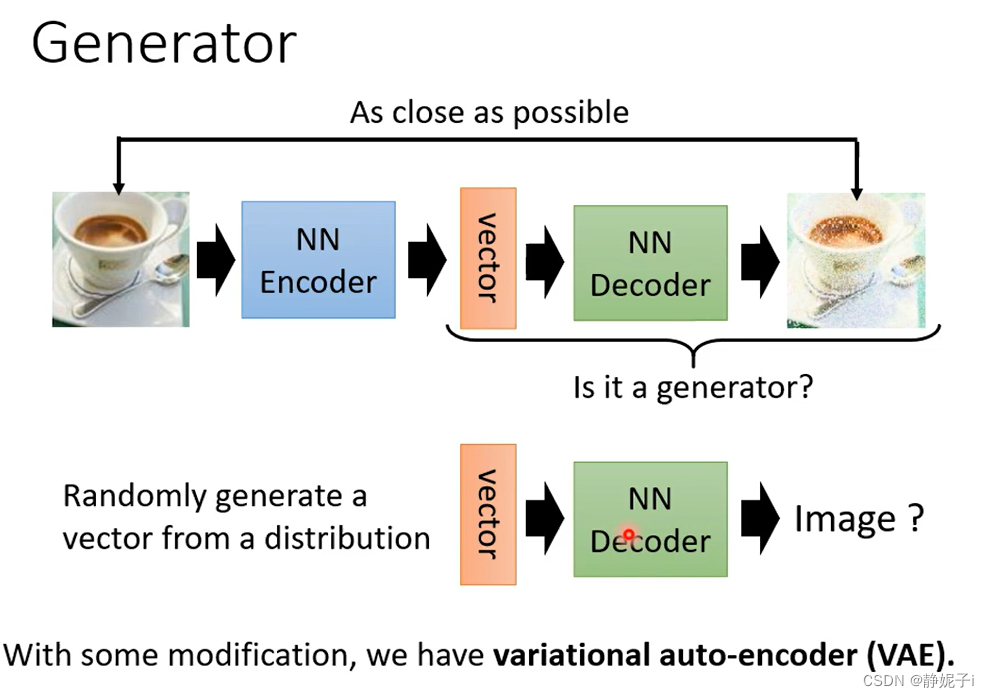

generator

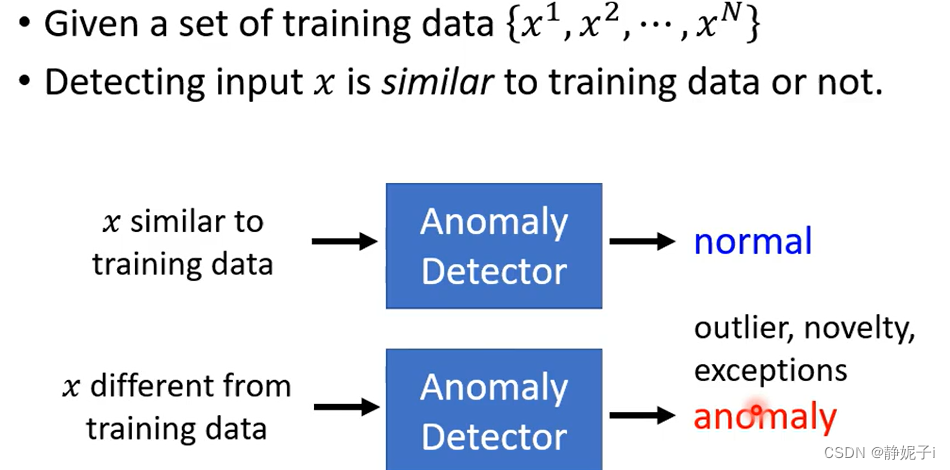

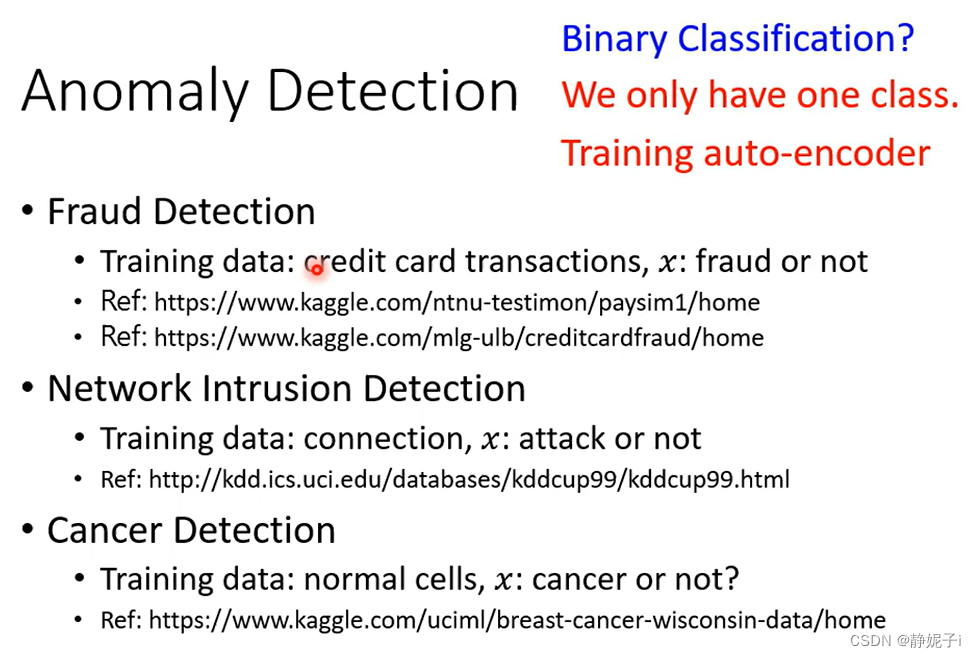

异常检测:输入X判断与训练数据相比是否正常