目录

1、Embedding

输入:我爱你巴拉巴拉巴拉巴拉巴

划分为12个字,每个字是512维度的向量。

2、位置编码

2.1 为什么需要位置编码?

考虑RNN(循环神经网络):

对于下图的U、W、V共享一套参数 且具有时间顺序。

BUT!!!!!!!!

Transformer如图:是可以并行的,会忽略前后顺序。因此,此时需要位置编码解决这个问题。

2.2 位置编码公式

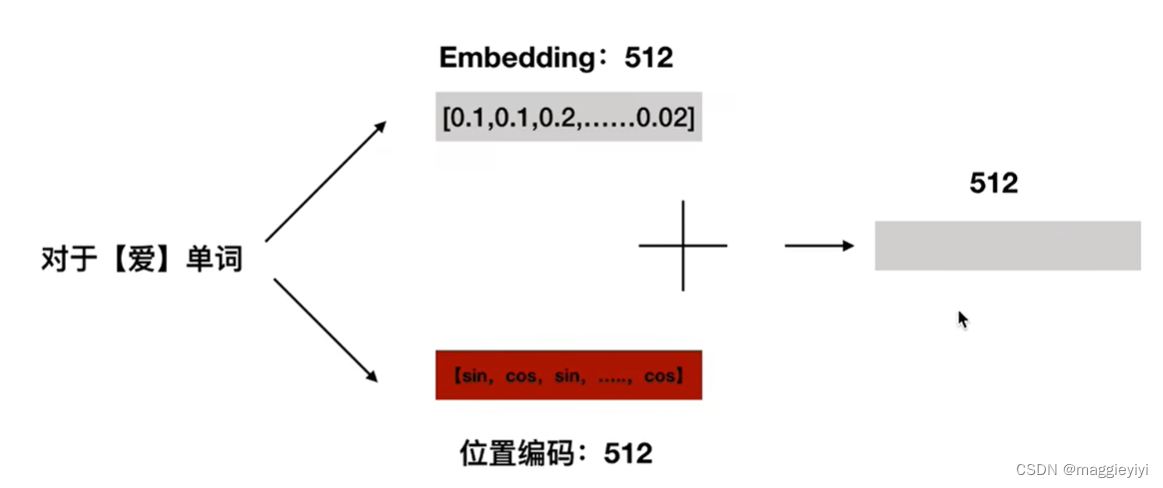

位置编码的方式如下图所示:

如对偶数位置的向量作sin计算,对奇数位置的向量作cos计算,得到位置编码。

之后:将embedding和位置编码相加,得到最终512维度的输入极为编码器的编码过程。

3 思考

ques: 为什么位置嵌入会有用?

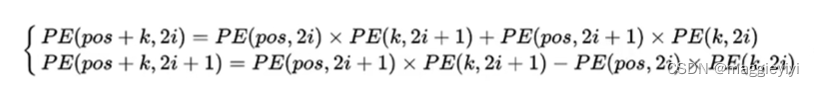

ans: 根据上述PE公式,我们可以得到一个特定维度的位置向量,并且三角函数具有如下性质:

因此可以得出:

故,pos+k位置的位置向量某一维度2i或2i+1而言,可以表示pos位置与k位置的位向量的2

i和2i+1维的线性组合。

所以,位置向量中蕴含了相对位置信息。

版权声明:本文为maggieyiyi原创文章,遵循 CC 4.0 BY-SA 版权协议,转载请附上原文出处链接和本声明。