定义

强化学习(Reinforcement Learning,RL)是智能体(Agent)为了最大化长期回报(Return)的期望,通过观察系统环境,不断试错(Trial-and-Error)进行学习的过程。

从强化学习的定义可以看出,强化学习具有两个最主要的特征:

- 通过不断试错来学习;

- 追求长期回报的最大化。

强化学习的框架一般包含5个构成要素,包括:

- 环境(Environment);

- 智能体(Agent);

- 观察(Observation);

- 行动(Action);

- 奖励(Reward)。

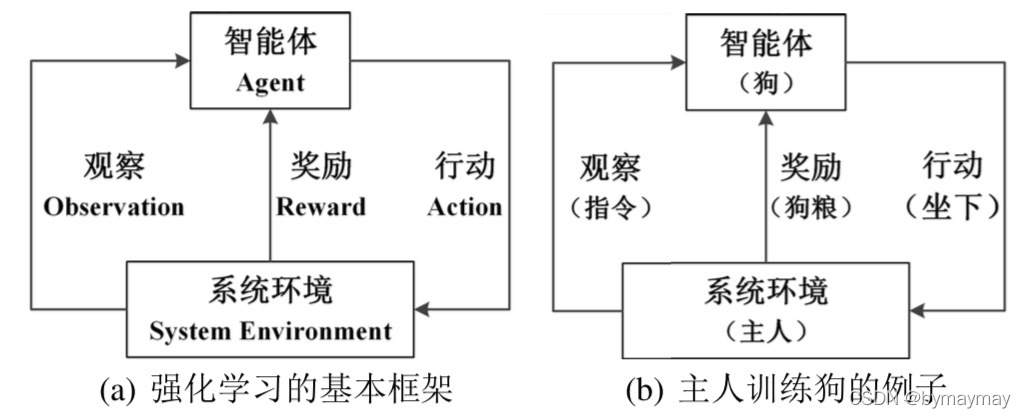

强化学习的基本框架如下图 (a) 所示,智能体对系统环境进行观察后产生行动,从系统环境中获得相应的奖励,智能体观察系统对自己上一次行动的奖励信号后,重新调整自己的下一次的行动策略。下图 (b) 展示了主人训练狗的过程就是强化学习过程的一个简单例子。主人想训练狗听从自己的指令,如果狗听从指令,产生了正确的行动,则主人会喂狗粮;如果狗未听从指令,产生了错误的行动,则狗得不到狗粮。在这个强化学习的例子中,主人充当着系统环境的角色,狗是智能体。狗(智能体)通过对主人(系统环境)的指令观察,产生相应的行动,狗粮就是主人对狗行动的奖励。

完全观测与不完全观测

上述框架是站在上帝视角描述问题,而强化学习的概念默认是站在智能体的角度看问题。

在

t t

t

时刻,系统环境的实际状态记为

S t e S^e_t

S

t

e

,智能体观测到的系统状态记为

S t a S^a_t

S

t

a

。智能体对系统状态的观测可以分为两种情况:

- 完全观测(Full Observability);

- 不完全观测(Partial Observability)。

完全观测

O t O_t

O

t

指的是智能体观测到的状态

S t a S^a_t

S

t

a

就是系统真实的全局状态

S t e S^e_t

S

t

e

,即完全观测

O t = S t a = S t e O_t=S^a_t=S^e_t

O

t

=

S

t

a

=

S

t

e

。

不完全观测

O ~ t \tilde{O}_t

O

~

t

指的是智能体只能观测到系统的局部状态,即不完全观测

O ~ = S t a ≠ S t e \tilde{O}=S^a_t\neq S^e_t

O

~

=

S

t

a

=

S

t

e

。

在接下来的内容中,除非特别说明,智能体对系统环境的观察都属于完全观测。

在完全观测的情况下,将智能体观察到的状态

S t a S^a_t

S

t

a

和系统真实的全局状态

S t e S^e_t

S

t

e

统一简称为状态(State)。

在

t t

t

时刻,智能体观测到系统环境的状态

S t S_t

S

t

,并产生相应的行动

A t A_t

A

t

,系统会在一下个时刻

t + 1 t+1