WARN TaskSchedulerImpl: Initial job has not accepted any resources; check your cluster UI to ensure that workers are registered and have sufficient resources,意思是:初始作业未接受任何资源;请检查群集UI以确保工作进程已注册并且有足够的资源。

出错可能有两种原因。

第一种

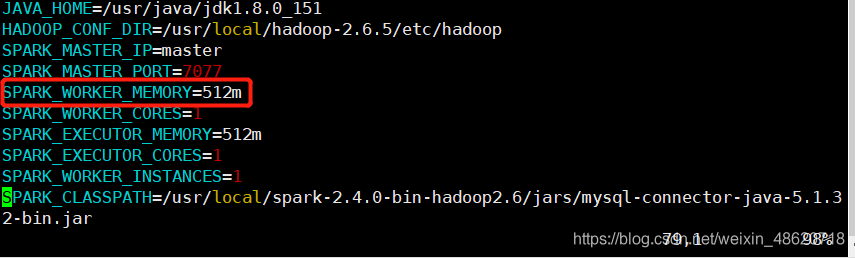

:是spark节点的内存满了,内存可以在spark的配置文件—>spark-env.sh中可以看到。

这个配置文件路径在:/usr/local/spark-2.4.0-bin-hadoop2.6/conf/spark-env.sh路径下。

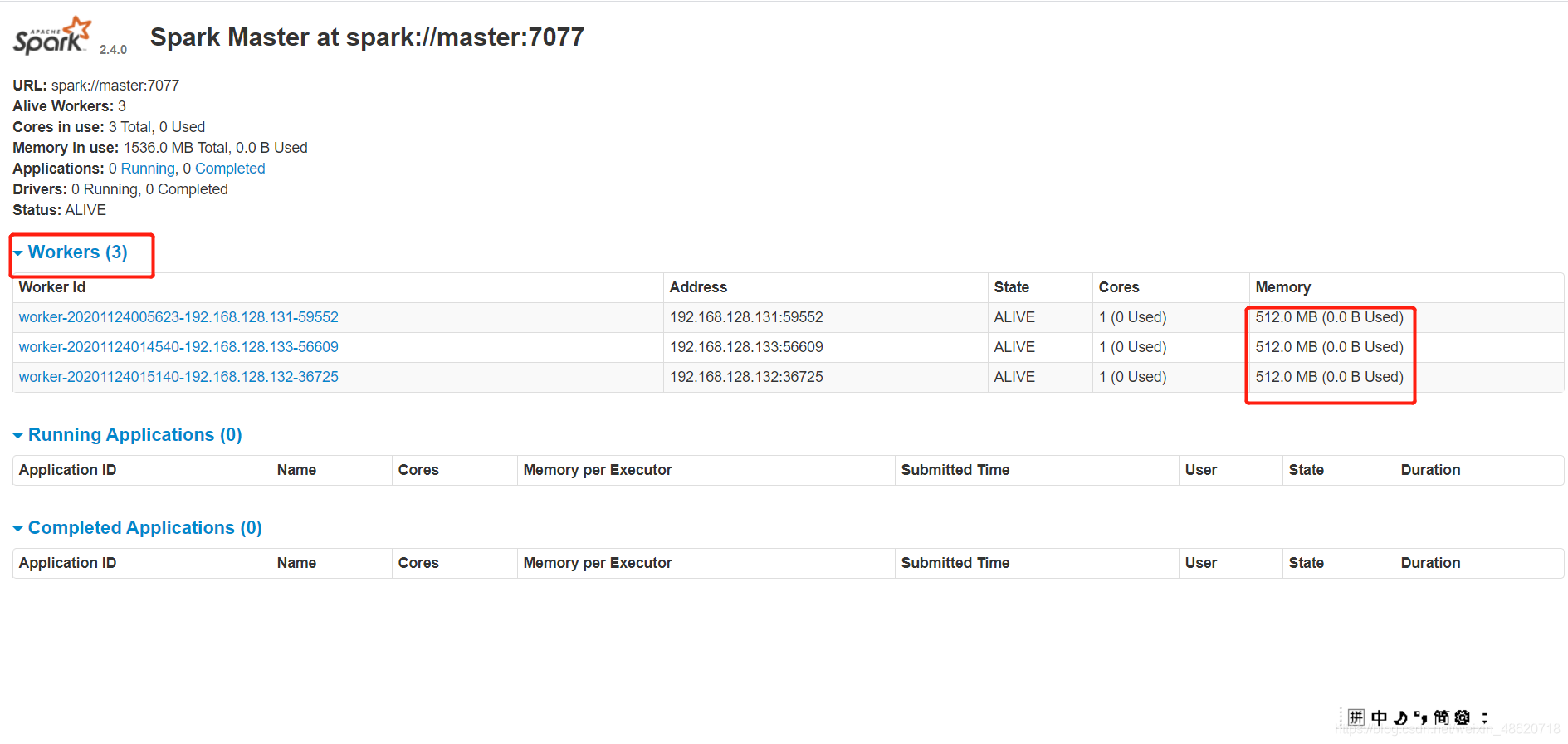

内存不知道满不满可以去独立集群Web界面查看应用的运行情况,打开浏览器,访问master:8080,

查看各个节点内存和使用情况,可以看到我的三个节点的内存还没有使用所以是0.0B的。

第二种是

:如果开启的是集群模式的情况下,要保证三个节点的服务都是开启的状态。如果三个节点没开启完全,就可能会出现标题出现的警告出错情况。

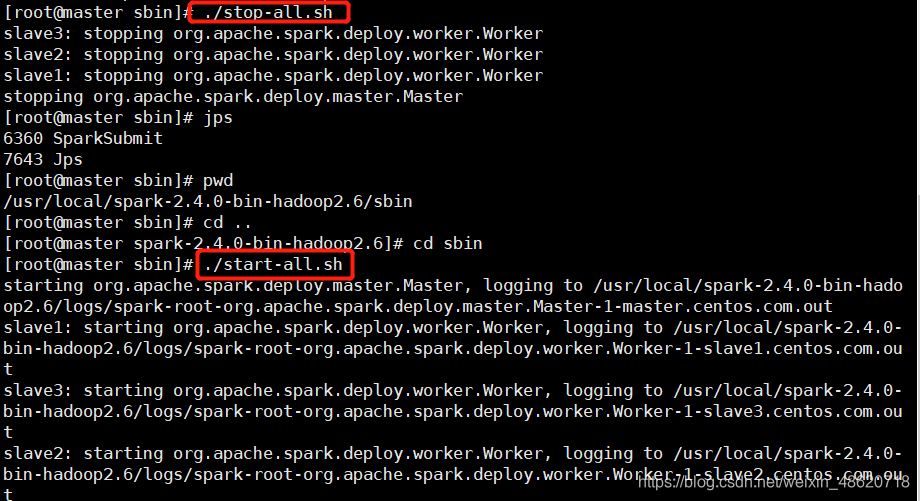

这个时候在master主节点上,重启一下这些服务。例如我重启了spark服务和hadoop服务。

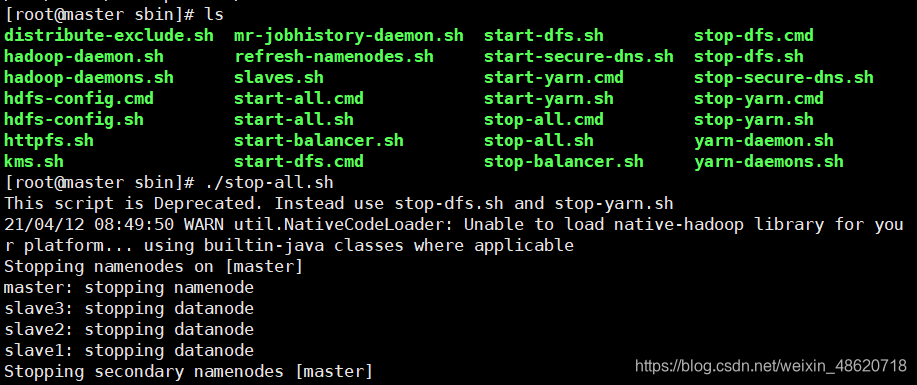

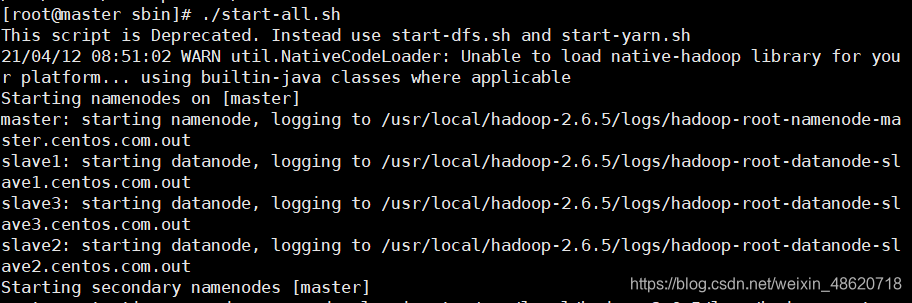

重启三个节点的hadoop服务,切换路径到/usr/local/hadoop-2.6.5/sbin,输入ls

,可以看到stop-all.sh命令。(注:主节点master输入-all的命令就可以同时开启三个节点的服务)

重启spark服务,在主节点master中,spark的命令在spark目录下的sbin中,如我的在/usr/local/spark-2.4.0-bin-hadoop2.6/sbin,输入停止命令,在开启spark的三个节点的服务。

在测试一下看看有没有问题。