链路聚合

什么是链路聚合

链路聚合(Link Aggregation)

是一个计算机网络术语,指将多个物理端口汇聚在一起,形成一个逻辑端口,以实现出/入流量吞吐量在各成员端口的负荷分担,交换机根据用户配置的端口负荷分担策略决定网络封包从哪个成员端口发送到对端的交换机。当交换机检测到其中一个成员端口的链路发生故障时,就停止在此端口上发送封包,并根据负荷分担策略在剩下的链路中重新计算报文的发送端口,故障端口恢复后再次担任收发端口。

链路聚合在增加链路带宽、实现链路传输弹性和工程冗余等方面是一项很重要的技术。

原理 : 多个物理的端口绑定在一起当成一个逻辑端口来使用,提高带宽,实现负载平衡或高可用的功能

应用场景: 网卡的链路聚合就是将多块网卡连接起来,当一块网卡损坏时,其余网卡仍工作,网络依旧可以正常运行,可以有效的防止因为网卡损坏带来的损失,同时也可以提高网络访问速度,其余网卡作为替补,防患于未然

配置的模式:网卡的链路聚合常用的有 bond 和 team 两种模式,bond模式最多可以添加两块网卡,team模式最多可以添加八块网卡

配置bond网络接口

bond聚合有两种方式:

| 轮询聚合 | 提高效率 两块网卡同时工作交替工作 |

| 主备聚合 | 提高安全性 一个网卡工作,工作的网卡坏了另一个就顶替上去active-backup |

实验准备:在虚拟机上配置双网卡 (不需要ip)

ip addr show ##查看双网卡设定是否成功

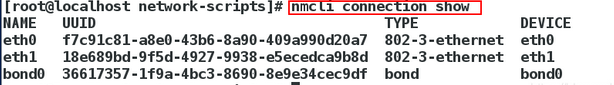

nmcli connection show ##查看连接网络服务的信息

nmcli connection delete 网卡名 ##删除掉连接网络服务的网卡 为了查看之后建立的bond网卡是否能够使用

nmcli connection add con-name bond0 ifname bond0 type bond mode active-backup ip4 172.25.254.100/24 ##

nmcli connection add con-name bond0 ifname bond0 type bond mode active-backup ##添加bond聚合的接口 命名任意 active-backup设定类型为主备

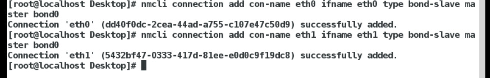

nmcli connection add con-name eth0 ifname eth0 type bond-slave master bond0

nmcli connection add con-name eth1 ifname eth1 type bond-slave master bond0 ##将虚拟出来的端口绑定两个真实的物理网卡

查看网络连接服务 应该显示“无“

添加bond聚合接口

因为没有真实的物理设备的支撑 bond类型的网卡不能使用 添加真实的物理网卡

查看真实的物理网卡是否添加成功

监控网卡工作状态 watch -n 1 “cat /proc/net/bonding/bond0”

查看bond聚合接口的主备聚合工作方式 起初是eth0作为主网卡工作

当停止主网卡服务后 eth1网卡替代主网卡开始工作

所以我们可以观察到网络服务并未终止 eth1–up eth0–down

ifconfig eth0 down

team聚合

| team的种类 | 名称 |

| broadcast | 广播容错 |

| roundrobin | 平衡轮叫 |

| activebackup | 主备 |

team——loadbalance具有负载均衡的功能(谁的负载少谁工作),和bond聚合相比 更加智能合理

创建之前先删除之前实验中的bond聚合

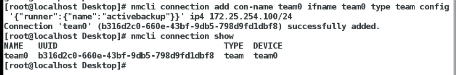

nmcli connection add con-name team0 ifname team0 type team config ‘{“runner”:{“name”:“activebackup”}}’ ip4 172.25.254.125/24 ##添加team聚合接口

nmcli connection add con-name eth0 ifname eth0 type team-slave master team0

nmcli connection add con-name eth1 ifname eth1 type team-slave master team0 ##分别将两块网卡绑定到此team接口

添加team聚合接口 创建后可以在网络中看到这组

给team接口添加真实的物理设备后 查看是否添加成功

监控 team接口的工作方式: watch -n 1 teamdctl team0 stat

查看正在工作的接口 eth0–up eth1–up 目前正在工作的是eth0

网络桥接

桥接是虚拟网卡

默认主机是没有网桥的(内核不开放的),虚拟机内核和系统和真机的内核和系统是相互独立的!

真机上网是通过内核调用网卡与外界进行联系的,而虚拟机的网卡是虚拟化的,不能直接上网。所以在真机的内核上面开一个网络桥接的口,将虚拟机的内核和真机的网卡连接在一起,从而虚拟机可以通过真机的网卡上网。

即在网卡上开一个接口,而该接口绑定一个IP,同一网段的虚拟机直接通过此接口绑定的IP与外界通信,相当于在虚拟机和真机上面架了一个桥,不需要受内核路由的控制,直接可以与外界通信

NAT和网桥的对比 : 1、相对于NAT,网桥不需要地址伪装,也不需要路由转发,也不需要配置网关,就可以与外界通信(配置的繁琐性)

2.网桥是工作在数据链路层(不需要IP,通过MAC通信),而NAT是在网络层(需要IP),所以前者的速度比后者快

桥接的创建

若之前有桥接,先删除桥接再进行本次实验

删除桥接之后查看网卡信息 ip中是没有桥接的

在没有桥接时我们去建立虚拟机

创建虚拟机时选择网络连接方式 打开Network selection查看其选项其中并没有桥接的选项。(默认为NAT方式连接网络)

1.用配置文件创建桥接

cd /etc/sysconfig/network-scripts

vim ifcfg-br0

DEVICE=br0

PREFIX=24

IPADDR=172.25.254.100

ONBOOT=yes

BOOTPROTO=none

TYPE=Birdge

更改物理网卡配置文件(真实的物理网卡上不需要有ip)

DEVICE=eth0

PREFIX24

ONBOOT=yes

BOOTPROTO=none

BRIDGE=br0

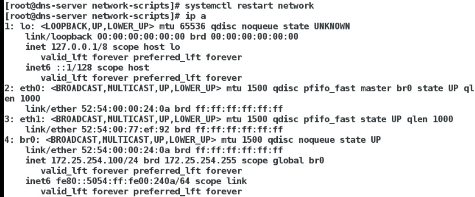

配置完成后重启网络服务

systemctl restart network

查看网络信息桥接创建成功

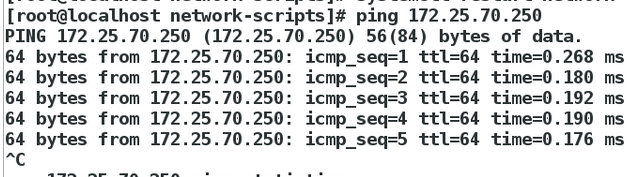

当虚拟网卡有了真实的物理设备作为支持 就可以ping的通

2.命令的方式创建桥接(命令的修改是临时的)

brctl addbr br0 ##添加桥接网卡

ifconfig br0 172.25.254.102/24 ##给桥接网卡设置ip

ifconfig ##查看当前网卡 里面有桥接网卡和对应ip

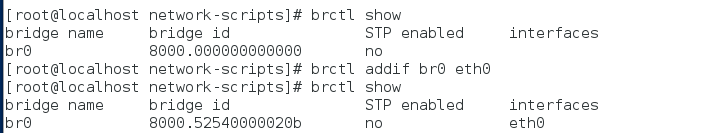

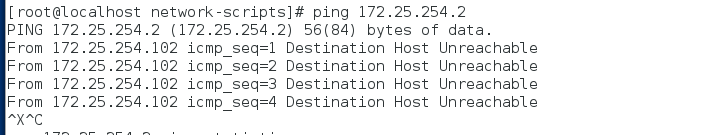

brctl show ##查看桥接网卡状态 没有真实物理设备与之对应 此时ping真机不能ping的通 ==有br0桥接网卡时eth0不再被使用所以eth0不能用来ping真机

brctl addif br0 eth0 ##给桥接网卡添加真实的物理设备

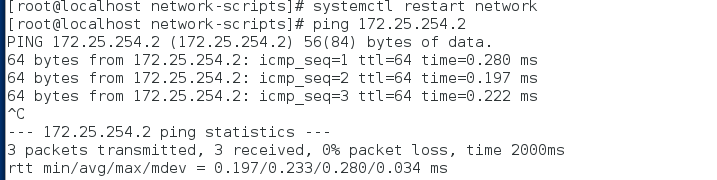

systemctl restart network ##重启网络

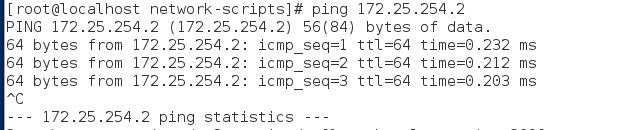

ping 172.25.254.102 ##添加真实的物理设备之后就可以ping通

命令方式添加桥接网卡 并给与桥接网卡ip

添加的桥接网卡没有真实的物理设备 需要添加真实物理设备

重启网络后 可以ping通

注意:更改网络后 一定要重启才能生效

有桥接时可以使用桥接的网络连接方式创建虚拟机,如没有桥接则只能使用默认的NAT方式

可以看到创建的虚拟机时 网络连接方式为Bridge br0

两种创建虚拟机的不同:使用桥接的网络方式创建虚拟机更加快速

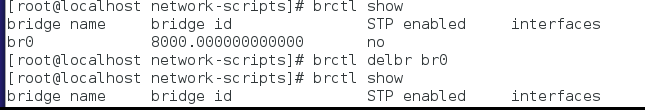

命令删除桥接

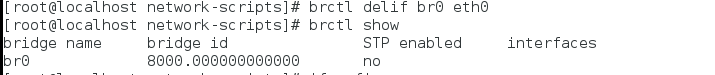

brctl delif br0 eth0 ##去掉桥接的物理设备

brctl show ##查看桥接设备状态 没有真实的物理设备与之对应

ifconfig br0 down ##停止br0服务

brctl delctl br0 ##删除桥接网卡

去掉桥接的物理设备

显然就算br0上有ip 但是没有设备支持ping 不通 虽然eth0也有ip但是依旧ping不通

停掉br0网卡后可以ping通

删除br0网卡

常见物理机与虚拟机网络不通问题解决

1.ip addr show ##查看网络状态——up

2. brctl show ##查看真实的物理设备是否存在(

真实的物理设备上没有ip

) 桥接是否断开 brctl addif br0 vent0

3.查看网络管理者NetworkManager的状态是否为开启 systemctl status NetworkManager

4.物理机网卡配置文件中是否多出文件 /etc/sysconfig/network-scripts 因为启动真机的时候系统会自动读取所有以ifcfg-开头的文件,因此将多余的文件删除

虚拟机网卡是否存在问题 存在问题删除网卡重新设置