springboot项目日志应用详解

1.项目配置文件

#端口设置

server:

tomcat:

uri-encoding: UTF-8

port: 8801

#配置数据库

spring:

jackson:

date-format: yyyy-MM-dd HH:mm:ss

time-zone: GMT+8

http:

encoding:

force: true

charset: UTF-8

enabled: true

multipart:

enabled: true

maxFileSize: '50Mb'

maxRequestSize: '50Mb'

datasource:

driver-class-name: com.mysql.jdbc.Driver

username: root

password: root

url: jdbc:mysql://localhost:3306/spjpa?serverTimezone=GMT%2b8&characterEncoding=utf8&useSSL=false

#数据库连接池配置

type: com.alibaba.druid.pool.DruidDataSource

# 下面为连接池的补充设置,应用到上面所有数据源中

druid:

initial-size: 5

min-idle: 5

max-active: 500

#添加回收机制

remove-abandoned: false

remove-abandoned-timeout: 1800

log-abandoned: true

# 配置获取连接等待超时的时间

max-wait: 60000

# 配置间隔多久才进行一次检测,检测需要关闭的空闲连接,单位是毫秒

time-between-eviction-runs-millis: 60000

# 配置一个连接在池中最小生存的时间,单位是毫秒

min-evictable-idle-time-millis: 300000

validation-query: SELECT 1 FROM DUAL

test-while-idle: true

test-on-borrow: false

test-on-return: false

pool-prepared-statements: true

max-pool-prepared-statement-per-connection-size: 20

# 配置监控统计拦截的filters,去掉后监控界面sql无法统计,'wall'用于防火墙

filters: stat,wall,log4j

filter:

stat:

log-slow-sql: true

connect-properties: druid.stat.mergeSql=true;druid.stat.slowSqlMillis=5000;

use-global-data-source-stat: true

aop:

auto: true

#jpa配置

jpa:

properties:

hibernate:

current_session_context_class: org.springframework.orm.hibernate5.SpringSessionContext

dialect: org.hibernate.dialect.MySQL5Dialect

hbm2ddl:

auto: update

show-sql: true

logging:

config: classpath:logback-spring-dev.xml

level:

com.kunbo.cn: debug

注意:在上面配置文件中最下面是日志文件的相关配置,包含日志文件的路径以及日志级别

2.开发环境日志文件配置

<?xml version="1.0" encoding="UTF-8"?>

<!-- 从高到地低 OFF 、 FATAL 、 ERROR 、 WARN 、 INFO 、 DEBUG 、 TRACE 、 ALL -->

<!-- 日志输出规则 根据当前ROOT 级别,日志输出时,级别高于root默认的级别时 会输出 -->

<!-- 以下 每个配置的 filter 是过滤掉输出文件里面,会出现高级别文件,依然出现低级别的日志信息,通过filter 过滤只记录本级别的日志 -->

<!-- 属性描述 scan:性设置为true时,配置文件如果发生改变,将会被重新加载,默认值为true scanPeriod:设置监测配置文件是否有修改的时间间隔,如果没有给出时间单位,默认单位是毫秒。当scan为true时,此属性生效。默认的时间间隔为1分钟。

debug:当此属性设置为true时,将打印出logback内部日志信息,实时查看logback运行状态。默认值为false。 -->

<configuration scan="true" scanPeriod="60 seconds" debug="false">

<contextName>d1money-web-ys-ems</contextName>

<!-- ConsoleAppender 控制台输出日志 -->

<appender name="STDOUT" class="ch.qos.logback.core.ConsoleAppender">

<!-- 对日志进行格式化 -->

<encoder>

<pattern>

%d{yyyy-MM-dd HH:mm:ss} [%thread] %-5level %logger -%msg%n

</pattern>

</encoder>

</appender>

<logger name="java.sql.PreparedStatement" value="DEBUG" />

<logger name="java.sql.Connection" value="DEBUG" />

<logger name="java.sql.Statement" value="DEBUG" />

<logger name="com.ibatis" value="DEBUG" />

<logger name="com.ibatis.common.jdbc.SimpleDataSource" value="DEBUG" />

<logger name="com.ibatis.common.jdbc.ScriptRunner" level="DEBUG" />

<logger name="com.ibatis.sqlmap.engine.impl.SqlMapClientDelegate"

value="DEBUG" />

<logger name="com.apache.ibatis" level="TRACE" />

<!-- root级别 DEBUG -->

<root level="debug">

<!-- 控制台输出 -->

<appender-ref ref="STDOUT" />

</root>

</configuration>

注意:开发环境只需满足开发人员在开发时观察控制台日志文件输出

3.测试环境日志文件

<?xml version="1.0" encoding="UTF-8"?>

<!-- 从高到地低 OFF 、 FATAL 、 ERROR 、 WARN 、 INFO 、 DEBUG 、 TRACE 、 ALL -->

<!-- 日志输出规则 根据当前ROOT 级别,日志输出时,级别高于root默认的级别时 会输出 -->

<!-- 以下 每个配置的 filter 是过滤掉输出文件里面,会出现高级别文件,依然出现低级别的日志信息,通过filter 过滤只记录本级别的日志 -->

<!-- 属性描述 scan:性设置为true时,配置文件如果发生改变,将会被重新加载,默认值为true scanPeriod:设置监测配置文件是否有修改的时间间隔,如果没有给出时间单位,默认单位是毫秒。当scan为true时,此属性生效。默认的时间间隔为1分钟。

debug:当此属性设置为true时,将打印出logback内部日志信息,实时查看logback运行状态。默认值为false。 -->

<configuration scan="true" scanPeriod="60 seconds" debug="false">

<contextName>d1money-web-ys-ems</contextName>

<!-- ConsoleAppender 控制台输出日志 -->

<appender name="STDOUT" class="ch.qos.logback.core.ConsoleAppender">

<!-- 对日志进行格式化 -->

<encoder>

<pattern>

%d{yyyy-MM-dd HH:mm:ss} [%thread] %-5level %logger -%msg%n

</pattern>

</encoder>

</appender>

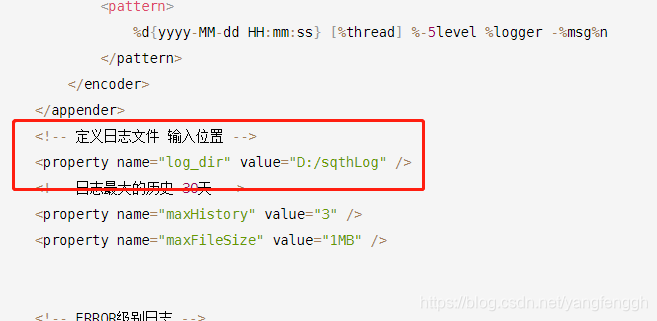

<!-- 定义日志文件 输入位置 -->

<property name="log_dir" value="D:/sqthLog" />

<!-- 日志最大的历史 30天 -->

<property name="maxHistory" value="3" />

<property name="maxFileSize" value="1MB" />

<!-- ERROR级别日志 -->

<!-- 滚动记录文件,先将日志记录到指定文件,当符合某个条件时,将日志记录到其他文件 RollingFileAppender -->

<appender name="ERROR"

class="ch.qos.logback.core.rolling.RollingFileAppender">

<!-- 过滤器,只记录WARN级别的日志 -->

<filter class="ch.qos.logback.classic.filter.LevelFilter">

<level>ERROR</level>

<onMatch>ACCEPT</onMatch>

<onMismatch>DENY</onMismatch>

</filter>

<!-- 最常用的滚动策略,它根据时间来制定滚动策略.既负责滚动也负责出发滚动 -->

<rollingPolicy class="ch.qos.logback.core.rolling.TimeBasedRollingPolicy">

<!--日志输出位置 可相对、和绝对路径 -->

<fileNamePattern>

${log_dir}/app_error.%d{yyyy-MM-dd}.%i.log

</fileNamePattern>

<!-- 可选节点,控制保留的归档文件的最大数量,超出数量就删除旧文件假设设置每个月滚动,且<maxHistory>是6, 则只保存最近6个月的文件,删除之前的旧文件。注意,删除旧文件是,那些为了归档而创建的目录也会被删除 -->

<maxHistory>${maxHistory}</maxHistory>

<timeBasedFileNamingAndTriggeringPolicy class="ch.qos.logback.core.rolling.SizeAndTimeBasedFNATP">

<maxFileSize>${maxFileSize}</maxFileSize>

</timeBasedFileNamingAndTriggeringPolicy>

</rollingPolicy>

<!-- 按照固定窗口模式生成日志文件,当文件大于20MB时,生成新的日志文件。窗口大小是1到3,当保存了3个归档文件后,将覆盖最早的日志。

<rollingPolicy class="ch.qos.logback.core.rolling.FixedWindowRollingPolicy">

<fileNamePattern>${log_dir}/%d{yyyy-MM-dd}/.log.zip</fileNamePattern> <minIndex>1</minIndex>

<maxIndex>3</maxIndex> </rollingPolicy> -->

<!-- 查看当前活动文件的大小,如果超过指定大小会告知RollingFileAppender 触发当前活动文件滚动 <triggeringPolicy

class="ch.qos.logback.core.rolling.SizeBasedTriggeringPolicy"> <maxFileSize>5MB</maxFileSize>

</triggeringPolicy> -->

<encoder>

<pattern>%d{yyyy-MM-dd HH:mm:ss.SSS} [%thread] %-5level %logger - %msg%n</pattern>

</encoder>

</appender>

<!-- WARN级别日志 appender -->

<appender name="WARN"

class="ch.qos.logback.core.rolling.RollingFileAppender">

<!-- 过滤器,只记录WARN级别的日志 -->

<filter class="ch.qos.logback.classic.filter.LevelFilter">

<level>WARN</level>

<onMatch>ACCEPT</onMatch>

<onMismatch>DENY</onMismatch>

</filter>

<rollingPolicy class="ch.qos.logback.core.rolling.TimeBasedRollingPolicy">

<!-- 按天回滚 daily -->

<fileNamePattern>

${log_dir}/app_warn.%d{yyyy-MM-dd}.%i.log

</fileNamePattern>

<!-- 日志最大的历史 30天 -->

<maxHistory>${maxHistory}</maxHistory>

<timeBasedFileNamingAndTriggeringPolicy class="ch.qos.logback.core.rolling.SizeAndTimeBasedFNATP">

<maxFileSize>${maxFileSize}</maxFileSize>

</timeBasedFileNamingAndTriggeringPolicy>

</rollingPolicy>

<encoder>

<pattern>%d{yyyy-MM-dd HH:mm:ss.SSS} [%thread] %-5level %logger - %msg%n</pattern>

</encoder>

</appender>

<!-- INFO级别日志 appender -->

<appender name="INFO"

class="ch.qos.logback.core.rolling.RollingFileAppender">

<!-- 过滤器,只记录INFO级别的日志 -->

<filter class="ch.qos.logback.classic.filter.LevelFilter">

<level>INFO</level>

<onMatch>ACCEPT</onMatch>

<onMismatch>DENY</onMismatch>

</filter>

<rollingPolicy class="ch.qos.logback.core.rolling.TimeBasedRollingPolicy">

<!-- 按天回滚 daily -->

<fileNamePattern>

${log_dir}/app_info.%d{yyyy-MM-dd}.%i.log

</fileNamePattern>

<!-- 日志最大的历史 30天 -->

<maxHistory>${maxHistory}</maxHistory>

<timeBasedFileNamingAndTriggeringPolicy class="ch.qos.logback.core.rolling.SizeAndTimeBasedFNATP">

<maxFileSize>${maxFileSize}</maxFileSize>

</timeBasedFileNamingAndTriggeringPolicy>

</rollingPolicy>

<encoder>

<pattern>%d{yyyy-MM-dd HH:mm:ss.SSS} [%thread] %-5level %logger - %msg%n</pattern>

</encoder>

</appender>

<!-- DEBUG级别日志 appender -->

<appender name="DEBUG"

class="ch.qos.logback.core.rolling.RollingFileAppender">

<!-- 过滤器,只记录DEBUG级别的日志 -->

<filter class="ch.qos.logback.classic.filter.LevelFilter">

<level>DEBUG</level>

<onMatch>ACCEPT</onMatch>

<onMismatch>DENY</onMismatch>

</filter>

<rollingPolicy class="ch.qos.logback.core.rolling.TimeBasedRollingPolicy">

<!-- 按天回滚 daily -->

<fileNamePattern>

${log_dir}/app_debug.%d{yyyy-MM-dd}.%i.log

</fileNamePattern>

<!-- 日志最大的历史 30天 -->

<maxHistory>${maxHistory}</maxHistory>

<timeBasedFileNamingAndTriggeringPolicy class="ch.qos.logback.core.rolling.SizeAndTimeBasedFNATP">

<maxFileSize>${maxFileSize}</maxFileSize>

</timeBasedFileNamingAndTriggeringPolicy>

</rollingPolicy>

<encoder>

<pattern>%d{yyyy-MM-dd HH:mm:ss.SSS} [%thread] %-5level %logger - %msg%n</pattern>

</encoder>

</appender>

<!-- TRACE级别日志 appender -->

<appender name="TRACE"

class="ch.qos.logback.core.rolling.RollingFileAppender">

<!-- 过滤器,只记录ERROR级别的日志 -->

<filter class="ch.qos.logback.classic.filter.LevelFilter">

<level>TRACE</level>

<onMatch>ACCEPT</onMatch>

<onMismatch>DENY</onMismatch>

</filter>

<rollingPolicy class="ch.qos.logback.core.rolling.TimeBasedRollingPolicy">

<!-- 按天回滚 daily -->

<fileNamePattern>

${log_dir}/app_trace.%d{yyyy-MM-dd}.%i.log

</fileNamePattern>

<!-- 日志最大的历史 30天 -->

<maxHistory>${maxHistory}</maxHistory>

<timeBasedFileNamingAndTriggeringPolicy class="ch.qos.logback.core.rolling.SizeAndTimeBasedFNATP">

<maxFileSize>${maxFileSize}</maxFileSize>

</timeBasedFileNamingAndTriggeringPolicy>

</rollingPolicy>

<encoder>

<pattern>%d{yyyy-MM-dd HH:mm:ss.SSS} [%thread] %-5level %logger - %msg%n</pattern>

</encoder>

</appender>

<logger name="java.sql.PreparedStatement" value="DEBUG" />

<logger name="java.sql.Connection" value="DEBUG" />

<logger name="java.sql.Statement" value="DEBUG" />

<logger name="com.ibatis" value="DEBUG" />

<logger name="com.ibatis.common.jdbc.SimpleDataSource" value="DEBUG" />

<logger name="com.ibatis.common.jdbc.ScriptRunner" level="DEBUG" />

<logger name="com.ibatis.sqlmap.engine.impl.SqlMapClientDelegate"

value="DEBUG" />

<logger name="com.apache.ibatis" level="TRACE" />

<!-- root级别 DEBUG -->

<root level="debug">

<!-- 文件输出 -->

<appender-ref ref="ERROR" />

<appender-ref ref="INFO" />

<appender-ref ref="WARN" />

<appender-ref ref="DEBUG" />

<appender-ref ref="TRACE" />

</root>

</configuration>

注意:测试环境就是项目打包测试运行中,需要将运行日志记录到指定的文件夹

将运行日志输入到D:/sqthLog

4.生产环境

<?xml version="1.0" encoding="UTF-8"?>

<!-- 从高到地低 OFF 、 FATAL 、 ERROR 、 WARN 、 INFO 、 DEBUG 、 TRACE 、 ALL -->

<!-- 日志输出规则 根据当前ROOT 级别,日志输出时,级别高于root默认的级别时 会输出 -->

<!-- 以下 每个配置的 filter 是过滤掉输出文件里面,会出现高级别文件,依然出现低级别的日志信息,通过filter 过滤只记录本级别的日志 -->

<!-- 属性描述 scan:性设置为true时,配置文件如果发生改变,将会被重新加载,默认值为true scanPeriod:设置监测配置文件是否有修改的时间间隔,如果没有给出时间单位,默认单位是毫秒。当scan为true时,此属性生效。默认的时间间隔为1分钟。

debug:当此属性设置为true时,将打印出logback内部日志信息,实时查看logback运行状态。默认值为false。 -->

<configuration scan="true" scanPeriod="60 seconds" debug="false">

<contextName>d1money-web-ys-ems</contextName>

<!-- ConsoleAppender 控制台输出日志 -->

<appender name="STDOUT" class="ch.qos.logback.core.ConsoleAppender">

<!-- 对日志进行格式化 -->

<encoder>

<pattern>

%d{yyyy-MM-dd HH:mm:ss} [%thread] %-5level %logger -%msg%n

</pattern>

</encoder>

</appender>

<!-- 定义日志文件 输入位置 -->

<property name="log_dir" value="D:/sqthLog" />

<!-- 日志最大的历史 30天 -->

<property name="maxHistory" value="3" />

<property name="maxFileSize" value="1MB" />

<!-- ERROR级别日志 -->

<!-- 滚动记录文件,先将日志记录到指定文件,当符合某个条件时,将日志记录到其他文件 RollingFileAppender -->

<appender name="ERROR"

class="ch.qos.logback.core.rolling.RollingFileAppender">

<!-- 过滤器,只记录WARN级别的日志 -->

<filter class="ch.qos.logback.classic.filter.LevelFilter">

<level>ERROR</level>

<onMatch>ACCEPT</onMatch>

<onMismatch>DENY</onMismatch>

</filter>

<!-- 最常用的滚动策略,它根据时间来制定滚动策略.既负责滚动也负责出发滚动 -->

<rollingPolicy class="ch.qos.logback.core.rolling.TimeBasedRollingPolicy">

<!--日志输出位置 可相对、和绝对路径 -->

<fileNamePattern>

${log_dir}/app_error.%d{yyyy-MM-dd}.%i.log

</fileNamePattern>

<!-- 可选节点,控制保留的归档文件的最大数量,超出数量就删除旧文件假设设置每个月滚动,且<maxHistory>是6, 则只保存最近6个月的文件,删除之前的旧文件。注意,删除旧文件是,那些为了归档而创建的目录也会被删除 -->

<maxHistory>${maxHistory}</maxHistory>

<timeBasedFileNamingAndTriggeringPolicy class="ch.qos.logback.core.rolling.SizeAndTimeBasedFNATP">

<maxFileSize>${maxFileSize}</maxFileSize>

</timeBasedFileNamingAndTriggeringPolicy>

</rollingPolicy>

<!-- 按照固定窗口模式生成日志文件,当文件大于20MB时,生成新的日志文件。窗口大小是1到3,当保存了3个归档文件后,将覆盖最早的日志。

<rollingPolicy class="ch.qos.logback.core.rolling.FixedWindowRollingPolicy">

<fileNamePattern>${log_dir}/%d{yyyy-MM-dd}/.log.zip</fileNamePattern> <minIndex>1</minIndex>

<maxIndex>3</maxIndex> </rollingPolicy> -->

<!-- 查看当前活动文件的大小,如果超过指定大小会告知RollingFileAppender 触发当前活动文件滚动 <triggeringPolicy

class="ch.qos.logback.core.rolling.SizeBasedTriggeringPolicy"> <maxFileSize>5MB</maxFileSize>

</triggeringPolicy> -->

<encoder>

<pattern>%d{yyyy-MM-dd HH:mm:ss.SSS} [%thread] %-5level %logger - %msg%n</pattern>

</encoder>

</appender>

<!-- WARN级别日志 appender -->

<appender name="WARN"

class="ch.qos.logback.core.rolling.RollingFileAppender">

<!-- 过滤器,只记录WARN级别的日志 -->

<filter class="ch.qos.logback.classic.filter.LevelFilter">

<level>WARN</level>

<onMatch>ACCEPT</onMatch>

<onMismatch>DENY</onMismatch>

</filter>

<rollingPolicy class="ch.qos.logback.core.rolling.TimeBasedRollingPolicy">

<!-- 按天回滚 daily -->

<fileNamePattern>

${log_dir}/app_warn.%d{yyyy-MM-dd}.%i.log

</fileNamePattern>

<!-- 日志最大的历史 30天 -->

<maxHistory>${maxHistory}</maxHistory>

<timeBasedFileNamingAndTriggeringPolicy class="ch.qos.logback.core.rolling.SizeAndTimeBasedFNATP">

<maxFileSize>${maxFileSize}</maxFileSize>

</timeBasedFileNamingAndTriggeringPolicy>

</rollingPolicy>

<encoder>

<pattern>%d{yyyy-MM-dd HH:mm:ss.SSS} [%thread] %-5level %logger - %msg%n</pattern>

</encoder>

</appender>

<!-- INFO级别日志 appender -->

<appender name="INFO"

class="ch.qos.logback.core.rolling.RollingFileAppender">

<!-- 过滤器,只记录INFO级别的日志 -->

<filter class="ch.qos.logback.classic.filter.LevelFilter">

<level>INFO</level>

<onMatch>ACCEPT</onMatch>

<onMismatch>DENY</onMismatch>

</filter>

<rollingPolicy class="ch.qos.logback.core.rolling.TimeBasedRollingPolicy">

<!-- 按天回滚 daily -->

<fileNamePattern>

${log_dir}/app_info.%d{yyyy-MM-dd}.%i.log

</fileNamePattern>

<!-- 日志最大的历史 30天 -->

<maxHistory>${maxHistory}</maxHistory>

<timeBasedFileNamingAndTriggeringPolicy class="ch.qos.logback.core.rolling.SizeAndTimeBasedFNATP">

<maxFileSize>${maxFileSize}</maxFileSize>

</timeBasedFileNamingAndTriggeringPolicy>

</rollingPolicy>

<encoder>

<pattern>%d{yyyy-MM-dd HH:mm:ss.SSS} [%thread] %-5level %logger - %msg%n</pattern>

</encoder>

</appender>

<!-- DEBUG级别日志 appender -->

<appender name="DEBUG"

class="ch.qos.logback.core.rolling.RollingFileAppender">

<!-- 过滤器,只记录DEBUG级别的日志 -->

<filter class="ch.qos.logback.classic.filter.LevelFilter">

<level>DEBUG</level>

<onMatch>ACCEPT</onMatch>

<onMismatch>DENY</onMismatch>

</filter>

<rollingPolicy class="ch.qos.logback.core.rolling.TimeBasedRollingPolicy">

<!-- 按天回滚 daily -->

<fileNamePattern>

${log_dir}/app_debug.%d{yyyy-MM-dd}.%i.log

</fileNamePattern>

<!-- 日志最大的历史 30天 -->

<maxHistory>${maxHistory}</maxHistory>

<timeBasedFileNamingAndTriggeringPolicy class="ch.qos.logback.core.rolling.SizeAndTimeBasedFNATP">

<maxFileSize>${maxFileSize}</maxFileSize>

</timeBasedFileNamingAndTriggeringPolicy>

</rollingPolicy>

<encoder>

<pattern>%d{yyyy-MM-dd HH:mm:ss.SSS} [%thread] %-5level %logger - %msg%n</pattern>

</encoder>

</appender>

<!-- TRACE级别日志 appender -->

<appender name="TRACE"

class="ch.qos.logback.core.rolling.RollingFileAppender">

<!-- 过滤器,只记录ERROR级别的日志 -->

<filter class="ch.qos.logback.classic.filter.LevelFilter">

<level>TRACE</level>

<onMatch>ACCEPT</onMatch>

<onMismatch>DENY</onMismatch>

</filter>

<rollingPolicy class="ch.qos.logback.core.rolling.TimeBasedRollingPolicy">

<!-- 按天回滚 daily -->

<fileNamePattern>

${log_dir}/app_trace.%d{yyyy-MM-dd}.%i.log

</fileNamePattern>

<!-- 日志最大的历史 30天 -->

<maxHistory>${maxHistory}</maxHistory>

<timeBasedFileNamingAndTriggeringPolicy class="ch.qos.logback.core.rolling.SizeAndTimeBasedFNATP">

<maxFileSize>${maxFileSize}</maxFileSize>

</timeBasedFileNamingAndTriggeringPolicy>

</rollingPolicy>

<encoder>

<pattern>%d{yyyy-MM-dd HH:mm:ss.SSS} [%thread] %-5level %logger - %msg%n</pattern>

</encoder>

</appender>

<logger name="java.sql.PreparedStatement" value="DEBUG" />

<logger name="java.sql.Connection" value="DEBUG" />

<logger name="java.sql.Statement" value="DEBUG" />

<logger name="com.ibatis" value="DEBUG" />

<logger name="com.ibatis.common.jdbc.SimpleDataSource" value="DEBUG" />

<logger name="com.ibatis.common.jdbc.ScriptRunner" level="DEBUG" />

<logger name="com.ibatis.sqlmap.engine.impl.SqlMapClientDelegate"

value="DEBUG" />

<logger name="com.apache.ibatis" level="TRACE" />

<!-- root级别 DEBUG -->

<root level="debug">

<!-- 文件输出 -->

<appender-ref ref="ERROR" />

<appender-ref ref="INFO" />

<appender-ref ref="WARN" />

<appender-ref ref="DEBUG" />

<appender-ref ref="TRACE" />

</root>

</configuration>

版权声明:本文为yangfenggh原创文章,遵循 CC 4.0 BY-SA 版权协议,转载请附上原文出处链接和本声明。