其实[

笔记(一)

到

(二)

]中说了很多回归和分类器的不同了,那么在经历了线性回归方法之后,就来说说分类器好了。machine learning是先分supervised learning and unsupervised learning,然后才是 regression v.s. classification, and clustering…疏通了脉络之后,再看《The Elements of Statistical Learning》这本书,就觉得顺畅多了。以前只是零零散散的接触一个个孤立的模型,没有找出一个脉络串起来过,自然也就不知道分别适用于什么场景。

——-满足大家的八卦之心之后,笔记开始——-

线性分类器

对应原书第四章。

先是来一点直觉上的东西:分类器顾名思义,就是把一堆样本归到不同的类别中去。那么这类模型的几何直觉是什么呢?很简单,空间分割嘛。最直白的,我们有一群人,组成了一个大的群体。然后现在要把大家归为男女两类,那么空间自然就是被分割为两个子空间——男和女了。

线性分类器是什么呢?分割男和女的时候,可能分割是三个一群,五个一簇的,所以非要画分割的界限的话,八成是山路十八弯的…我们以前说过,这类的模型问题就是可能复杂度比较高(比如参数的个数较多),导致就算训练误差小,测试误差不一定小。所以呢,我们希望这个分割界限是直线的(二维平面下)、或者平面的(三维空间中),或者超平面的(高位空间中),这样就比较清晰明了的感觉了。

线性分类器:logit模型(或称logistic regression)

这里也不完全是按照吴老师上课讲的东西了,因为回头再看这本书会发现书中还有一些很好玩的直觉很强的东西。错过不免可惜,一并收纳。

首先换一下记号~我们在前面都用

代表被解释变量,从现在开始对于分类问题,我们改用G。

损失函数

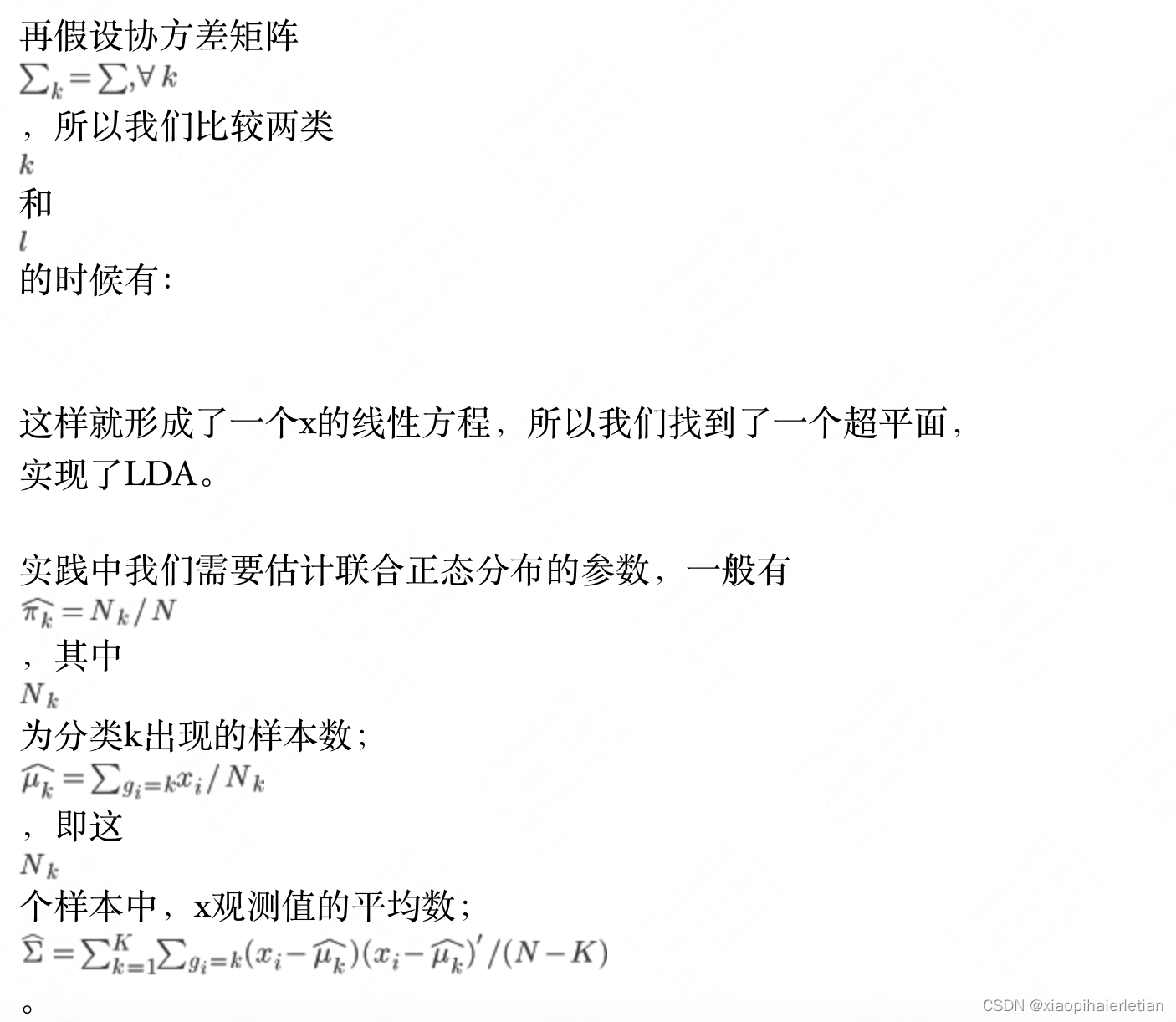

LDA:linear discriminant analysis(贝叶斯意义下)

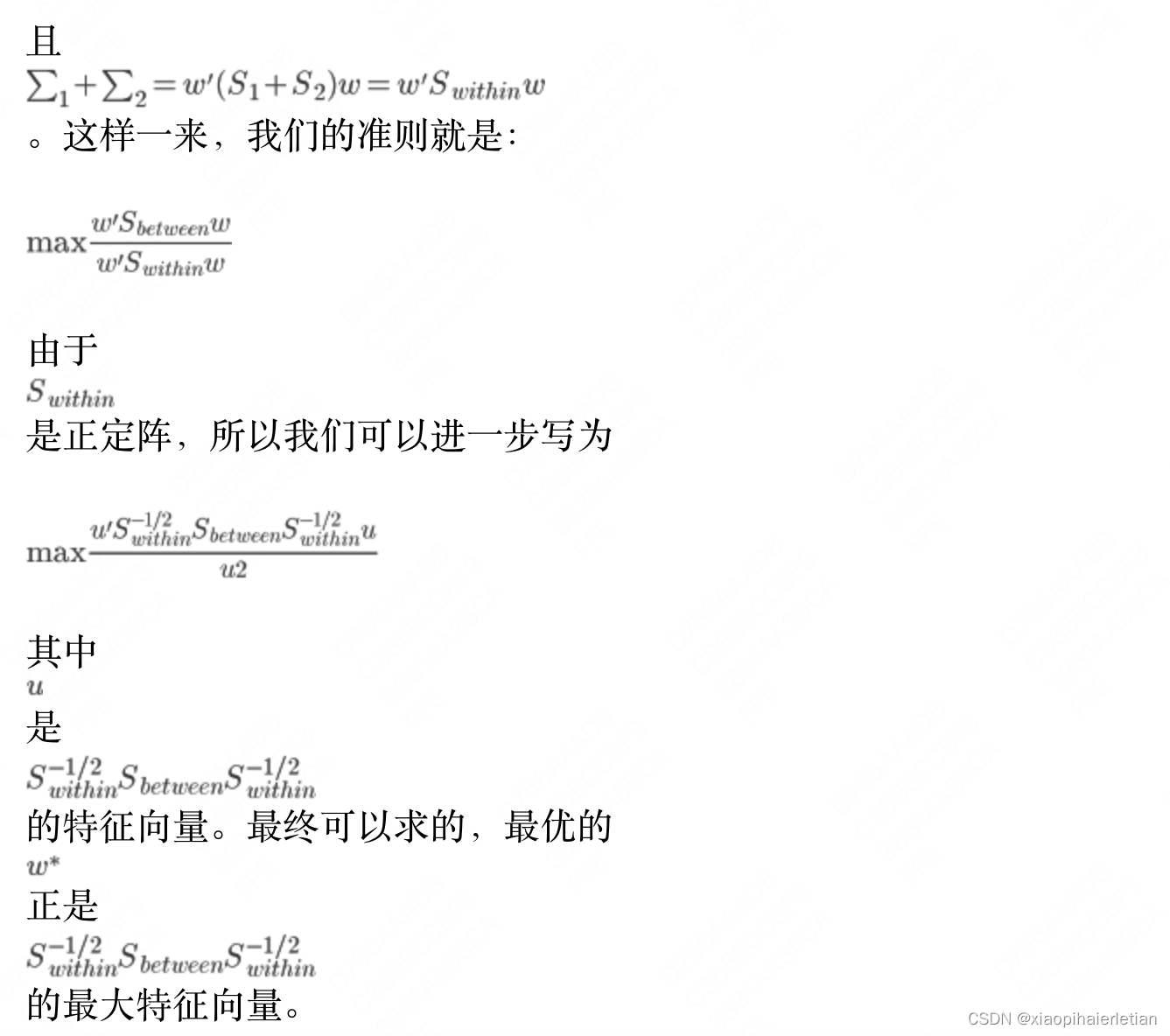

Fisher视角下的分类器

说实话,我对LDA(或者QDA)的理解都非常有限…这本书里面还有一节说到LDA和logit怎么选,我也是大概看了一下没有特别的看明白…笔记只是如实记录,海涵。暂时还不知道讲到Fisher到底是想讲什么…理解力好有限,唉。

——最后的碎碎念——

除了统计学习精要,

Coursera

的Model Thinking也终于结课了,做完了期末考试卷,感觉心里空空的。这门课真的是开的非常深入浅出,覆盖了这么多学科、问题的各种模型,非常有助于逻辑思考和抽象。只是多少有些遗憾的,很多东西来不及细细回味,听过了视频就忘了,没有努力的去理解那些模型背后的逻辑。过阵子应该好好整理一下这门课的笔记,算作是一个良好的回顾吧。

不知道为什么,工作之后再去学这些东西,真的感觉力不从心的时刻多了很多。这半年只有这么区区两门课,就让我觉得有时候不得不强迫自己一下赶上进度。不过为了保持一个基本的生活质量,还是应该不时看看这些新东西的,要不生活都腐朽了。