Transformer模型作为一种强大的深度学习架构,其性能和效果受到超参数的选择和调整的影响。正确选择和调整超参数可以提升模型的性能和泛化能力,而错误的选择可能导致性能下降。本文将分享一些经验和策略,帮助您在使用Transformer模型时进行超参数的选择和调整。

Transformer模型中的超参数选择和调整有何经验?

第一部分:常见的Transformer模型超参数

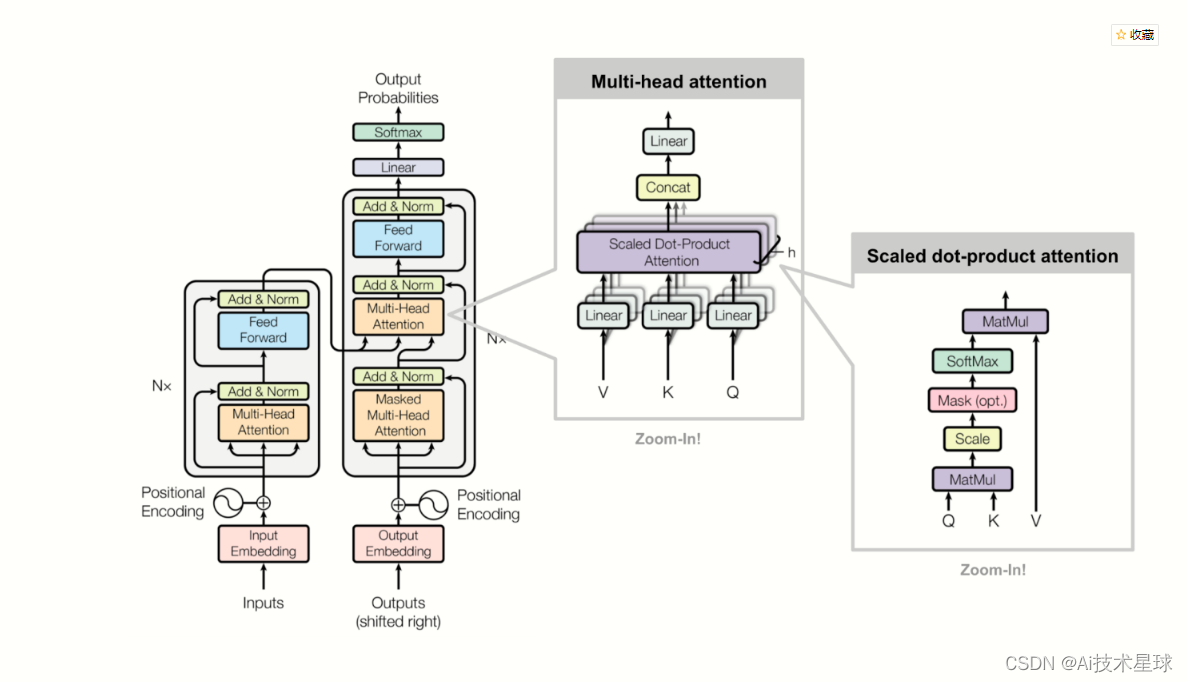

- 嵌入维度(Embedding Dimension):讨论输入和输出嵌入的维度选择,如词嵌入和位置编码的维度。

- 注意力头数(Number of Attention Heads):解释多头注意力机制的作用和头数的选择原则。

- 编码器和解码器层数(Number of Encoder and Decoder Layers):探讨编码器和解码器的层数对模型性能的影响。

- 学习率(Learning Rate):介绍学习率的设置和调整策略,如初始学习率、学习率衰减和学习率调度器的选择。

- 批量大小(Batch Size):讨论批量大小的选择对训练速度和模型性能的影响。

第二部分:超参数调整策略

- 网格搜索(Grid Search):详细介绍网格搜索方法,在给定超参数空间中穷举搜索最佳组合。

- 随机搜索(Random Search):解释随机搜索方法,在超参数空间中随机选择组合进行评估。

- 贝叶斯优化(Bayesian Optimization):介绍贝叶斯优化方法,在已有评估结果的基础上通过建模选择下一个要评估的超参数组合。

- 自动调参工具(AutoML Tools):介绍一些常用的自动调参工具和库,如Optuna、Hyperopt和Keras Tuner。

第三部分:经验和实践建议

- 利用先验知识:根据任务的特点和数据的特性,利用先验知识对超参数的选择进行初始化。

- 逐步调整策略:建议从较小的数据集和简单的模型开始,逐步增加复杂性和规模,并观察超参数对性能的影响。

- 多次训练和评估:进行多次实验,观察超参数在不同运行中的稳定性和一致性。

- 超参数共享:在编码器和解码器中共享一些超参数,以减少搜索空间和加快调优过程。

-

白嫖配套资料+60G入门进阶AI资源包+技术问题答疑+完整版视频

关注公众号:AI技术星球,回复:123

内含:深度学习神经网络+CV计算机视觉学习(两大框架pytorch/tensorflow+源码课件笔记)+NLP等

在使用Transformer模型时,选择和调整超参数是优化模型性能的重要步骤。本文分享了一些常见的超参数和调整策略,以及一些经验和实践建议。在实际应用中,建议结合任务需求、数据特性和计算资源进行超参数的选择和调整,并根据实验结果进行迭代优化,以获得更好的性能和效果。

版权声明:本文为njhhuuuby原创文章,遵循 CC 4.0 BY-SA 版权协议,转载请附上原文出处链接和本声明。