Hive(二)安装

1. 事前准备

(1)HDFS+YARN集群

Hive是基于Hadoop的,其查询底层执行的是MapReduce任务,所以请先准备一个能够成功启动HDFS+YARN的集群.机器配置受限的可以参考我的另一篇博客

Docker-hadoop集群搭建

(一般来讲,宿主机

我指的是Linux宿主机比如我用的就是腾讯云

有2G物理内存应该能跑起来,当然内存越大越流畅.)

(2)Hive下载

下载地址:

http://hive.apache.org/downloads.html

下载前请仔细阅读,看看所下载的Hive版本,支持的Hadoop版本.

官方文档:

https://cwiki.apache.org/confluence/display/Hive/GettingStarted

2. 安装部署

2.1 Hive安装及配置

2.1.1解压下载的Hive包

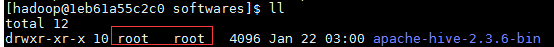

sudo tar xzvf apache-hive-2.3.6-bin.tar.gz -C /opt/softwares/

解压后一般都是owner和group都是root,这里改成普通用户

sudo chown -R hadoop:hadoop apache-hive-2.3.6-bin

# 个人习惯,为解压后的文件创建一个符号链接

sudo ln -s apache-hive-2.3.6-bin/ hive

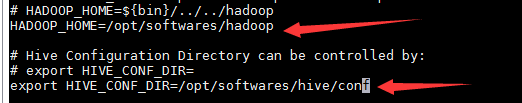

2.1.2 配置hive-env.sh

将

hive-env.sh.template

复制或改名为hive-env.sh

cp hive-env.sh.template hive-env.sh

进入该文件,配置

HADOOP_HOME

及

HIVE_CONF_DIR

HADOOP_HOME=/opt/softwares/hadoop

export HIVE_CONF_DIR=/opt/softwares/hive/conf

2.1.3 配置hive-site.xml

复制

hive-default.xml.template

为

hive-site.xml

或者直接新建

cp hive-default.xml.template hive-site.xml

删去<configuration></configuration>标签所有属性添加下列属性内容

<property>

<name>hive.metastore.warehouse.dir</name>

<property>/user/hive/warehouse</property>

<description>location of default database for the warehouse</description>

</property

版权声明:本文为Leonardy原创文章,遵循 CC 4.0 BY-SA 版权协议,转载请附上原文出处链接和本声明。