by wangben @ beijing

特征选择的主要目的有两点:

1. 减少特征数量提高训练速度,这点对于一些复杂模型来说尤其重要

2. 减少noisefeature以提高模型在测试集上的准确性。一些噪音特征会导致模型出现错误的泛化(generalization),从而在测试集中表现较差。另外从模型复杂度的角度来看,特征越多模型的复杂度越高,也就越容易发生overfitting。

互信息(Mutual information)和卡方检验(chisquare)是两种比较常用的特征选择方法:

互信息

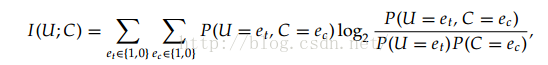

互信息是用来评价一个事件的出现对于另一个事件的出现所贡献的信息量,具体的计算公式为:

其中U、C代表两个事件,e的取值可以为0或者1,1代表出现这个事件,0代表不出现。

把上述公式拆解为统计形式为:

版权声明:本文为yihucha166原创文章,遵循 CC 4.0 BY-SA 版权协议,转载请附上原文出处链接和本声明。