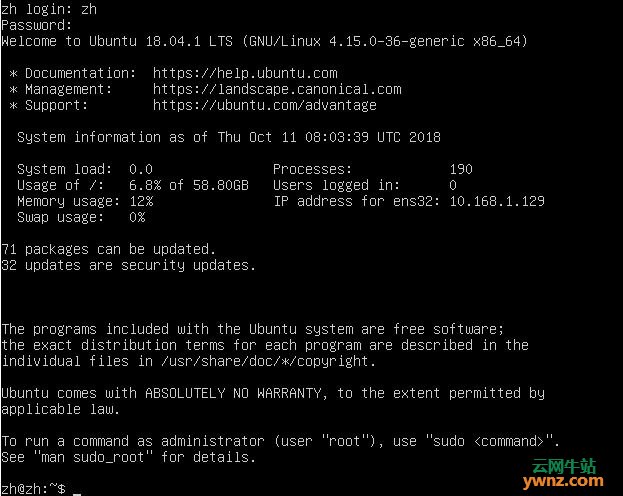

本文介绍安装Hadoop系统环境,所用的操作系统是Ubuntu Server 18.04.1 Linux 4.15.0-36-generic x86_64。

一、前提

先安装好Ubuntu Server 18.04.1系统,请参考安装Ubuntu 18.04 LTS服务器版详细步骤。

二、安装ssh环境

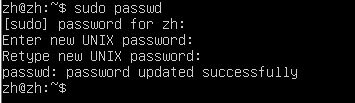

1.配置root用户密码

修改root用户的初始密码:

sudo passwd

退出当前用户,使用root登陆系统。

2.关闭防火墙

关闭防火墙:

systemctl stop firewalld.service

开机不启动防火墙:

systemctl disable firewalld.service

查看防火墙状态:

ufw status

inactive状态是防火墙关闭状态,active是开启状态。

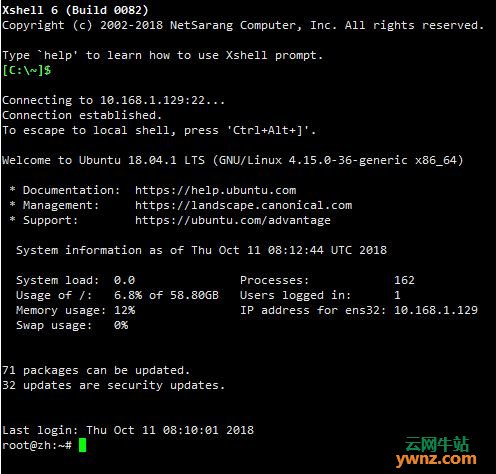

3.配置root用户远程连接

注:装了ssh-server,如果未安装,请先安装:

apt-get install openssh-server

修改sshd_config:

vim /etc/ssh/sshd_config

找到:

# Authentication:

LoginGraceTime 120

PermitRootLogin without passwd

StrictModes yes

改成:

# Authentication:

LoginGraceTime 120

PermitRootLogin yes

StrictModes yes

然后重启SSH服务即可。

重启过后通过shell连接:

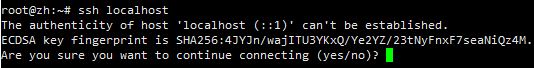

4.设置ssh localhost免密码登录:

ssh localhost

exit

输入密码登录本机和退出本机:

在进行了初次登陆后,会在当前家目录用户下有一个.ssh文件夹,进入该文件夹下:

cd ~/.ssh/

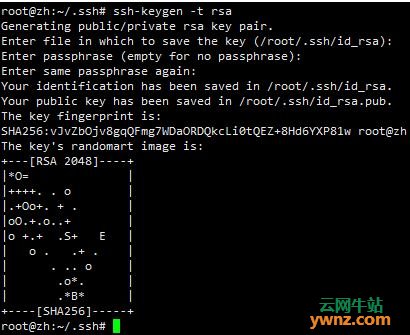

使用rsa算法生成秘钥和公钥对:

ssh-keygen -t rsa

运行后一路回车就可以了,其中第一个是要输入秘钥和公钥对的保存位置,默认是在:

.ssh/id_rsa

然后把公钥加入到授权中:

cat ./id_rsa.pub >> ./authorized_keys

再次ssh localhost的时候就可以无密码登陆了。

三、安装jdk

1.解压jdk

创建一个java的文件夹,用户存放Java文件:

mkdir /usr/local/java

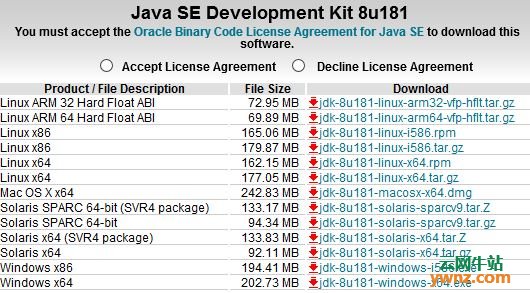

通过ftp工具把下载好的jdk安装包上传到java文件夹下:

解压:

cd /usr/local/java

tar -vxzf jdk-8u181-linux-x64.tar.gz

解压成功后会在当前目录下看到:

jdk1.8.0_181文件夹

然后删除安装包:

rm jdk-8u181-linux-x64.tar.gz

2.配置jdk

设置环境变量:

vim /etc/profile

在末尾增加以下代码:

JAVA_HOME=/usr/local/java/jdk1.8.0_181

PATH=$PATH:$HOME/bin:$JAVA_HOME/bin

export JAVA_HOME

export PATH

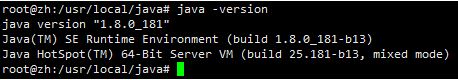

重新加载环境变量的配置文件:

source /etc/profile

检测:

java -version

四、安装Hadoop

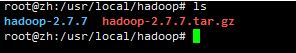

1.解压hadoop

创建一个hadoop的文件夹,用户存放hadoop文件:

mkdir /usr/local/hadoop

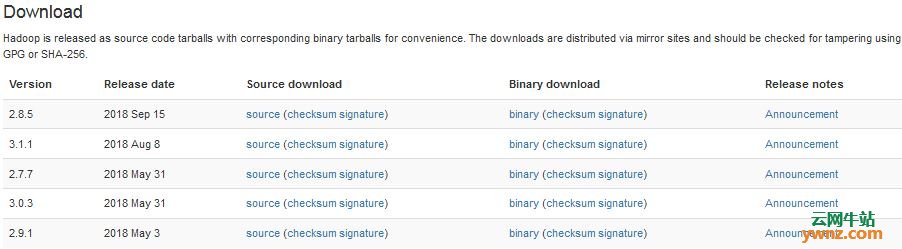

通过ftp工具把下载好的hadoop安装包上传到hadoop文件夹下。

解压:

cd /usr/local/hadoop

tar -vxzf hadoop-2.7.7.tar.gz

解压完成:

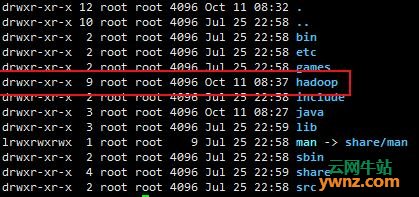

移动hadoop-2.7.7文件下的文件到当前的目录:

mv ./hadoop-2.7.7/* ./

删除hadoop-2.7.7文件夹:

rm -rf ./hadoop-2.7.7

查看文件夹的所有者以及用户组,最重要的是拥有者是否是当前用户

如果拥有者不是当前用户,则修改为当前用户:

sudo chown -R 当前用户名 ./hadoop

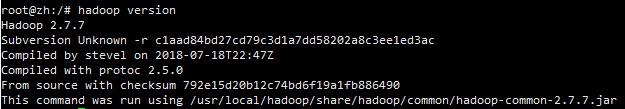

2.配置hadoop

设置环境变量:

vim /etc/profile

在末尾增加以下代码:

JAVA_HOME=/usr/local/java/jdk1.8.0_181

HADOOP_HOME=/usr/local/hadoop

PATH=$PATH:$HOME/bin:$JAVA_HOME/bin:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

export JAVA_HOME

export PATH

export HADOOP_HOME

重新加载环境变量的配置文件:

source /etc/profile

检测:

hadoop version

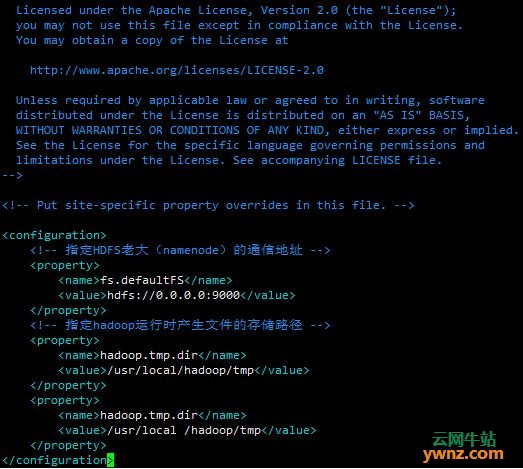

3.修改配置文件

在core-site.xml中增加:

fs.defaultFS

hdfs://0.0.0.0:9000

hadoop.tmp.dir

/usr/local/hadoop/tmp

hadoop.tmp.dir

/usr/local/hadoop/tmp

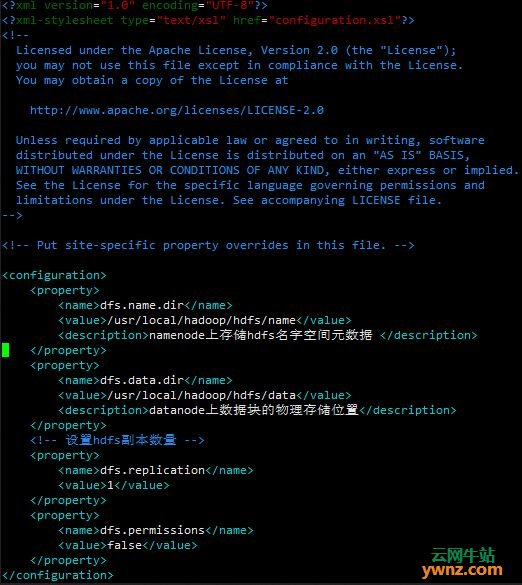

在hdfs-site.xml中增加:

dfs.data.dir

/usr/local/hadoop/hdfs/data

datanode上数据块的物理存储位置

dfs.replication

1

dfs.permissions

false

在hadoop-env.sh中更改JAVA_HOME。

注释掉:

export JAVA_HOME=${JAVA_HOME}

添加:

export JAVA_HOME=/usr/local/java/jdk1.8.0_181

4.测试,启动

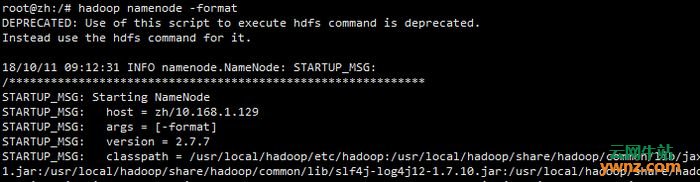

格式化namenode:hadoop namenode -format

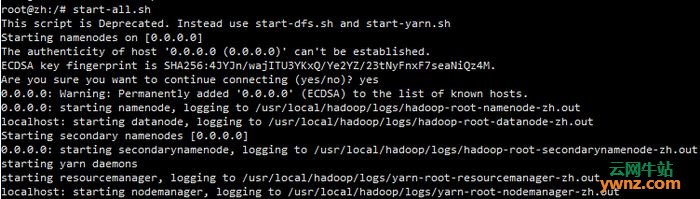

启动hdfs:start-all.sh

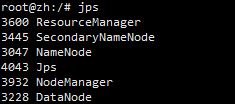

查看相应的进程:jps

确定6个进程全部启动。

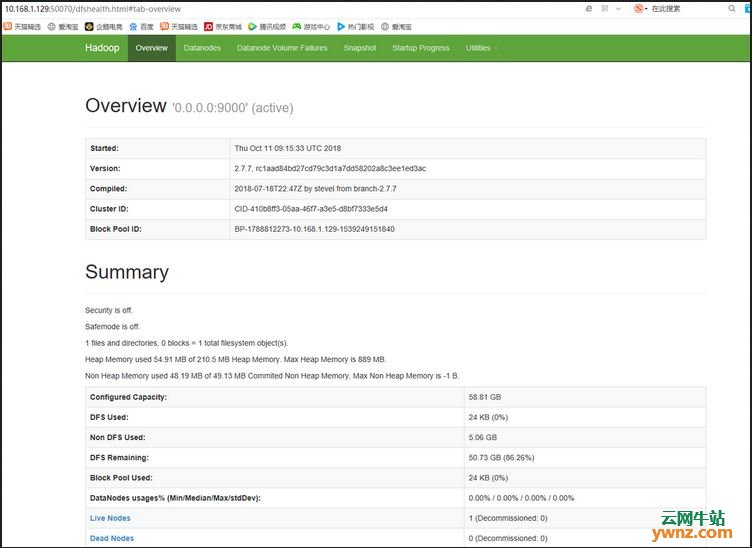

访问测试:10.168.1.129:50070(没问题就全部完成了。)

相关主题