您是否在使用Conv2d时遇见问题了呢?

您是否还在以Conv2d(128, 256, 3)的方式简单使用这个最具魅力的layer呢?

想更了解Conv2d么?让我们一起来深入看看它的真容吧,让我们触到它更高端的用法。

在第5节中,我们已经使用了Linear层来构建模型。其来自于torch.nn中

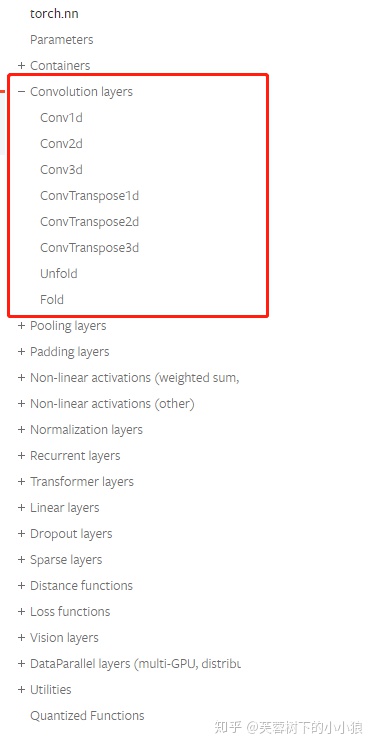

首先,我们先对torch.nn 来个整体的认识。官方链接:

https://pytorch.org/docs/stable/nn.html#

可以看到,在torch.nn下包含了我们模型的概念、一些常用层、损失函数等的定义。我们不一一详细说,只说我们刚开始操作时最经常用到的。今天我们从最常用的2维卷积层说起。

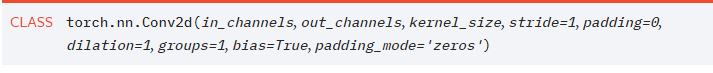

首先还是看官方文档对Conv2d的整体定义:

Conv2d,就是用来实现2d卷积操作的。要使用好这个类,我们先得搞清楚它的输入参数都是些啥?

in_channels —— 输入的channels数

out_cha

版权声明:本文为weixin_42371574原创文章,遵循 CC 4.0 BY-SA 版权协议,转载请附上原文出处链接和本声明。