基础配置和之前的一样,这里放上前面的博客:https://blog.csdn.net/weixin_43887873/article/details/125032225

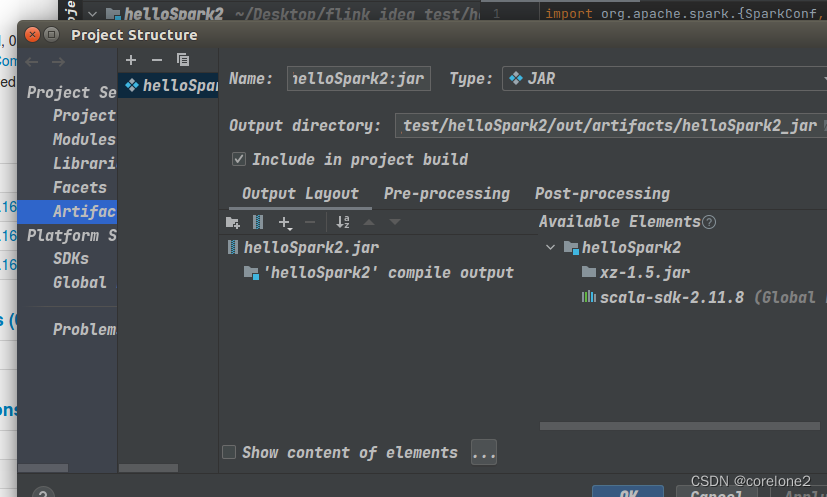

不同的地方就是直接在idea的代码里面设置为集群环境运行,并设置jar包路径。jar包路径设置为idea项目里的,并且勾选了include in project build,这样运行代码的时候,就能自动打包,并提交到集群上【所以集群肯定是得提前开着的】

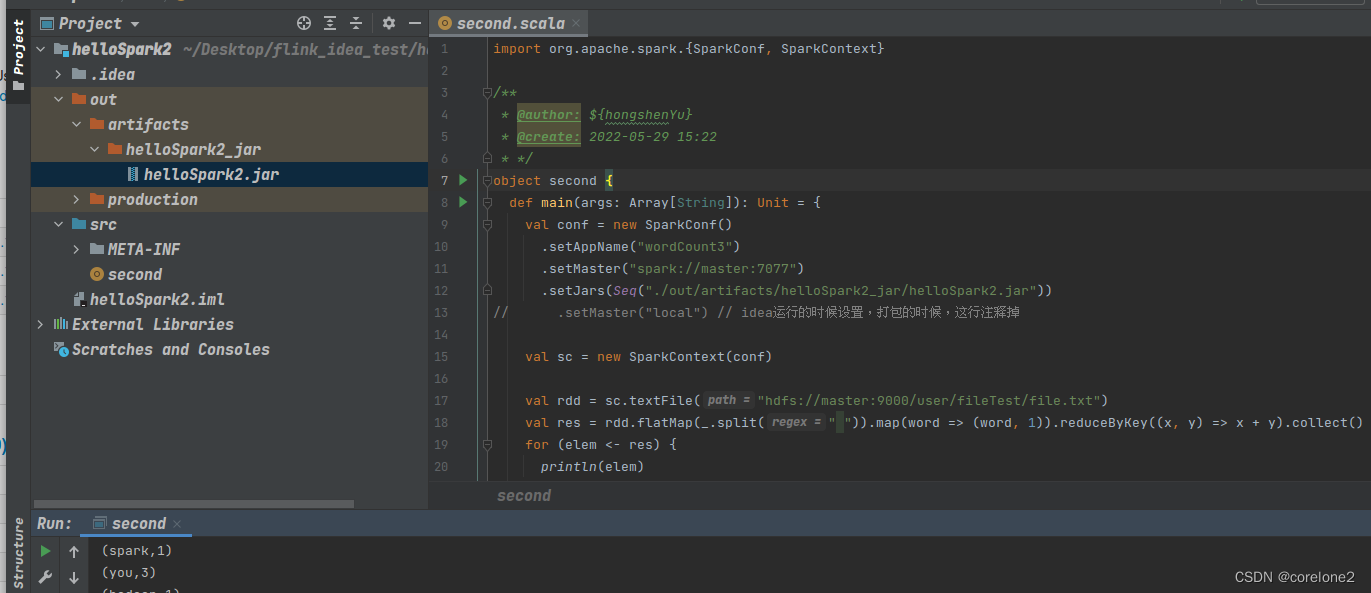

在Standalone集群环境下运行

在Yarn-client集群环境下运行

和在standalone环境下的区别就是,首先肯定要设为

setMaster("yarn-client")

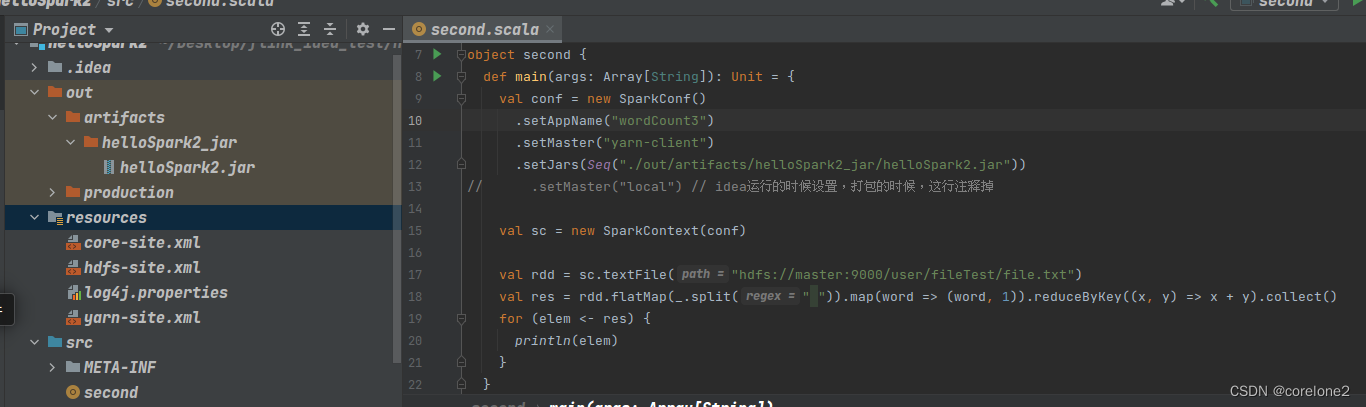

然后,要在yarn集群下运行,需要yarn集群环境的配置文件:

yarn-site.xml 、 core-site.xml 、 hdfs-site.xml 放到 resource 下面,因为程序运行的时候需要这些环境。

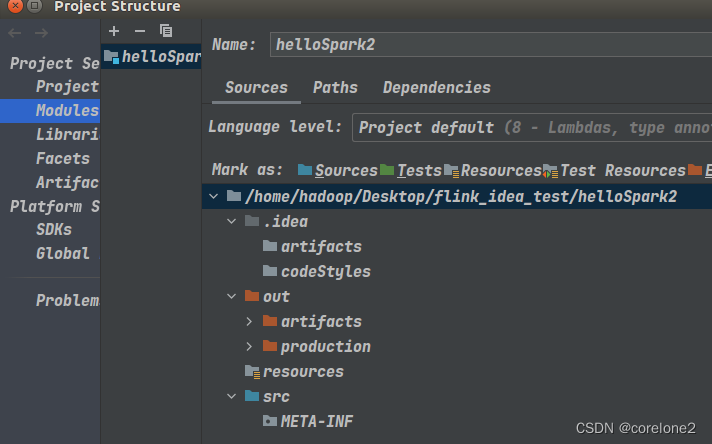

由于我一开始间的scala项目是没有resources资源文件夹的。所以我们先建一个resources资源文件夹,然后把几个文件放进去。

建resources资源文件夹:

就是在Modueles -> 右键项目,新建文件夹,取名为resources,选择为Resources。这个文件夹就变为资源文件夹了。

然后把yarn的几个配置环境文件放到建好的资源文件夹下:

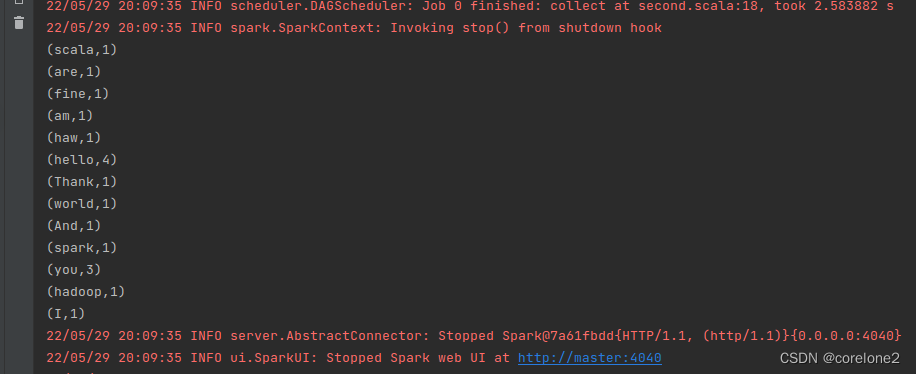

直接运行,和上面一样,会自动提交jar包到集群环境,由于是yarn-client模式,客户端会有输出。

最后声明:这几个idea运行spark,都是直接建的scala项目。自己导入的jar包。

不是利用maven的。

不过就是导依赖和打jar包不一样,其他应该差不多。

放到集群模式,应该需要,客户端的spark版本和集群的spark版本一致。

不知道后续放到实验室机房的集群环境有没有用。

参考文献:

https://www.jianshu.com/p/b4e4658c459c

https://blog.csdn.net/qq_45083975/article/details/112859381