pca的基础知识请参考《A TUTORIAL ON PRINCIPAL COMPONENT ANALYSIS》,这里记录一下使用python实现pca实验过程

新建一个x向量,参数10为正态分布的标准差,0为均值,100为向量长度

x=np.random.normal(0,10,100)新建一个噪声noise

noise=np.random.normal(0,4,100)新建一个y

y=5*x+3.3+noise组合起来得到数据集X

X=np.vstack((x,y))

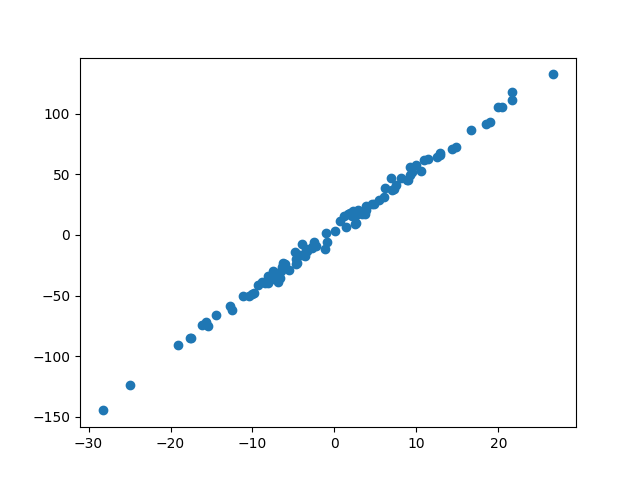

绘制出来看看

plt.scatter(X[0,:],X[1,:])

plt.show()

下面我们需要计算该数据集的协方差:

A=np.cov(X)np.cov这个函数默认数据集是列向量,首先会对所有特征减去均值,再求np.dot(X,X.T),再除n-1,得到:

array([[ 110.93271433, 555.42677191],

[ 555.42677191, 2794.35288558]])对角线上的元素的特征自身的方差,因为X的第一个特征x的标准差是10,方差10*10=100,X的第二个特征y的标准差是25*100=2500,可以看到上面这个协方差对角元素还是跟这两个理论值接近的

接下来求协方差的特征分解:

a,b=np.linalg.eig(A)得到a,对应两个特征值

array([ 5.11658217e-01, 2.90477394e+03])b,两个特征向量

array([[-0.98080561, -0.19498807],

[ 0.19498807, -0.98080561]]) 发现第二个特征值是第一个的几百倍,对应图上的点主方向,另外一个对应主方向的垂直方向,检查b的第二列发现这个方向也是数据点分布的主方向

最后进行变换

np.dot(b[:,1].reshape(1,-1),X)这里只取一个主分量,因为y确实是依赖x得出来的,Y=PX,P=E.T

完毕!

版权声明:本文为qq_29573053原创文章,遵循 CC 4.0 BY-SA 版权协议,转载请附上原文出处链接和本声明。