目录

1.2 将桥接的 IPv4 流量传递到 iptables 的链

1.8 安装 kubelet、kubeadm、kubectl 组件

2.6 如果 kubectl get cs 发现集群不健康,更改以下两个文件

一. 部署k8s

环境准备

- master:192.168.119.70

- node1:192.168.119.20

- node2:192.168.119.30

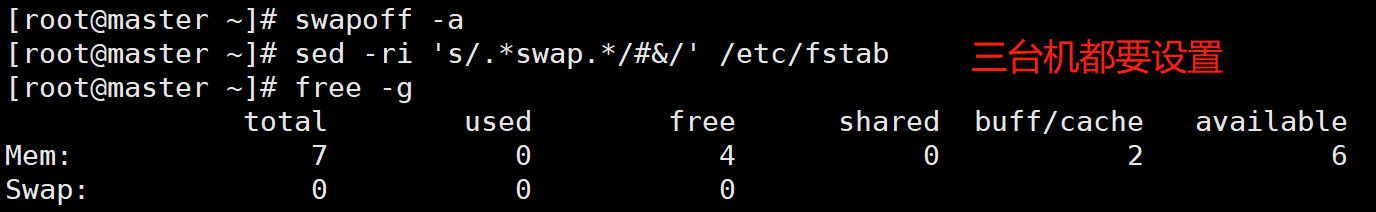

1. 三台机器环境配置

swapoff -a #临时

sed -ri 's/.*swap.*/#&/' /etc/fstab #永久

free -g #验证,swap 必须为 0;

1.1 做映射

三台都要配置

# vim /etc/hosts

192.168.119.70 master

192.168.119.20 node1

192.168.119.30 node2

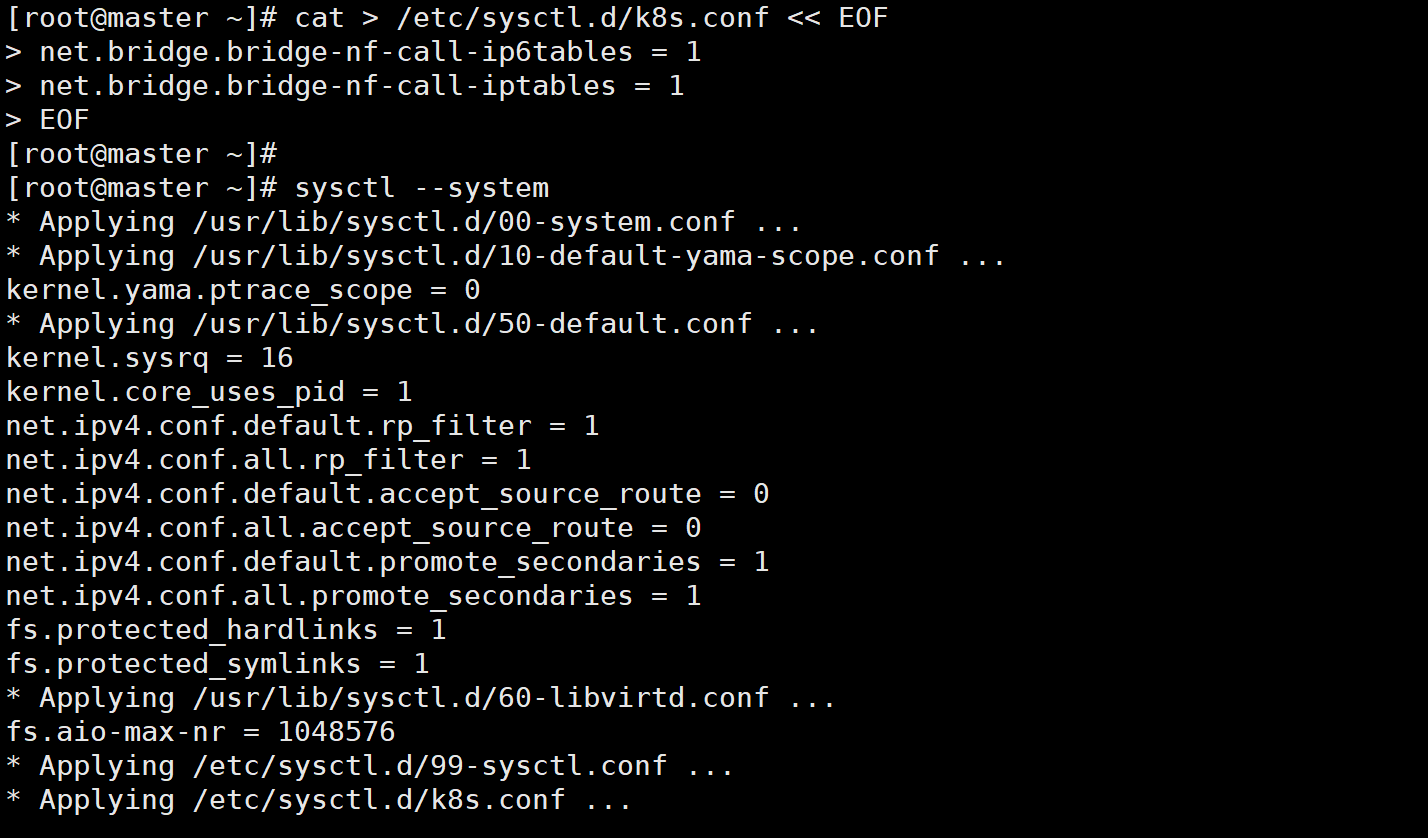

1.2 将桥接的 IPv4 流量传递到 iptables 的链

cat > /etc/sysctl.d/k8s.conf << EOF

net.bridge.bridge-nf-call-ip6tables = 1

net.bridge.bridge-nf-call-iptables = 1

EOF

sysctl --system

1.3 docker安装

安装依赖包

# yum install -y yum-utils device-mapper-persistent-data lvm2

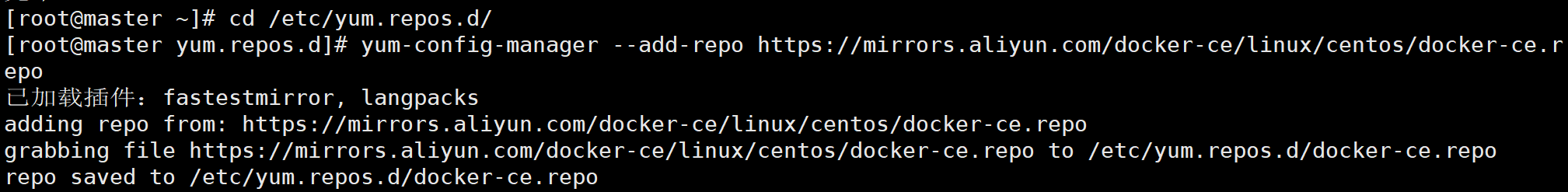

1.4 设置阿里云镜像源

# cd /etc/yum.repos.d/

# yum-config-manager --add-repo https://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo

1.5 安装docker-ce 社区版

# yum install -y docker-ce

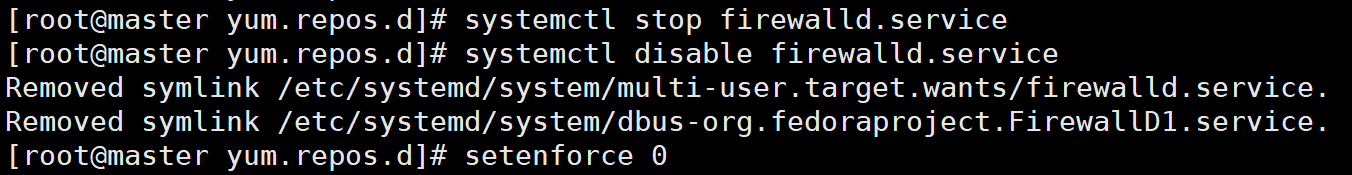

1.6 环境配置

# systemctl stop firewalld

# systemctl disable firewalld

# setenforce 0

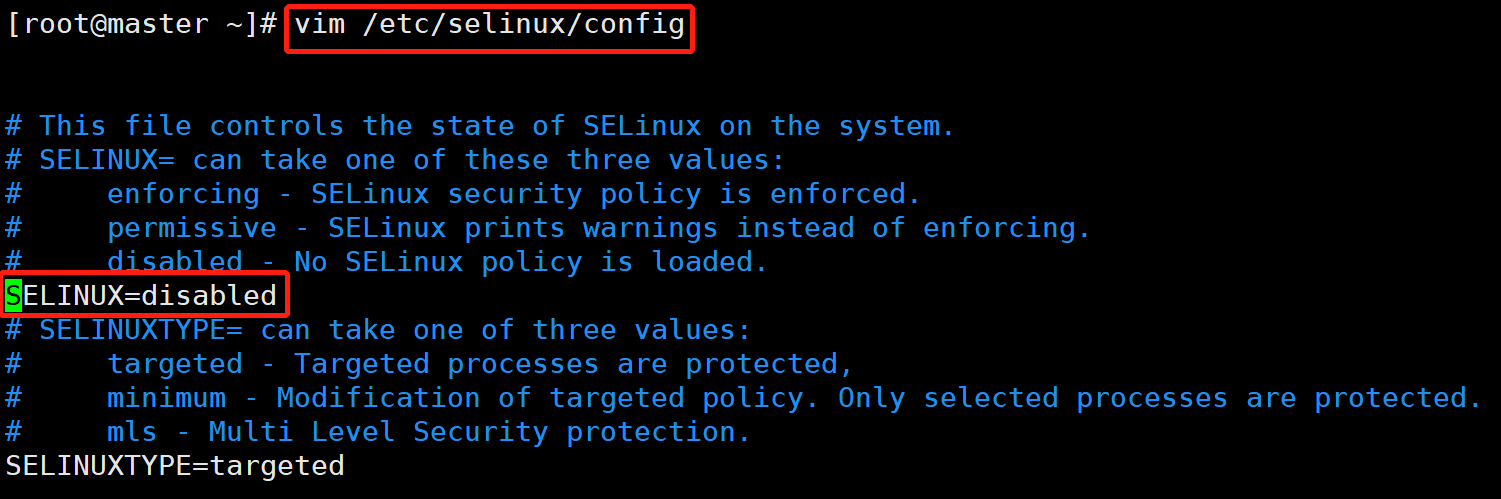

# vim /etc/selinux/config

SELINUX=disabled

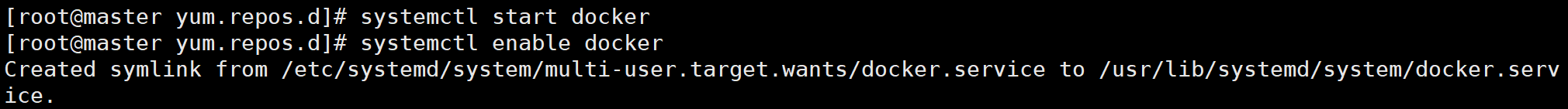

# systemctl start docker

# systemctl enable docker

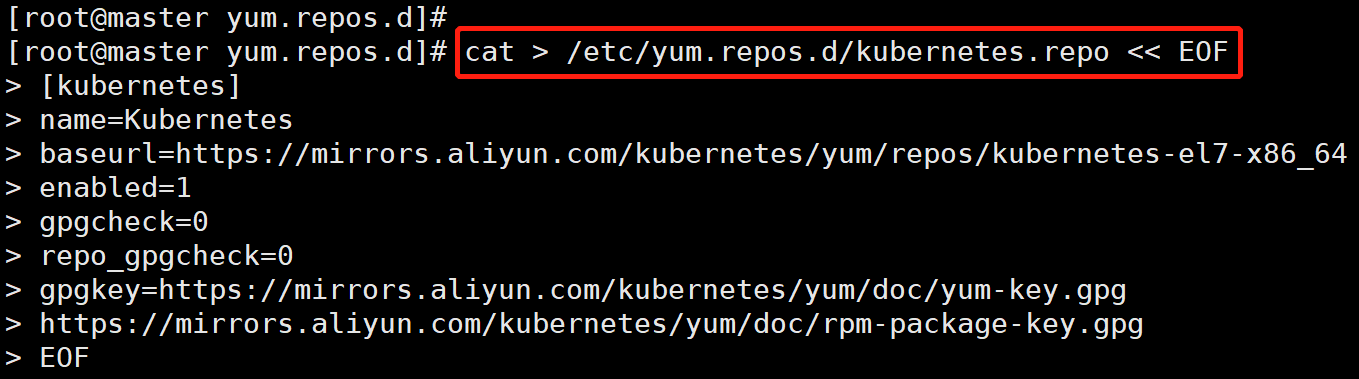

1.7 所有节点配置k8s源

cat > /etc/yum.repos.d/kubernetes.repo << EOF

[kubernetes]

name=Kubernetes

baseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64

enabled=1

gpgcheck=0

repo_gpgcheck=0

gpgkey=https://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg

https://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpg

EOF

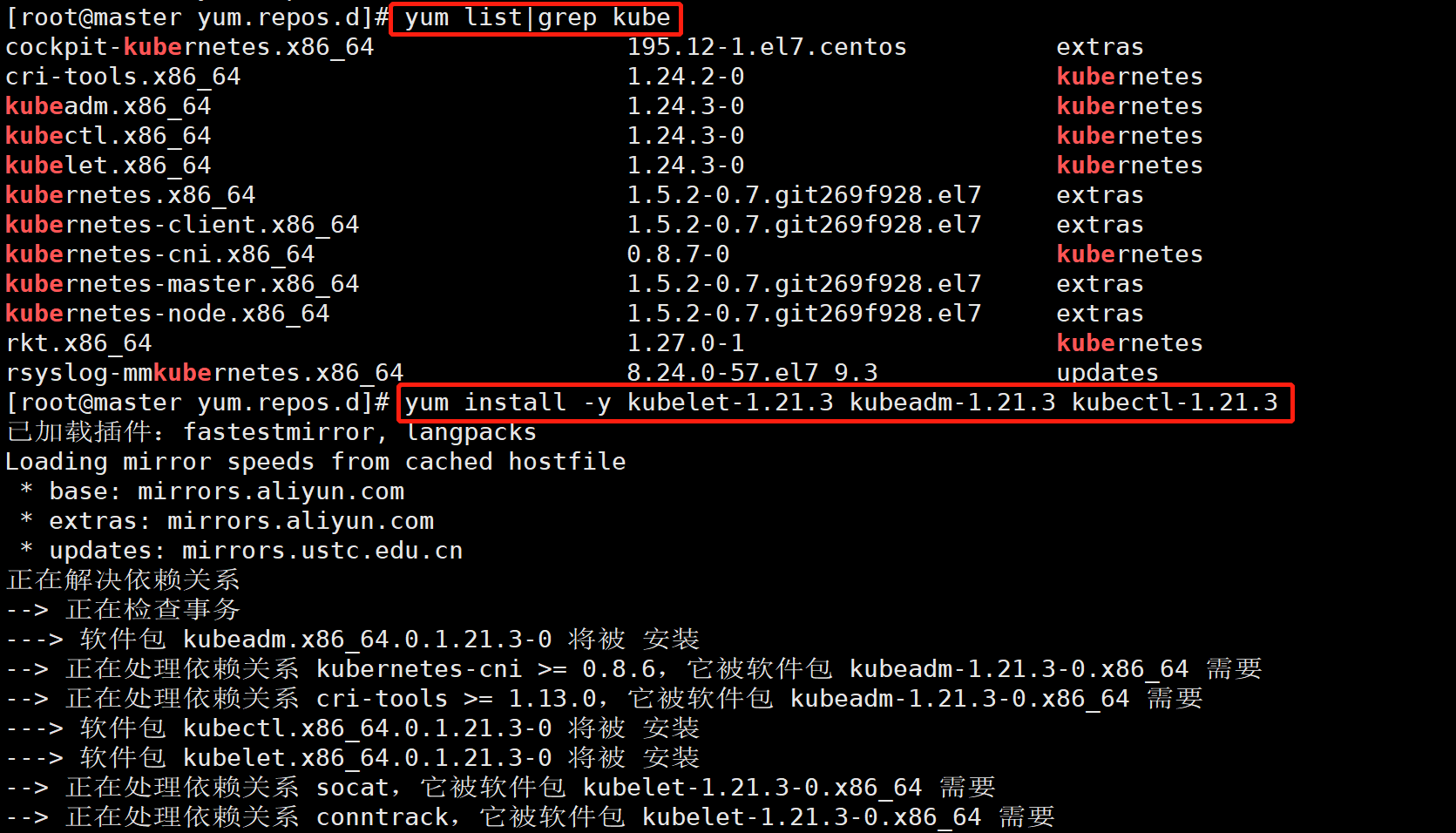

1.8 安装 kubelet、kubeadm、kubectl 组件

# yum list|grep kube

# yum install -y kubelet-1.21.3 kubeadm-1.21.3 kubectl-1.21.3

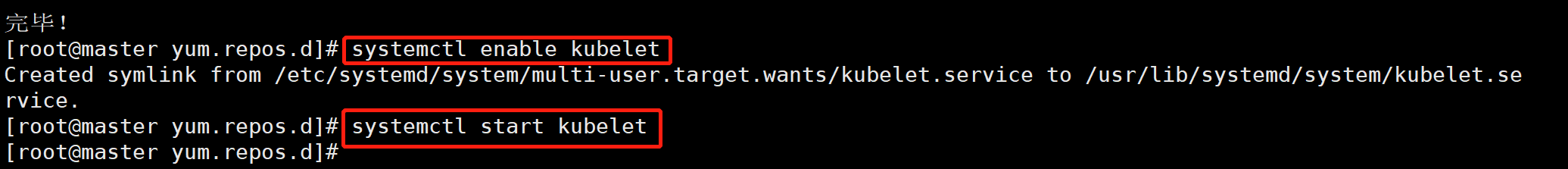

# systemctl enable kubelet

# systemctl start kubelet

2. master节点制作

kubeadm init \

--apiserver-advertise-address=192.168.119.70 \

--image-repository registry.cn-hangzhou.aliyuncs.com/google_containers \

--kubernetes-version v1.21.3 \

--service-cidr=10.125.0.0/16 \

--pod-network-cidr=10.150.0.0/16

#如有问题:

【用这个】kubeadm init –apiserver-advertise-address=192.168.10.27 –image-repository registry.cn-hangzhou.aliyuncs.com/google_containers –kubernetes-version v1.21.3 –service-cidr=10.125.0.0/16 –pod-network-cidr=10.150.0.0/16

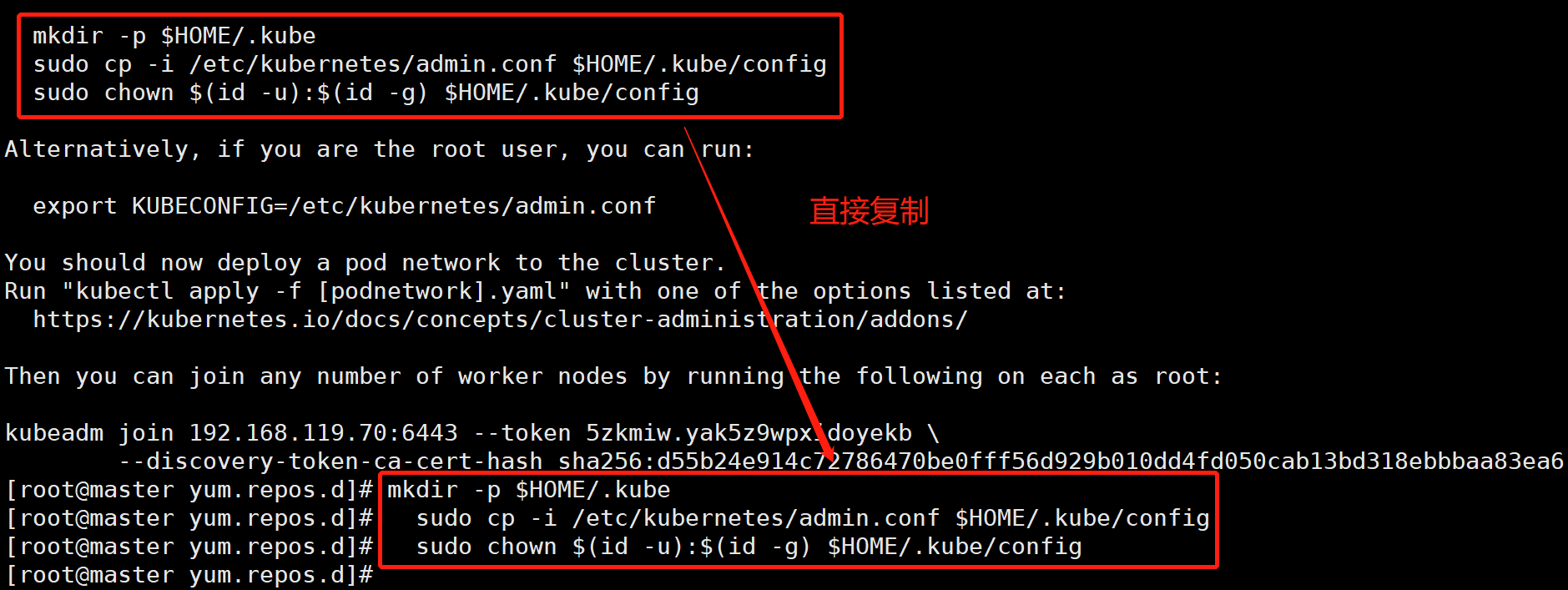

2.1 创建K8S组件的家目录 提权(必做)

mkdir -p $HOME/.kube

sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

sudo chown $(id -u):$(id -g) $HOME/.kube/config

##镜像批量导出,方便以后使用docker save

docker images | grep -v TAG | awk '{print $1":"$2}'

-o name.tar.gz

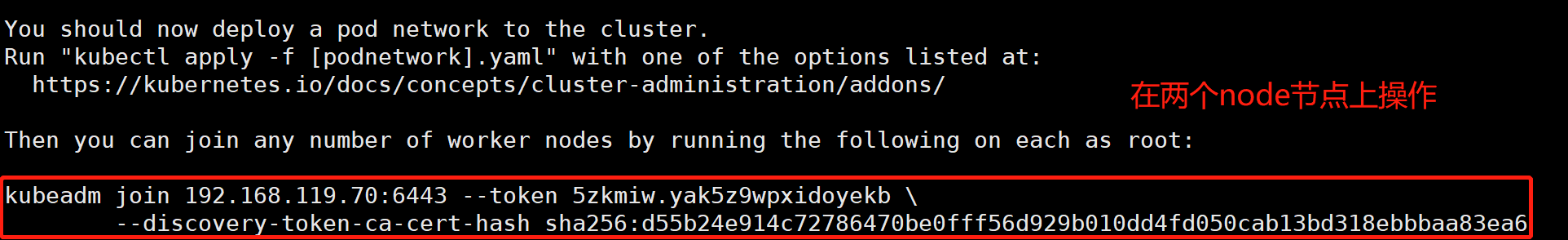

2.2 复制、记录申请加入集群命令【在两个节点服务器上写】

kubeadm join 192.168.119.70:6443 --token 5zkmiw.yak5z9wpxidoyekb \

--discovery-token-ca-cert-hash sha256:d55b24e914c72786470be0fff56d929b010dd4fd050cab13bd318ebbbaa83ea6

2.3 重新生成token

#若token 过期或丢失,需要先申请新的token 令牌【令牌过期时间是:24小时,等过了24小时之后,令牌失效,使用下面这个命令进行刷新重新生成令牌!】

kubeadm token create

#列出token

kubeadm token list | awk -F" " '{print $1}' |tail -n 1

#然后获取CA公钥的的hash值

openssl x509 -pubkey -in /etc/kubernetes/pki/ca.crt | openssl rsa -pubin -outform der 2>/dev/null | openssl dgst -sha256 -hex | sed 's/^ .* //'

#替换join中token及sha256:

kubeadm join 192.168.119.70:6443 --token 5zkmiw.yak5z9wpxidoyekb \

--discovery-token-ca-cert-hash sha256:d55b24e914c72786470be0fff56d929b010dd4fd050cab13bd318ebbbaa83ea6

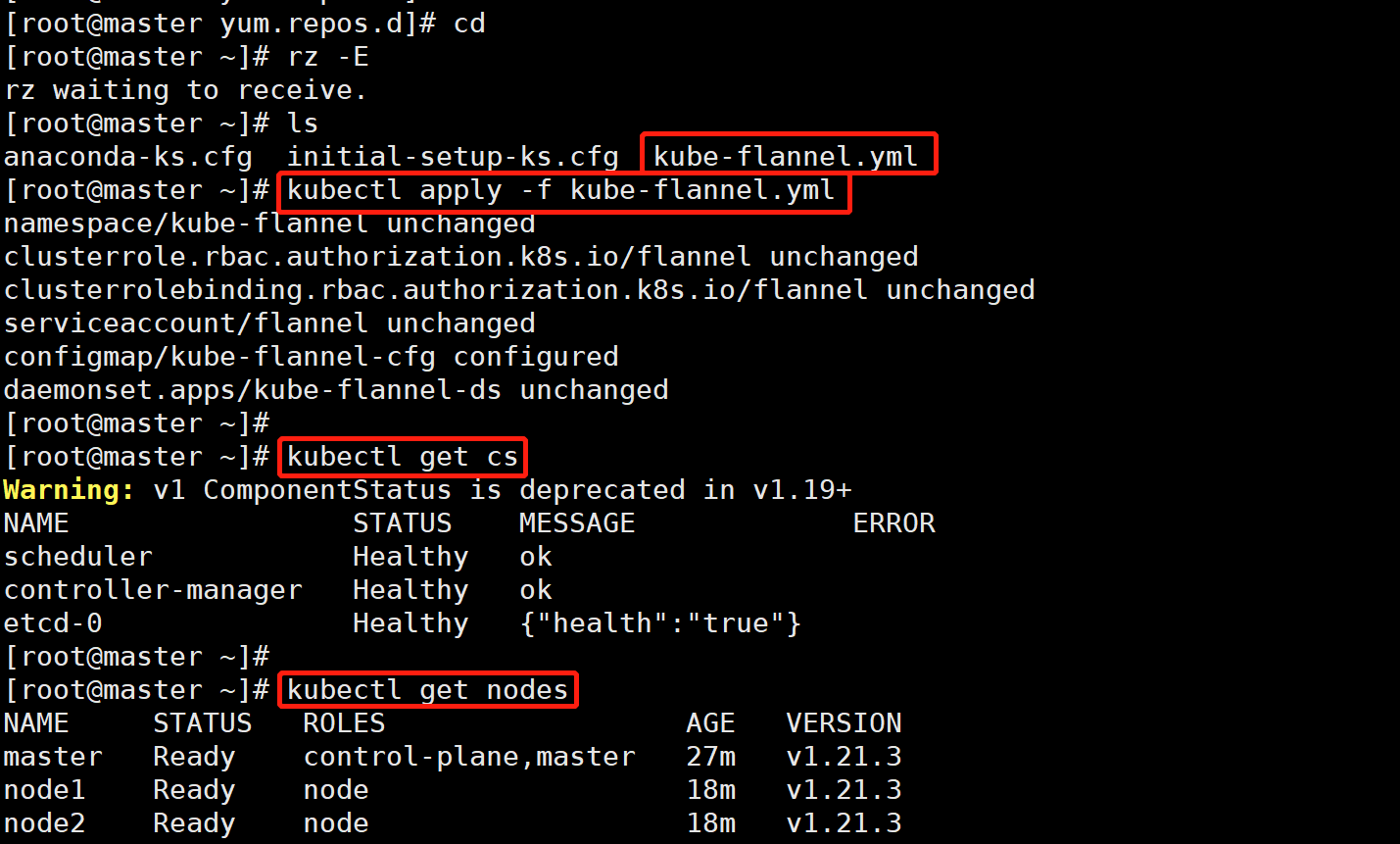

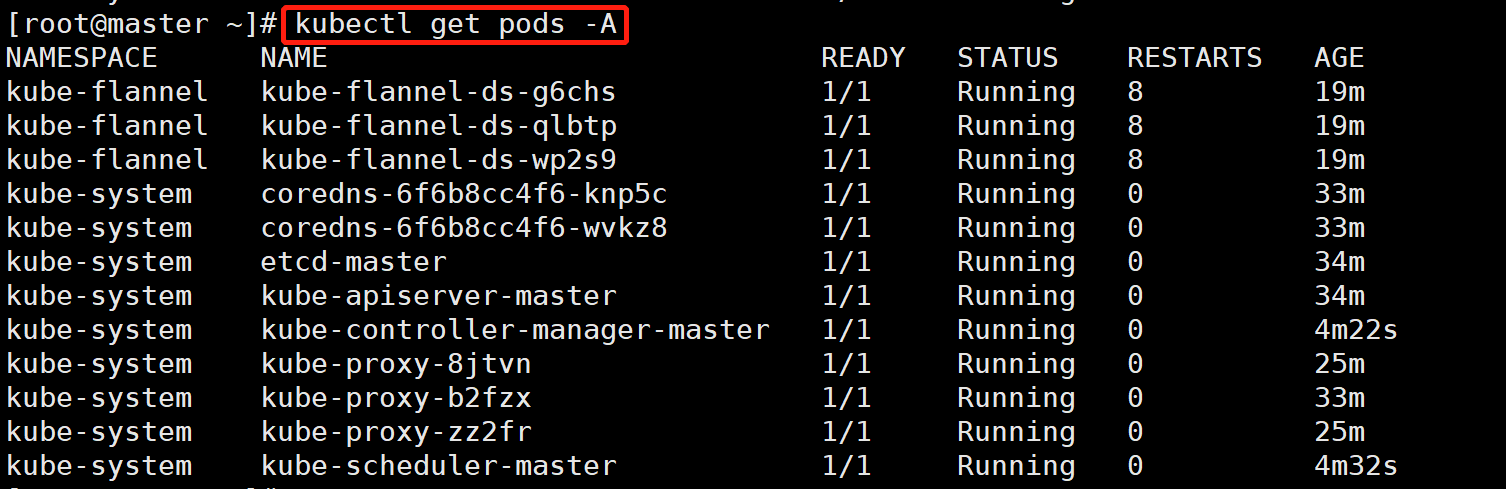

2.4 使用镜像包导入的方式完成flannel的部署

s三台都要做

# kubectl apply -f \

> https://raw.githubusercontent.com/coreos/flannel/master/Documentation/kube-flannel.yml

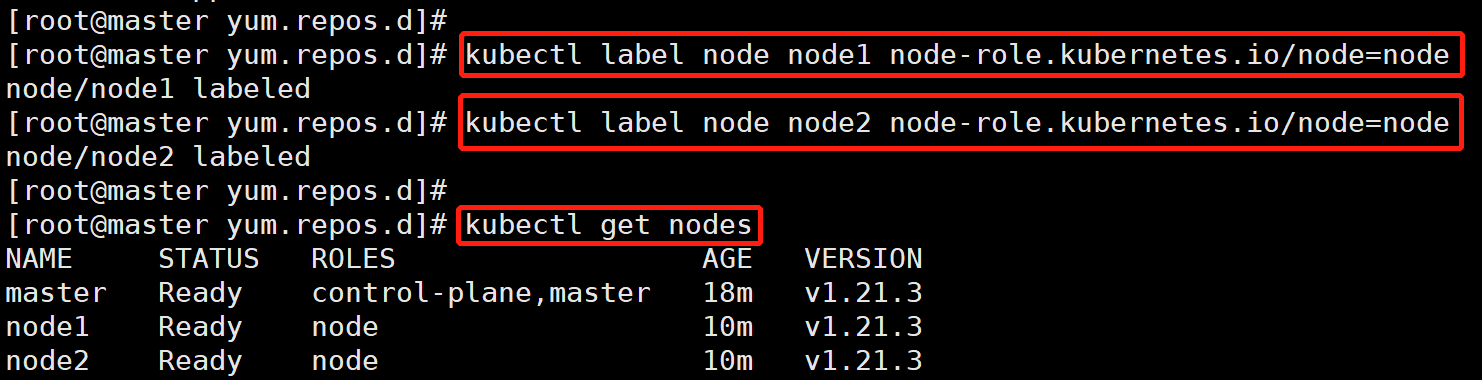

2.5 node节点打上“node”的标签

# kubectl label node node1 node-role.kubernetes.io/node=node

# kubectl label node node2 node-role.kubernetes.io/node=node

# kubectl get nodes

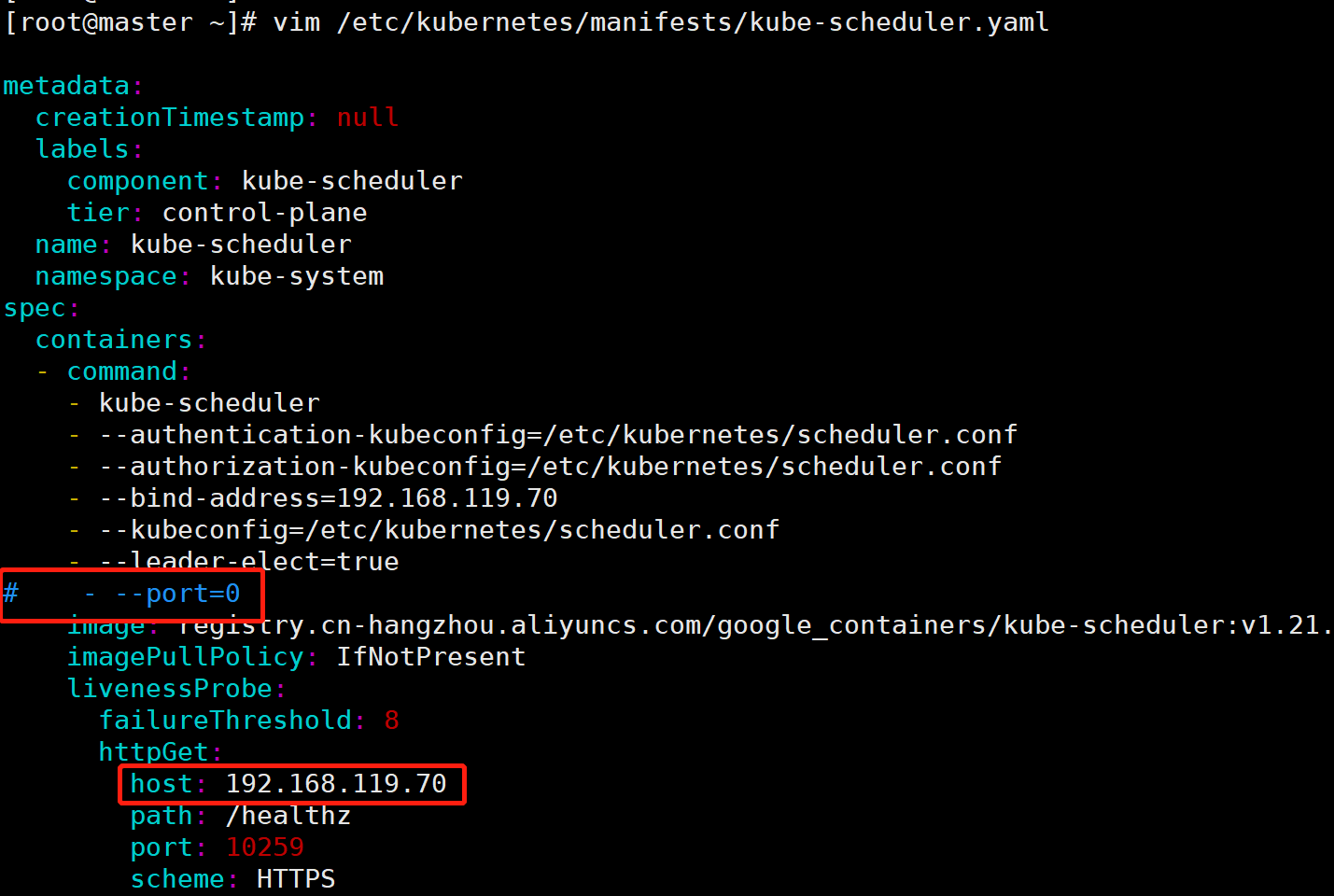

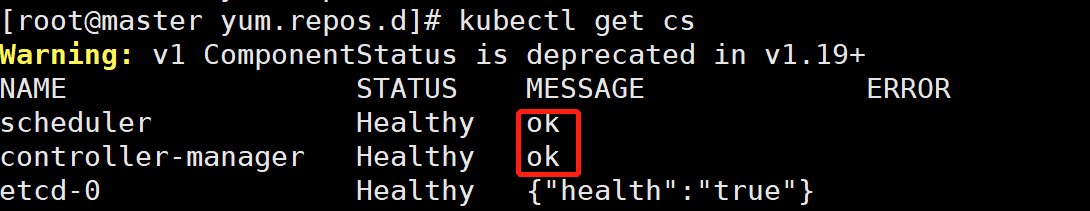

2.6 如果 kubectl get cs 发现集群不健康,更改以下两个文件

# vim /etc/kubernetes/manifests/kube-scheduler.yaml

# vim /etc/kubernetes/manifests/kube-controller-manager.yaml

'修改如下内容'

把--bind-address=127.0.0.1变成--bind-address=192.168.119.70 #修改成k8s的控制节点master01的ip

把httpGet:字段下的hosts由127.0.0.1变成192.168.119.70(有两处)

#- --port=0 # 搜索port=0,把这一行注释掉

# systemctl restart kubelet

2.7 把flannel配置文件拉进去,然后执行他